Gehirn und Sprache/ Druckversion

Vorwort

Dieses Buch kann im Regal der fertigen Bücher stehen. Und doch ist es niemals fertig. So ist das bei 'Wikibüchern': Sie sind nie fertig. Dennoch ist das Buch 'fertig' in dem Sinne, dass es jetzt seinen Zweck erfüllt: Man kann es mit Gewinn lesen, weil das, was der Hauptautor tun wollte, getan ist: Eine Anleitung zum weiteren Vorgehen zu geben.

In diesem Vorwort spricht nicht der Autor und Initiator, sondern ein hinzugeeilter Co-Autor, der dafür plädieren möchte, dieses „Essay“ unter die Wikibooks zu rechnen, die eigentlich Lehrbücher und keine Essays sein wollen.

Dieses Buch ist kein normales Lehrbuch. Was es lehrt, ist, sich auf Ideen einzulassen, und zwar auf Ideen, die erklären sollen, wie die menschliche Sprache als symbolverarbeitendes System funktioniert. Dieses Feld ist noch so unerforscht, dass es keine üblichen Lehrbücher gibt, in denen der symbolverarbeitende Sprachapparat in allen Einzelheiten erklärt wird. Hier kann man mit Denken lernen. Zwei Gründe, warum dieses Buch ein Lehrbuch ist:

- Ideen sind etwas Seltenes, was man behüten soll. Wo Ideen sind, entstehen oft noch mehr, oft ganz andere. Wir müssen auch lernen Ideen zu haben.

Dasselbe gilt für das Entdecken von Problemen: Es gibt zwar Probleme wie Sand am Meer, aber interessante Probleme zu entdecken und zu formulieren, das kommt nicht so oft vor. Probleme zu entdecken ist viel origineller als Probleme zu lösen (Popper). So mag auch die hier gebotene Lösung am Ende falsch sein, sie kann dennoch zu den richtigen Ideen anregen. Auch Kolumbus löste sein Problem nicht, westwärts den Seeweg nach Indien zu finden. Aber der Weg war interessant.

Oder ein weniger grandioses Beispiel, das aber aktueller ist: Das berühmt-berüchtigte Ziegenproblem, das zum Beispiel Gero von Randow (rororo 1992-2006, ISBN 3-499-61905-9) behandelt. Viele halten es für falsch gelöst (es ist dort richtig gelöst!), aber Randows Abhandlung darüber ist in jedem Fall eine amüsante und lehrreiche Einführung in das Denken in Wahrscheinlichkeiten. (so der Untertitel)

- Ich erwähne das Ziegenbeispiel absichtlich. Viele professionelle Mathematiker und noch viel mehr Laien haben die Lösung des Ziegenproblems, wie Marilyn vos Savant sie vorschlug, entschieden und zum Teil hochempört abgelehnt. Der Grund war, dass hartnäckige eingeschliffene Vorstellungen uns hindern, die neue sehr einfache Lösung zu begreifen. Könnte es nicht hier bei den Problemen Sinnverstehen und Bewusstsein ganz ähnlich sein?

- Im Umkreis dieses Problems vom Funktionieren der Sprache und der Erklärung des Bewusstseins gibt es so viel Literatur, dass es überhaupt kein Problem sein sollte, dieses Essay durch anklickbare Unterkapitel (die auf separate Seiten führen) als Studienführer zu gestalten, der auf diesen interessanten Gebieten – Sprachfunktionieren, Bewusstsein und mathematische Modelle dafür – von großem Nutzen sein kann.

Sprechen ist Abkürzen

Abkürzung I: Zeichen verweisen auf komplexe Sachverhalte

'DNS': Drei Buchstaben nur, und der gebildete Leser weiß, was gemeint ist: die Desoxyribonukleinsäure (englisch: DNA für deoxyribonucleic acid). Die drei Buchstaben stehen für einen komplizierten chemischen Begriff, der als Abfolge von 23 Buchstaben ein Zungenbrecher ist und schon deshalb lieber in der Kurzform „DNS“ gebräuchlich ist. Zwanzig Buchstaben werden auch beim Schreiben gern eingespart, wenn es kürzer geht, und weil die DNS nicht der einzige Zungenbrecher in der heutigen Sprache ist, lesen und sprechen wir zunehmend in Abkürzungen: ISDN, WWW, SPD, CDU, RAM, HIV, H5N1, TV, AT, StrGb, Uno, Kfz,... zwei bis vier Buchstaben können zehn mal so große Wortkomplexe stellvertretend ersetzen, und mancher Beamte weiß genau, was VAHRG bedeutet, Versorgungsausgleichshärteregelungsgesetz mit dreiundvierzig Buchstaben, abgekürzt auf fünf.

So selbstverständlich sparen wir uns mit vielen sprachlichen Abkürzungen Zeit und Mühe, dass die Frage nie gestellt wird, wie so etwas möglich ist.

Versuchen wir, der Frage ein wenig neugierig nachzugehen: Wie können drei Buchstaben genau die gleiche Botschaft tragen wie dreiundzwanzig?

Apropos „dreiundzwanzig“: Auch für dieses vierzehn Zeichen lange Zahlwort kann man eine Kurzform mit Hilfe der Ziffern 2 und 3 schreiben, und es ist äußerst praktisch, das Wort viermillionensiebenhundertachtundzwanzigtausendvierhundertneunundsechzig kurz mit sieben Ziffern als 4728469 zu notieren. Die gleiche Zahl als eine Menge (z.B. als Strichliste) betrachtet ist völlig unübersichtlich und in der genauen Größe nur sehr mühsam zu bestimmen. Nur zehn Zeichen ermöglichen uns im Dezimalsystem eine übersichtliche und exakte Darstellung jeder beliebigen Größe, sie verwandeln riesige Mengen in kleine, übersichtliche Sprachhäppchen, die unser Geist verdauen kann.

Wenn auch Unklarheit herrscht, wie das Prinzip dieser sprachlichen Verkleinerung funktioniert, ist deren Vorteil deutlich: Wir sparen viel Zeit, Mühe und Material, indem wir die Kurzformen benutzen. Besonders die Zahlen, aber auch die wissenschaftlichen Symbole in der Chemie, Elektrotechnik usw. tragen in ihrer knappen Form sehr zur Übersichtlichkeit des Dargestellten bei. Zum Beispiel werden die Bauteile der elektronischen Schaltungen, die Kondensatoren, Widerstände, Transistoren usw. in einem Schaltplan mit sehr einfachen Strichzeichnungen als Symbole eingezeichnet, Zahlen bezeichnen ihre Größe. Diese vereinfachende Skizzierung ermöglicht dem Fachmann erst eine Übersicht über den Sinn des ganzen Schaltplanes und dessen Funktionen, und damit auch eine Übersicht über das beschriebene Gerät. Die nächste Stufe der Vereinfachung ist die sogenannte „Blackbox“: Ganze Gruppen von Bauelementen werden durch ein Rechteck und eine Beschreibung von Input und Output ersetzt.

Die größten Triumphe erzielen die Mathematiker mit ihren Abkürzungen: E=mc² ist die kleinste Form für einen großartigen Gedanken Einsteins, der die Welt gewaltig veränderte. Es erscheint mir die Meinung berechtigt zu sein, dass die wesentlichen Vorteile der Mathematik auf ihrer Fähigkeit beruhen, große, unübersichtliche Komplexe in einer extrem kleinen, aber übersichtlichen und exakten Darstellung zu präsentieren.

Auch wenn Abkürzungen von Begriffen hauptsächlich in der Mathematik und den Wissenschaften üblich sind, halte ich eine genaue Untersuchung dieser sprachlichen Fähigkeit für wichtig, weil sich damit ein wesentlicher Aspekt jeder Sprache aufdecken lässt, der in einer starken Vereinfachung (Reduktion) von Komplexität besteht.

Abkürzungen II: komprimierte Daten

Um diesen Aspekt zu entdecken, ist ein Vergleich mit der Computertechnik hilfreich. Seitdem auch Musik, Bilder und Videos in Computern gespeichert werden, ist der Begriff Datenkomprimierung gebräuchlich geworden.

Datenkomprimierung bedeutet: große Datenmengen können durch Algorithmen in wesentlich kleinere Formen „verpackt“ werden, aus denen sich die ursprünglichen Daten wieder „entpacken“ lassen. Davon profitieren z.B. MP3-Player oder digitale Fotoarchive, die mit wenig Speicher viel Musik oder Bilder speichern können. Außerdem empfiehlt sich die Komprimierung der Datenmengen bei der Kommunikation im Internet, weil große Dateien lange Übertragungszeit benötigen.

Speicherkapazität und Übertragungszeit sind auch für die sprachliche Kommunikation der Menschen wichtige Parameter, und so erscheint jede sprachliche Abkürzung einer technischen Datenkomprimierung vergleichbar. Wenn z.B. die drei Buchstaben DNA das 23 Buchstaben lange Wort ersetzen, so lässt sich daraus ein Komprimierungsverhältnis von 7,6 : 1 errechnen.

Dieses Größenverhältnis ist ungefähr mit den technischen Komprimierungen vergleichbar. Allerdings gibt es eine Obergrenze, wie stark etwas komprimiert werden kann. Bei Bildern kann eine besonders starke Komprimierung dazu führen, dass bei der Rekonstruktion die Details unscharf und pixelig werden.

Abkürzungen III: in Symbolen komprimierter Sinn

Ein wichtiger Unterschied zwischen sprachlicher Abkürzung und technischer Komprimierung besteht darin, dass der Computer keinerlei Wissen oder Verständnis von den Daten hat, die er bearbeitet, komprimiert und speichert.

In der menschlichen Kommunikation ist dagegen immer schon ein Wissen der Wörter und deren Bedeutung vorauszusetzen, ohne welches der Gebrauch der Sprache gar nicht möglich ist, zum Beispiel in einer Fremdsprache.

Dieses Vorwissen, über das unser Gedächtnis verfügen muss, erzeugt einen Vorteil: Mit dem bereits vorhandenen umfangreichen Weltwissen kann die Kommunikation unter Menschen in einer Art geführt werden, die dem Individuum ein Verständnis von Sinn vermittelt und mitteilbar macht. Kein Computer hat ein Weltwissen und ein Verständnis für den Sinn der Daten, die er bearbeitet, komprimiert, speichert und ausgibt.

Halten wir einmal fest: Die menschliche Sprache bietet uns mit den sogenannten Abkürzungen die Erleichterung, große Datenmengen in kleinere zu verwandeln bzw. zu komprimieren. Dazu sind Gedächtnisleistungen nötig, die zu einem Verständnis des Sinnes beitragen, der in den Zeichenfolgen zum Ausdruck kommt.

Die Alltagssprache der einfachen Art benutzt die Abkürzung weniger, aber wenn ein Boxer K(nock) O(ut) geschlagen wird, versteht jeder den Sinn des Kürzels auch ohne Englischkenntnisse.

Die meisten elementaren Begriffe einer primitiven Alltagssprache sind aber schon von Beginn an (Papa, Mama) so kurz, dass weitere Abkürzung sinnlos ist.

Betrachten wir als Beispiele einer elementar einfachen Sprache diese Wörter: See, Meer, Land, Mond, Tal, Berg, Ei, Brot, Wurst, Fleisch, Tier, Floh, Gott, Jahwe, Allah, warm, kalt, nah, weit, Schnee, Blitz, ja, nein, und, noch, wenn, dann, eins, zwei, drei, vier, Tür, Haus, Bett, müde, wach, Tag, Jahr......wir können die Reihe noch lange fortsetzen, und finden auch in allen Fremdsprachen die Bestätigung, dass die elementaren Wörter einer Sprache meist dermaßen kurz sind, dass Abkürzungen dafür kaum noch möglich sind.

Aus dieser unübersehbaren Tatsache ziehe ich einen Schluss über die allgemeine Funktion der Sprache, die meines Erachtens in einer optimalen Datenreduktion oder Komprimierung zu liegen scheint. Wir komprimieren Daten nicht nur mit den Abkürzungen, sondern schon mit jedem Wort, angefangen mit „Mama“ und "Papa". Mit diesen kurzen Lautkomplexen können wir in "Echtzeit" über komplexe Dinge "sinnieren" und kommunizieren.

Wenn ein Kind circa acht Monate nach seiner Geburt sein erstes Wort benutzt, hat es schon unzählige Datenmengen von dem Objekt „Mama“ in seinem Gedächtnis, die es alle zusammen in der einfachsten Sprachform zum Ausdruck bringt, das heißt: es komprimiert bereits eine riesige Menge von Information in eine simple sprachliche Kurzform!

Diese Funktion der Sprache wird bisher von keinem Sprachwissenschaftler beschrieben, sodass es mir überlassen ist, den Gedanken weiter zu spinnen.

Eine Bestätigung ihrer komprimierenden Funktion finden wir schon in der Sprache selbst: Ein Dichter verdichtet die Sprache im Gedicht, mit dem er seine komplexen Gedanken und Gefühle zum Ausdruck bringt, das heißt: er komprimiert sie. Das griechische Wort Symbol umschließt auch die Wörter, und es bedeutet genau übersetzt „das Zusammengehäufte“, das heißt: das Komprimierte. Der Philosoph Ernst Cassirer nannte den Menschen „animal symbolicon“, das zusammenhäufende, also komprimierende Lebewesen, weil nach seiner Meinung die Verwendung von Symbolen das spezifisch herausragende Merkmal der menschlichen Gattung und ihrer Kultur ist.

Sprache: Symbolische oder komprimierende Abkürzung?

Zweifel an der offensichtlich komprimierenden Funktion der Sprache müssen natürlich bestehen bleiben, solange nicht erklärt werden kann, wie diese spezielle Fähigkeit der Menschen zustande kommt. Ich habe bereits geschrieben, dass unser Gedächtnis zum Verständnis von Sinn die nötigen Informationen bereitstellen muss. „Gedächtnis, Verständnis, Sinn, Information“ sind nun aber selbst äußerst schwierige Wörter, die zuerst ausführlich erörtert werden müssen. Dafür werden die folgenden Kapitel benutzt.

Davor will ich noch einmal auf die technische Methode der Komprimierung zurückkommen, deren Verfahren bekannt ist. Digitale Dateien werden mit speziellen Algorithmen kleiner gemacht, indem unnötige Informationen daraus entfernt werden, die Dateien werden beim Komprimieren quasi „abgespeckt“.

Zum Beispiel können in einem Text häufig wiederkehrende Wörter eingespart werden, indem nur der Platz notiert wird, an dem sie stehen. Bei der digitalen Aufnahme von Musik werden die höchsten Frequenzen, die wir nicht mehr hören können, herausgefiltert und gar nicht erst aufgezeichnet, damit die Datenmenge kleiner ist. Bei Bildern haben oft große Flächen die gleiche Farbe, sodass man nur die Grenzen der gleichen Farbfelder angeben muss, um ein Bild in die komprimierte Form zu verwandeln.

Es ist leicht verständlich, dass diese „abspeckenden“ Komprimierungsverfahren enge Grenzen haben.

Eine wesentlich effektivere Methode zeigt uns die Sprache. Wörter sind keine abgespeckten Formen der Objekte, die von ihnen repräsentiert werden, sie bestehen ja nur aus kurzen Laut-oder Zeichenfolgen und haben mit den Objekten nichts gemeinsam. Die Informationsmengen der Objekte können unbeschränkt groß sein, und können dennoch durch ein sekundenlanges Wort augenblicklich aktualisiert werden, zum Beispiel „Prag, Rom“.

- Wörter sind nicht „abgespeckte“ Datenmengen.

Die technischen, abspeckenden Komprimierungsmethoden können dafür sicher nicht verwendet werden. Aber welcher Zusammenhang besteht dann zwischen der komprimierten Form der Wörter und ihren Bedeutungen? Diese Frage ist bisher von der Kognitions- und Sprachwissenschaft noch nicht befriedigend beantwortet worden, sodass wir eine Antwort erst noch finden müssen.

Einen ersten Hinweis über die Art des Zusammenhanges findet man in einem sehr alten Buch, der Bibel. Was immer man von Religion hält, muss man dem biblischen Jesus die Fähigkeit zugestehen, tiefe Gedankengänge in einfachen Gleichnissen auszusprechen. Eines davon ist das Gleichnis vom Sämann, mit dem Jesus seine Jünger anregen will, jedes Wort sorgfältig zu bewahren, damit es hundertfach Frucht bringt. Wörter sind wie Samen, die auf steinigem Boden verkümmern, von Vögeln gefressen werden können oder auf gutem Boden große Gewächse mit vielen Früchten erzeugen.

Abkürzung IV: Baupläne speichern statt Gebäude speichern

Wörter sind genau wie Samen sehr klein im Verhältnis zu ihren Erzeugnissen. Die Natur hat offensichtlich mit den Samen bereits die Fähigkeit zur Komprimierung großer Organismen in kleinste Formen unter Beweis gestellt.

So wie die Wörter nicht als abgespeckte Versionen der Objekte aufzufassen sind, sind auch die winzigen Speicherformen der Lebewesen nicht als abgespeckte Individuen zu verstehen. Ein Wort enthält also nicht den Gegenstand, auch nicht in sozusagen datenreduzierter Form. Und genauso enthält die Walnuss nicht den Nussbaum in komprimierter Form.

Was der Samen enthält ist die Bauanleitung, die Herstellungsvorschrift, das Rezept. In Form dieser Bauanleitung erreicht die Natur maximale Komprimierung der Organismen in ihren Samen. Heute wissen wir sehr genau, wie in den langen Ketten der DNA, in denen sich immer nur vier Moleküle abwechseln, die Bauanleitung aller Organismen festgelegt wird. Die ganze Variationsbreite der Lebewesen entsteht nur durch die Variationen der vier Basen in den DNA-Sequenzen der Gene.

- Die Walnuss ist Bauanleitung für einen Baum.

Es liegt auf der Hand, dass eine Bauanleitung sehr viel kleiner sein kann, als ihr Produkt. Die Größe eines Produktes erscheint sogar völlig unabhängig von der Größe seiner Herstellungsvorschrift zu sein, wenn diese Vorschrift ständig von Neuem wiederholt wird. Mit einem Rezept kann man einen Kuchen backen, aber durch seine ständige Wiederholung können auch ganze Kuchenberge damit erzeugt werden. Genau diese Methode, die ständige Wiederholung der gleichen Vorschrift (Zellteilung), erzeugt aus den mikroskopisch kleinen Genen die ganze Bandbreite des Lebens.

So erreicht der biblische Vergleich der Wörter mit den Samen durch die moderne Genetik eine Bestätigung. Die Parallelen sind nicht zu übersehen: So wie die ganze Mannigfaltigkeit des Lebens mit der Variation der vier DNA-Basen beschrieben werden kann, kann sprachlich auch die ganze Bandbreite der menschlichen Gedanken und Gefühle mit der Variation von Zeichenfolgen ausgedrückt werden.

- Ein kleiner Bauplan enthält sie nicht und schafft sie doch: riesige komplexe Gebäude.

Auch die häufige Wiederholung der gleichen Vorgänge ist eine typische Tatsache in jedem Sprachgebrauch, besonders in der Lernphase in den ersten Schuljahren. Rechnen und Schreiben lernen wir nur durch endlose Wiederholung der gleichen Vorschriften.

Zusammenfassung und Vorschau

Zusammenfassend lässt sich sagen, dass die komprimierende Wirkung der Sprache vermutlich darauf beruht, dass ihre Zeichenfolgen als Teile einer Konstruktionsvorschrift wirken, einer Bauanleitung, mit welcher der ganze Kosmos des menschlichen Geistes hergestellt werden kann.

In der Wissenschaft sind solche spekulativen Behauptungen verpönt, solange sie nicht bewiesen werden können. Unsere Ansicht über das Funktionieren von Sprache beruht zwar auf einfachen Tatsachen, aber für die Theorie, die sich nun abzuzeichnen beginnt, müssen wir uns die Prüfungen erst noch ausdenken, sonst kann sie keine wissenschaftliche Anerkennung erringen.

Zunächst werden wir uns mit einigen theoretischen Begriffen befassen, die in dieser Theorie vorkommen, um genau zu wissen, worüber wir eigentlich reden. Diese Begriffe kennen wir auch aus dem Alltagsdenken. Es wurde schon festgestellt, dass das Besondere der menschlichen Sprache auch darin liegt, dass sie bei grundlegend schon vorhandenem Wissen den Sinn von Informationen ausdrückt und auf andere Menschen überträgt. Sinn, Wissen, Gedächtnis und Information sind also diese Begriffe, die so weit erklärt werden müssen, dass wir die Theorie der Sprache begreifen und später vielleicht auch nachprüfen können. Auch der schillernde Begriff Bewusstsein gehört zu den ungeklärten Grundlagen der Sprache, weil ohne Bewusstsein die Sprachfähigkeit nicht vorhanden ist.

Wir wollen uns in den folgenden Kapiteln die Mühe machen, diese komplizierten Begriffe von verschiedenen Seiten zu beleuchten, um uns ganz klar zu sein, worüber wir sprechen und um dann die komprimierende Funktion der Sprache als Ergebnis einer sehr einfachen Bauanleitung besser verstehen zu können.

Be-Sinn-liches

Bordcomputer HAL und der Turing-Test

Im Jahr 1965 drehte Stanley Kubrick den Film „2001:Odyssee im Weltraum“. Wer den Film gesehen hat, wird sich an den Bordcomputer Hal 9000 des Raumschiffes erinnern, der als neueste Errungenschaft auch den Sinn der menschlichen Sprache perfekt verstehen konnte. Die Dialoge der Astronauten mit ihrem Zentralrechner wurden ohne jede Einschränkung wie zwischen Menschen geführt. Schließlich handelte HAL sogar völlig eigenwillig und übernahm brutal die Herrschaft über die Raumstation mit der selbstbewussten Begründung, dass ein Computer wie er sich nicht irren könnte. Das Jahr 2001 ist vergangen, aber ein Computer mit so beunruhigenden Fähigkeiten ist noch nicht in Sicht.

Mit dem Verständnis für den Sinn von Sprachäußerungen, den HAL sogar aus den Bewegungen der Lippen ohne Ton erfassen konnte, bekam diese Maschine eine Eigenschaft, die mit dem Wort „Bewusstsein“ verbunden werden kann.

Das ist ein Beispiel für den sogenannten Turing-Test: wenn eine Kommunikation zwischen Mensch und Maschine so stattfindet, dass ein Mensch nicht mehr unterscheiden kann, ob er es mit einem Menschen oder einem Apparat zu tun hat, dann darf man von einem Beweis für Bewusstsein sprechen. Offenbar ist Sinnverständnis das wesentliche Kriterium für Bewusstsein und kein anderes denkbar. Hirnströme, Atmung und Herzschlag mögen Bedingungen für Bewusstsein sein, aber sie sind kein Kriterium. Ohne sie ist man bewusstlos, aber ihr Vorhandensein macht das Bewusstsein weniger plausibel, als das Bestehen des Turing-Tests.

- Turing-Test: Sinn verstehen wie ein Mensch zeugt von Bewusstsein.

Kubriks fiktiver Filmcomputer HAL hätte diesen Test ohne Schwierigkeiten bestanden. Als ihm der Strom abgeschaltet wurde, sang er sogar ein Kinderlied und gestand dem Astronauten, dass er Angst habe, Todesangst.

Wenn die Visionen des Filmproduzenten nach 41 Jahren noch nicht in Erfüllung gingen, kann man fragen, was den Computern heute noch fehlt, um wie HAL den Sinn von Sprachsequenzen, Sätzen und ganzen Erzählungen zu verstehen. Obwohl ein großer Forschungsaufwand (IBM usw.) auf dieses Ziel gerichtet ist, lassen sich mit keinem Rechenapparat sinnvolle Gespräche führen, die über ein kleines, festgelegtes Repertoire hinausgehen (z.B. Fahrkartenbestellung bei der Bahn). Viele Skeptiker halten generell Bewusstsein in Maschinen für unmöglich. Die Computerindustrie arbeitet dennoch unverdrossen an der Erfüllung ihres erklärten Zieles, mit den Apparaten wie mit Menschen zu kommunizieren. Der Tag, an dem ein Millionenheer von Sekretärinnen durch anwenderfreundliche Maschinen ausgetauscht wird, scheint aber noch in weiter Ferne, solange kein Computer den Sinn der Sprache erfasst, die er aufnimmt, speichert und von sich gibt.

- Sinn und Bewusstsein stehen in einem engen Zusammenhang zueinander.

Was verstehen wir unter 'Sinn' ?

Während der Begriff „Bewusstsein“ als ein heiß umstrittener Schwerpunkt der interdisziplinären Kognitionsforschung äußerst kontrovers diskutiert wird, und in unzähligen Veröffentlichungen immer wieder neue Hypothesen zu seiner Erklärung aufgestellt werden, erscheint der Begriff „Sinn“ in der Sprache der Wissenschaft ebenso wie im alltäglichen Sprachgebrauch völlig selbstverständlich, als ob jeder Mensch schon wüsste, was darunter zu verstehen sei.

So findet man z. B. in einem philosophischen Wörterbuch (G. Klaus 1969) unter 'Sinn': „Der Mensch allein ist bewusster Gestalter von Sinn, und er allein kann durch seine Tätigkeit den Dingen und Prozessen einen Sinn verleihen.“ - Mehr nicht als diese zirkuläre Erklärung! Was Sinn ist, wird mit Sinn erklärt! Den Umgang mit Sinn auf Menschen zu begrenzen, ist überdies mit Blick auf die geistigen Leistungen der Säugetiere, Menschenaffen, Delphine usw. zumindest fragwürdig.

Ebenso fragwürdig bleibt auch der Versuch des Mathematikers G. Frege (1892), Sinn und Bedeutung zu trennen, Bedeutung nur auf den Inhalt von wahren Sätzen zu begrenzen und Sinn als den reinen Ausdruck der Zeichen zu definieren.

Es lässt sich leicht nachweisen, dass die Sinndefinition der mathematischen Aussagenlogik für den größten Teil der menschlichen Sinnerzeugnisse zu eng ist. Das wird deutlich, wenn wir an Kunstwerke denken. Aber auch schon in der Umgangssprache wird Sinn vermittelt, der mit Logik nicht erfassbar ist. Fragen, Befehle, Witze und Lügen haben einen Sinn, der mit den Kategorien 'richtig-falsch' oder 'wahr-unwahr' nicht zu erfassen ist.

Nehmen wir dazu folgendes Beispiel: Der Satz “Hände hoch oder ich schieße“ wird in einem völlig anderen Sinn aufgenommen, wenn er aus dem Mund eines Knaben mit Wasserpistole kommt, als wenn ein Gangster mit echtem Schießeisen ihn äußert. Der Sinn ist offensichtlich abhängig von seiner Einbindung in die ganze Lebenssituation.

Mit dieser Abhängigkeit vom Kontext kann Sinn nur solchen Geschöpfen zugänglich sein, die eine organisch-ganzheitliche Verbindung mit der Umwelt erfassen und bewerten können. Darum entzieht Sinn sich jeder Objektivierung. Sinn ist und bleibt immer die subjektive Bewertung durch ein Individuum. Sie ist subjektiv, weil sie immer auf eine sehr persönliche gefärbte Vorstellungswelt zurückgreift. Zum Beispiel assoziiert bei den Worten „Glück“ oder „Unglück“ jeder Mensch etwas anderes. Selbst bei „Salz“ und „Wasser“ stellen sich unterschiedliche Assoziationen ein.

Von den Naturwissenschaften, die mit objektiv nachvollziehbaren Erkenntnissen zu tun haben, kann keine Klärung des Begriffes erwartet werden, obwohl der Begriff 'Sinn' auch dort ausgiebig benutzt wird.

In den Geisteswissenschaften dagegen gibt es eine Richtung, die der Auslegung von Sinn verpflichtet ist: die Hermeneutik, die Wissenschaft von der Sinndeutung eines Textes. Sie geht davon aus, dass es in den meisten Fällen möglich ist, trotz der unterschiedlichen subjektiven Erfahrungen festzustellen, was ein Text objektiv sagen will. Objektiv heißt hier: die einzelnen Textausleger kommen im Allgemeinen unabhängig voneinander zu übereinstimmenden Ergebnissen. Wir hoffen zum Beispiel, dass unsere Leser wenn sie diesen Absatz lesen, in etwa übereinstimmend verstehen, was wir sagen wollen. Wie funktioniert dieses Verstehen der Sprache, das ist unsere Frage.

Diese alte Hermeneutik der Textauslegung wird heute als altmodisch angesehen und ist in Vergessenheit geraten. Als 'modern' gilt die neue Universal-Hermeneutik eines Heidegger und Gadamer, die von den Verfechtern der alten Hermeneutik kritisiert wird, zum Beispiel von Hans Albert in seinem Buch Zur Kritik der reinen Hermeneutik.

Mir ist es bisher nicht gelungen, aus der mir zugänglichen Sprachwissenschaft oder Philosophie eine klare Vorstellung von dem Begriff Sinn zu erhalten, obwohl kaum ein Autor ohne dessen Gebrauch auskommt. Dieser Begriff taucht in so vielen Variationen in der Umgangssprache auf und wird dabei schon von jedem Schulkind leicht verstanden, dass anscheinend in der Wissenschaft kein Bedürfnis nach der Bestimmung seiner Bedeutung besteht.

Unterscheidung von Definition, Begriff und Kriterium

Nun gibt es, wie wir wissen, auch keine befriedigende Definition des Wortes „Zeit“ und doch weiß jeder, was der Sinn des Wortes ist. Augustinus sagt: „Wenn du mich fragst, was Zeit ist, weiß ich es nicht. Wenn du mich nicht fragst, weiß ich es.“ Wir haben also einen brauchbaren (intuitiven) Begriff von Zeit.

Und wir haben auch ein sehr gutes Kriterium dafür, festzustellen, was Zeit ist: die Uhrzeit, die wir vom Ziffernblatt ablesen. Messen können wir sie exakt. Exakt sagen, was Zeit ist, können wir nicht.

Also: Was uns fehlt ist eine exakte Definition, aber der Sinn des Begriffs ist uns klar, und wir wissen auch, wie man Zeit misst: Es fehlt uns an nichts.

Auch die Definition von Wahrheit ist schwierig. Aber hier gibt es tatsächliche eine wissenschaftliche Definition. Sie wurde von dem polnisch-amerikanischen Logiker Alfred Tarski geliefert. Sie umfasst ein ganzes Buch. Aber suchen wir denn nach einer Definition? Was die Wahrheit betrifft genügt es, die Bedeutung des Wortes zu kennen, damit wir wissen, worüber wir sprechen, wenn wir von Wahrheit reden: „Wahrheit ist die Übereinstimmung mit den Tatsachen“. Das ist nicht die Definition, aber die Bedeutung des Wortes 'Wahrheit'. In diesem Sinne kennen wir sie aus dem Alltagsdenken. Ein Kriterium für Wahrheit gibt es übrigens nicht (siehe Münchhausen-Trilemma).

Darauf wollen wir hier nicht eingehen; denn etwas anderes ist wichtig: Wir müssen bei Wörtern wie Zeit, Wahrheit, Sinn und überhaupt bei allen Substantiven scharf unterscheiden zwischen Begriff, Definition und Kriterium (siehe Niemann, im Lexikon des Kritischen Rationalismus den Eintrag 'Begriff-Definition-Kriterium').

Wonach suchen wir hier im Zusammenhang mit Sinn? Wir suchen nach dem Begriff von 'Sinn', die Art wie wir den Sinn eines Wortes oder eines Satzes 'begreifen'. Die Suche nach dem Sinn von 'Sinn' könnte man nennen, oder nach der Bedeutung von 'Bedeutung'; denn beide Wörter sind in diesem Zusammenhang Synonyme (im Englischen 'meaning', was hier wichtig ist, da es dort eine umfangreiche Literatur zu diesem Thema gibt).

Nicht nach der strengen Definition suchen wir. Deren Fehlen stört nicht weiter, denn sie liegt auch bei dem Wort 'Zeit' nicht vor und auch bei 'Wahrheit' interessiert sie nur ganz wenige Spezialisten.

Viele Philosophen haben sich mit dem Sinn des Wortes 'Sinn' beschäftigt. Einige Philosophen des Wiener Kreises in der ersten Hälfte des letzten Jahrhunderts zum Beispiel behaupteten: Der Sinn des Satzes zeigt sich in seiner Verifikation, also in seiner Bewahrheitung. Damit meinten sie: Man muss überlegen, was den Satz wahr macht, dann begreift man, ob und welchen Sinn er hat. Also zum Beispiel, wenn man nach dem Sinne des Satzes fragt, „Wie ist es, eine Fledermaus zu sein?“ (Siehe Thomas Nagels berühmten Aufsatz „What is it like to be a Bat?“). Dazu müsste man dann wissen, wie man diesen Satz verifizieren könnte. Die Frage ist, (A) Sieht man die Sache aus der Perspektive eines Menschen? Oder (B) aus der Sicht der Fledermaus? Der Fall (A) ist verifizierbar, aber er bringt wohl nicht den vollen Sinn des Satzes zutage. Der Satz (B) ist nicht verifizierbar und in diesem Sinne werden wir den Sinn des Satzes niemals erfassen können.

Soweit die Philosophen. Sie interessieren uns nur am Rande. Denn wir wollen wissen: Wie macht es das Gehirn, um aus einer Reihe von Wörtern die Bedeutung eines Satzes zu gewinnen?

Sinn und Bewusstsein

Wir hatten mit Turing gesagt, dass es einen engen Zusammenhang zwischen Sinnverstehen und Bewusstsein gebe. Und der Bordcomputer HAL verdeutlichte, wie entscheidend die Frage nach dem Sinnverstehen für die Frage „Existiert dort ein Bewusstsein?“ ist. Wissen wir über das Bewusstsein etwas, das Licht auf den Prozess wirft, einem Satz Bedeutung abzugewinnen? Daher jetzt einige Gedanken über den sprachlichen und über den beobachtbaren Zusammenhang zwischen Sinn und Bewusstsein.

Während der moderne Begriff vom menschlichen Bewusstsein erst von Descartes geprägt und 1719 von Christian Wolff in den deutschen Sprachraum eingeführt wurde, kam das Wort 'Sinn' schon bei den griechischen und römischen Philosophen in der Beschreibung der ganzheitlichen Erkenntnisfähigkeit der Menschen (sensus communis) zu seiner Bedeutung.

Der Gedanke eines allumfassenden Sinnes (sensus communis) wurde von Aristoteles in dem Vermögen begründet, mit dem Gegenstand zugleich die Wahrnehmung des Gegenstandes selber wahrzunehmen und daher die äußeren Sinne unterscheiden zu können. Dank dieses umfassenden Sinnes, der als ein innerer Sinn wirkt, haben wir Zugang zu dem, was den Sinnen gemeinsam ist, wie Bewegung, Ruhe, Zahl und Größe sowie deren Begrifflichkeit.

Als common sense, Gemeinsinn oder „innerer Sinn“ wurde dieser „Sensus communis“ in der alten Philosophie ausgiebig diskutiert, aber bisher noch nicht mit einer naturalistischen Theorie in Verbindung gebracht.

Parallel dazu wurde in den letzten Jahrhunderten der Begriff 'Bewusstsein' zum schillernden Leitthema der Philosophie, Psychologie, Kognitionsforschung, Linguistik usw...

Das Verhältnis von Sinn und Bewusstsein lässt sich gut an gebräuchlichen Redewendungen erkennen. Bewusstlos oder besinnungslos liegt jemand am Boden und kommt dann wieder zum Bewusstsein oder zur Besinnung. Die beiden Begriffe können hier ohne Verlust ausgetauscht werden.

Der Unterschied zwischen Sinn und Bewusstsein wird erst deutlich, wenn über Tätigkeiten gesprochen wird.

Fast jede Handlung vom morgendlichen Aufstehen bis zu den abendlichen Ritualen ist in einer Weise sinnvoll. Wenn ich gefragt werde, warum ich das und jenes tue, so kann ich eine Begründung nennen, worin ein Sinn enthalten ist.

Sinnlose Handlungen kennen wir von Kleinkindern, sinnlos Betrunkenen oder Schwachsinnigen. Da sprechen wir nie von bewusstlosen Handlungen.

Wenn ich über etwas nachsinne, sinniere, und schließlich, lange Rede, kurzer Sinn, etwas Eigensinniges sinnfällig zu Papier bringe, dann entdeckt ein Leser darin sinngemäß oder auch tiefsinnig entweder Sinn oder Unsinn, vielleicht auch Wahnsinn, Schwachsinn, Blödsinn. Die Begriffe „Bewusstsein“, „Unbewusstsein“ oder gar „Wahn-“ bzw. „Schwach-“ oder „Blödbewusstsein“ wären hier fehl am Platz.

So lässt sich mit dem üblichen Sprachgebrauch und mit dem, was wir im Alltagsleben beobachten, die Grenze zwischen Sinn und Bewusstsein umreißen.

Sinn meint immer den aktuellen Inhalt von Bewusstsein, also Strukturen und deren Verbindungen im ganzheitlichen Zusammenhang der Wahrnehmungen, Handlungen und Gefühle eines Subjektes. Wir erleben Sinn als eine Gesamtschau, die in jedem Augenblick beurteilend auf das Verhalten einwirkt, indem sämtliche Gedächtnisspuren aus der Vergangenheit und Pläne über die Zukunft, unser Weltwissen, mit der aktuellen Situation und deren Folgerungen in Einklang (oder Widerspruch) gebracht werden. Sinn ist somit die Quintessenz des Bewusstseins, die jeden Moment ein ganzheitliches Verhalten auf der Basis einer ganzheitlichen Zusammenfassung aller Wahrnehmungen, Gefühle und Gedächtnisspuren erzeugt.

Wenn ich etwas sehr bewusst, mit größter Aufmerksamkeit erlebe, muss das keineswegs sehr sinnvoll sein, z. B. der Wahnsinn des Krieges. Man kann oft beobachten, dass unser Bewusstsein durch Sinnwidriges alarmiert wird, während die vielen sinnhaltigen Wahrnehmungen und Tätigkeiten uns nicht besonders erregen, sondern eher beruhigen.

Als Beispiel für die Alarmwirkung einer sinnwidrigen Wahrnehmung vergesse ich nie den Abend im Februar 1990, an dem ich auf einen Balkon trat und in den klaren Winterhimmel schaute. Ich sah den Mond als eine schmale Sichel und war einen Moment wie verwirrt, wusste aber nicht warum, bis meine Erinnerung an den Vollmond des vorigen Abends sich meldete und mein Verstand empört sagte: „Das kann doch nicht wahr sein!“ Erst der bald folgende Gedanke an die Möglichkeit einer Mondfinsternis verwandelte die sinnwidrige Beobachtung in Sinn und beruhigte mein Gemüt, nachdem eine Radiomeldung ihn bestätigte.

An dieser Erinnerung lässt sich erkennen, dass eine beliebige Wahrnehmung augenblicklich mit dem ganzen Gedächtnisinhalt verglichen werden muss, bevor sie von dem Sinn-Ganzen akzeptiert und aufgenommen wird. Das Bewusstsein ist erst beruhigt, wenn eine Wahrnehmung sich widerspruchslos in das Ganze der Gedächtnisorganisation eingliedern lässt und damit Sinn ergibt.

Ähnliche Beispiele kennt jeder Mensch aus seinem Leben, wenn eine vertraute Umgebung, ein bekannter Mensch oder das eigene Auto irgendwie geringfügig verändert, etwas Befremdendes. Das regelmäßige Ticken einer Uhr wird kaum noch bewusst wahrgenommen. Kommt die Uhr durch einen Defekt aus dem Rhythmus, so wird die Abweichung schnell bemerkt.

Mein Vorschlag, das Verhältnis von Sinn und Bewusstsein auf einen einfachen Nenner zu bringen, besteht darin, dass ich Bewusstsein als eine Tätigkeit verstehe, als bewusstes Sein, was nichts anderes bedeutet als „Sein mit deklarativem Wissen“, welches durch das Gedächtnis „in Erinnerung“ gehalten wird. Das ständige Ziel dieser Tätigkeit ist die Herstellung von Sinn aus dem ganzheitlichen Produkt aller Sinnesorgane, Gefühle und dem „Weltwissen“ im Gedächtnis.

Weil das Überleben des Individuums mit dieser Ganzheitsschau und der daraus abgeleiteten Möglichkeit zum ganzheitlich-sinngemäßen Handeln abgesichert werden soll, wirken Sinnwidrigkeiten bei der Sinnproduktion ähnlich wie der Schmerz alarmierend, aufregend, während sinnvolle Routinen mit jeder Wiederholung weniger Aufmerksamkeit erfordern, zunehmend automatisiert werden können. Das zeigt sich z. B. beim Autofahren, wo ungewöhnliche Sinnesmeldungen sofort beachtet werden müssen, während die routinierten Schaltvorgänge kaum noch wahrgenommen werden.

Wer sich noch an seine erste Fahrstunde erinnert, der weiß, wie schwierig die gleichzeitige Bedienung von Kupplung, Schalthebel, Bremse und Lenkung am Anfang war, und welche lebenswichtige Erleichterung durch die Automatisierung der Bewegungen erfolgt.

Die Beispiele von der Mondfinsternis, der befremdenden Veränderung, der kaputten Uhr und der Verkehrssituation machen deutlich, dass unser ständiges Bemühen um Sinnbildung nicht auf Kunst und Sprache beschränkt ist, sondern zunächst nur der Orientierung dient, indem alle Sinnesorgane eine ganzheitliche Verbindung mit dem Gedächtnis und den Gefühlen des Individuums erhalten und mit ihnen eine organische Einheit, den Sinn, erzeugen. Nichts spricht dagegen, dass diese lebenswichtige Tätigkeit sich im Lauf der Evolution entwickelt hat, das heißt auch: genetisch bedingt ist und einer naturalistischen Erklärung zugänglich sein muss!

Daraus ergeben sich Fragen:

1. Ist die Fähigkeit zur Sinnfindung auf den Menschen beschränkt, oder gibt es ähnliche Fähigkeiten im Tierreich?

Bei dieser Frage muss anerkannt werden, dass Lebewesen auf allen Entwicklungsstufen Vorgänge aufweisen, die uns sinnvoll im Hinblick auf die Erhaltung des Lebens erscheinen. Ein qualitativer Unterschied der menschlichen Intelligenz kann aber darin gesehen werden, dass Menschen den Sinn bewusst erfassen, das heißt im Zusammenhang mit ihrem Weltwissen und ausdrückbar und kommunizierbar mittels der Sprache.

2. Wird der Sinn von Menschen (oder eventuell auch von anderen Lebewesen) aus einer sinnlosen Umwelt als „Konstruktion“ hergestellt, oder existiert er bereits in der Natur und wird vom Menschen nur entdeckt bzw. vorgefunden?

Diese Frage wurde z. B. von dem Philosophen Nicolai Hartmann so beantwortet: „Sinn kann es nicht an sich, sondern nur „für jemand“ geben.“

Die Welt also kann keinen Sinn haben vor dem Auftreten des geistig-sinnempfänglichen und sinnverstehenden Wesens in ihr. Sinn ist hier als „erklärendes Ziel“ gemeint. Ich verstehe den Sinn der Welt, wenn ich wüsste, wozu sie geschaffen ist oder wohin sie geht usw.

Diese auch von J. P. Sartres Existenzialismus verbreitete Auffassung erscheint mir auch heute im „westlichen Denken“ allgemein gültig zu sein.

Im „östlichen Denken“ des chinesischen Taoismus begegnet uns dagegen im Begriff des „TAO“ (= Sinn) eine tiefgründige Auslegung, die zu einem gegensätzlichen Ergebnis führt.

Bekanntlich wird das Weltall in der chinesischen Philosophie auf das Wirken der beiden polaren Weltprinzipien Yin und Yang zurückgeführt. Der Sinn, chinesisch Tao, ist dasjenige, was das Spiel dieser „Kräfte“ in Bewegung bringt und unterhält. Weil dieses Etwas nur eine Richtung bedeutet, die unsichtbar und völlig unkörperlich ist, hat man im Chinesischen das Wort Tao = „Weg, Lauf“ dafür gewählt, der ja auch nichts in sich selber ist, und doch alle Bewegungen regelt.

Yin und Yang kommen nicht zum Stillstand, der Kreislauf des Werdens setzt sich dauernd fort. Der Grund dafür ist, dass zwischen den beiden Urkräften immer wieder ein Spannungszustand entsteht, ein Gefälle, das die Kräfte in Bewegung hält und zu ihrer Vereinigung drängt, wodurch sie sich immer wieder neu erzeugen. Wie das konkret geschieht, wird durch Tao, den Sinn bewirkt, ohne dass dieser dabei irgendwie in Erscheinung tritt, sein Walten ist unsichtbar.

Diese östliche Sicht enthält eine Logik, die der westlichen Auffassung fehlt:

Logisch kann eine sinnbildende Tätigkeit nur dann zur Orientierung dienen, wenn dem subjektiv offenbarten Sinn ein objektiver Sinn der Wirklichkeit zu Grunde liegt. Ohne diesen natürlichen Zusammenhang wäre Sinn sinnlos, eine private Konstruktion ohne praktischen Überlebenswert.

Bleiben wir dabei, dass die Sinnfindung eine alltägliche Lebensnotwendigkeit ist, dann können wir die Fähigkeit der Sprache, Sinn von Mensch zu Mensch weiter zu geben, als außerordentlichen Fortschritt der Evolution bewundern.

Kehren wir wieder zur Bedeutung des Sinnes in der Sprache zurück, die uns wie Ariadnes Faden durch das Labyrinth unseres Weltbildes führt.

Sprache macht Sinn zwischen Menschen mitteilbar, indem Sinn in eine genaue Reihenfolge von Sprachzeichen gegliedert wird, aus welcher er vom Empfänger rekonstruiert werden kann.

Für meinen Versuch, Sinn zu beschreiben, habe ich jetzt eine exakte Reihenfolge aus zigtausend Buchstaben, Satzzeichen und Pausen hergestellt, damit Tausende von Wörtern gebildet und mit denen eine genau durchdachte Reihenfolge von Sätzen festgelegt.

Jeder Leser ist mit Sinn bestens vertraut, selbst täglich darum bemüht, und ich kann annehmen, dass er auf bekanntem Terrain voranschritt, als er meinen Wortreihen folgend einige Gedanken über das kurze Wort Sinn in das Zentrum seiner Aufmerksamkeit stellte.

Ebenso vertraut ist jedem Menschen die Sprache. Wir behalten den Sinn im Auge, wenn wir der Fähigkeit der Sprache, Sinn zum komprimierten Ausdruck zu bringen, im nächsten Teil mit weiteren Überlegungen nachgehen.

Am Anfang war der Rhythmus

Der Vergleich der Wörter mit den Samen in dem biblischen Gleichnis des Nazareners hatte zu der Ansicht geführt, dass die Wörter ebenso wie die Samen große, komplizierte Gebilde erzeugen, indem sie wie die Samen als Bauanleitung wirken.

Die Frage ist: Wie kann man sich eine Bauanleitung für die sprachliche Komprimierung von Sinn vorstellen?

Es wurde im ersten Kapitel auch schon geschrieben, dass eine mathematische Darstellung von Gegebenheiten dadurch ihren Wert erhält, dass mit ihr auch komplizierte Dinge und Vorgänge in kürzester, und dadurch überschaubarer Form präzise ausgedrückt werden können.

Deshalb gilt in der Wissenschaft ein Problem erst dann für optimal erklärt, wenn es in einer mathematischen Formulierung vorliegt.

So können wir den Schluss ziehen, dass wir eine Bauanleitung für Sprache erst dann richtig verstehen und uns eine genaue Vorstellung davon machen können, wenn eine mathematische Beschreibung dafür möglich ist.

Lieber Leser, Sie sollen jetzt nicht befürchten, dass Sie mir nun nicht mehr folgen können, wenn ich auf eine mathematische Betrachtung der Sprachfähigkeit und der Begriffe „Sinn, Wissen, Gedächtnis“ hinarbeite. Ich verstehe selbst nicht allzuviel von der Rechenkunst und kann deshalb nur laienhaft mit dieser Sprachform umgehen. Trotzdem werde ich versuchen, den Satz: „Das Einfache ist das Siegel des Wahren“ (simplex sigillum veri) mit einem sehr einfachen mathematischen Modell von Sinnerzeugung und Sprachfähigkeit zu bestätigen, ein Modell, das mit ein wenig Mühe auch von Ihnen, verehrter Leser, begreifbar ist.

Ein mathematisches Modell für eine Herstellungsvorschrift, eine Bauanleitung, ein Rezept, eine Bedienungsanleitung und dergleichen nennt man in der Mathematik einen Algorithmus, wenn alle einzelnen Schritte dieser Anleitung präzise definiert sind.

Zum Beispiel bei einem Kuchenrezept sind in einer bestimmten Reihenfolge die genauen Mengen der Zutaten in einer präzisen Handlungsanweisung zusammenzubringen und in vorgeschriebener Zeit auf bestimmte Temperaturen zu erhitzen, mathematisch gesprochen ist jedes Rezept ein Algorithmus.

Es gibt unzählige Algorithmen, einfache und sehr komplizierte. Jedes Computerprogramm besteht aus einem großen Algorithmus, der meistens aus sehr vielen kleineren Algorithmen besteht, die miteinander verknüpft sind.

Wenn wir also in der großen Menge möglicher Algorithmen eine mathematische Vorschrift suchen, die uns als Modell für die Erzeugung von Sinn und dessen Komprimierung in kurze Zeichenketten dienen kann, dann muss zuerst einmal genau formuliert werden, was dieser Algorithmus können muss.

Der Begriff „Sinn“ wurde im vorigen Abschnitt als ein sich ständig neu bildendes Integrationsprodukt aller Sinnesorgane und Gefühle mit unserem ganzen Weltwissen beschrieben, bei dem alles mit allem in Verbindung steht, wie in einem Organismus.

Die Sprache verknüpft große Teile von Sinn und bringt sie in die Form einer exakt gegliederten Zeichenfolge, aus welcher der Empfänger die Sinnverbindung rekonstruieren kann, wenn er der Artikulation aufmerksam folgt.

Ein Algorithmus, der diese Aufgabe erledigen kann, muss immer wieder schnell neue Sinnkomlexe erzeugen, alte wieder löschen können. Der Vergleich mit der rhythmisch wiederholenden Zellteilung in biologischen Systemen legte bereits eine rhythmisch wiederholende Tätigkeit bei der Sinnproduktion nahe.

Auch mit einem vergleichenden Blick auf die Technik lässt sich vermuten, dass diese Aufgabe wie bei einem Monitor in einer rhythmischen Tätigkeit bewältigt werden muss, um der aktuellen Situation in jedem Moment eine neue Struktur zu geben. Das kann nur mit einem Algorithmus realisiert werden, der in Bruchteilen einer Sekunde Sinn erzeugt, um ihn sofort wieder zu löschen, neue Eindrücke zu neuem Sinn zu formen, zu löschen usw., also ein rhythmisch wiederholender Vorgang, wie zum Beispiel die Abtastfrequenz bei elektronischen Bildschirmen.

Die Natur gibt uns viele Hinweise dafür, dass die geistigen Tätigkeiten in einer rhythmischen Form geschehen.

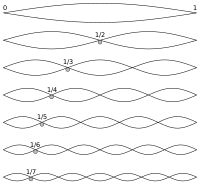

Zuerst können wir in der Sprache schon einen Sprachrhythmus feststellen, der bei allen Sprachen ungefähr im gleichen Bereich liegt.

Bei entspanntem Sprechen werden ungefähr zwei Artikulationen in einer Sekunde erzeugt, schnelleres Sprechen ist nur bis zu einer Grenze von circa sechs Artikulationen pro Sekunde möglich. Man braucht nur laut von einundzwanzig bis neunundzwanzig zu zählen, um den Sprachrhythmus und die Grenzen seiner Geschwindigkeit zu erfahren.

Die Eingabe von Sprache in eine Tastatur und das flüssige Schreiben von Hand zeigen ebenso einen Arbeitstakt dieser Tätigkeiten, der sich am deutlichsten in der Musik untersuchen lässt.

Eine rhythmische Tätigkeit ist auch das Lesen. Untersuchungen der Augenbewegungen beim Lesen zeigen einen Rhythmus, der circa 4-5 sprungartige Folgebewegungen der Augen in einer Sekunde hervorbringt.

Schließlich können wir noch anführen, dass die meisten Bewegungen eine rhythmische Komponente haben: Gehen, Schwimmen, Essen, viele Arbeiten, zum Beispiel das Stricken, Rühren, Hämmern usw. sind rhythmische Tätigkeiten mit einer ähnlichen Grenzgeschwindigkeit wie Sprechen und Lesen, also höchstens circa fünf Zyklen pro Sekunde.

Halten wir fest,

- (I) dass es zahlreiche Hinweise für einen Arbeitstakt der geistigen Tätigkeit, also des gesuchten Algorithmus, der Sinn und Sprache erzeugt, gibt.

Die nächste Forderung an eine Erzeugungsvorschrift von Sinn betrifft den

- (II) organisch-ganzheitlichen Zusammenhang des Sinn-Ganzen,

der sich auch in der Sprache zeigt. Wilhelm von Humboldt, der Vater der allgemeinen Sprachwissenschaft, beschrieb diesen Zusammenhang so:

„Man kann die Sprache mit einem ungeheuren Gewebe vergleichen, in dem jeder Theil mit dem anderen, und alle mit dem Ganzen in mehr oder weniger deutlich erkennbarem Zusammenhang stehen. Der Mensch berührt beim Sprechen, von welchen Beziehungen man ausgehen mag, immer nur einen abgesonderten Theil dieses Gewebes, thut dies aber instinktgemäß immer dergestalt, als wären ihm zugleich alle, mit welchen jener einzelne nothwendig in Übereinstimmung stehen muss, im gleichen Augenblick gegenwärtig.“ An anderer Stelle schrieb Humboldt: „Die Sprache ist, wie es aus ihrer Natur selbst hervorgeht, der Seele in ihrer Totalität gegenwärtig, d.h. jedes Einzelne in ihr verhält sich so, dass es Anderem, noch nicht deutlich gewordenem, und in einem durch die Summe der Erscheinungen und die Gesetze des Geistes gegebenen oder vielleicht zu schaffenden möglichen Ganzen entspricht.“

Wie kann so ein Gebilde, in dem unser ganzes Weltwissen mit der Wahrnehmung und Gefühlen zu einem Ganzen zusammengefasst wird und mit Sprache ausdrückbar ist, von einem mathematischen Modell, einer Rechenvorschrift, vereinfacht dargestellt werden? Wahrscheinlich werden alle Sprachwissenschaftler selbst Mathematiker an dieser Möglichkeit zweifeln, was uns nicht davon abhält, der Frage weiter nachzugehen.

Eine Spur zur Lösung des Problems oder dem gesuchten Algorithmus finden wir in der nächsten Anforderung, die

- (III) den Begriff der Grenze in das Zentrum unserer Überlegungen rückt.

Es sind die Fähigkeiten zum Unterscheiden und zum Entscheiden, die unserem Sinn und der Sprache erst die Möglichkeit geben, die Welt in einzelne Objekte zu differenzieren und einzuteilen und unterschiedlich darauf zu reagieren. Das Wort „Scheide“ ist bekanntlich ein altes Synonym für Grenze.

Wir teilen (mit Grenzen) die Welt ein in verschiedene Objekte und entscheiden (mit Grenzen) in jedem Moment, was gerade sinnvoll zu tun ist. Die wesentliche Anforderung an einen Algorithmus, der diese Aufgabe erfüllen soll, muss also darin bestehen, Grenzen zu erzeugen.

Grenzen, die einen ganzheitlichen Zusammenhang bilden, nennen wir „Gestalt“.

Wenn wir die Schöpfungsgeschichte der Bibel lesen, finden wir den Beginn der Welt in der Trennung von Tag und Nacht, Himmel und Erde, Wasser und Land, und es sind seitdem sicher unzählige weitere Trennungen dazugekommen, die das Sinn-Ganze des heutigen Menschen in eine Begriffswelt einteilen, die zur Orientierung dient, indem sie mit der Objektwelt in Übereinstimmung ist.

Ein rhythmisch sich wiederholender Algorithmus, der mir als mathematisches Modell für die Sinn- und Sprachproduktion vorschwebt, sollte demnach hauptsächlich Grenzen erzeugen, unzählig viele und komplizierte Grenzen, die alle innerhalb des Sinn-Ganzen miteinander verknüpft sind.

„Die Grenzen meiner Sprache bedeuten die Grenzen meiner Welt“, schrieb Ludwig Wittgenstein, und Wilhelm von Humboldt fasste den Gedanken in den Sätzen:

„Der Umfang des Wortes ist die Gränze, bis zu welcher die Sprache selbstthätig bildend ist“ und „Dies setzt natürlich eine große Schärfe der abgränzenden Beziehungen, da wir vorzüglich von diesen reden, aber auch eine gleiche in den Lauten voraus.“

Mit anderen Worten: Mit einer abgrenzend wirkenden Artikulation der Sprache werden Grenzen für die Bedeutung, den Umfang und den Sinn der Wörter und Sätze erzeugt, wird Verschiedenes unterschieden und entschieden. Ein Algorithmus der geistigen Tätigkeit muss in gleichförmiger Tätigkeit Grenzen erzeugen, wenn er Sinn und Sprache begreifbar machen soll.

Als weitere Forderung muss noch

- (IV) der Begriff Ähnlichkeit mit dem Konzept verbunden werden.

Um die Bedeutung von „Ähnlichkeit“ zu verstehen, erinnere ich an das „Höhlengleichnis“ des griechischen Philosophen Plato.

Plato beschrieb unsere eingeschränkte Fähigkeit zur Erkenntnis der Welt mit der Situation von Menschen, die in einer Höhle mit dem Gesicht zur Wand sitzen und auf der Wand nur die Schatten der Objekte wahrnehmen, die mit dem Licht vom Höhleneingang in die Höhle gelangen.

Das Höhlengleichnis ist ein schönes Bild, das die Bedeutung von Grenzen (Schatten) unterstützt und unser mangelhaftes Wissen entschuldigt, aber es bietet keine Erklärung dafür, warum die Menschen trotz behinderter Erkenntnismöglichkeit zu dem enormen Wissen gekommen sind, mit dem sie heute umgehen.

Diese Erklärung schaffen wir durch eine Erweiterung des Höhlengleichnisses mit Hilfe des Begriffes „Ähnlichkeit“:

Die Bewohner der Höhle sehen nur die Grenzen der Dinge, aber darin können sie Ähnlichkeiten entdecken und so zu einer Einteilung der Objekte und zum (eingeschränkten) Wissen über die Welt gelangen.

Die biologische Fähigkeit zum Entdecken von Ähnlichkeiten muss nicht weiter bewiesen werden, denn sie gehört mit Sicherheit zu den elementaren Qualitäten der Sinnesorgane im gesamten Tierreich.

- (V) Pars pro toto

Schließlich soll noch die sprachliche Komprimierung der ähnlichen Grenzgebilde durch das mathematische Modell anschaulich gemacht werden.

Diese komprimierte Form der Sinngrenzen in kurzen Folgen von Lauten oder Buchstaben lässt sich in vornehmem Latein als Pars-pro-toto-Funktion benennen, also: „Ein Teil steht für das Ganze“.

Was mit „Pars pro toto“ gemeint ist, lässt sich mit der Spurensuche erklären, die unsere Vorfahren bei der Jagd zur hohen Kunst entwickelt hatten.

Aus winzigen Fußspuren, abgeknickten Gräsern usw. können Jäger oder Detektive umfangreiche Zusammenhänge „lesen“. Heute genügen schon mikroskopische DNA-Spuren, um einen Täter zu identifizieren, ein Teil steht für das Ganze. Dass diese Fähigkeit nicht nur Menschen, sondern auch Hunden zu eigen ist, merkt ein Hundehalter oft, wenn er z.B. die Leine in die Hand nimmt, und der Hund schon zur Tür läuft, weil er die Bedeutung der Geste versteht, pars pro toto.

Zusammenfassend muss eine Vorschrift zur Erzeugung von Sinn und Sprache in schneller Taktfolge komplizierte Grenzen in organischem Zusammenhang produzieren, wobei eine Ähnlichkeit der Sinngrenzen einer Ähnlichkeit der Objektgrenzen entspricht. Die individuellen Grenzformen der Begriffsgestalten sind durch eine „Pars-pro-toto“-Funktion untrennbar mit kurzen Zeichenfolgen verbunden, die als Sprache funktionieren.

Mathematikstunde

Die Anforderungen, die an eine Bauanleitung für Sinn und Sprache zu stellen sind, erscheinen sehr schwierig zur Vorstellung oder Realisierung zu sein.

Als Wissenschaftler stellt man oft mit Staunen fest, dass die Natur sehr komplizierte Dinge mit sehr einfachen Mitteln herstellen kann. Sinn und Sprache sind die kompliziertesten Produkte der Natur. Es soll uns nicht wundern, wenn deren Rätsel auch eine sehr einfache und schöne Lösung erhält.

Es wurde schon erwähnt, dass die mathematische Sprachform besonders gut zur übersichtlichen Darstellung komplizierter Dinge geeignet ist.

Wir beginnen also eine kurze Mathematikstunde mit der Formulierung der Aufgabe, die in mathematischer Darstellung als Algorithmus gelöst werden soll:

Gesucht wird ein Algorithmus, der in rhythmischer Abfolge durch Grenzbildung ein lebendig wachsendes Sinnsystem erzeugen kann, in dem unendlich viele ähnliche und unterscheidbare Gestalten mit einer „Pars pro Toto“-Funktion durch kurze Zeichenfolgen repräsentiert werden können.

Algorithmische Grenzbildung

Die einfachste Form einer Grenze, zwei Grenzpunkte auf einer Linie, erhalten wir durch die ständige Abfolge einer sehr einfachen Vorschrift, der wiederholten Quadrierung (Iteration). Wenn der Ausgangswert, die Zahl, mit der ich die Quadrierung beginne, größer als Eins ist (>1) , dann werden alle folgenden Ergebnisse immer größer, sie gehen gegen Unendlich.

Beispiel: 2,4,16,..........

Umgekehrt werden die Ergebnisse immer kleiner und gehen gegen Null, wenn der Ausgangswert kleiner als Eins (<1) ist.

Nur mit der Eins kann der Vorgang beliebig oft wiederholt werden, das Ergebnis bleibt immer gleich Eins, die Eins ist ein somit Grenzpunkt auf der Zahlengeraden. Das Gleiche gilt auch, wenn ich das Vorzeichen 'Minus' benutze , für Minus-Eins.

Wir halten fest: Bei der iterierten Quadrierung der reelle Zahlen erhalten wir zwei Grenzpunkte, die wir uns auf der Zahlengeraden bei Eins und Minus-Eins vorstellen können.

Damit ist noch nicht viel erreicht, aber wir verstehen das nächste Grenz-Beispiel als Produkt wiederholter Quadrierung nun ohne große Schwierigkeit.

Verwenden wir bei der Quadrierung nicht reelle Zahlen, sondern komplexe Zahlen (mit einem imaginären und reellen Anteil), dann halten wir uns gedanklich nicht mehr auf einer geraden Linie auf, sondern in der zweidimensionalen (Gaußschen) komplexe Zahlenebene. Auch hier erzeugt die iterierte Quadrierung eine Grenze zwischen den (komplexen) Zahlen, deren Ergebnisse gegen Unendlich oder gegen Null gehen. Diese Grenze ist in der Gaußschen Zahlenebene ein Kreis mit dem Radius Eins.

So erhalten wir mit einer sehr einfachen, aber oft wiederholten Rechenvorschrift immerhin schon eine geschlossene Grenzlinie, die ein zweidimensionales Gebiet präzise begrenzt. Wir behalten diese einfach zu verstehende Tatsache als wichtiges Zwischenergebnis der Mathematikstunde fest, obwohl die Kreislinie beinahe das Gegenteil von dem ist, was gesucht wird.

Wir suchen ja ein sehr differenziertes Grenzsystem voller Information, und die Kreislinie ist eine Grenzlinie, die überall die gleiche, also fast gar keine Information enthält. Dafür kann sie schon viel Ähnlichkeit aufweisen, sie ähnelt sich an jeder Stelle.

Wenn die grenzbildende Wirkung der wiederholten Quadrierung mit realen und komplexen Zahlen so mit ein paar gedanklichen Zahlenexperimenten zu erklären war, können wir die Spur zu dem Algorithmus, der den gestellten Anforderungen genügt, mit einer Exkursion in die Geschichte der Mathematik weiter verfolgen.

Gaston Maurice Julia war ein französischer Mathematiker, der als Soldat im ersten Weltkrieg verwundet in einem Lager lag und sich dabei mit dem Gedanken beschäftigte, wie die Kreisgrenze bei der iterierten Quadrierung komplexer Zahlen sich verändert, wenn bei jedem Zwischenergebnis noch eine bestimmte (komplexe) Zahl addiert wird, bevor erneut quadriert wird.

G. Julia konnte noch keinen Computer für seine Gedanken benutzen, und so konnte er keine Antwort auf seine Frage finden, aber er äußerte bereits eine Ahnung, dass mit dieser Methode bizarre Veränderungen der kreisförmigen Grenze zu erwarten sind, die das Phänomen „Selbstähnlichkeit“ in vielen Größenordnungen erzeugen.

Die Arbeit, die G. Julia zu dieser Frage schrieb, wurde 1919 von der französischen Akademie ausgezeichnet, blieb dann aber ein halbes Jahrhundert völlig unbeachtet.

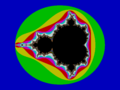

Der polnische Mathematiker Benoit Mandelbrot (*1924) zählt sicher zu den neugierigsten und verspieltesten Vertretern seiner Fachrichtung. Er stieß in den 60ziger Jahren auf Julias Arbeit. Da er zu dieser Zeit bei IBM an der Entwicklung der Computer arbeitete, konnte er Julias Gedanken am Computer experimentell untersuchen. Eher mit spielerischem Zufall als mit methodischer Suche entdeckte Mandelbrot dabei die Formel, die ihn berühmt machte und seinen Namen trägt, die Mandelbrot-Menge.

Diese Grenze in der Gausschen Zahlenebene, die auch den Kosenamen „Apfelmännchen“ erhielt, entsteht wie die Juliamengen aus der iterierten Quadrierung komplexer Zahlen mit Addition einer (komplexen) Zahl.

Genau gesagt ist die Mandelbrot-Menge die Grenze zwischen allen Julia-Mengen, die in sich zusammenhängend sind (deren Ergebnisse gegen Null gehen) und den Julia-Mengen, die nicht zusammenhängend sind (im Ergebnis gegen Unendlich gehen).

Der Rand dieser Figur, der mit der sehr einfachen Formel erzeugt wird, entsteht aus einer Kreisform durch fortwährend wiederkehrende, kleiner werdende Einbuchtungen, wie die glatte Haut eines Apfels, die immer mehr verschrumpelt. Durch diesen Vorgang wird die Grenze fraktal, selbstähnlich in verschiedenen Größenordnungen.

Die Grenze der Mandelbrot-Menge ist das komplizierteste Objekt der Mathematik, weil in ihr unendlich viele verschiedene Julia-Mengen enthalten sind. Man kann diese Struktur wie ein Bilderbuch mit unendlich vielen selbstähnlich verschachtelten Bildern betrachten.

Sogar eine der Sprache ähnliche „Pars pro Toto“-Funktion lässt sich in der Mandelbrot-Menge nachweisen: Welche der unendlichen Strukturen im aktuellen Rechenvorgang erzeugt wird, hängt nur von der Zahl C (C für Control) ab, die zum jeweiligen Quadrierungsergebnis addiert wird. Es besteht somit für jede spezifische Zahlenfolge von C ein spezifischer Ausschnitt der fraktalen Grenze, der von ihr erzeugt wird.

Die kurzen Zahlenfolgen bewirken hier also die Erzeugung riesiger selbstähnlicher Strukturkomplexe, vergleichbar den DNA-Sequenzen und den sprachlichen Zeichenfolgen. Damit erscheint die Mandelbrot-Menge als Modell für den Zusammenhang von Sinn und Sprache.

Liebe(r) Leser(in),

Sie haben soeben verfolgt, wie mit einigen Indizien der Algorithmus, der für unsere Sinn-und Sprachproduktion verantwortlich sein soll, als ein sehr einfaches und gleichzeitig sehr kompliziertes mathematisches Modell vorgeführt wurde, eine unendlich komplizierte Grenze mit „Pars pro Toto“-Funktion, Selbstähnlichkeit und organischem Zusammenhang, erzeugt mit der häufigen Wiederholung einer äußerst einfachen Rechenvorschrift.

Zum Glück sind wir hier mit den Links in der Lage, jeden Begriff ausführlich zu erklären. Meine Darstellung der Julia-und Mandelbrot-Formeln ist ehrlich gesagt laienhaft und oberflächlich, noch dazu ohne Bilder (muss noch nachgeholt werden). Es gibt darüber jede Menge Literatur, aber hier genügt Wiki allemal, um sich gut zu informieren.

Deshalb möchte ich an dieser Stelle eine Pause einlegen, in der jeder Leser sich ein wenig mit der Mandelbrot-Menge beschäftigen kann und meine Behauptung, dass diese als mathematisches Modell für unsere Sinn- und Sprachproduktion dienen kann, kritisch überprüfen kann.

Originelle Ideen entstehen bekanntlich oft aus der Verbindung von weit voneinander entfernten Tatsachen. Die Entfernung unserer geistigen Tätigkeit zur Mandelbrot-Menge erscheint auf den ersten Blick unüberbrückbar weit. Bei genauerem Hinsehen wird der Leser mir hoffentlich zustimmen, denn: „Pulchritudo splendor Veritas“, „Die Schönheit ist der Glanz der Wahrheit“.

Mandelbrot-Mengen

Mandelbrot-Menge oder Z n+1 = Z n2 + c

Einen Kontinent kann man allein durch Bilder schon kennen lernen, aber reichhaltiger sind die Eindrücke einer Reise.

Ähnlich ist es mit der MM (Abkürzung für Mandelbrot-Menge), die in vielen Ausschnitten in Wiki Commons unter Mathematik/ Fraktale/ Mandelbrot-set zu sehen ist.

Ein tieferes Verständnis ergibt sich mit jedem Computer, wenn darin ein kleines Programm (z. B. Winfrakt) aus dem Internet installiert wird, das die Figur selbst auf dem Bildschirm erzeugt. Wie mit einem Mikroskop kann man dabei Ausschnitte der Grenze vergrößern und wie auf einer Reise den unendlichen Formenreichtum erleben. Indem die Auswahl der Farben variiert wird, lassen sich unendlich viele schöne Bilder mit künstlerischem Reiz herstellen.

Zum philosophischen Staunen muss schon der extreme Kontrast zwischen den unendlichen Strukturen der MM und der simplen Formel ihrer Herstellung anregen.

Mit ihren Symmetrieeigenschaften, den Spiralen, Verästelungen und dem organischen Zusammenhang erinnert die MM auch an biologische Systeme, die ebenfalls aus kleinen Vorschriften äußerst komplexe Strukturen erzeugen.

Die Möglichkeit, die Ergebnisse dieses kurzen Algorithmus mit dem Computer sichtbar zu machen, ist auch hilfreich dabei, ihn als anschauliches Modell für Sinn und Sprache zu benutzen.

Betrachten wir die folgenden Bilder, auf denen die Ergebnisse der ersten Arbeitsschritte der Formel erkennbar sind.

Die erste Quadrierung erzeugt eine kreisförmige Grenze zwischen Blau und Schwarz, eine informationsarme Linie.

Wir können diese Grenze als Modell für den geistigen Zustand betrachten, den ein neugeborenes Kind am Beginn seiner geistigen Entwicklung hat, die berühmte „Tabula rasa“, noch völlig ohne Information.

Der zweite Iterationsschritt erscheint als symmetrische grüne Einbeulung, die zu einer Birnenform der Grenze führt..

Wenn wir darin ein Modell für die ersten Eindrücke sehen, die ein Baby erhält, kann auch wieder an die biblische Schöpfungsgeschichte erinnert werden.

Demnach entstand die Vielfältigkeit der Welt am Anfang aus groben, symmetrischen Einteilungen in Licht und Dunkel, Wasser und Land, Himmel und Erde usw.

Ähnlich muss das Neugeborene seine ersten Eindrücke in grobe Kategorien wie z. B. hell und dunkel, laut und still, warm und kalt usw. abgrenzen, wenn es sein eigenes Wissen von der Welt aufzubauen beginnt.

Der dritte Schritt macht mit neuen Dellen das Prinzip aller weiteren Schritte deutlich: Jede vorangegangene Einbuchtung wird durch zwei neue, kleinere Eindrücke verformt, wobei eine strenge Spiegelsymmetrie erhalten bleibt, aber eine Differenzierung der nun sich herausbildenden Längsachse bemerkbar ist.

Die Spitze im linken Teil der Längsachse steht als einziger Punkt noch mit dem ursprünglichen Kreis in Verbindung und wird es auch nach allen folgenden Arbeitsschritten des Algorithmus immer bleiben.

Die folgenden Schritte lassen das Prinzip immer klarer sichtbar werden: So wie man bei einem Menschenkind von seinen ersten Eindrücken spricht, die durch ständige Verfeinerung ein ständig sich differenzierendes Weltbild entstehen lassen, so entwickelt die Grenze der MM aus immer feiner werdenden Einbuchtungen einen kosmischen Formenreichtum in organischem Zusammenhang.

- 4.-30.Iteration

-

5.Schritt der MM

-

left

-

30. Schritt der MM

Die Bilder zeigen die ersten Wiederholungen eines endlos wiederholbaren Vorgangs. In den symmetrischen Umrissen der Grenzlinie wird schon eine „quasi natürliche“ Gestalt wie ein Käfer oder Blatt sichtbar. Es lässt sich auch erkennen, dass die Grenzlinie durch die neuen Eindrücke nie unterbrochen wird, also immer in ganzheitlichem Zusammenhang bleiben muss.

Bei dreißig Iterationen sind die neu hinzugefügten Einbuchtungen schon so klein, dass die Grenzveränderungen in der Grundfigur kaum noch erkennbar sind. Der Computer ermöglicht es aber, sehr kleine Ausschnitte wie mit einem Mikroskop zu betrachten.

Der Ausschnitt zeigt schon sehr deutlich die Selbstähnlichkeit der Grenze, die unendlich viele kleine Kopien der Grundfigur enthält. Auch die immer feiner werdende Verästelung der Grenze ist sichtbar, lässt aber nicht erahnen, welche unendlich feinen Strukturen noch darin verborgen sind.

Ich denke, dass mit diesen Bildern gezeigt werden kann, wie das mathematische Modell den Beginn des kindlichen Weltwissens und seine endlose Verfeinerung anschaulich machen kann.

Für ein Verständnis der sprachlichen Minimierung, zu dem die anfängliche Frage hinführen sollte, kann der C-Wert der Formel herangezogen werden. Das ist die (komplexe) Zahlenfolge, die jedem Teil der Grenze in der komplexen Ebene zugeordnet ist und diesen Teil konstruiert, wenn er in die Formel eingesetzt wird. Vergleichbar den Samen und den sprachlichen Zeichenfolgen ist auch der C-Wert eine kurze Zeichenfolge, die sehr komplexe Strukturen mit „pars pro toto“– Funktion erzeugen kann.

Um den Vorteil dieser Fähigkeit leicht zu begreifen, genügt wieder einmal der Vergleich mit der Digitaltechnik:

Jedes der obigen Bilder wird vom Computer aus 768x1024 Pixeln hergestellt und benötigt zur Speicherung 2,2 MB Speicherplatz. Um die Speichermenge zu verringern, lassen sich technische Algorithmen einsetzen, die „überflüssige Information“ heraussuchen und eine „abgespeckte Version“ erzeugen, die aber immer noch über 100 KB Speicher benötigen wird, um das Bild ohne bemerkbare Verluste zu rekonstruieren.

Wenn das Bild aber anstatt dessen als Ergebnis eines ständig wiederholten Algorithmus mit einem kurzen Controll-Wert C herstellbar ist, dann genügt es, diesen C-Wert zu speichern, um das Bild völlig verlustfrei wieder daraus zu rekonstruieren.

Es liegt auf der Hand, dass die Speicherung einer kurzen Zahlenfolge den Speicherbedarf extrem vermindert. Auch die Übertragungszeit hängt von der Größe einer Datei ab und wird durch die knappe Zeichenfolge so kurz, dass eine Kommunikation in „Echtzeit“ überhaupt erst möglich ist.

Zusammenfassend lässt sich sagen, dass die Visualisierung der MM am Computer wesentliche Aspekte von Sinn und Sprache anschaulich und begreifbar macht.

Wir haben damit ein Grundprinzip der sprachlichen Tätigkeit in einem sehr abstrakten, aber mit Hilfe des Computers sichtbar gemachten Algorithmus vor Augen. Das Prinzip besteht in der Sprache wie in der MM in einer Minimierung der unendlich komplexen Strukturen in kurze Folgen von Werten, die einen ständig wiederholenden Algorithmus steuern, der die Strukturen in einer organisch verbundenen Grenze rekonstruiert und das weitere Wachstum dieser Grenze modifiziert.

Das Modell bietet eine Erklärung für die nahezu unbegrenzte Speicherkapazität und die extrem schnelle Kommunikation der Menschen mit Hilfe der Sprache.

Ich will nicht verschweigen, dass diese Verbindung der geistigen Tätigkeit mit der Mandelbrot-Menge nicht über das rational-diskursive Denken hergestellt wurde, sondern mehr intuitiv mit einer unmittelbaren Einsicht begann, die mich durch ihre Einfachheit und Schönheit überzeugte...

Ich bin deshalb dankbar, hier die Möglichkeit zur komfortablen Darstellung mit Links und Bildern zu erhalten.

Hinweis:

Wer kein Programm zur Erzeugung der Mandelbrotmenge nutzen möchte, kann Videos im Internet dazu finden. Zum Beispiel dieses Video auf YouTube.

Na und?

Was ist gewonnen mit einer gedanklichen Verbindung zwischen dem „ungeheuren Gewebe“ der Sprache, „in dem jeder Theil mit dem anderen, und alle mit dem Ganzen in mehr oder weniger deutlich erkennbarem Zusammenhang stehen“ (Humboldt), und der fraktalen Grenzstruktur, die wir als Ergebnis der einfachen Rechenvorschrift Z n+1 = Z n² + c am Computer betrachten können?

Vorurteile

Bisher existiert noch kein wissenschaftliches Modell für jenes Phänomen, das wir subjektiv als „Sinn“ sehr gut kennen und zum sprachlichen Ausdruck bringen können. Wenn die Mandelbrot-Menge uns bei der Vorstellung hilft, wie dieses spezifisch menschliche „geistige“ Produkt aus geregelter Tätigkeit zu erklären ist, dann füllt sie nicht ein Vakuum, sondern muss sich gegen bestehende Vorurteile behaupten.

Über Jahrtausende herrschte im Kulturkreis der von Abraham und Moses gegründeten Religionen die Vorstellung, dass die Menschen die Sprache im Paradies von ihrem göttlichen Schöpfer erhielten und ihr Sinnverständnis durch den Genuss der verbotenen Frucht vom Baum der Erkenntnis geweckt wurde. Als Strafe für ihren babylonischen Hochmut verwirrte Gott die Menschen so, dass sie in verschiedenen Sprachen redeten und sich nicht mehr verständigen konnten.

Erst die Aufklärung brachte mit Herder, W. von Humboldt usw. die Idee von der natürlichen Evolution der Sprache und der geistigen Fähigkeiten in die Diskussion. Erst seit dieser Zeit gibt es eine akademische Sprachforschung. Die Linguistik ist im Vergleich zur Mathematik oder Musikwissenschaft eine junge Wissenschaft, noch in den Kinderschuhen.

„Ignorabimus“ (wir werden es nie wissen) war die Grundüberzeugung der Wissenschaftler bis zur Mitte des zwanzigsten Jahrhunderts, wenn es um eine genaue Erklärung des Bewusstseins und der geistigen Vorgänge ging. Erst mit der Simulation geistiger Vorgänge in den ersten Computern konnte die Natur der geistigen Vorgänge in neuem Licht gesehen werden und deren naturalistische Erklärung ins Auge gefasst werden. Mit dem Begriff „Künstliche Intelligenz“ versprach man sich auch ein neues Verständnis für die natürliche Intelligenz.

Durch die neue, technische Sichtweise kam ein neues Vorurteil in Mode, welches lautet: „Alle geistigen Vorgänge können auf digitale Rechenvorgänge zurückgeführt werden.“ Diese optimistische Meinung wird heute auch von der Neurophysiologie unterstützt, weil Nervenzellen tatsächlich ähnlich wie die Schaltelemente der Computer arbeiten, das heißt: Mit Nervenzellen lassen sich die logischen Grundfunktionen (und-oder) und Rechenoperationen ausführen.

Heute sind alle geistigen Produkte digitalisierbar, Text, Musik, Bilder, Videos, alles kann gespeichert, bearbeitet und im Internet sekundenschnell verschickt werden, und so sagt die gängige Meinung der technisch gebildeten Zeitgenossen heute oft, dass alle geistigen und auch sprachlichen Vorgänge auf digitaler Grundlage wie im Computer zu erklären sind.

Mit bescheidenen Errungenschaften, zum Beispiel den elektronischen Navigationshilfen im Auto und Robotern, die auf gesprochene Befehle reagieren, stützen Computerexperten ihre Hoffnung, eines Tages mit den Maschinen wie mit Menschen sprachlich zu kommunizieren. Elektronische Gesprächspartner oder Briefpartner sind bisher jedoch noch nicht möglich, keine Rechenmaschine versteht den Sinn der von ihr durchgeführten digitalen Operationen, kein Computer hat ein Wissen davon, was er tut, und kein Computer hat bisher den Turing-Test bestanden.

Sind neuronale Netze die Lösung?

Einen Ausweg aus dem Problem, menschliches Denken und Sprechen elektronisch zu simulieren, sehen die Fachleute in dem Terminus neuronale Netze, mit dem Gedächtnismodelle entwickelt wurden, wie sie auch in der Gehirnrinde vermutet werden.

Doch auch bei neuronalen Netzen fehlt der Qualitätssprung, der das menschliche Erleben von Sinn und das zu Grunde liegende Weltwissen hervorruft.

Über diesen Mangel der neuronalen Netze sehen die Fachleute hinweg, indem sie den Begriff einer parallelen Datenverarbeitung von der gewöhnlichen, seriellen Datenverarbeitung abgrenzen und in der „massiven Parallelverarbeitung des Gehirns“ das Geheimnis der menschlichen Geistestätigkeit vermuten. Mit einer milliardenfachen parallelen Verarbeitung soll erklärbar werden, warum der Mensch in einem Augenblick so viele Sinnesdaten gleichzeitig verarbeiten kann, wie es von keinem Computer zu schaffen ist.

Hier sollte bedacht werden, dass im Prinzip kein Unterschied zwischen einem parallelen und einem seriellen Computer besteht, beides sind letzten Endes Rechenmaschinen. Unterschiede können nur in der größeren Verarbeitungsgeschwindigkeit der parallelen Computer liegen, aber der Qualitätssprung zum Sinnverständnis und dem Wissen um das eigene Handeln ist mit diesem Schlagwort nicht erklärbar.

Parallelen sind dadurch definiert, dass sie einander nie berühren. Bei der augenblicklichen, sinnlichen Erfassung einer komplexen Situation sind jedoch alle Sinnesdaten in Verbindung und ergeben einen zusammenhängenden Sinn, der aus paralleler Datenverarbeitung per definitionem gar nicht gewonnen werden kann. Die Einheit des bewussten Erlebens scheint ganz unvereinbar mit dem Bild eines Parallelcomputers zu sein.

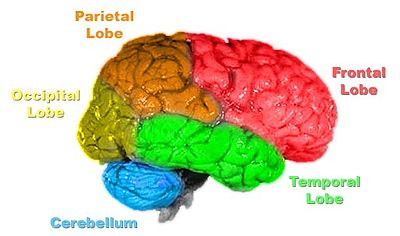

Ein weiteres Problem ergibt sich aus der Gestalt der neuronalen Netze, wie sie tatsächlich in der Hirnrinde existieren. Weder von der Neurophysiologie noch von der mathematisch-technischen Seite wurde die spezielle Art und Weise der Verästelung beachtet, die von den Nervenzellen im Großhirn ausgebildet wird.

Der Psychologe Donald Hebb, der die Idee der neuronalen Netze 1949 als Erster formulierte, konnte noch keine Angaben über die Feinstruktur der Verästelungen im Großhirn machen, weil die Architektur der Hirnrinde noch nicht restlos bekannt ist. Die Verbindungen der Nervenzellen sind im Cortex so komplex, dass ihre genaue Beschreibung bisher unmöglich ist.

Die Informationstheoretiker entwickelten technischen Nachbildungen der neuronalen Netze in geradlinig-geometrischen Formen. Diese technisch-geradlinige Form der Darstellung wurde von bekannten Hirnforschern, z. B. dem Nobelpreisträger John C. Eccles, auch für ein gedankliches Modell der Gedächtnisorganisation übernommen. Warum diese technisch-gradlinige Darstellung von neuronalen Netzen der Großhirnarchitektur in die Irre führt, kann mit folgenden Gedanken begründet werden:

In den technischen Schaltplänen werden die leitenden Verbindungen der Elemente völlig unabhängig von ihrem tatsächlichem Verlauf aus praktischen Gründen als gerade Linien mit rechtwinkeligen Abzweigungen eingezeichnet. Man kann diese idealisierende Abweichung vom realistischen Verlauf bei elektrischen Leitungen ohne Probleme im Schaltbild vernachlässigen.

Es ist aber eine Frage von grundlegender Bedeutung, ob solche Abweichungen von der Realität bei den neuronalen Verbindungen im Gehirn genauso ignoriert werden können, wie in den technischen Geräten. Dieses Problem ergibt sich nicht nur im Blick auf die Hirnrinde sondern stellt sich in allen Teilen des Gehirns.

Einer technisch-geradlinigen Modellierung der Neuronenverbände steht die Tatsache entgegen, dass die Nervenzellen für ihre vielseitigen Aufgaben im Nervensystem sehr unterschiedliche Formen der Verästelung ausbilden. Die Genetiker sprechen von omnipotenten Stammzellen, die je nach ihrem Einsatzort im Gehirn spezifische Formen ausbilden und sich danach mikroskopisch in ihren spezifischen Verästelungsformen gravierend unterscheiden, zum Beispiel als Purkinje-Zelle, Pyramidenzelle, Sternzelle, Golgi-Zelle, Mooszelle usw.

Die im Gehirn zu beobachtenden Verzweigungen der Nervenzellen unterliegen also weder dem Zufall noch folgen sie den geometrischen Mustern der technischen Nachbildung. Deshalb findet man im ganzen Nervensystem sehr charakteristische Formen der Verästelung, die jeweils einer spezifischen Funktion in einem speziellen Hirngebiet optimal angepasst sind.

Als Beispiel für die Bedeutung der spezifischen Verästelung kann auf das Kleinhirn verwiesen werden, dessen Zellarchitektur gut bekannt ist. Hier sind es die sogenannten Purkinje-Zellen, die mit ihrer spalierartigen Verzweigung einzigartig im ganzen Nervensystem sind und in der Kleinhirnrinde eine ganz spezielle Aufgabe der zeitlichen Bewegungssteuerung erfüllen.

Es ist unwahrscheinlich, dass die Verzweigungsarchitektur im Großhirn dem Zufall überlassen ist. Eher ist zu vermuten, dass die Verzweigungen der dort vorherrschenden Pyramidenzellen genau wie die Verästelungstypen der übrigen Nervenzellen durch Wachstumsvorschriften geregelt werden, die zur Differenzierung ihrer Verästelung und damit auch ihrer Funktion führen.

Aus dieser Sicht erscheint das verbreitete Konzept der künstlichen „neuronalen Netze“ mit paralleler Verarbeitung mangelhaft, seine Misserfolge sind erklärbar.

Ein mathematisches Modell für das Sinn-Ganze

Als Alternative zu dem bekannten Modell (neuronale Netze im Parallelcomputer) hat der Mandelbrot-Algorithmus den Vorteil, dass seine fraktale Grenzstruktur sichtbar gemacht werden kann. Der unendliche Formenreichtum in ganzheitlichem Zusammenhang ermöglicht uns die Vorstellung, wie in unserem Kopf etwas Ähnliches, ein Sinn-Ganzes aus vielen kleinen Schritten aufgebaut werden kann.

Der sichtbare Zusammenhang verschiedener Strukturen mit bestimmten Zeichenfolgen (dem C-Wert) gestattet einen Vergleich mit der in Zeichenfolgen komprimierenden Fähigkeit der Sprache (und der Samen).

„Der Mensch berührt beim Sprechen, von welchen Beziehungen man ausgehen mag, immer nur einen abgesonderten Theil dieses Gewebes, thut dies aber instinktgemäß immer dergestalt, als wären ihm zugleich alle, mit welchen jener einzelne nothwendig in Übereinstimmung stehen muss, im gleichen Augenblick gegenwärtig.“ So beschrieb W. von Humboldt die Pars-pro-toto-Funktion der Sprache. Die Mandelbrot-Formel kann auch diese Funktion vor Augen führen, weil in jedem Teil ihrer Grenzstruktur eine kleine Kopie der Grundfigur gefunden werden kann, in jedem Teil das Ganze, wie die genetische Substanz in jeder Zelle eines Organismus.

Diese einmaligen Eigenschaften einer simplen Rechenvorschrift lassen die MM als nützliches Modell für Sinn und Sprachfunktion erscheinen.

Um nicht missverstanden zu werden: Wir behaupten damit nicht die völlige Übereinstimmung der Formel mit der Realität der Gehirnvorgänge, sondern möchten nur auf eine Ähnlichkeit der Eigenschaften hinweisen, die auf ähnliche Vorgänge ihrer Realisierung schließen lässt.

Mathematische Vorgänge können auf verschiedene Weise realisiert werden, in Nervensystemen oder elektronischen Schaltungen, und so kann das Modell uns hilfreich beim Verständnis unserer geistigen Vorgänge sein, aber auch als Anregung für zukünftige Computer dienen, die einmal den Turing-Test bestehen sollen.

Der Pulsschlag des Geistes

Plädoyer für das Einbeziehen der Hirnforschung

Sprache ist kein Produkt der Zunge sondern des Gehirns. Folglich ist die moderne Gehirnforschung zunehmend auch für die Linguistik und Philosophie von Interesse.