Entropie: Geschichte

Zurück zur Übersicht

Stoffsammlung

[Bearbeiten]Physik

[Bearbeiten]

- Fahrenheit und Reaumur

- Entwicklung des Thermometers, Temperaturskalen

- Boyle Mariott

- empirische Gasgesetze

- Joseph Black (1728-1799)

- erkannte die Wärme als mengenartig und unterschied sie von der Temperatur.

- führte auch die Größe Wärmekapazität ein, (heute Entropiekapazität)

- Antoine Laurent de Lavoisier

- entwickelte die Stofftheorie der Wärme Kalorische_Theorie

- Watt

- Dampfmaschine, Umwandlung von Wärme in mechanische Energie 1765

- 1765

- Dampfmaschine, Umwandlung von Wärme in mechanische Energie 1765

- Benjamin Thompson

- entwickelte eine Methode zur Messung der spezifischen Wärme von Stoffen

- Umwandlung von Arbeit in Wärme (beim Bohren von Kanonenrohren)

- 1800

- Gay-Lussac

- thermische Zustandsgleichung für Gase

- 1820

- thermische Zustandsgleichung für Gase

- Julius Robert von Mayer

- hat das mechanische Wärmeäquivalent berechnet und den 1. Hauptsatz der Thermodynamik publiziert.

- James Prescott Joule

- hat das mechanische Wärmeäquivalent berechnet und die Umwandlung von Strom in Wärme erforscht.

- Benoit Pierre Émile Clapeyron ( 1799 bis 1864 ), ein Pionier der Thermodynamik

- von Helmholtz

- Nicolas Léonard Sadi Carnot

- Hat angenommen, dass Wärme einem Erhaltungsgesetz unterworfen ist

- hat die Größe S eingeführt

- hat den Begriff Entropie geprägt

- gilt als einer der Entdecker des 2.Hauptsatzes der Thermodynamik

- Zitate von Clausius:

Vorläufig will ich mich darauf beschränken, als ein Resultat anzuführen, daß wenn man sich dieselbe Größe, welche ich in bezug auf einen einzelnen Körper seine Entropie genannt habe, in konsequenter Weise unter Brücksichtigung aller Umstände für das ganze Weltall sich gebildet denkt, und wenn man daneben zugleich den anderen, seiner Bedeutung nach einfacheren Begriff der Energie anwendet, man die den beiden Hauptsätzen der mechanischen Wärmetheorie entsprechenden Grundgesetze des Weltalls in folgender einfachen Form aussprechen kann:

- 1. Die Energie der Welt ist konstant.

- 2. Die Entropie der Welt strebt einem Maximum zu.

von Rudolf Clausius (Quelle Poggendorfs Annalen der Physik und Chemie 125, 335-400 (1965))

I prefer going to the ancient languages for the names of important scientific quantities, so that they mean the same thing in all living tongues. I propose, accordingly, to call S the entropy of a body, after the Greek word ‘transformation.’ I have designedly coined the word entropy to be similar to energy, for these two quantities are so analogous in their physical significance, that an analogy of denominations seems to me helpful. von Rudolf Clausius deutsche Quelle wird noch gesucht

- hat eine wichtige Formel zur Entropie erarbeitet und die statistische Thermodynamik mitbegründet.

- [FAZ Artikel zum 100.Todestag]

- Gibbs

- hat die Energiebilanzen chemischer Reaktionen berechnet

- und die physikalische Chemie begründet

- 1876

- Max Planck

- hat herausgefunden, daß die Entropie am absoluten Nullpunkt der Temperatur gleich Null ist

- Hohlraumstrahlung

- 1900

- Zwei kurze Zitate zeigen die Schwierigkeiten, die Physiker mit der Entropie hatten.

- Die Entropie war bei den damaligen Physikern so ein Bißchen nicht sehr beliebt, weil die so ein vages Gespenst war. Max Planck

- Entropie ist etwas, was man nicht versteht, aber man gewöhnt sich daran. Max Planck zugeschrieben.

- Gibbs

- mathematische Theorie zur Boltzmann-Entropie

- 1902

- mathematische Theorie zur Boltzmann-Entropie

- Einstein

- hat eine Formel über die Abhängigkeit der Entropie S von dem, von einer monochromatischen Strahlung eingenommenen, Volumen V entwickelt.

- Diese Gleichung zeigt, daß die Entropie einer monochromatischen Strahlung von genügend kleiner Dichte nach dem gleichen Gesetze mit dem Volumen variiert wie die Entropie eines idealen Gases oder die einer verdünnten Lösung

- Hat die Bose-Einstein Statistik berechnet und damit die Existenz des Bose-Einstein-Kondensat vorausgesagt.

- Satyendranath Bose(1924) für Photonen, A. Einstein für massive Teilchen, 1925

- H. Callendar

- hat die Einheit der Entropie mit J/K eingeführt und die Entropie als Wärme interpretiert.

- siehe H. L. Callendar Proc. Phys. Society of London 23 (1911)

- hat das Buch The Properties of Steam and Thermodynamic Theory of Turbines geschrieben

- hat die Temperaturmessung stark verbessert.

- Paul Ehrenfest

- Schüler Boltzmanns, hat das Urnenmodell propagiert

- Hat die Entropie an Hand des Entropiespiels mit Hunden und Flöhen erklärt.

- Landau

- hat Phasenübergänge theoretisch berechnet,

- 1930

- hat Phasenübergänge theoretisch berechnet,

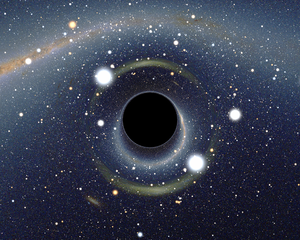

- Jacob Bekenstein hat 1973 eine Formel der Entropie schwarzer Löcher aufgestellt und damit die Verbindung Entropie-Gravitation bearbeitet. Er stellte die Bekenstein-Grenze auf und setzte damit der Entropie eines Raumquaders eine obere Grenze.

- J. D. Bekenstein, "Black holes and entropy", Phys. Rev. D 7:2333-2346 (1973).

- J. D. Bekenstein: A universal upper bound on the entropy to energy ratio for bounded systems. In: Physical Review D. 23/1981, S. 287–298

- Gerard t' Hooft verallgemeinerte die Bekenstein-Grenze, um die Entropie in einem sphärischen Raumbereich mit bestimmter Oberfläche zu begrenzen.

- Stephan Hawking beschäftigte sich viel mit Schwarzen Löchern und deren Entropie. Er errechnete Ihre Strahlungsabgabe ( Hawking-Strahlung und meint er hätte das Problem des Informationsverlustes in Schwarzen Löchern gelöst ([Hole Information Loss Problem]).

- Pierre-Gilles_de_Gennes erhielt 1991 den Nobelpreis für Physik für seine Arbeiten zur Erforschung von Ordnungszuständen in Flüssigkristallen und Polymere.

Entropie in der IT

[Bearbeiten]- Ralph Hartley

- Quelle : RVL Hartley 1928 Transmission of Information , Bell Syst.Tech.J., vol 7 : S 535)

- behauptete, daß die Informationsmenge H an Information, die in einer aus Zeichen eines Alphabets S gebildeten Nachricht N enthaltene "Menge an Information" als Logarithmus definiert werden könne

H = N log S

- Claude Elwood Shannon

- Entwickelte die berühmte Formel für die Informationsmenge

- 1949: Communication Theory of Secrecy Systems

- hier legt Shannon die theoretischen Grundlagen der Kryptographie

- Warren Weaver

- Weaver war zusammen mit Claude Shannon Begründer der Informationstheorie.

- W. Weaver ; C. E. Shannon: The Mathematical Theory of Communication. Urbana, Illinois: University of Illinois Press, 1949

- Erwin Schrödinger

- In seinem 1944 erschienenem Werk Was ist Leben? (im Original What is Life?) führt er den Begriff der Negentropie ein.

- Norbert Wiener

- Hat die Kybernetik mit entwickelt

- John von Neumann

- Hat die Entropie in der Quantenmechanik berechnet

- Ludwig von Bertalanffy

- hat die Systemtheorie mit entwickelt

- Leo Szilard

- Habiltationsschrift:Über die Entropieverminderung in einem thermodynamischen System bei Eingriffen intelligenter Wesen.

- Zeitschrift für Physik, Band 53, Nr. 11-12, S. 840-856, November 1929, Link zum abstract

- Der Text verknüpfte erstmals die Konzepte Intelligenz, Gedächtnis, Entropie und Information und wurde zu einer der Grundlagen der mathematischen Informationstheorie.

- Habiltationsschrift:Über die Entropieverminderung in einem thermodynamischen System bei Eingriffen intelligenter Wesen.

- Léon Brillouin schlug den Begriff Negentropie vor.

- Léon Brillouin Science and Information Theory (New York: Academic Press, 1956)

- Tom Stonier

- Hat eine interessante Bücher über die Information geschrieben

- hat eine weitere Formel zum Zusammenhang Information - Entropie postuliert

- Gregory Chaitin

- Hat ein schönes einfaches Beispiel von Zufallsinformation und geordneter Information veröffentlicht.

- Randomness and Mathematical Proof Scientific American 232, No. 5 (May 1975), pp. 47-52

- Almost everyone has an intuitive notion of what a random number is. For example, consider these two series of binary digits:

- Fast jeder hat eine Vorstellung davon, was eine Zufallszahl ist. Beispielsweise kann man die folgenden zwei binären Zahlen betrachten.

- Hat ein schönes einfaches Beispiel von Zufallsinformation und geordneter Information veröffentlicht.

01010101010101010101 01101100110111100010

Literatur

[Bearbeiten]- A History of Thermodynamics. The Doctrine of Energy and Entropie

- von Ingo Müller (Autor)

- Preis: EUR 85,55 Gebundene Ausgabe: 330 Seiten Verlag: Springer, Berlin; Auflage: 1st ed.

- (Februar 2007) Sprache: Englisch ISBN-10: 3540462260

- von Ingo Müller (Autor)

- Die Zunahme der Entropie

- von Gerhard Ernst (Autor)

- 127 Seiten Mentis-Verlag; Auflage: 1 (2003) ISBN-10: 3897853795

- Kurzbeschreibung: Die Zunahme der Entropie ist ein universell anzutreffendes, aber schwer zu erklärendes Phänomen. Die Schwierigkeiten werden deutlich, wenn man die Versuche betrachtet, den Zweiten Hauptsatz der Thermodynamik aus fundamentaleren Gesetzen abzuleiten. Ziel der vorliegenden Arbeit ist es, die Struktur dieser nomologischen Reduktion zu klären. Die Ableitung des Zweiten Hauptsatzes ist das Kernstück einer Reduktion der Thermodynamik auf grundlegendere physikalische Theorien. Diese wiederum gilt als klassisches Beispiel für die Reduktionsbeziehung überhaupt. Es gibt jedoch eine Reihe schwerwiegender Probleme. Das vorliegende Buch möchte diese Probleme und die Art und Weise, wie man versucht hat sie zu lösen, klären. Damit behandelt sie ein Thema an der Schnittstelle von Philosophie der Physik, Wissenschaftstheorie und physikalischer Grundlagenforschung.

- von Gerhard Ernst (Autor)

- Das Reich des Zufalls

- von Gerd Gigerenzer (Autor), Zeno Swijtink (Autor), Theodore Porter (Autor)

- Verlag: Spektrum Akademischer Verlag (1999) ISBN-10: 3827401011

- Produktbeschreibungen: Wenn man sieht, welchen Rang die Statistik heute innehat, wundert man sich schon, wie spät in der Wissenschaftsgeschichte die Statistik erst geschmiedet wurde. Ausgangspunkt waren bezeichnenderweise Gedanken, die sich der bekannte Mathematiker Blaise Pascal über Gewinnchancen bei einem Spiel machte (unter dieser Nähe zum Anrüchigen litt die Zunft recht lange). Die Geschichte von Pascals Denkspielen bis zur heutigen Teilchenphysik, den Meinungsumfragen, ja sogar der komplexen Baseballstatistik haben die sechs Autoren dieses Buches mit hoher Detailschärfe aufgeschrieben. Dabei beschränken sie sich nicht darauf, die dazugehörige, knifflige Mathematik herzuleiten -- tatsächlich kommen im Buch nur sehr wenige Formeln vor -- vielmehr raffen sie die historische Entwicklung der Zufallswissenschaften während der letzten 300 Jahre und -- sehr schön! -- stellen die Erkenntnisse in das gesellschaftliche Umfeld der jeweiligen Zeit. Dabei kommen zuweilen recht amüsante Fakten zutage: Während sich die Mathematiker etwa bemühten, das Risiko von Lebensversicherungen kalkulierbar zu machen, scherte sich die Branche seinerzeit kaum um die Ergebnisse -- weil Leibrenten im London früherer Jahrhunderte vielfach getarnte Kreditrückzahlungen waren, für die der Wucherparagraph nicht galt. Pech für Pascal, Poisson, Bernoulli, Gauß, Maxwell & Co., alles große Namen, die sich um die Statistik verdient gemacht haben.

- von Gerd Gigerenzer (Autor), Zeno Swijtink (Autor), Theodore Porter (Autor)

Links

[Bearbeiten]- Geschichte_der_Wahrscheinlichkeitsrechnung

- Die Wahrscheinlichkeitsrechnung hat sich lange Zeit, teilweise auch heute noch, um den zentralen Begriff Entropie nicht gekümmert. Trotzdem zeigt die Geschichte der Wahrscheinlichkeitsrechnung auch den Weg zum mathematischen Verständnis der Entropie auf. Die Entropie ist in der Wahrscheinlichkeitsrechnung als ein Maß für die Zahl der Möglichkeiten eines oder mehrerer Zufallsprozesse anzusehen. Grob vereinfacht kann man die Entropie auch als Menge an Zufall bezeichnen.

- http://en.wikipedia.org/wiki/History_of_entropy

- Englischer Wikipediaartikel über die Geschichtes des Begriffes Entropie