Das Mehrkörperproblem in der Astronomie/ Druckversion

Michael Oestreicher

Das Mehrkörperproblem

in

der Astronomie

https://de.wikibooks.org/wiki/Das_Mehrkörperproblem_in_der_Astronomie/

![]() – Das Mehrkörperproblem in der Astronomie

– Das Mehrkörperproblem in der Astronomie

Mehrkörpersysteme in der Astronomie

[Bearbeiten]Die kosmische Hierarchie

[Bearbeiten]

Wie bereits seit langem bekannt, sind die Himmelskörper nicht regellos im Universum verteilt, sondern innerhalb von Systemen höchst unterschiedlicher Größe und Struktur angeordnet. Monde umkreisen Planeten, diese wiederum bewegen sich um Zentralgestirne. Die Sterne selbst sind ebenfalls keine Einzelgänger. Sehr häufig umkreisen sich zwei Sterne gegenseitig, bilden also ein sogenanntes Doppelsternsystem. Ein Beispiel hierfür ist Sirius, der hellste Stern am Nachthimmel, welcher einen sehr lichtschwachen Begleiter in Gestalt eines weißen Zwerges besitzt. Doch auch Mehrfachsysteme kommen vor. So besteht Castor, das hellste Objekt im Sternbild Zwillinge, in Wahrheit aus 6 Sternen: drei äußerst enge Paare, die um einen gemeinsamen Schwerpunkt laufen, wie Struve (1952) [1] erkannte.

Selbst solche Objekte stehen in der Hierarchie der Sternsysteme freilich noch fast ganz unten. Mehr als 1000 sogenannte offene Sternhaufen sind bekannt, ziemlich dichte Ansammlungen von typischerweise mehreren 100 Sternen. Ein typischer Vertreter sind die Plejaden, das Siebengestirn, für welches Jones (1970) [2] 340 zugehörige Objekte bis zur 15.Größenklasse (entsprechend Hauptreihensternen des Spektraltyps K) auflistet. Aktuelle Beobachtungen von Bouy und anderen (2015) [3], welche auch sehr lichtschwache Rote und Braune Zwerge berücksichtigen, lassen sogar 2100 Mitglieder erkennen. Besonders spektakulär erscheinen dem Beobachter die Kugelhaufen, wo hunderttausende von Sternen auf so engem Raum angeordnet sind, dass diese selbst mit leistungsstarken Instrumenten häufig nur am Randbereich des Systems noch als Individuen erkannt werden können. 47 Tucanae im Sternbild Tukan ist eines der schönsten Beispiele.

Einzel-, Doppel- und Mehrfachsterne sowie Kugel- und offene Sternhaufen finden sich wiederum zu Galaxien unterschiedlicher und oft sehr komplexer Gestalt zusammen. Spiralgalaxien wie die Andromedagalaxie bestehen aus drei Komponenten: einer im Vergleich zu ihrem Durchmesser sehr dünnen Scheibe (welche die Spiralarme und offenen Sternhaufen enthält), einer linsenförmigen Verdickung im Zentrum (auch in der deutschen Literatur oft mit dem englischen Begriff Bulge bezeichnet) sowie einem annähernd kugelsymmetrischen Halo (wo sich die Kugelhaufen befinden). Balkenspiralgalaxien ähneln den einfachen Spiralgalaxien, doch unterscheiden sie sich von diesen dadurch, dass die Spiralarme an einer balkenförmigen Struktur ansetzen. Unsere eigene Milchstraße, lange Zeit als gewöhnliche Spiralgalaxie betrachtet, könnte laut Benjamin (2008) [4] ebenfalls ein Balkensystem darstellen. Sowohl gewöhnliche als auch Balkenspiralen können mehrere hundert Milliarden Sterne enthalten. Darüber hinaus enthalten sie große Mengen an interstellarer Materie in Form von Gas und Staub. Den Löwenanteil an ihrer Masse aber scheint dunkle Materie zu stellen, die sich allein durch ihre Gravitationswirkung verrät.

Zum Ensemble der großen Sternsysteme gehören auch elliptische Galaxien. Wie der Name bereits andeutet, weisen sie die Gestalt eines Ellipsoids auf, ohne dabei wie Spiralgalaxien auffällige Strukturen zu zeigen. Elliptische Systeme sind oft noch massereicher als Spiralgalaxien, wobei wiederum dunkle Materie zu dominieren scheint. Der Anteil interstellarer Materie ist oft sehr gering.

Mit der Verfügbarkeit immer größerer und damit lichtempfindlicherer Teleskope sind in den letzten Jahrzehnten neben den großen verstärkt die Zwerggalaxien ins Blickfeld der Forschung gerückt, wobei als bekannteste Vertreter die Magellanschen Wolken zu nennen sind. Hinsichtlich ihrer Größe und Sternanzahl stehen sie zwischen den Kugelhaufen und den großen Galaxien. Meist sind sie von elliptischer oder unregelmäßiger Gestalt, wohingegen Zwergspiralen selten sind. Zwergsysteme weisen im Vergleich zu großen Galaxien meist einen geringeren Anteil interstellarer Materie auf, werden dafür aber um so mehr von dunkler Materie beherrscht.

Trotz ihrer gewaltigen Dimensionen stellen selbst die Galaxien noch nicht das Ende der Stufenleiter dar, sie ordnen sich vielmehr in eine noch höhere Hierarchie ein. Große Galaxien wie die Milchstraße halten sich einen Hofstaat von mehreren Zwerggalaxien (so sind die eben erwähnten Magellanschen Wolken gravitativ an die Milchstraße gebunden). Mehrere solche von kleinen Satelliten umgebene sowie einzelne Galaxien schließen sich weiter zu Galaxienhaufen zusammen, zum Beispiel bilden die von der Milchstraße und der Andromedagalaxie definierten Satellitenysteme zusammen mit einigen weiteren Galaxien die Lokale Gruppe. Galaxienhaufen können bis zu einige 1000 Galaxien enthalten.

Die Galaxienhaufen schließlich bilden die größten bekannten Systeme des Universums, die sogenannten Superhaufen. Der uns am nächsten stehende ist der Virgo-Superhaufen, zu welchem auch die Lokale Gruppe gerechnet wird. Selbst auf dieser höchsten Ebene liegt keine irreguläre Verteilung der Materie vor. Haufen und Superhaufen scheinen vielmehr sich entlang von Filamenten anzuordnen, zwischen denen sich riesige, kaum Galaxien enthaltende Leerräume befinden.

Um die Entstehung und Dynamik all dieser Strukturen zu verstehen, hat sich die Simulation von Mehrkörpersystemen als sehr nützliches Werkzeug erwiesen. Im Prinzip stellt man hierbei das zu untersuchende System als ein Ensemble von Massepunkten dar und berechnet mit bestmöglicher Genauigkeit, wie sich diese infolge ihrer wechselseitigen Anziehungskraft bewegen. Welches reale Objekt dabei einem Massepunkt entspricht, hängt von der betrachteten Hierarchieebene ab. Interessiert man sich für die Vorgänge innerhalb eines Sternhaufens, so repräsentiert jeder Massepunkt einen Stern. Gegebenenfalls um einen Stern laufende Planeten sind dagegen aufgrund ihrer im Vergleich zum Zentralgestirn geringen Masse in der Regel irrelevant. Zudem ist die Ausdehnung ihrer Bahnen viel kleiner als der typische Abstand selbst zum nächsten Stern. Von der Ebene eines Sternhaufens betrachtet, darf ein Stern mitsamt seines Planetensystems somit als ein einziger Körper behandelt werden. Will man großräumige Strukturen des Kosmos untersuchen, so entspricht einem Massepunkt eine Galaxie, wenn nicht gar ein ganzer Galaxienhaufen. Die exakte Verteilung der Sterne innerhalb der Galaxien ist für die relative Bewegung der Galaxien und erst recht der Galaxienhaufen untereinander zumeist bedeutungslos.

Oft reicht es zur Erklärung bestimmter Strukturen jedoch nicht aus, lediglich mit einem Ensemble von Massepunkten als Modell zu arbeiten, die unter wechselseitigem Einfluss der Schwerkraft stehen. Auch anderer Phänomene, wie etwa hydrodynamische Vorgänge oder Strahlung, spielen häufig eine wichtige Rolle. Man nimmt beispielsweise an, dass ein offener Sternhaufen aus einem durch Masseanziehung bedingten Kollaps einer großen, kalten Wolke aus molekularem Wasserstoff hervorgeht. Im Verlauf eines solchen Zusammenbruchs zerfällt die Wolke zu kleineren Klumpen, aus denen schließlich einzelne, z.T. sehr massereiche Sterne entstehen. Solche geben jedoch eine intensive ultraviolette Strahlung ab und ionisieren dadurch ihre Umgebung. Zusätzlich verdrängen sie, durch Strahlungsdruck und Sternwind, das sie umgebende Gas. Nach wenigen Millionen Jahren zerplatzen die ersten sehr massereichen Sterne durch Supernova-Explosionen. Durch die dabei entstehenden Schockwellen wird viel Gas aus dem noch jungen Sternhaufen herausgeschleudert. Die anfänglich sehr aktive Sternentstehung kommt durch diese Verluste an Rohmaterial mehr und mehr zum Erliegen.

Die Simulation von Mehrkörpersystemen wird auch, aber nicht nur, durch den Einfluss solch zusätzlicher Effekte häufig sehr komplex. In bestimmten Fällen ist die Ersetzung realer Himmelskörper durch Massepunkte auch schlicht nicht zulässig. Ein frappantes Beispiel ist der Sternhaufen R136 im Tarantelnebel, welcher die Zentralregion der Großen Magellanschen Wolke darstellt. Dieser Haufen enthält Sterne so hoher Leuchtkraft, dass man von Einzelmassen von bis zu 300 Sonnenmassen ausgehen muss, was nach der aktuellen Theorie der Sternentstehung eigentlich unmöglich ist. Jedoch ist die Sterndichte in diesem Haufen so hoch, dass gemäß Fuji und Portegies Zwart (2013) [5] tatsächlich einzelne Mitglieder miteinander kollidieren und so zu Objekten weit höherer Masse verschmelzen können.

Die Simulation unterschiedlicher Typen von Mehrkörpersystemen im Kosmos soll in diesem Buch detailliert behandelt werden. Dabei wird ausschließlich das Modell unter der Schwerkraft sich bewegender Massepunkte zum Einsatz kommen, da es trotz aller hier skizzierten Vereinfachungen viele Beobachtungen korrekt wiedergeben kann. Zunächst werden die dafür unentbehrlichen physikalischen Grundlagen erläutert, anschließend allgemeine Verfahren für das Lösen von Bewegungsgleichungen vorgestellt. Ein großer Nachteil des auf Massepunkten beruhenden Modells besteht darin, dass sich solche Punkte beliebig nahe kommen könnten und dann im Prinzip unbegrenzt große Anziehungskräfte aufeinander ausüben würden. Wie dieses Problem umgangen werden kann, wird in einem eigenen Kapitel dargelegt. Eine weitere Schwierigkeit für astronomische Mehrkörpersimulationen erwächst aus der Tatsache, dass wegen der großen Reichweite der Gravitation jedes Mitglied eines solchen Systems auf alle übrigen Angehörigen einwirkt. Bei einer auf einem Standard-Verfahren beruhenden Lösung der Bewegungsgleichungen wächst der Rechenaufwand daher mit dem Quadrat der Anzahl der Massepunkte. In einem weiteren Kapitel werden deshalb Algorithmen vorgestellt, welche eine wesentlich effizientere Behandlung von Mehrkörpersystemen gestatten. Im letzten Kapitel wird erläutert, wie sich diese optimierten Lösungsverfahren auf tatsächlich beobachtete Ensembles vom Planetensystem bis herauf zum Universum als Ganzes anwenden lassen.

Grundlagen

[Bearbeiten]Im Folgenden soll ungeachtet aller hier angedeuteten Komplikationen die Schwerkraft als einzige in einem Mehrkörpersystem wirkende Kraft berücksichtigt werden. Zudem sollen - abgesehen von einigen Diskussionen in speziellen Abschnitten - alle Körper als ideale Massenpunkte betrachtet werden. Damit wird indirekt angenommen, dass der Abstand zweier Sterne stets sehr viel größer ist als ihr Durchmesser. Bevor mögliche Lösungsansätze im Detail besprochen werden, sollen zuvor einige für deren Verständnis unentbehrliche Grundbegriffe skizziert werden.

- Vektoren und Skalare

- Mittlere und momentane Geschwindigkeit

- Mittlere und momentane Beschleunigung

- Das Newtonsche Kraftgesetz

- Das Newtonsche Gravitationsgesetz

- Energieerhaltung

- Ruck

Vektoren und Skalare

[Bearbeiten]Bei vielen der in einem Sternsystem interessierenden Größen, z.B. den Geschwindigkeiten der einzelnen Mitglieder, kommt es nicht nur auf den Betrag an, sondern auch auf die Richtung, in welche die Massenpunkte sich bewegen - wie bei einer Autofahrt, wo man sich nicht nur Gedanken darüber macht, wie viele Kilometer man pro Stunde zurücklegen will, sondern auch darüber, welchen Weg man einschlagen muss, um an das Ziel zu gelangen. Solche Größen werden als Vektoren bezeichnet. Dagegen kann man einer Größe wie der Masse keine Richtung zuordnen. Eine solche Größe nennt man Skalar.

Vektoren werden in der Regel durch einen Pfeil über dem Größensymbol gekennzeichnet. Diskutiert man z.B. die Geschwindigkeit einschließlich ihrer Richtung, so schreibt man .

Komponentendarstellung und Betrag eines Vektors

[Bearbeiten]Die Tatsache, dass Vektoren eine Richtungsangabe beinhalten, führt zwangsläufig dazu, dass solche aus mehreren Komponenten bestehen. Will man z.B. von Nürnberg nach Frankfurt gelangen, muss man sich in nordwestliche Richtung bewegen. Die Angabe "Nordwesten" aber schließt bereits zwei Komponenten ein, nämlich "Westen" und "Norden". Man könnte diese durch kartesische Koordinaten wiedergeben, in dem man z.B. die West-Ost-Richtung als x-Achse und die Süd-Nord-Richtung als y-Achse darstellt. Der von Nürnberg nach Frankfurt zielende Vektor hätte dann eine in negative x-Richtung zeigende Komponente und eine etwa gleich große in positive y-Richtung weisende.

Im Alltag kommt man meist mit zwei Richtungskomponenten aus. In einem Sternsystem dagegen mit voller räumlicher Bewegung der einzelnen Massenpunkte sind drei Komponenten erforderlich, zu der x- und y-Achse tritt die z-Achse als weitere kartesische Komponente hinzu. Will man die einzelnen Komponenten eines Vektors auflisten, so verwendet man oft folgende Schreibweise:

, und sind dabei die Geschwindigkeiten in Richtung der drei kartesischen Achsen.

Nicht nur die Geschwindigkeit, auch der Ort eines Körpers ist ein Vektor, denn für eine Ortsangabe werden gleichfalls mehrere Komponenten benötigt. Auf der Erde genügen dazu der Längen- und Breitengrad. In einem Sternsystem müssen abermals drei Komponenten angegeben werden, wobei man als Bezugspunkt zumeist den Schwerpunkt wählt (dieser ist, wie im letzten Abschnitt dieses Unterkapitels dargelegt wird, der auf die Verteilung der einzelnen Massen bezogene Mittelpunkt des Systems). Man schreibt dann z.B.

Der Ortsvektor bezeichnet demgemäß die Richtung, in welcher man vom Ursprung aus zu dem gewünschten Objekt schauen muss.

Den Betrag eines Vektors kann man aus seinen Komponenten mittels des Satzes des Pythagoras berechnen. Um kenntlich zu machen, dass man den Betrag meint ohne Richtungsangaben, lässt man entweder den Pfeil über dem Größensymbol weg (schreibt also z.B. einfach ) oder umgibt die als Vektor markierte Größe mit Betragsstrichen (z.B. ). Auf den Geschwindigkeitsvektor angewandt liefert der Satz des Pythagoras den Absolutwert der Gesamtgeschwindigkeit:

Im Falle des Ortsvektors gewinnt man den Abstand eines Massenpunktes vom Schwerpunkt des Systems.

Vektoren stellt man sich anschaulich oft als Pfeile vor. Die Komponenten geben die Richtung an, nach welcher der Pfeil orientiert ist, der Betrag dessen Länge.

Im Verlauf einer Mehrkörpersimulation müssen Betragsberechnungen sehr häufig durchgeführt werden, so dass es angebracht ist, dafür eine eigene Prozedur zu definieren. Übergeben wird dieser der vektor, dessen Betrag zu bestimmen ist. vektor ist ein Array, das drei Double stellvertretend für die drei kartesischen Komponenten enthält. Der Rückgabewert ist ebenfalls vom Typ Double.

double betrag (double *vektor)

{

return (sqrt (pow (vektor[0],2) + pow (vektor[1],2) + pow (vektor[2],2)));

}

Die wichtigste Anwendung dieser Prozedur besteht in der Berechnung des Abstands zweier Körper. Zunächst bestimmt man dafür den Differenzvektor der Ortsvektoren der beiden Objekte und anschließend dessen Betrag.

Nicht nur für obige, sondern auch für alle nachfolgend in diesem Buch besprochenen Prozeduren werden für reelle Zahlen (Gleitkommazahlen) Variablen des Datentyps Double verwendet. Zwar werden mit diesem Datentyp für jede Gleitkommazahl 8 Byte Speicherplatz benötigt, doch werden mit einer Genauigkeit von 15-16 Dezimalstellen Rundungsfehler minimiert, was wegen der bei einer Mehrkörpersimulation auftretenden großen Zahl von Rechenoperationen von großer Wichtigkeit ist. Mit dem Datentyp Float kommt man mit 4 Byte pro reelle Zahl aus, doch kann mit nur 7-8 vorgehaltenen Dezimalstellen keine ausreichende Rechengenauigkeit gewährleistet werden.

Addition und Subtraktion von Vektoren

[Bearbeiten]Auf Vektoren können die Grundrechenarten Addition und Subtraktion gleichermaßen angewandt werden wie auf Skalare. Dies geschieht, indem man die einzelnen Komponenten addiert bzw. voneinander subtrahiert. Betrachtet man zwei Vektoren und , so gilt für die Vektorsumme :

Amalog gilt für die Vektordifferenz :

Graphisch kann man die Vektoraddition durchführen, in dem man an die Spitze des Vektors den Fuß von setzt. Der Summenvektor erstreckt sich dann von dem Fuß von bis zur Spitze von .

Im Falle der Subtraktion wird ebenfalls der Fuß von an die Spitze von gesetzt, dabei aber zugleich in seine Gegenrichtung umgeklappt. Der Differenzvektor weist wiederum vom Fuß von zur Spitze des umgeklappten Vektors .

Bei der Simulation eines Sternsystems wird die Vektoraddition vor allem zur Berechnung der auf ein Mitglied wirkenden Gesamtkraft benötigt. Jeder andere Massenpunkt übt auf einen beliebig herausgegriffenen Körper eine gewisse Anziehungskraft aus. Um die gesamte Gravitation zu kennen, müssen alle diese einzelnen Kraftvektoren aufsummiert werden.

Um die Anziehung zwischen zwei Massenpunkten zu bestimmen, muss deren Abstand bekannt sein. Dazu wiederum müssen wie schon angedeutet deren Ortsvektoren voneinander subtrahiert werden, woraus der sogenannte Abstandsvektor resultiert.

Multiplikation eines Vektors mit einem Skalar und Einheitsvektor

[Bearbeiten]Wie Skalare können auch Vektoren mit weiteren Skalaren multipliziert werden. Um einen Vektor mit einem Skalar zu multiplizieren, bildet man für jede seiner Komponenten das Produkt mit :

Multipliziert man einen Vektor mit einem Skalar > 1, so wird dieser einfach in der ursprünglichen Richtung gestreckt. Liegt der Skalar zwischen 0 und 1, resultiert eine Stauchung wiederum in ursprünglicher Richtung. Bei Multiplikation mit einem negativen Skalar wird der Vektor nicht nur gestreckt (falls < -1) oder gestaucht (für zwischen -1 und 0), sondern zugleich in seine Gegenrichtung umgeklappt.

Die Division mit einem Skalar ist gleichbedeutend mit der Multiplikation mit . Wird ein Vektor durch Multiplikation mit einem Skalar > 1 gestreckt, so wird er durch Division mit demselben gestaucht (die Division wirkt dann wie eine Multiplikation mit einem Skalar < 1).

Eine besondere, aber in der Praxis oft benötige Rechenoperation ist die Division eines Vektors mit seinem eigenen Betrag. Der dadurch gewonnene Vektor hat exakt die Länge 1 und wird als Einheitsvektor bezeichnet; er zeigt in die gleiche Richtung wie der Ausgangsvektor:

Der Einheitsvektor stellt eine reine Richtungsangabe dar. So bezeichnet beispielsweise der Einheitsvektor der Geschwindigkeit die Richtung, in welche sich ein Objekt gerade bewegt. Der Einheitsvektor des Abstandsvektors gibt die Verbindungslinie zweier Massenpunkte an.

Der einheitsvektor eines vektor lässt sich mit folgender Prozedur gewinnen. Zunächst liefert die Betragsprozedur in Form der Double laenge den Betrag von vektor. Danach wird jede Komponente von vektor mit laenge dividiert. einheitsvektor ist wie vektor ein Array mit 3 Double.

Der Nullvektor, dessen Komponenten und somit auch dessen Betrag gleich 0 sind, ist nicht normierbar. Um diesen Sonderfall programmiertechnisch abfangen zu können, gibt die Prozedur für den Nullvektor wiederum den Nullvektor zurück.

void einheit (double *vektor, double *einheitsvektor)

{

double laenge;

unsigned int k;

laenge = betrag (vektor);

for (k = 0;k < 3;k ++)

{

if (laenge > 0)

einheitsvektor[k] = vektor[k] / laenge;

else

einheitsvektor[k] = 0;

}

}

Skalarprodukt und Kreuzprodukt

[Bearbeiten]Das "Produkt" zweier Vektoren hat im Gegensatz zur Multiplikation eines Vektors mit einem Skalar mit einer gewöhnlichen Multiplikation nur wenig zu tun. Es existieren zwei verschiedene Formen, das Skalarprodukt und das Kreuzprodukt.

Das Skalarprodukt zweier Vektoren und wird so genannt, weil es nicht wie die bisher skizzierten Rechenoperationen wieder einen Vektor, sondern einen Skalar liefert. Es wird in der Regel durch den gewöhnlichen Multiplikationspunkt zwischen den beiden betrachteten Vektoren kenntlich gemacht, man schreibt also . Gegeben ist es durch die Beträge von und sowie den Cosinus des von den beiden Vektoren eingeschlossenen Winkels :

Graphisch lässt sich das Skalarprodukt folgendermaßen darstellen. Man projiziert den Vektor senkrecht auf und erhält so den Vektor . Das Skalarprodukt folgt dann durch Multiplikation der Beträge von und . Ist der Winkel spitz, zeigt in die gleiche Richtung wie und das Skalarprodukt ist positiv. Stehen die beiden zu "multiplizierenden" Vektoren senkrecht aufeinander, so verschwindet die Projektion von , d.h. das Skalarprodukt ist gleich 0. Im Falle eines stumpfen Zwischenwinkels zeigt der Projektionsvektor in die Gegenrichtung von , wodurch das Skalarprodukt negativ wird.

Schließlich sei auch die kartesische Darstellung des Skalarprodukts gegeben. Man multipliziert jeweils die Komponenten der beiden Vektoren miteinander und summiert die einzelnen Produkte auf.

Das skalarprodukt zweier Vektoren vektor1 und vektor2 lässt sich durch folgende Prozedur berechnen. Beide sind Arrays mit je 3 Double, der Rückgabewert ebenfalls vom Typ Double.

double skalarprodukt (double *vektor1, double *vektor2)

{

return (vektor1[0] * vektor2[0] + vektor1[1] * vektor2[1] + vektor1[2] * vektor2[2]);

}

Das Skalarprodukt taucht in mehreren in diesem Buch verwendeten Formeln auf, wobei jedoch keine herausragende Anwendung genannt werden kann. In der Geometrie wird das Skalarprodukt z.B. verwendet, um nachzuprüfen, ob zwei Geraden aufeinander senkrecht stehen. Dies ist dann der Fall, wenn das Skalarprodukt ihrer Richtungsvektoren gleich 0 ist.

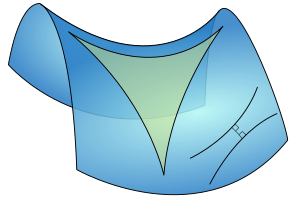

Das Kreuzprodukt erinnert noch weniger an die gewöhnliche Multiplikation als das Skalarprodukt. Es liefert wieder einen Vektor und wird durch ein "x" zwischen den zu kombinierenden Vektoren gekennzeichnet (z.B. ). Der resultierende Vektor steht senkrecht auf den beiden Ausgangsvektoren, sein Betrag entspricht der Fläche des von diesen aufgespannten Parallelogramms:

Die kartesische Darstellung des Kreuzprodukts ist relativ kompliziert:

Im Gegensazu zu Vektoraddition und Skalarprodukt folgt das Kreuzprodukt dem Kommutativgesetz nicht, es gilt:

Auch für das Kreuzprodukt sei eine Prozedur gegeben. Übergeben werden dieser die zu untersuchenden Vektoren vektor1 und vektor2, zurückgegeben wird das Ergebnis vektor3. Sämtliche Vektoren sind Arrays mit je 3 Double.

void kreuzprodukt (double *vektor1, double *vektor2, double *vektor3)

{

vektor3[0] = vektor1[1] * vektor2[2] - vektor1[2] * vektor2[1];

vektor3[1] = vektor1[2] * vektor2[0] - vektor1[0] * vektor2[2];

vektor3[2] = vektor1[0] * vektor2[1] - vektor1[1] * vektor2[0];

}

Eine klassische Anwendung des Kreuzprodukts in der Astronomie ist die Bestimmung des Bahndrehimpulses der Planetenbewegung, welcher durch das Kreuzprodukt des Orts- und Geschwindigkeitsvektors des Planeten, multipliziert mit dessen Masse, gegeben ist. Der Bahndrehimpuls verändert sich während des Umlaufs um die Sonne nicht, woraus das Zweite Keplersche Gesetz folgt, wonach der Ortsvektor (als Verbindungslinie zwischen Sonne und Planet) in gleichen Zeiten gleiche Flächen überstreicht. Dieses Gesetz wird oft auch als Flächensatz bezeichnet.

Schwerpunkt eines Systems von Massenpunkten

[Bearbeiten]Für die Simulation eines Mehrkörpersystems wählt man wie bereits erwähnt als Koordinatenursprung zumeist dessen Schwerpunkt. Man erhält dessen Ortsvektor , indem man für die Ortsvektoren der einzelnen Mitglieder deren gewichtetes Mittel bildet, wobei als Gewichtsfaktoren die individuellen Massen dienen:

Jede Komponente von stellt eine Art Mittelwert der entsprechenden Komponenten der Einzelobjekte dar. Im Gegensatz zum gewöhnlichen (arithmetischen) Mittel tragen die individuellen Körper jedoch nicht in gleichem Maße dazu bei, sondern mehr oder weniger je nach ihrer Masse. Ist z.B. doppelt so groß wie , so wird das Mitglied 1 bei der Mittelwertbildung gegenüber dem Mitglied 2 quasi doppelt gezählt. Der Schwerpunkt stellt somit den Mittelpunkt des Systems dar, wobei aber berücksichtigt wird, wie die einzelnen Massen verteilt sind.

Ein alltägliches Beispiel für den Schwerpunkt als gewichtetes Mittel unterschiedlicher Massen ist der Hebel. Um mit einer kleinen Masse z.B. eine doppelt so große Masse aufwiegen zu können, muss der Hebelarm für doppelt so lang sein wie für . Der Schwerpunkt des Sonnensystems liegt sehr nahe am Sonnenmittelpunkt (nahe deren Oberfläche), weil die Masse der Sonne sehr viel größer ist als diejenige selbst des massereichsten Planeten, des Jupiter.

Um die Ortsvektoren der einzelnen Massenpunkte auf den Schwerpunkt zu beziehen, zieht man einfach dessen Ortsvektor von diesen ab:

Lässt man eine Mehrkörpersimulation ablaufen, so ist es wünschenswert, dass der Schwerpunkt selbst ruht, also im Koordinatenursprung verharrt. Dies gelingt, indem man auch die Geschwindigkeiten in das Schwerpunktsystem umrechnet. Man geht dabei vor wie für die Ortsvektoren, d.h. bestimmt erst die Geschwindigkeit des Schwerpunkts und zieht diese dann von den ursprünglichen Geschwindigkeiten der Einzelobjekte ab.

Die Geschwindigkeit des Schwerpunkts folgt in Analogie zu seinem Ortsvektor aus dem gewichteten Mittel der Geschwindigkeiten der individuellen Körper:

Entsprechend gewinnt man die korrigierten Einzelgeschwindigkeiten aus den originalen durch Subtraktion der Schwerpunktgeschwindigkeit:

Die Frage, wie die anfänglichen Positionen und Geschwindigkeiten der Massenpunkte festzulegen sind, wird im Praxiskapitel ausführlich behandelt. Es wird dort aufgezeigt, dass die dafür erforderliche Herangehensweise sehr stark von dem Typ des zu untersuchenden Systems abhängt.

Die Umrechnung von Orten und Geschwindigkeiten ins Schwerpunktsystem kann mit folgender Prozedur bewerkstelligt werden. Übergeben werden dieser die Anzahl der Körper N, die Gesamtmasse M des Systems, die Einzelmassen m sowie die Vektoren r im ursprünglichen System. N ist vom Typ unsigned Integer, M eine Double. An für sich könnte die Gesamtmasse auch innerhalb der Prozedur bestimmt werden. Jedoch wird diese auch für andere Anwendungen benötigt, so dass M für die später diskutierten Praxisbeispiele vorab berechnet wird.

m ist ein eindimensionales Array, welches aus N Double besteht, entsprechend der Masse jedes einzelnen Objekts. r stellt ein zweidimensionales Array dar, welches N Vektoren enthält, die wiederum je drei Double auflisten. Diese Vektoren können sowohl Orte als auch Geschwindigkeiten repräsentieren, je nachdem was man umrechnen will.

Die Prozedur bestimmt zuerst den Zähler obiger Ausdrücke. Anschließend wird dieser durch M dividiert. Der so gewonnene Schwerpunkt wird durch das Array s repräsentiert. Im letzten Schritt erfolgt für r der Übergang ins Schwerpunktsystem, d.h. dieses Array nimmt am Ende auch die Rückgabewerte auf. Die Ausgangswerte werden dabei überschrieben, d.h. nicht weiter verwendet.

void schwerpunkt (unsigned int N, double M, double *m, double **r)

{

unsigned int i,k;

double s[3];

for (k = 0;k < 3;k ++)

s[k] = 0;

for (i = 0;i < N;i ++)

{

for (k = 0;k < 3;k ++)

s[k] += m[i] * r[i][k];

}

for (k = 0;k < 3;k ++)

s[k] /= M;

for (i = 0;i < N;i ++)

{

for (k = 0;k < 3;k ++)

r[i][k] -= s[k];

}

}

Die Koordinatentransformation in das Schwerpunktsystem muss nur ein einziges Mal zu Beginn der Simulation durchgeführt werden. Begründet ist dies durch die Erhaltung der Energie (welche im Unterkapitel Energieerhaltung detailliert besprochen wird) sowie die Unabhängigkeit der physikalischen Gesetze vom Beobachtungsort und der Blickrichtung. Die fundamentale Annahme, dass überall im Kosmos die gleichen physikalischen Gesetze gelten, bezeichnet man als Homogenität des Raumes. Die nicht weniger bedeutsame Annahme, dass (auf genügend großer Längenskala) das Universum in jeder Blickrichtung die gleichen Eigenschaften aufweist, als Isotropie des Raumes.

Mittlere und momentane Geschwindigkeit

[Bearbeiten]Definition

[Bearbeiten]Um die Bahnen der einzelnen Mitglieder eines Sternsystems vorhersagen zu können, braucht man ein Verfahren, das deren momentane Geschwindigkeiten zu jedem Zeitpunkt liefert (es soll zunächst nur vom Betrag der Geschwindigkeit die Rede sein). Tatsächlich messen kann man jedoch nur die mittlere Geschwindigkeit , welche sich auf die in einem gewissen Zeitraum zurückgelegte Strecke bezieht.

Kommt man z.B. mit dem Auto in 2 Stunden 200 km weit, so beträgt die mittlere Geschwindigkeit 200 km / 2 h = 100 km/h. Dem Ideal der momentanen Geschwindigkeit kann man aber zumindest nahe kommen, indem man den durch die Messung überspannten Zeitraum sehr klein macht. Dies geschieht z.B. durch den Tachometer, welcher die Drehzahl (und damit mit Hilfe des Abrollumfangs der Räder die gefahrene Strecke) auf einer Zeitskala von Zehntelsekunden erfasst (gemessen wird dabei allein der Betrag der Geschwindigkeit, nicht jedoch deren Richtung).

Bei einer für jeden beliebigen Zeitpunkt bekannten momentanen Geschwindigkeit lässt sich die während eines bestimmten Zeitraums zurückgelegte Strecke bestimmen, indem man gegen aufträgt und die Fläche unter der entsprechenden Kurve ermittelt. Bei konstanter Geschwindigkeit ist diese Fläche ein Rechteck entsprechend der bekannten Regel Strecke = Geschwindigkeit ∙Zeit.

Für eine Mehrkörpersimulation müssen Positionen und Geschwindigkeiten wie zu Beginn dieses Kapitels diskutiert natürlich als Vektoren betrachtet werden. Man erhält den mittleren Geschwindigkeitsvektor, indem man für jede Komponente des Ortsvektors deren Änderung mit der Zeit betrachtet:

Bei konstantem Geschwindigkeitsvektor gilt wiederum für die Änderung des Ortsvektors während einer bestimmten Zeit:

Einschub für Fortgeschrittene: Definition der Geschwindigkeit

Die mittlere Geschwindigkeit folgt aus der während eines Zeitraums zurückgelegten Strecke gemäß:

Je kleiner man wählt, umso besser stimmt die mittlere Geschwindigkeit mit der momentanen Geschwindigkeit überein. Im Grenzfall gehen die beiden Geschwindigkeiten ineinander über.

Aus dieser Definition von als Grenzwert von folgt, dass die momentane Geschwindigkeit durch die erste Zeitableitung der Strecke gegeben ist.

Umgekehrt gewinnt man die während eines endlichen Zeitraums bewältige Distanz durch Integration über .

Durch Division mit erhält man den exakten Zusammenhang zwischen momentaner und mittlerer Geschwindigkeit.

Mittlere und momentane Beschleunigung

[Bearbeiten]Definition

[Bearbeiten]Die Kenntnis der momentanen Geschwindigkeiten - wiederum sollen zunächst nur Beträge statt Vektoren diskutiert werden - setzt wiederum diejenige der momentanen Beschleunigungen voraus. Diese stellt wie die momentane Geschwindigkeit eine Idealisierung dar, denn auch eine Änderung der Geschwindigkeit lässt sich nur für einen bestimmten von Null verschiedenen Zeitraums erfassen. Daraus resultiert eine mittlere Beschleunigung

Diese Mittelung kommt auch in Redewendungen wie „in 10 s von 0 auf 100“ zum Ausdruck. Um die entsprechende mittlere Beschleunigung zu bestimmen, müssen für Zeit und Geschwindigkeit natürlich analoge Einheiten benutzt werden. 100 km/h entsprechen 100 / 3.6 ≈ 28 m/s, woraus eine mittlere Beschleunigung von 28 m/s / 10 s = 2.8 m/s2 folgt – pro Sekunde nimmt die Geschwindigkeit im Mittel um 2.8 m/s zu.

Wie für die Geschwindigkeit kann man auch für die Beschleunigung zumindest näherungsweise Momentanwerte gewinnen, indem man nur über sehr kurze Zeiträume misst. Fährt man mit hoher Geschwindigkeit in eine Kurve, so erfährt man plötzlich eine senkrecht zur Fahrtrichtung nach „außen“ wirkende Beschleunigung.

In der technischen Praxis wird die Beschleunigung nicht mit Hilfe obiger Definition, sondern auf Grundlage des Newtonschen Kraftgesetzes bestimmt, in dem die auf eine bekannte Masse ausgeübte Kraft gemessen wird. Die Definition der Beschleunigung als Änderung der Geschwindigkeit pro Zeitintervall ist jedoch fundamental für die im nächsten Kapitel vorgestellten Lösungsmethoden des Mehrkörperproblems.

Auf das Newtonsche Kraftgesetz wird im folgenden Unterkapitel ausführlich eingegangen. Anwendungen wie Trägheitsnavigation oder Seismologie belegen, dass man anhand dieses Prinzips Beschleunigungen auch für sehr kurze Zeiträume messen und damit dem Ideal der Momentanbeschleunigung sehr nahe kommen kann.

Die während eines gewissen Zeitraums eintretende Änderung der Geschwindigkeit lässt sich auf ähnliche Weise berechnen wie die zurückgelegte Strecke. Man trägt nun die Momentanbeschleunigung gegen die Zeit auf und betrachtet wiederum die Fläche unter der dazugehörigen Kurve. Bei gleichbleibender Beschleunigung erhält man abermals ein Rechteck in Übereinstimmung mit der Vorschrift Änderung der Geschwindigkeit = Beschleunigung ∙ Zeit.

Ebenso wie Ort und Geschwindigkeit stellt auch die Beschleunigung einen Vektor dar. Um den mittleren Beschleunigungsvektor zu bestimmen, muss man für den Geschwindigkeitsvektor die zeitliche Änderung einer jeden Komponente untersuchen:

Im Falle eines konstanten Beschleunigungsvektors lautet dementsprechend die Änderung des Geschwindigkeitsvektors im Verlauf eines gewissen Zeitintervalls:

Einschub für Fortgeschrittene: Definition der Beschleunigung

Die folgende Diskussion ist derjenigen über die Geschwindigkeit vollkommen analog. Die mittlere Beschleunigung ist gegeben durch die während eines Zeitraums sich einstellenden Änderung der Geschwindigkeit .

Erneut ist der momentane Wert als Grenzwert des Mittelwerts definiert.

Dies bedeutet, dass die momentane Beschleunigung mit der ersten Zeitableitung der Geschwindigkeit identisch ist.

Die während eines endlichen Zeitraums beobachtbare Änderung der Geschwindigkeit folgt aus dem Integral über .

Wieder liefert die Division mit die Beziehung zwischen momentanem und mittlerem Wert.

Beschleunigung und Strecke

[Bearbeiten]Oft ist nicht nur der Zusammenhang zwischen Beschleunigung und Geschwindigkeit, sondern auch direkt zwischen Beschleunigung und zurückgelegter Strecke von Interesse (wobei abermals zunächst nur Beträge diskutiert werden). Für den Spezialfall einer konstanten Beschleunigung lässt er sich wiederum graphisch recht einfach herleiten.

Wird ein Körper aus der Ruhelage heraus konstant beschleunigt, so nimmt seine Geschwindigkeit direkt proportional zur verflossenen Zeit zu. Die dabei zurückgelegte Strecke ist dann als Dreiecksfläche unter der Geschwindigkeitskurve gegeben. Die Grundlinie des Dreiecks ist durch die verstrichene Zeit , dessen Höhe durch gegeben. Aus der wohlbekannten Beziehung Dreiecksfläche = Grundlinie ∙ Höhe / 2 folgt so:

Diese Beziehung gibt z.B. an, welche Strecke man nach einer gewissen Zeit beim freien Fall unter Vernachlässigung des Luftwiderstands zurückgelegt hat. Für ist dann der Wert von 9.81 m/s2 für die Fallbeschleunigung einzusetzen. Nach 1 s ist man 4.9 m, nach 2 s aber schon das vierfache, nämlich 19.6 m gefallen.

Setzt man bzw. in obige Formel ein, gewinnt man folgende von der Zeit unabhängige Beziehung zwischen Strecke und Geschwindigkeit:

Damit kann man z.B. berechnen, mit welcher Geschwindigkeit man bei einer bestimmten Fallhöhe auf dem Boden ankommt. Bei einem Sprung vom 5-Meter-Brett beträgt die Aufprallgeschwindigkeit 9.9 m/s entsprechend 36 km/h. Ein vom 10-Meter-Brett fallender Turmspringer bringt es auf 14.0 m/s bzw. 50 km/h.

Weist ein konstant beschleunigter Körper zu Beginn bereits eine gewisse Geschwindigkeit auf, so muss zur nach einer Zeit bewältigten Strecke der Anteil hinzuaddiert werden, so dass gilt.

Betrachtet man Ort, Geschwindigkeit und Beschleunigung abermals als Vektoren, so ist obige Formel für jede Komponente einzeln anzuwenden:

Einschub für Fortgeschrittene: Beschleunigung und zurückgelegte Strecke

Aus den Definitionen von momentaner Beschleunigung und Geschwindigkeit folgt, dass erstere durch die zweite Zeitableitung der Strecke gegeben ist.

Dadurch ist die Berechnung der zurückgelegten Distanz aus der momentanen Beschleunigung allgemein etwas aufwendiger. Die momentane Geschwindigkeit nach einem Zeitraum lässt sich schreiben als:

Die nochmalige Integration über obigen Ausdruck liefert für :

Für einen aus dem Ruhezustand heraus konstant beschleunigten Körper erhält man daraus wiederum die bereits oben graphisch abgeleitete klassische Beziehung.

Das Newtonsche Kraftgesetz

[Bearbeiten]Als nächstes stellt sich die Frage, wie die Beschleunigungen zu bestimmen sind, welche auf die Mitglieder eines Mehrkörpersystems einwirken. Den Schlüssel hierzu liefert das Newtonsche Kraftgesetz, welches anschaulich oft als Kraft = Masse • Beschleunigung formuliert wird.

Um ein Auto der Masse von 1000 kg in 10 Sekunden von 0 auf 100 km/h zu beschleunigen, ist demnach eine Kraft von 1000 kg • 2.8 m/s2 = 2800 Newton erforderlich (wobei hier Luftwiderstand und Haftreibung vernachlässigt sind). Kennt man die auf einen Massenpunkt einwirkende Kraft, so folgt aus dem Kraftgesetz die Beziehung Beschleunigung = Kraft / Masse.

Die Beschleunigung, welche ein Körper erfährt, ist also der auf ihn ausgeübten Kraft direkt und seiner Masse umgekehrt proportional. Um eine doppelt so große Masse der gleichen Beschleunigung zu unterwerfen, ist die doppelte Kraft erforderlich.

Das Kraftgesetz betrachtet nicht nur die Beträge von Kraft und Beschleunigung, sondern auch deren Richtungen. Es gilt die einleuchtende Regel, dass die Beschleunigung in dieselbe Richtung erfolgt, in welcher die Kraft gerichtet ist. Dies kommt auch schon in obiger Vektorschreibweise zum Ausdruck, wonach der Beschleunigungsvektor lediglich mit einem Skalar > 0 (nämlich der Masse) multipliziert werden muss, um den Kraftvektor zu erhalten. Bei einer solchen Rechenoperation aber bleibt - wie schon ganz zu Anfang dieses Kapitels erläutert - die ursprüngliche Richtung des Vektors erhalten.

Wie schon erwähnt, ermöglicht es das Newtonsche Kraftgesetz, Beschleunigungen zu messen, indem man die auf eine bekannte Testmasse einwirkenden Kräfte betrachtet. Man stelle sich z.B. einen Aufzug vor, in welchem an einer Federwaage eine Masse von 1 kg hängt. Ruht der Aufzug, wirkt allein die Schwerebeschleunigung (etwa 9.8 m/s2) auf die Masse ein. Die Federwaage zeigt dann eine Kraft von 9.8 Newton an. Setzt sich der Aufzug nach oben in Bewegung, so wird die Testmasse einer zusätzlichen Beschleunigung unterworfen. Die Feder wird dadurch stärker ausgelenkt, sie zeigt jetzt eine größere Kraft an, woraus die Beschleunigung des Aufzugs gemäß bestimmt werden kann. Zeigt die Federwaage z.B. 12 Newton an, so entspricht das einer Beschleunigung von (12 / 1 - 9.8) m/s2 = 2.2 m/s2.

Himmelskörper kann man natürlich nicht als Testmassen benutzen, um die auf sie ausgeübten Beschleunigungen zu messen. Wie im nächsten Unterkapitel gezeigt, liefert für solche das Newtonsche Gravitationsgesetz belastbare Kriterien für die wechselseitig herrschenden Kräfte und damit Beschleunigungen.

Das Newtonsche Gravitationsgesetz

[Bearbeiten]Kernaussagen

[Bearbeiten]Die Berechnung der in einem Mehrkörpersystem herrschenden Kräfte selbst beruht auf dem Newtonschen Gravitationsgesetz. Dieses besagt, dass die zwischen zwei Massen und herrschende Anziehungskraft diesen direkt und dem Quadrat ihres Abstandes umgekehrt proportional ist, und die Kraft in Richtung ihrer Verbindungslinie wirkt. soll dabei die Kraft bezeichnen, welche der Körper auf den Körper ausübt.

bezeichnet dabei die Gravitationskonstante mit dem Wert 6.67384 10-11 m3 kg-1 s-2. ist der Einheitsvektor auf der Verbindungslinie der beiden Massen, er zeigt von nach .

In der Praxis interessiert nicht die auf einen Massenpunkt einwirkende Kraft, sondern nur dessen Beschleunigung. Aus dem Newtonschen Kraftgesetz folgt, dass die Masse folgende Beschleunigung durch die Masse erfährt:

Entsprechend erleidet die Masse eine Beschleunigung durch die Masse in entgegengesetzter Richtung.

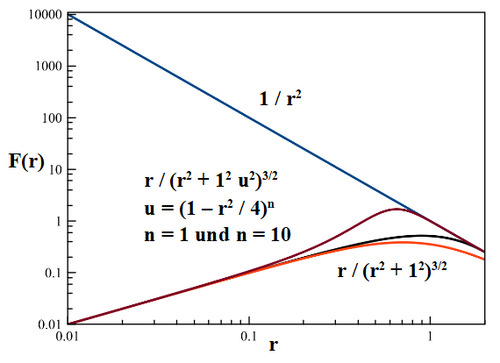

Aus der umgekehrt quadratischen Abhängigkeit der Anziehungskraft vom Abstand der Massen folgt, dass bei doppeltem Abstand diese auf ein Viertel des Vergleichswertes abgefallen ist, bei dreifachem Abstand auf ein Neuntel usw. Die Schwerkraft fällt also nur langsam mit zunehmendem Abstand ab. Im Prinzip besitzt sie eine unendliche Reichweite, was bei der Modellierung von Mehrkörperensembles erhebliche Schwierigkeiten nach sich ziehen kann. Andererseits nimmt die wechselseitige Anziehungskraft enorm zu, wenn zwei Mitglieder sich sehr nahe kommen. Da solche zumeist als Massenpunkte behandelt werden, können im Verlauf einer Simulation grundsätzlich beliebig kleine Abstände und damit unbegrenzt große Kräfte auftreten. Auch dieser Effekt erschwert eine zuverlässige Behandlung astronomischer Systeme enorm.

Um die gesamte Beschleunigung eines Massenpunkts zu kennen, müssen sämtliche Einzelbeschleunigungen aufaddiert werden, welche alle übrigen Mitglieder des Ensembles auf diesen ausüben. Eine solche Gesamtbetrachtung ist für alle Körper notwendig, d.h. es müssen alle möglichen Abstandspaare betrachtet werden, die man für die individuellen Massenpunkte bilden kann. Daraus folgt, dass der Aufwand zur Berechnung aller Anziehungskräfte quadratisch mit der Anzahl der Mitglieder eines Mehrkörpersystems ansteigt. Eine exakte Erfassung der Kräfte ist mit vertretbarem Rechenaufwand somit nur für eine Simulation von bis zu einigen 1000 Massenpunkten möglich. Für komplexere Systeme ist man auf Näherungsverfahren angewiesen, welche später im Detail erläutert werden.

Wie bereits erörtert, werden für praktische Simulationen oft kartesische Koordinaten mit dem Schwerpunkt des zu untersuchenden Ensembles als Ursprung verwendet. Die momentane Position der Masse sei so durch einen Vektor und diejenige der Masse durch einen solchen gegeben.

Für die Berechnung der wechselseitigen Beschleunigungen der beiden Massen kommt es allein auf den Abstandsvektor an. In kartesischen Koordinaten lautet dieser:

Den Einheitsvektor gewinnt man, indem man den Abstandsvektor mit seinem eigenen Betrag dividiert:

Einsetzen in die oben gegebenen Beschleunigungen liefert:

Der Betrag des Abstandsvektors folgt aus dem Satz des Pythagoras:

Elementare Schlussfolgerungen

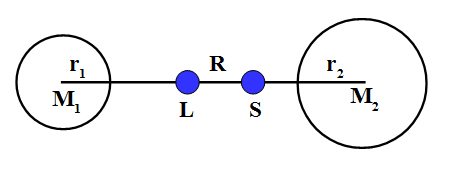

[Bearbeiten]An dieser Stelle sollen bereits einige Schlussfolgerungen gezogen werden, welche für die Simulation von Mehrkörpersystemen von Bedeutung sind. Dazu soll das sehr einfache Beispiel einer kleinen Masse betrachtet werden, welche um eine große Masse auf einer Kreisbahn mit Radius umläuft.

Dabei sei zuerst die Bahngeschwindigkeit betrachtet. Man erhält sie durch Gleichsetzen der Gravitationsbeschleunigung mit der Zentripetalbeschleunigung :

Je weiter ein Körper von seiner Zentralmasse entfernt ist, um so geringer ist seine Bahngeschwindigkeit, was auch für Ellipsenbahnen zutrifft. Im Falle einer Kreisbahn nimmt umgekehrt proportional zur Quadratwurzel der Entfernung ab, d.h. bei vierfacher Entfernung beträgt die Bahngeschwindigkeit nur noch die Hälfte, bei neunfachem Abstand noch ein Drittel des Bezugswertes usw.

Aus der Bahngeschwindigkeit und dem Umfang der Bahn folgt die Umlaufdauer . Es gilt , woraus durch Einsetzen und Quadrieren folgt:

Das Quadrat der Umlaufdauer ist dem Kubus des Bahnradius proportional, wobei die Proportionalitätskonstante durch die Zentralmasse bestimmt ist. Diese Beziehung gilt unverändert auch für Ellipsen, wobei an die Stelle des Bahnradius die große Halbachse tritt. Es handelt sich hierbei um das 3. Keplersche Gesetz.

Verdoppelt man die Entfernung, so steigt die Umlaufdauer um den Faktor entsprechend etwa 2.8. Bei dreifacher Entfernung nimmt um das -fache zu, entsprechend ungefähr dem Faktor 5.2.

Das 3. Keplersche Gesetz bietet eine sehr anschauliche Prüfmöglichkeit für die Gültigkeit des Gravitationsgesetzes und damit der daraus abgeleiteten Kräfte und Beschleunigungen. Die Entfernung der Erde von der Sonne kann aus Parallaxenmessungen bestimmt werden, die Abstände zu den übrigen Planeten des inneren Sonnensystems auch aus Radarmessungen. Die Verhältnisse der Abstände zur Sonne sind also mit hoher Genauigkeit bekannt und können mit den ebenfalls genau bekannten Verhältnissen der Umlaufdauern verglichen werden (eine Gegenüberstellung der Absolutentfernungen zur Sonne und der absoluten Werte der Umlaufdauern erforderte auch noch eine unabhängige Kenntnis der Sonnenmasse).

Man muss bei dieser Argumentation allerdings beachten, dass das 3. Keplersche Gesetz streng genommen nur für ein aus lediglich zwei Körpern bestehendes System gültig ist. Allerdings wird die auf einen Planeten einwirkende Schwerkraft fast völlig von der Sonne dominiert, so dass dessen Bahn als eine von den übrigen Planeten nur geringfügig gestörte Ellipse betrachtet werden darf. Auf diese Problematik wird im Praxiskapitel ausführlich eingegangen.

Sieht man sich Umlaufdauer, Bahngeschwindigkeit und Gravitationsbeschleunigung nochmals genau an, so stellt man fest, dass sie folgenden Zusammenhang erfüllen:

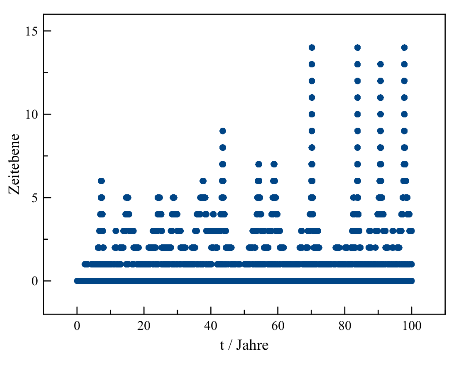

Wie später gezeigt wird, ist dieses Verhältnis von Geschwindigkeit und Beschleunigung eines Massenpunktes ein fundamentales Kriterium für die zeitliche Schrittweite, mit welcher dessen Bewegung in einem Mehrkörpersystem modelliert werden soll. Es wird sehr häufig dynamische Zeit genannt.

C-Code: Beschleunigungen im Mehrkörpersystem

Nun stehen alle erforderlichen Kenntnisse für die praktische Berechnung der auf einen Massenpunkt einwirkenden Beschleunigung bereit. Angesichts der immer gleichartigen Berechnungen für jede Vektorkomponente bietet es sich an, die Positionen (x,y,z) zu einem Array r und die Beschleunigungen (ax,ay,az) zu einem Array a für den Variablentyp Double zusammenzufassen. Da r und a für jeden Körper gebraucht werden, müssen diese Größen tatsächlich als zweidimensionale Arrays deklariert werden. Die Masse m muss ebenfalls für jedes Mitglied des Ensembles gegeben sein. Als Skalar erfordert diese nur ein eindimensionales Array wiederum für den Variablentyp Double.

Die Unsigned Integer i und k dienen dazu, die einzelnen Massenpunkte und deren Vektorkomponenten abzuzählen. Die Unsigned Integer N gibt die Gesamtzahl der Körper an. Für den Abstandsvektor dr zweier Objekte genügt ein einfaches Array für den Variablentyp Double mit 3 Elementen. Die Double d3 schließlich bezeichnet die 3. Potenz dessen Betrags.

Programmiertechnisch werden zweidimensionale Vektorarrays wie r und a im Folgenden als eindimensionale Arrays von Zeigern behandelt. Für jeden Massenpunkt gibt es einen Zeiger, der auf jede der 3 Komponenten des entsprechenden Vektors deuten kann. Eindimensionale Skalararrays wie m werden jeweils durch einen einzigen Zeiger realisiert. Ein solcher Zeiger kann auf jeden der N Körper deuten.

Die Berechnung der Beschleunigung ist ein während einer Mehrkörpersimulation sich ständig wiederholender Vorgang. Somit ist es naheliegend, diese als Prozedur zu definieren, welcher die Nummer objekt des gerade zu bearbeitenden Massenpunkts, N, m und r übergeben werden. Zurückgegeben wird die Beschleunigung a[objekt]. Mit dieser Konstruktion werden i, k, dr und d3 zu lokalen Variablen. Aufgerufen wird die Prozedur durch die Anweisung beschleunigung (objekt,N,m,r,a[objekt]).

/* Globale Variablen */

unsigned int objekt

unsigned int N;

double *m;

double **r;

double **a;

void beschleunigung (unsigned int objekt, unsigned int N, double *m, double **r, double *a)

{

/* Lokale Variablen */

unsigned int i,k;

double dr[3];

double d3;

/* Initialisierung der Beschleunigung */

for (k = 0;k < 3;k ++)

a[k] = 0;

/* Berechnung der Beschleunigung */

for (i = 0;i < N;i ++)

{

if (i != objekt)

{

/* Abstandsvektor zwischen einem beliebigen Körper i und dem untersuchten Massenpunkt objekt */

for (k = 0;k < 3;k ++)

dr[k] = r[i][k] - r[objekt][k];

/* 3.Potenz dessen Betrags */

d3 = pow (betrag (dr),3);

/* Beitrag der Beschleunigung durch den Körper i */

for (k = 0;k < 3;k ++)

a[k] += G * m[i] * dr[k] / d3;

}

}

}

Vor allem für mehrdimensionale Arrays ist eine sorgfältige Speicheradressierung erforderlich, die hier zumindest kurz angedeutet werden soll. Benötigt werden hierzu zumindest die Anweisungen malloc (um Speicher zu adressieren) und free (um solchen wieder freizugeben).

Für eindimensionale Skalararrays wie die Masse ist die Speicheradressierung sehr einfach. Mit der Anweisung malloc wird für jeden Körper Speicher für eine Double bereitgestellt.

m = malloc (N * sizeof (double));

Bei zweidimensionalen Arrays wie hier etwa der Position erfolgt die Speicheradressierung in zwei Schritten. Zunächst wird für jedes Objekt Speicher für einen Zeiger (Vektorobjekt) reserviert (deshalb sizeof (double *) und nicht sizeof (double)). Anschließend wird für jeden dieser Zeiger Platz für jeweils 3 Double (Vektorkomponenten) geschaffen.

r = malloc (N * sizeof (double *));

for (i = 0;i < N;i ++)

r[i] = malloc (3 * sizeof (double));

Um reservierten Speicher wieder freizugeben, genügt für Skalararrays abermals eine einzige Anweisung. Mit free wird der gesamte durch die N Double beanspruchte Platz wieder frei.

free (m);

Zweidimensionale Arrays verlangen auch bei der Speicherfreigabe ein zweistufiges Vorgehen, wobei aber im Vergleich zur Speicheradressierung die Reihenfolge umgekehrt wird. Zuerst muss für jeden Körper der durch die Vektorkomponenten belegte Speicher freigegeben werden. Danach kann der durch die Vektorobjekte selbst belegte Platz geräumt werden.

for (i = 0;i < N;i ++)

free (r[i]);

free (r);

Für eine detaillierte Behandlung der Speicherverwaltung mittels C oder C++ sei auf die einschlägige Literatur (auch unter Wikibooks selbst) verwiesen.

Energieerhaltung

[Bearbeiten]Jedes noch so komplexe System weist unabhängig von seinem genauen Aufbau einige allgemeingültige Eigenschaften auf. So ist in jedem isolierten System die Gesamtenergie konstant. Allerdings sind die meisten natürlichen Systeme nicht isoliert, z.B. tauscht jedes Lebewesen Energie und Stoffe mit seiner Umgebung aus. Auch Sternsysteme sind es streng genommen nie, da die von einer Masse ausgehende Schwerkraft wie bereits erwähnt zwar mit zunehmender Entfernung immer schwächer wird, aber niemals ganz verschwindet.

Ist ein Mehrkörperensemble im Vergleich zum Abstand zu Körpern ähnlicher Masse klein genug, dürfen die von diesen fernen Nachbarn ausgeübten Kräfte meist vernachlässigt werden. Eine solche Entscheidung bedarf allerdings eines gewissen Fingerspitzengefühls. Selbst die nächsten Sterne sind zu weit entfernt, um die Bahnen der Planeten nachweisbar zu beeinflussen. In diesem Sinne ist das Sonnensystem faktisch isoliert. Die in der sogenannten Oortschen Wolke sich aufhaltenden Kometen jedoch sind so weit von der Sonne entfernt, dass nahe Sterne sehr wohl deren Orbits massiv stören können. Auf diese Weise gelangen immer wieder einige von ihnen in das innere Sonnensystem, das sich so doch in Wechselwirkung mit den Sternen seiner Umgebung befindet.

Die abstrahierten Massenpunkte einer Computersimulation dürfen selbstverständlich immer als isoliert betrachtet werden. Die große Schwierigkeit besteht darin, zu entscheiden, ob eine solche Sichtweise den tatsächlichen Gegebenheiten angemessen ist.

Kinetische Energie

[Bearbeiten]Ein allein der Schwerkraft unterworfenes System weist zwei Formen von Energie auf, kinetische Energie und potentielle Energie. Unter der kinetischen Energie (auch Bewegungsenergie genannt) versteht man die Energie, welche man aufwenden muss, um eine Masse vom Ruhezustand aus auf eine bestimmte Geschwindigkeit zu beschleunigen. Sie ist der beschleunigten Masse und dem Quadrat der Endgeschwindigkeit direkt proportional. Um eine doppelt so hohe Geschwindigkeit zu erreichen, muss das vierfache an Energie zur Verfügung stehen. Um die gesamte kinetische Energie eines Mehrkörpersystems zu kennen, müssen die Energien aller einzelnen Massenpunkte aufaddiert werden.

Der Zusammenhang zwischen Bewegungsenergie, Masse und Geschwindigkeit lässt sich leicht aus dem Prinzip Arbeit = Kraft • Weg herleiten, wobei hier wieder nur Beträge betrachtet werden sollen. Man betrachte einen Körper der Masse , welcher aus dem Ruhezustand auf einer Strecke einer konstanten Beschleunigung unterworfen wird. Nach dem Newtonschen Kraftgesetz ist dazu eine Kraft

erforderlich. Das Arbeitsprinzip besagt, dass dazu wiederum eine Energie

aufgewandt werden muss. Setzt man die schon aus dem Abschnitt "mittlere und momentane Beschleunigung" bekannte Beziehung zwischen Geschwindigkeit, Beschleunigung und Wegstrecke ein, so erhält man:

Einschub für Fortgeschrittene: Kinetische Energie bei beliebiger Beschleunigung

Obige Formel lässt sich auch für beliebige Beschleunigungen beweisen. sei nun eine nur für eine beliebig kleine Strecke wirksame Momentanbeschleunigung. Um den Weg zurückzulegen, wird die Arbeit

benötigt. Mit Hilfe der Definitionen und resultiert daraus

und durch Integration aus dem Ruhezustand

Potentielle Energie

[Bearbeiten]Die potentielle Energie gibt die Energie an, die man benötigt, um eine Masse vollständig aus dem Anziehungsbereich einer anderen zu entfernen. Bei dieser Beschreibung wird man sofort wieder mit dem Problem der in Wahrheit nie vorhandenen Isolation von Himmelskörpern konfrontiert. Da die Schwerkraft in ihrer Reichweite nicht beschränkt ist, kann ein Körper strenggenommen niemals der Anziehung eines anderen entkommen. Jedoch ist es möglich, wie die Raumfahrt anschaulich gemacht hat, eine (kleine) Masse auf eine Bahn zu bringen, auf welcher sie sich immer weiter von der (großen) Masse entfernt, von wo aus sie gestartet ist. Die Energie, die man für eine derartige Bahn aufwenden muss, ist den beiden Massen direkt und ihrem ursprünglichen Abstand umgekehrt proportional. Je näher sich die Massen beim Start zueinander befinden, um so mehr Energie ist erforderlich, um die beiden effektiv voneinander zu trennen, bei z.B. halbem Startabstand die doppelte Energie. Dies ist freilich nicht überraschend, da bei kleineren Anfangsabstand eine entsprechend größere Anziehungskraft überwunden werden muss.

Den exakten Wert der potentiellen Energie erhält man, indem man die Anziehungskraft vom Startabstand an gegen die Entfernung aufträgt und die Fläche unter der entsprechenden Kurve berechnet. Man folgt also abermals der Regel Arbeit = Kraft • Weg, wobei aber nun sich die Kraft entlang der zurückgelegten Strecke ständig ändert. Obwohl nie gänzlich verschwindet, hat diese Fläche einen endlichen Inhalt. Man erhält als Ergebnis, was leider aber nicht elementar beweisbar ist:

In einem aus vielen Massenpunkten bestehendem System existiert für jedes Mitglied gegenüber allen anderen potentielle Energie. Um ein solches aus dem Gesamtsystem zu entfernen, müssen die Anziehungskräfte jeweils aller anderen Körper überwunden werden. Um die gesamte potentielle Energie zu bestimmen, muss über alle möglichen Abstandspaare addiert werden. Sie wird als negative Größe angesetzt, da sie ja aufgewandt werden muss, um das Ensemble aufzulösen.

Einschub für Fortgeschrittene: Potentielle Energie im Schwerefeld

Der Beweis für obige Beziehung lässt sich folgendermaßen skizzieren. Nach dem Gravitationsgesetz wirkt auf eine Kraft

Um von um eine kleine Wegstrecke zu entfernen, muss die Arbeit

verrichtet werden. Um gänzlich entkommen zu lassen, wird das Integral über die Arbeit vom ursprünglichen Abstand bis ins Unendliche fortgeführt. Daraus ergibt sich:

Kinetische und potentielle Energie zusammen bilden die konstante Gesamtenergie des Systems, doch besteht zwischen beiden ein ständiges Wechselspiel. Entfernen sich zwei Massenpunkte voneinander, werden sie durch ihre gegenseitige Anziehung abgebremst. Sie verlieren kinetische Energie, gewinnen aber an potentieller Energie. Nähern sie sich, verhält es sich umgekehrt. Die Massen werden auf höhere Geschwindigkeiten beschleunigt, aus potentieller Energie wird kinetische Energie.

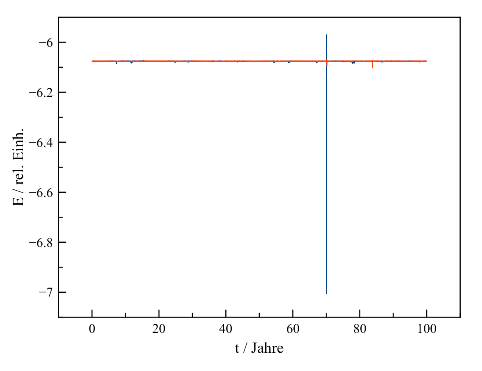

Das Hin und Her zwischen den beiden Energieformen sei hier am Beispiel eines simulierten Doppelsternsystems gezeigt. Beide Komponenten weisen eine Sonnenmasse auf. Die Startpositionen (in Astronomischen Einheiten) der Simulation sind (5 / 0 / 0) und (-5 / 0 / 0), die Anfangsgeschwindigkeiten (in km/s) (0 / 5 / 0) und (0 / -5 / 0).. Während eines Umlaufs variiert der Abstand der beiden Komponenten zwischen 3.9 und 10.0 Astronomischen Einheiten. Im Moment größter Annäherung weisen sie eine Geschwindigkeit von jeweils 12.7 km/s, zum Zeitpunkt maximaler Entfernung eine solche von je 5.0 km/s auf. Die Umlaufdauer beträgt etwa 13.0 Jahre. Man erkennt sehr deutlich den periodischen, zueinander spiegelbildlichen Verlauf von kinetischer und potentieller Energie.

In einem aus vielen einzelnen Massenpunkten bestehenden System ist die Zeitabhängigkeit der Energie selbstverständlich viel komplizierter. Enge Begegnungen zweier Komponenten machen sich durch kurzzeitige Maxima kinetischer Energie entsprechend Minima potentieller Energie bemerkbar. Darüber hinaus unterliegt die Aufteilung der Gesamtenergie aber auch bestimmten langfristigen Trends, welche im praktischen Teil detailliert beschrieben werden.

Ein alltägliches Beispiel für die Umwandlung der einen in die andere Energieform ist das Wasserkraftwerk. Das ins Tal fließende Wasser nimmt an Geschwindigkeit, d.h. an kinetischer Energie zu, welche zum Antrieb einer Turbine genutzt werden kann. Gleichzeitig verliert es potentielle Energie. Um etwa den See eines Pumpspeicherkraftwerks wieder aufzufüllen, muss ja eine andere Energiequelle, z.B. ein Windkraftwerk, angezapft werden.

Elementare Schlussfolgerungen

[Bearbeiten]Betrachtet man die beiden Energieformen für ein System aus 2 Körpern, erwächst aus dem beständigen Hin und Her von kinetischer und potentieller Energie folgende wichtige Regel. Um die beiden Massen für immer voneinander zu entfernen, muss die kinetische Energie des Systems dem Betrage nach mindestens gleich dessen potentieller Energie sein. Überwiegt der Betrag der potentiellen Energie, was einer negativen Gesamtenergie entspricht, bleiben sie einander auf endlichen Bahnen gebunden.

Dies lässt sich anhand einer Kreisbahn mit Radius leicht demonstrieren. Die Bahngeschwindigkeit eines Körpers der Masse , welcher um ein Zentralobjekt der Masse läuft, beträgt wie im letzten Unterkapitel gezeigt und damit seine kinetische Energie . Für die potentielle Energie gilt . Sofern sehr viel größer ist als , kann man davon ausgehen, dass die Zentralmasse sich fast unbeweglich am Schwerpunkt beider Massen aufhält, so dass deren kinetische Energie vernachlässigbar ist. Damit beläuft sich die Gesamtenergie auf:

Die Gesamtenergie eines auf einer Kreisbahn laufenden Körpers ist somit dem Bahnradius umgekehrt proportional. Im Falle einer Ellipsenbahn tritt an die Stelle des Kreisradius die große Halbachse. Bei einer unendlich weiten Bahn ist die Gesamtenergie in der Tat gleich Null

Aus diesem Grenzfall, dass kinetische und potentielle Energie betragsmäßig genau gleich sind, folgt die sogenannte Fluchtgeschwindigkeit . Diese gibt die Mindestgeschwindigkeit an, auf welche die Masse beschleunigt werden muss, um vom Abstand aus die Masse zu verlassen. Das Gleichsetzen der Ausdrücke für die kinetische und potentielle Energie liefert unmittelbar:

Die Fluchtgeschwindigkeit unterschiedet sich von der Bahngeschwindigkeit allein um den Faktor und zeigt somit die gleiche Abhängigkeit von .

Bei Simulationen von Sternsystemen finden sich nach einer gewissen Zeit stets einzelne Massenpunkte, die im Vergleich zu der Mehrzahl der Mitglieder sehr weit vom Schwerpunkt des Ensembles entfernt sind. Für solche Körper können die übrigen Objekte weitgehend als eine im Schwerpunkt ruhende Zentralmasse aufgefasst werden. Zeigen diese Ausreißer eine mit zunehmender Entfernung abfallende Geschwindigkeit kleiner als , so sind sie weiterhin an das Gesamtsystem gebunden. Anderenfalls handelt es sich um Massenpunkte, welche bereits im Begriff sind, das Ensemble zu verlassen.

Der Hinauswurf einzelner Mitglieder aus einem Mehrkörpersystem widerspricht nicht der Energieerhaltung. Die für 2 Massenpunkte geltende Regel, dass ein System mit einem Überschuss an potentieller Energie stabil ist, lässt sich nämlich nicht auf komplexere Ensembles übertragen. Für ein aus 3 oder mehr Körpern bestehendes System garantiert eine negative Gesamtenergie nur eine relative Stabilität. Dort können Massen durch enge Vorübergänge ohne weiteres so stark beschleunigt werden, dass sie dem Gesamtsystem entkommen. Die dazu erforderliche kinetische Energie wird durch eine Verringerung der potentiellen Energie gewonnen. Die zurückgebliebenen Körper rücken im Mittel etwas näher zusammen.

Diese Eigenschaft eines Mehrkörpersystems wird z.B. für die interplanetare Raumfahrt genutzt. Durch nahe Vorübergänge an großen Planeten können Raumsonden erheblich beschleunigt und so die Flugzeiten ins äußere Sonnensystem enorm verkürzt werden.

C-Code: Gesamtenergie im Mehrkörpersystem

Die für die Berechnung der Beschleunigung eines Massenpunktes eingeführten Variablen m, r, dr, i, k und N können auch für die Bestimmung der Energie verwendet werden. Für die kinetische Energie muss die Geschwindigkeit v analog zur Position r als Vektorarray für den Variablentyp Double deklariert werden, die Energie selbst als einfache Double Ekin. Für die potentielle Energie ist das Vektorarray r schon vorhanden, zusätzlich benötigt werden als einfache Double Epot für die Energie selbst und d für den Betrag des Abstandsvektors, ferner als weiterer Zähler die Unsigned Integer j.

Für die Berechnung der Bahnen der Massenpunkte wird die Energie nicht benötigt, wohl aber zur Kontrolle der Stabilität einer Mehrkörpersimulation. Die Bestimmung der Energie erfolgt daher ebenfalls im Rahmen einer regelmäßig aufgerufenen Prozedur. Die Übergabeparameter sind N, m, r und v, die Rückgabevariablen Ekin und Epot. Der Aufruf geschieht durch energie (N,m,r,v,&Ekin,&Epot).

/* Globale Variablen */

unsigned int N;

double *m;

double **r;

double **v;

double Ekin,Epot;

void energie (unsigned int N, double *m, double **r, double **v, double *Ekin, double *Epot)

{

/* Lokale Variablen */

unsigned int i,j,k;

double dr[3];

double d;

/* Berechnung der kinetischen Energie */

*Ekin = 0;

for (i = 0;i < N;i ++)

*Ekin += m[i] * pow (betrag (v[i]),2) / 2;

/* Berechnung der potentiellen Energie */

*Epot = 0;

for (i = 0;i < N;i ++)

{

/* Beitrag pro Abstandspaar zur potentiellen Energie */

for (j = i + 1;j < N;j ++)

{

/* Abstandsvektor zwischen zwei Körpern j und i und dessen Betrag */

for (k = 0;k < 3;k ++)

dr[k] = r[j][k] - r[i][k];

d = betrag (dr);

/* Potentielle Energie pro Abstandspaar */

Epot -= G * m[i] * m[j] / d;

}

}

}

Ruck

[Bearbeiten]Definition

[Bearbeiten]Wie in den ersten Abschnitten dieses Kapitels gezeigt wurde, ist die mittlere Geschwindigkeit definiert als das Verhältnis zurückgelegte Strecke / Zeit , die mittlere Beschleunigung wiederum als das Verhältnis Geschwindigkeitsänderung / Zeit . Die entsprechenden momentanen Größen gewinnt man, indem man das Zeitintervall so klein wie möglich hält. Die sich anschließende Diskussion von Kraft und Energie macht deutlich, dass zum physikalischen Verständnis eines Systems, in welchem allein die Schwerkraft wirkt, diese Größen ausreichen.

Für bestimmte Lösungsverfahren des Mehrkörperproblems - der Gegenstand des nächsten Kapitels - ist es jedoch erforderlich, über Strecke, Geschwindigkeit und Beschleunigung hinaus weitere Größen durch fortgesetzte Betrachtung der zeitlichen Änderung einzuführen. Als dabei Wichtigste ist der mittlere Ruck zu nennen, dessen Symbol j auf seine englische Bezeichnung "jerk" zurückgeht. Er gibt die pro Zeitintervall auftretende Änderung der Beschleunigung an.

Die mathematische Definition entspricht durchaus der Alltagserfahrung. Das Gefühl, bei einer Notbremsung durchgeschüttelt zu werden, ist nicht allein auf die hohen Absolutwerte der dabei auftretenden Beschleunigungen zurückzuführen, sondern auch auf deren abrupte Änderungen. Tritt man heftig auf die Bremse, so erfährt man sofort eine starke der Fahrtrichtung entgegengesetzte Beschleunigung. Kommt das Auto zum Stillstand, verschwindet diese ebenso rasch wieder. Tatsächlich ist die Fahrdynamik eine der wichtigsten Anwendungen des Rucks.

Wie für die Geschwindigkeit und Beschleunigung kann man durch extrem kleine Momentanwerte auch für den Ruck ableiten und mit den Methoden der Differential- und Integralrechnung allgemeine Zusammenhänge zwischen den momentanen Größen , und aufstellen. Für das Verständnis von auf dem Ruck basierenden Lösungsmethoden genügt aber die Betrachtung des mittleren bzw. eines für kleine Zeitintervalle konstanten Rucks , so dass auf eine weitere Diskussion der momentanen Größen verzichtet wird. Wird ein Körper einem konstanten Ruck unterworfen, so ändert sich seine Beschleunigung gemäß obiger Definition linear mit der Zeit.

Ruck und Geschwindigkeit

[Bearbeiten]Für eine auf dem Ruck beruhende Lösung eines Mehrkörperproblems wird selbstverständlich ein Zusammenhang zwischen diesem und der Geschwindigkeit benötigt. Für den Fall eines konstanten Rucks lässt sich ein solcher elementar ableiten, das Vorgehen entspricht völlig der Beziehung zwischen konstanter Beschleunigung und zurückgelegter Strecke.

Wirkt der Ruck aus der Ruhelage heraus, so liegt nach einer Zeit eine zu dieser direkt proportionale Beschleunigung vor. Trägt man die Beschleunigung über die Zeit auf, so erhält man als Fläche unter der Kurve (analog zum Problem der bei konstanter Beschleunigung bewältigten Distanz) ein Dreieck. Somit besteht folgender Zusammenhang (man vergleiche mit für konstante Beschleunigung).

Weist ein Körper schon zu Anfang eine Beschleunigung auf, so gilt wegen des Zusatzbeitrags

Ruck und Strecke

[Bearbeiten]Schließlich muss auch die Beziehung zwischen Ruck und zurückgelegter Strecke betrachtet werden. Selbst für den einfachen Fall eines konstanten Rucks lässt sich diese leider ohne höhere Mathematik nicht angeben. Da die Geschwindigkeit wie soeben gezeigt nun quadratisch von der Zeit abhängt, liegt die gesuchte Strecke im Diagramm gegen jetzt als Fläche unter einer Parabel vor, nicht als Dreieck wie im Fall einer konstanten Beschleunigung. Für einen zu Beginn ruhenden Körper liefert die Integralrechnung folgendes Ergebnis.

Existieren schon zu Anfang eine Beschleunigung und eine Geschwindigkeit , so müssen deren Beiträge und berücksichtigt werden. Damit gilt allgemein

Einschub für Fortgeschrittene: Geschwindigkeit, Beschleunigung und Ruck als Taylor-Entwicklung der Strecke

Gemäß des Taylorschen Satzes lässt sich eine reelle Funktion in der Umgebung einer Stelle als Potenzreihe darstellen, sofern diese dort stetig und beliebig oft differenzierbar ist.

Setzt man sowie und betrachtet die ersten 3 Glieder der Summe, so erhält man

Man erkennt leicht, dass dies dem Zusammenhang zwischen konstantem Ruck und der während einer gewissen Zeit bewältigten Distanz entspricht. Der Vergleich liefert unmittelbar, dass Geschwindigkeit, Beschleunigung und Ruck der 1., 2. und 3. Ableitung der Strecke nach der Zeit entsprechen.

Ruck im Schwerefeld

[Bearbeiten]Im Zusammenhang mit einem astronomischen Mehrkörpersystem interessieren natürlich vor allem die Rucks, den zwei Massen und aufgrund der Schwerkraft aufeinander ausüben. Man findet, was sich wiederum einer elementaren Betrachtung entzieht, dass diese gegenseitigen Rucks im Gegensatz zu den Beschleunigungen nicht nur vom Abstandsvektor , sondern auch der vektoriellen Geschwindigkeitsdifferenz zwischen und abhängen. Im ersten Term erscheint diese allein, im zweiten als Bestandteil des Skalarprodukts mit dem Abstandsvektor.

Einschub für Fortgeschrittene: Zeitableitung der Gravitationsbeschleunigung

Obige Formeln erhält man, in dem man die im Abschnitt "Das Newtonsche Gravitationsgesetz" hergeleiteten wechselseitigen Schwerebeschleunigungen zweier Massen nach der Zeit ableitet. Betrachtet man z.B. die x-Komponente der durch auf ausgeübten Beschleunigung, so liefert die Quotientenregel für die entsprechende Komponente des Rucks

Die Ableitung des Abstandsvektors nach der Zeit liefert unmittelbar die Geschwindigkeitsdifferenz. Weniger offensichtlich ist die Ableitung dessen Betrags. Schreibt man diesen aber ausführlich gemäß des Satzes von Pythagoras hin (), so erkennt man, dass das Skalarprodukt durch zweimaliges Nachdifferenzieren innerhalb der Wurzel entsteht. Denn es gilt:

Elementare Schlussfolgerungen

[Bearbeiten]Auf die schon wiederholt erörterte Kreisbahn soll nun auch der Ruck angewandt werden. Bei unbeweglicher Zentralmasse sind vektorieller Abstand und Geschwindigkeitsdifferenz zwischen und direkt durch die entsprechenden Größen der umlaufenden Masse gegeben. Auf einem kreisförmigen Orbit stehen Orts- und Geschwindigkeitsvektor zudem stets senkrecht aufeinander, so dass das Skalarprodukt der beiden verschwindet. Damit ist der Betrag des auf ausgeübten Rucks einfach durch gegeben. Setzt man noch die Bahngeschwindigkeit ein, so lautet das Endergebnis:

Der Ruck nimmt sehr rasch mit zunehmendem Bahnradius ab - bei doppeltem Radius um einen Faktor (etwa 11.3), bei dreifachem um einen Faktor (ungefähr 46.8) usw.

Die starke Abhängigkeit des Rucks von der Ausdehnung der Bahn lässt sich auch im Alltag nachvollziehen. Bei einer kurvenreichen Fahrt kann nicht nur das häufige Bremsen und Gas geben Schwindelgefühl hervorrufen, sondern auch die heftigen Rucks beim Passieren enger Kurven.

Betrachtet man das Verhältnis von Beschleunigung und Ruck für eine Kreisbahn, so stellt man fest, dass es mit dem Verhältnis von Umlaufgeschwindigkeit und Beschleunigung exakt identisch ist und somit ebenfalls als Maß für die dynamische Zeit dienen kann:

C-Code: Rucks im Mehrkörpersystem

Die Berechnung des in einem Mehrkörpersystem auf einen Massenpunkt ausgeübten Rucks folgt der gleichen Struktur wie diejenige der Beschleunigung. Benötigt werden jetzt aber nicht nur die Positionen r, sondern auch die Geschwindigkeiten v der einzelnen Mitglieder, für welche wie für die Rucks j Zeigerarrays für den Variablentyp Double definiert werden müssen. Zusätzlich zur 3. wird die 5. Potenz d5 des Abstandvektors dr gebraucht, hinzu tritt die vektorielle Geschwindigkeitsdifferenz dv zwischen zwei Körpern. skalar schließlich bezeichnet das aus Abstand und Geschwindigkeitsdifferenz gebildete Skalarprodukt.

Wie die Beschleunigung wird auch der Ruck im Rahmen einer ständig wiederkehrenden Prozedur bestimmt. Zu den bisherigen Übergabeparametern objekt, N, m und r tritt das Vektorarray v hinzu. Da der Ruck nie allein, sondern immer zusammen mit der Beschleunigung betrachtet wird, werden für den aktuell untersuchten Körper beide Größen a[objekt] und j[objekt] zurückgegeben. Der Aufruf der Prozedur geschieht durch ruck(objekt,N,m,r,v,a[objekt],j[objekt]).

/* Globale Variablen */

unsigned int objekt

unsigned int N;

double *m;

double **r;

double **v;

double **a;

double **j;

void ruck (unsigned int objekt, unsigned int N, double *m, double **r, double **v, double *a, double *j)

{

/* Lokale Variablen */

unsigned int i,k;

double dr[3];

double d3,d5;

double dv[3];

double skalar;

/* Initialisierung von Beschleunigung und Ruck */

for (k = 0;k < 3;k ++)

{

a[k] = 0;

j[k] = 0;

}

/* Berechnung von Beschleunigung und Ruck */

for (i = 0;i < N;i ++)

{

if (i != objekt)

{

/* Abstandsvektor und Geschwindigkeitsdifferenz zwischen einem beliebigen Körper i */

/* und dem untersuchten Massenpunkt objekt */

for (k = 0;k < 3;k ++)

{

dr[k] = r[i][k] - r[objekt][k];

dv[k] = v[i][k] - v[objekt][k];

}

/* 3.und 5.Potenz des Betrags des Abstandsvektors */

d3 = pow (betrag (dr),3);

d5 = pow (betrag (dr),5);

/* Skalarprodukt von Abstandsvektor und Geschwindigkeitsdifferenz */

skalar = skalarprodukt (dr,dv);

/* Beitrag der Beschleunigung und des Rucks durch den Körper i */

for (k = 0;k < 3;k ++)

{

a[k] += G * m[i] * dr[k] / d3;

j[k] += G * m[i] * (dv[k] / d3 - 3 * skalar * dr[k] / d5);

}

}

}

}

Allgemeine Lösungsmethoden

[Bearbeiten]Wie im vorausgegangenen Kapitel diskutiert, hängt die Beschleunigung eines jeden Massenpunkts von dessen eigener und den Positionen aller anderen ab, so dass sämtliche Beschleunigungen untereinander gekoppelt sind. Eine exakte Lösung dieses Problems, welche die Positionen und Geschwindigkeiten aller Massenpunkte für jeden beliebigen Zeitpunkt und somit deren genaue Bahnen angibt, ist im Allgemeinen nur für ein aus zwei Körpern bestehendes System möglich. Schon mit drei Massenpunkten ist man von wenigen Spezialfällen abgesehen auf Näherungen angewiesen, die im Kern auf folgenden, bereits von Euler ausgesprochenen Gedanken zurückgehen.

- Euler-Verfahren

- Zwischenschritt-Verfahren: Leapfrog und Runge-Kutta

- Prädiktor-Korrektor-Verfahren: Leapfrog und Hermite-Polynome

- Mehrschrittverfahren

- Tests

Euler-Verfahren

[Bearbeiten]Konstruktion

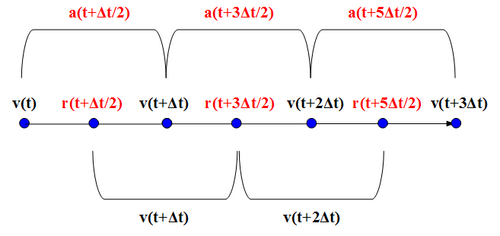

[Bearbeiten]Bereits der Mathematiker Euler entwickelte das Konzept, ein zu komplexes System in diskreten Zeitschritten zu beobachten, anstatt nach einer kontinuierlichen, für beliebige Zeiten geltenden Lösung zu suchen. Sind diese Schritte klein genug, darf man annehmen, dass die Beschleunigungen und Geschwindigkeiten der Massen unterdessen sich kaum ändern und so während des Intervalls näherungsweise als konstant betrachten. Man geht also davon aus, dass die zu einem bestimmten Zeitpunkt gegebenen Momentanbeschleunigungen und -geschwindigkeiten den mittleren Werten für den gesamten Zeitrahmen entsprechen. Die Entwicklung des Systems von einem Zeitpunkt zum nächsten lässt sich dann mit nachfolgendem Schema beschreiben. Mit der neuen Position kennt man auch die neue Beschleunigung und kann so den nächsten Schritt vollziehen.

Obiger Ansatz bedeutet, dass man die wahre Geschwindigkeitskurve durch eine Stufenfunktion annähert und dementsprechend die darunterliegende Fläche (welche wie im letzten Kapitel besprochen die zurückgelegte Strecke darstellt) durch Rechtecke. Die Breite eines solchen Rechtecks ist durch den Zeitschritt gegeben, seine Höhe durch die Geschwindigkeit jeweils zu Beginn eines solchen Schritts. Untenstehende Abbildung lässt bereits erahnen, dass insbesondere bei plötzlichen Änderungen der Geschwindigkeit auf diese Weise die tatsächliche Fläche unter der Kurve nur schlecht ausgefüllt wird, d.h. die entsprechende Vorhersage für die Bahn eines Massenpunktes sehr ungenau ist.

Auf analoge Weise werden unter der Beschleunigungskurve Rechtecke platziert, um die Änderung der Geschwindigkeit während eines Zeitschritts zu ermitteln. Es zeigt sich die gleiche Schwäche wie bei der Betrachtung der zurückgelegten Entfernung.

Genauigkeit

[Bearbeiten]Die unzureichende Genauigkeit des Euler-Verfahrens lässt sich anhand der Kreisbahn leicht demonstrieren. Abermals sei eine sehr kleine Masse betrachtet, welche sich auf einem Kreis mit Radius um eine viel größere Masse bewegt.

Gemäß der Zeichnung soll sich zu Beginn genau rechts von aufhalten. Die Geschwindigkeit der kleinen Masse weist dann exakt nach oben (oder unten). Es ist einleuchtend, dass sich schon nach dem ersten Schritt außerhalb der tatsächlichen Kreisbahn befindet, in einer zu großen Entfernung . Der Fehler ist beträchtlich, wie man z.B. für das System Erde-Sonne zeigen kann. Wählt man als Schrittweite 1 Tag, so liegt der Fehler etwa bei 0.015 %. des tatsächlichen Bahnradius. Da die Fehler der einzelnen Schritte dazu tendieren, sich aufzusummieren (wie im letzten Unterkapitel präsentierte praktische Beispiele zeigen), liegt die gesamte relative Abweichung nach 1 Jahr schon etwa bei 5 %. Es liegt auf der Hand, dass ein solches Ergebnis völlig inakzeptabel ist.

Mit kleineren Zeitschritten lässt sich die Genauigkeit des Verfahrens steigern, doch erwächst aus einem solchen Versuch ein neues Dilemma. Eine detaillierte Betrachtung zeigt nämlich für den Fehler pro Schritt folgenden Zusammenhang:

Der Fehler des Verfahrens hängt nur quadratisch von ab, mit z.B. halb so großen Zeitintervallen lässt sich nur die vierfache Genauigkeit pro Schritt erzielen. Verringert man allgemein um einen Faktor , so weist jeder Einzelschritt eine um verbesserte Genauigkeit auf. Jedoch werden dann auch Mal so viele Schritte benötigt, um die Entwicklung des Systems über eine bestimmte Gesamtzeit zu verfolgen. Die Genauigkeit der Gesamtsimulation wächst so lediglich linear um das -fache. Um etwa die Erdbahn mit einem jährlichen relativen Fehler von 0.1 % statt 5 % wiederzugeben, wäre eine auf 1/50 reduzierte Schrittweite nötig, d.h. von 1/50 Tag ≈ 1/2 Stunde. Ein Fehler von nur ein Millionstel des wirklichen Radius pro Jahr erforderte gar noch 1000 Mal kleinere Schritte von ungefähr 2 Sekunden. Für eine Simulation mit akzeptablen Rechenzeit wächst die Genauigkeit des Euler-Verfahrens viel zu langsam mit kleinerer Schrittweite.

Der prozentuale Fehler hängt nicht nur von selbst, sondern auch dem Abstand der beiden Massen ab. Hierbei gilt:

Er verhält sich dem Kubus von umgekehrt proportional, nimmt also dramatisch zu, wenn zwei Massenpunkte sich sehr nahe kommen. Beträgt ihr Abstand die Hälfte des ursprünglichen Wertes, liegt der Fehler des Verfahrens 8 Mal höher als zu Beginn. Bei einem Drittel der anfänglichen Distanz ist er schon auf das 27-fache des Ausgangswertes angewachsen. Die außerordentlich schnell wachsende Unsicherheit der Lösung im Falle einer engen Begegnung zweier Körper stellt eine grundsätzliche Schwierigkeit dar, welche auch bei genaueren Näherungsverfahren auftritt. Die daraus resultierende Instabilität eines simulierten Sternsystems kommt später noch ausführlich zur Sprache.

Mit Hilfe des 3. Keplerschen Gesetzes lässt sich eine weitere wichtige Aussage über den Fehler des Euler-Verfahrens bei der Kreisbahn gewinnen. Aus der Proportionalität folgt für den relativen Fehler:

Für die Genauigkeit der Simulation ist das Verhältnis zwischen zeitlicher Schrittweite und Umlaufszeit maßgeblich. Dies gilt auch für präzisere Methoden.

Einschub für Fortgeschrittene: Wiedergabe einer Kreisbahn durch das Euler-Verfahren

Die Startposition der kleinen Masse sei:

Für ihre Geschwindigkeit an dieser Stelle gilt:

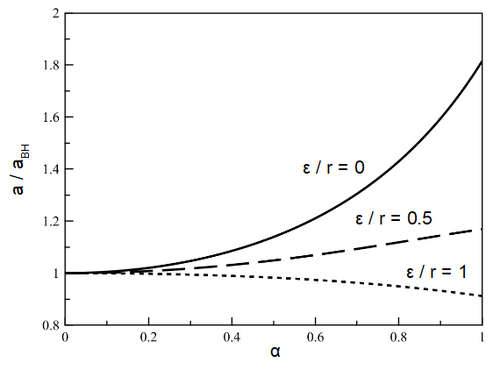

bezeichnet die konstante Winkelgeschwindigkeit, welche man für auf einer Kreisbahn erwartet. Aus der Forderung, dass die Anziehungskraft gleich der Zentripetalkraft sein muss, folgt: