Druckversion des Buches Einführung in die Tensorrechnung

- Dieses Buch umfasst derzeit etwa 61 DIN-A4-Seiten einschließlich Bilder (Stand: 14.08.2007).

- Wenn Sie dieses Buch drucken oder die Druckvorschau Ihres Browsers verwenden, ist diese Notiz nicht sichtbar.

- Zum Drucken klicken Sie in der linken Menüleiste im Abschnitt „Drucken/exportieren“ auf Als PDF herunterladen.

- Mehr Informationen über Druckversionen siehe Hilfe:Fertigstellen/ PDF-Versionen.

- Hinweise:

- Für einen reinen Text-Ausdruck kann man die Bilder-Darstellung im Browser deaktivieren:

- Internet-Explorer: Extras > Internetoptionen > Erweitert > Bilder anzeigen (Häkchen entfernen und mit OK bestätigen)

- Mozilla Firefox: Extras > Einstellungen > Inhalt > Grafiken laden (Häkchen entfernen und mit OK bestätigen)

- Opera: Ansicht > Bilder > Keine Bilder

- Texte, die in Klappboxen stehen, werden nicht immer ausgedruckt (abhängig von der Definition). Auf jeden Fall müssen sie ausgeklappt sein, wenn sie gedruckt werden sollen.

- Die Funktion „Als PDF herunterladen“ kann zu Darstellungsfehlern führen.

|

Gegenstand dieser Abhandlung sind zunächst die Tensoren 2. Stufe (auch Tensoren vom Rang 2 genannt).

(Anmerkung: Skalare sind Tensoren 0. Stufe, Vektoren sind Tensoren 1. Stufe.)

Tensoren 2. Stufe sind mathematische Operatoren, die bei Anwendung auf einen Vektor einen anderen Vektor erzeugen, der bestimmte Eigenschaften hat. (Beispiele folgen später.)

Nach Festlegung (Definition, Vereinbarung) eines Koordinatensystems – künftig kurz Basis oder Basissystem genannt – lässt sich jeder Tensor durch eine »Matrix« beschreiben, d. h. durch eine bestimmte Anzahl von Zahlen in einer bestimmten Anordnung. Für einen Skalar (Tensor 0. Stufe) besteht diese Matrix nur aus dem Skalar selbst. Bei einem (dreidimensionalen) Vektor v (Tensor 1. Stufe) besteht die Matrix aus den drei Komponenten v1, v2, v3, die der Vektor bezüglich der benutzten Basis hat:

Dies ist eine einzeilige Matrix oder kurz: eine Zeilenmatrix. Möglich ist aber auch die Beschreibung des Vektors durch eine einspaltige Matrix (kurz: Spaltenmatrix):

Man beachte, dass diese Matrizen lediglich vereinfachte Beschreibungen des entsprechenden Vektors sind, dass sie aber nicht mit dem Vektor identisch sind. Dies ist wichtig, weil ein und derselbe Vektor in verschiedenen Basen durch ganz verschiedene Matrizen dargestellt wird, während der Tensor selbst von der benutzten Basis unabhängig ist (er ist » invariant gegenüber Basiswechsel «).

Ein Tensor 2. Stufe lässt sich bezüglich einer Basis durch eine Matrix mit drei Zeilen und drei Spalten darstellen, durch eine so genannte 3 x 3 Matrix:

Auch hier gilt: Eine solche Matrix ist nur eine von beliebig vielen Darstellungsformen des Tensors.

Da Tensoren 2. Stufe bei Berechnungen immer zusammen mit einem Vektor auftreten und die Berechnungen immer mit Matrizen ausgeführt werden, sollen zunächst die dafür benötigten Begriffe und Gesetze der Matrizenrechnung erklärt werden.

Grundbegriffe: Matrizen und Matrizendarstellung von Vektoren[Bearbeiten]

Eine Matrix vom Typ (m, n) ist ein rechteckiges Schema von m · n Größen, die in m Zeilen (waagerechten Reihen) und n Spalten (senkrechten Reihen) angeordnet sind. Diese Größen heißen Elemente der Matrix. Das Element aik (auch Aik) der Matrix A steht in der i-ten Zeile und in der k-ten Spalte. Die Elemente können reelle oder komplexe Zahlen sein, aber auch andere mathematische Objekte, wie Vektoren, Polynome, Differentiale und andere.

Eine Matrix A vom Typ (m, n) kann so dargestellt werden:

(1.1)

Dabei kann der Index (m, n) bei A und (aik) auch weggelassen werden, wenn der Typ der Matrix entweder offensichtlich oder unwichtig ist.

Die in der Einleitung vorgestellten Beschreibungen eines Vektors durch eine Matrix setzen die Vereinbarung einer Basis voraus, der die Komponenten des Vektors (also die Elemente der Matrix) zugeordnet sind. Diese Basis besteht bis auf weiteres immer aus drei aufeinander senkrechten Einheitsvektoren e1, e2, e3. (Eine andere gängige Bezeichnung für diese »Basisvektoren« ist i, j, k.)

Die Darstellung eines (physikalischen) Vektors v mit den (skalaren) Komponenten v1, v2, v3 in der Komponentendarstellung zur Basis {e1, e2, e3} = {ei} lautet dann

(1.2)

Eine identische Darstellung dieses Vektors mittels zweier Matrizen (»Matrizendarstellung«) ist dann (unter Benutzung der später erklärten Gesetze der Matrizenmultiplikation) so möglich:

(1.3)

Die Matrizendarstellung eines Vektors ist also das Produkt der Zeilenmatrix seiner Komponenten und der Spaltenmatrix aus den Einheitsvektoren der benutzten Basis.

Zur Beschreibung dieser Basisvektoren kann man nicht auf eine andere Basis zurückgreifen, weil man dann vor der Aufgabe stünde, die Basisvektoren dieser neuen Basis zu beschreiben, was zu einer unendlichen Regression führen würde. Daher muss man die Lage der Basisvektoren bezüglich des jeweiligen Beobachters angeben. Dies kann z. B. durch die Vereinbarung geschehen, dass der Vektor e1 in der Zeichenebene des Beobachters liegt und nach rechts zeigt, der Vektor e2 ebenfalls in der Zeichenebene liegt und nach oben zeigt. Damit ist auch die Lage des Vektors e3 festgelegt, da er mit den ersten beiden Vektoren ein Rechtssystem bilden muss. Wir nehmen im Folgenden immer an, dass eine derartige Vereinbarung getroffen wurde.

Aus dem so genannten Zeilenvektor der Mathematik (in Wahrheit eine »Zeilenmatrix«) wird also erst durch Multiplikation mit der »Spaltenmatrix« mit den Elementen ei (i = 1, 2, 3) ein physikalischer Vektor.

Da die Komponentenmatrix eines Vektors nur für eine bestimmte Basis gilt, wird im Folgenden diese Basis immer als definiert vorausgesetzt.

Wir vereinbaren nun:

1. Die künftig als »Vektoren« bezeichneten Größen sind stets physikalische Vektoren, also gerichtete physikalische Größen.

2. Die Matrix der Komponenten eines Vektors v wird stets als Spaltenmatrix geschrieben und mit (v) = (vi) bezeichnet.

3. Wenn aus zwingenden Gründen (z. B. bei der Multiplikation von Matrizen) die Komponentenmatrix eines Vektors als Zeilenmatrix geschrieben werden muss, benutzen wir dafür die Bezeichnung

(v)T = (vi)T.

(v)T = (vi)T heißt die transponierte Matrix der ursprünglichen Matrix (v) = (vi).

Aus

folgt also

folgt also  und umgekehrt.

und umgekehrt.

Damit folgt aus Gleichung 1.3:

(1.4)

Beachte: Der Vektor v bleibt unbeeinflusst davon, ob er als Zeilenmatrix oder als Spaltenmatrix dargestellt wird, aber natürlich sind die beiden Matrizen nicht gleich: Nach der Definition der Gleichheit (siehe unten) können nur Matrizen vom selben Typ (m, n) gleich sein. Es ist nützlich, stets deutlich zwischen einem Vektor und seiner Matrix (seiner Matrizendarstellung) zu unterscheiden: Eine Matrix ist kein Vektor, und ein Vektor ist keine Matrix. Ein Vektor ist unabhängig vom benutzten Koordinatensystem (Basis); seine Matrix ist nur eine von mehreren Darstellungsformen des Vektors, und sie ist (genauer: ihre Elemente sind) von der benutzten Basis abhängig.

Gleichheit zweier Matrizen: Zwei Matrizen sind gleich, wenn sie vom selben Typ (m, n) sind und alle einander entsprechenden Elemente der Matrizen gleich sind:

Summe (Differenz) zweier Matrizen: Voraussetzung: Beide Matrizen müssen vom gleichen Typ (m, n) sein. Einander entsprechende Elemente der beiden Matrizen werden addiert bzw. subtrahiert.

Multiplikation einer Matrix A mit einem Skalar: Alle Elemente der Matrix werden mit dem Skalar k multipliziert.

Transponierte Matrix: Die transponierte Matrix AT entsteht durch Vertauschung der Zeilen und Spalten.

Daraus folgt:

Insbesondere ist

und

Eine quadratische Matrix hat ebenso viele Zeilen wie Spalten: m = n.

Eine quadratische Matrix A heißt symmetrisch, wenn AT = A ist. Dann ist

Eine quadratische Matrix heißt schiefsymmetrisch oder antisymmetrisch, wenn AT = - A ist. Dann ist

Daraus folgt, dass alle Elemente aii auf der »Hauptdiagonalen« der Matrix (das ist die von links oben nach rechts unten verlaufende Diagonale) gleich null sind.

Produkte zweier Matrizen und Vektor-Matrix-Produkte[Bearbeiten]

Die Multiplikation zweier Matrizen A und B setzt voraus, dass die Anzahl der Spalten von A gleich der Anzahl der Zeilen von B ist. (Diese »Verkettbarkeitsbedingung« ergibt sich aus der folgenden Vorschrift zur Berechnung der Produktmatrix.) Das Produkt AB zweier Matrizen ist wieder eine Matrix.

Rechenvorschrift: Das Element cik ist das Skalarprodukt der i-ten Zeile von A mit der k-ten Spalte von B. (Über Skalarprodukte zweier Vektoren siehe unten.) Bei der Berechnung des Skalarprodukts werden die Zeilen und Spalten wie (physikalische) Vektoren behandelt, das heißt, die Elemente der Zeilen und Spalten denke man sich zunächst mit den entsprechenden Einheitsvektoren multipliziert, dann wird die eigentliche Multiplikation vorgenommen. Dabei gelten die einschlägigen Gesetze der Vektoralgebra:

e1·e1 = e2·e2 = e3·e3 = 1,

e1·e2 = e2·e3 = e3·e1 = 0.

Wir begnügen uns hier mit dem Beispiel zweier 3x3-Matrizen: Es seien

Dann ist

wobei

Also ist für zwei 3x3-Matrizen

(1.5)

Spezialfälle: Produkte zweier einreihiger Matrizen

Mit Rücksicht auf die Verkettbarkeit gibt es genau zwei Möglichkeiten:

(1.6)

Das Produkt ist eine 3 x 3-Matrix. Sie begegnet uns wieder beim dyadischen Produkt zweier Vektoren.

(1.7)

Das Ergebnis ist die Summe dreier reeller Zahlen, also ebenfalls eine reelle Zahl, die man auch als 1x1-Matrix interpretieren kann.

Dieser Fall begegnet uns wieder beim Skalarprodukt zweier Vektoren.

Produkte einer einreihigen Matrix (sowie eines Vektors) mit einer 3x3-Matrix

Je nach der Stellung der einreihigen Matrix B (bzw. des Vektors) zur 3x3-Matrix A sind zwei Fälle zu unterscheiden, das »Vorprodukt« und das »Nachprodukt«.

1. Das Vorprodukt

Das Vorprodukt BA kann wegen der Verkettbarkeitsbedingung nur gebildet werden, wenn B eine Zeilenmatrix ist. Daher vereinbaren wir:

(1.8)

Nach den Regeln der Matrizenmultiplikation ist das Ergebnis ebenfalls eine Zeilenmatrix:

(1.9)

Nun können wir eine neue Rechenoperation für Vektoren definieren, nämlich das Vorprodukt der Matrix eines Vektors mit einer 3 x 3 Matrix, indem wir in den Gleichungen 1.8 und 1.9 die Matrix B durch die Matrix (v) eines Vektor v ersetzen. Dabei müssen wir wegen der Verkettbarkeitsbedingung die transponierte Matrix (v)T benutzen. Dann gilt für das Vorprodukt (v)T A

(1.10)

Analog zu Gleichungen 1.8 und 1.9 ist

(1.11)

Wir vereinbaren nun, dass die Matrix auf der rechten Seite der Gleichung 1.11 als die transponierte Matrix (w)T eines Vektors w interpretiert werden soll:

Für den Vektor w selbst gilt nach Gleichung 1.4:

![{\displaystyle {\boldsymbol {w}}=\left({\boldsymbol {w}}\right)^{\mathsf {T}}{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}=\left[\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {A}}\right]{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a62c6b03410e8bf51bc9f241b9a5ae22ec7322b8)

Also Folge dieser Vereinbarung gilt künftig:

Das Vorprodukt ( v )T A aus der transponierten Matrix eines Vektors v und einer 3 x 3 Matrix A ist die transponierte Matrix ( w )T eines Vektors w mit folgender Eigenschaft:

(1.12)

![{\displaystyle {\boldsymbol {w}}=\left({\boldsymbol {w}}\right)^{\mathsf {T}}{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}=\left[\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {A}}\right]{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a62c6b03410e8bf51bc9f241b9a5ae22ec7322b8)

oder

(1.13)

Anmerkung: Die eckigen Klammern dienen hier und im Folgenden dazu, die Reihenfolge der Multiplikationen zu verdeutlichen. (Runde Klammern werden zur Kennzeichnung von Matrizen benutzt.)

Übung 1.1

Beweisen Sie, dass (v)T E = (v)T, wobei

die 3 x 3 Einheitsmatrix und v ein Vektor ist.

Übung 1.2

Beweisen Sie das Distributivgesetz für das Vorprodukt:

![{\displaystyle \left({\boldsymbol {v}}\right)^{\mathsf {T}}\left[{\boldsymbol {A}}+{\boldsymbol {B}}\right]=\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {A}}+\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {B}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b508ac774bf9a461e4a48cb7f414d803c8f20a2a)

wobei A und B 3 x 3-Matrizen sind und v ein Vektor ist.

Übung 1.3

Beweisen Sie:

![{\displaystyle \left({\boldsymbol {v}}\right)^{\mathsf {T}}\left[{\boldsymbol {E}}+{\boldsymbol {A}}\right]=\left({\boldsymbol {v}}\right)^{\mathsf {T}}+\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {A}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/79e92cb73821b9b8150ef0f340a676ce682d63e8)

2. Das Nachprodukt

Hier muss wegen der Verkettbarkeitsbedingung die Matrix B als Spaltenmatrix geschrieben werden:

(1.14)

Das Ergebnis ist nach den Regeln der Matrizenmultiplikation eine Spaltenmatrix:

(1.15)

Nun können wir auch das Nachprodukt der Matrix eines Vektors mit einer 3 x 3 Matrix definieren, indem wir in Gleichung 1.14 die Matrix B durch die Matrix eines Vektors v ersetzen und vereinbaren, dass die Spaltenmatrix auf der rechten Seite der Gleichung 1.16 die Matrix (w) eines Vektors w sein soll.

(1.16)

Für den Vektor w gilt daher

(1.17)

Übung 1.4

Beweisen Sie: E(v) = (v), wobei E die 3 x 3 Einheitsmatrix und v ein Vektor ist

Übung 1.5

Beweisen Sie das Distributivgesetz für das Nachprodukt:

![{\displaystyle \left[{\boldsymbol {A}}+{\boldsymbol {B}}\right]\left({\boldsymbol {v}}\right)={\boldsymbol {A}}\left({\boldsymbol {v}}\right)+{\boldsymbol {B}}\left({\boldsymbol {v}}\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3df46eaf634007baff4a0970f03eb10e3c43952b)

wobei A und B 3 x 3 Matrizen sind und v ein Vektor ist.

Übung 1.6

Beweisen Sie:

![{\displaystyle \left[{{\boldsymbol {E}}+{\boldsymbol {A}}}\right]\left({\boldsymbol {v}}\right)=\left({\boldsymbol {v}}\right)+{\boldsymbol {A}}\left({\boldsymbol {v}}\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/04829d76be8a8be35757f30214d2e8049dd3fde7)

wobei v ein Vektor, A eine 3 x 3 Matrix und E die 3 x 3-Einheitsmatrix ist.

Produkte von Vektoren[Bearbeiten]

Es gibt drei Arten von Produkten von je zwei Vektoren:

Das Vektorprodukt wird hier nicht benötigt.

1. Das Skalarprodukt

In der Vektoralgebra wird das Skalarprodukt v·w zweier Vektoren im Hinblick auf physikalische Belange basisunabhängig so definiert:

(1.19)

wobei v und w die Beträge der beiden Vektoren sind und φ der von ihnen eingeschlossene Winkel ist.

Beschreibt man die Vektoren durch ihre Komponenten bezüglich einer kartesischen Basis {e1, e2, e3}, dann erhält man für ihr Skalarprodukt formal die Gleichung

(1.20)

In der Vektoralgebra wird gezeigt, dass Skalarprodukte distributiv sind und man daher die Klammern nach den Regeln der Algebra ausmultiplizieren darf. Berücksichtigt man

dabei, dass

ist (was sich aus der Definitionsgleichung (1.19) für φ = 90° bzw. 0° ergibt), so erhält man

(1.21)

Die rechte Seite der Gleichung (1.21) ist identisch mit dem Produkt der Zeilenmatrix (vi)T und der Spaltenmatrix (wi):

(1.22)

sodass also gilt

(1.23)

2. Das dyadische Produkt

Das dyadische Produkt zweier Vektoren v und w (kurz auch: Dyade) wird geschrieben

und gelesen: v mal im Kreis w.

Ebenso wie die beiden Vektoren ist auch ihr dyadisches Produkt vom benutzten Basissystem unabhängig. Bei der Definition des dyadischen Produkts wird die Komponentendarstellung der Vektoren bezüglich einer bestimmten Basis benutzt, und daher ist auch das Ergebnis zunächst eine basisabhängige Größe, und zwar eine Matrix. (Leider gibt es – anders als bei den vektoralgebraischen Definitionen des Skalar- und des Vektorprodukts - keine anschauliche und basisunabhängige Definition des dyadischen Produkts, die nur auf den Eigenschaften der beiden Vektoren basiert.)

Definition: Haben v und w in einem bestimmten Basissystem die Komponenten (v1, v2,v3) und (w1, w2,w3), ist also

dann ist das dyadische Produkt  der beiden Vektoren im benutzten Basissystem

der beiden Vektoren im benutzten Basissystem

(1.24)

Durch Ausmultiplizieren erhält man nach Gleichung (1.6)

(1.25)

Diese 3 x 3 Matrix stellt – wie noch gezeigt werden wird – einen Tensor vom Rang 2 dar.

Übungen:

1.7 Welche Beziehungen müssen zwischen den Elementen einer 3 x 3 Matrix bestehen, damit diese ein dyadisches Produkt darstellen kann? Hinweis: Man setze aik = uivk und untersuche die Konsequenzen.

1.8 Können aus den Elementen einer Tensormatrix eindeutig die Vektoren u und v bestimmt werden, deren dyadisches Produkt der Tensor ist? Wenn nein, warum nicht, und wie viel Vektorkomponenten können willkürlich gewählt werden?

1.9 Welche Beziehung besteht zwischen den auf der Hauptdiagonalen der Tensormatrix stehenden so genannten »Tensorkomponenten 1. Art« u1 v1, u2 v2, u3 v3 einerseits und dem Skalarprodukt u · v andererseits?

1.10 Welche Beziehungen bestehen zwischen den übrigen 6 Tensorkomponenten (sie heißen »Tensorkomponenten 2. Art«) und den Komponenten des Vektorprodukts u x v?

Rechengesetze für Dyaden[Bearbeiten]

Die einschlägigen Rechengesetze für 3x3-Matrizen lassen sich unmittelbar auf Dyaden übertragen.

1. Multiplikation einer Dyade mit einem Skalar

Matrizen werden mit einem Skalar multipliziert, indem alle ihre Elemente vi wk mit diesem Skalar multipliziert werden. Dabei ist die Reihenfolge der Faktoren beliebig. Also ist

(1.26)

![{\displaystyle k\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]=\left[{k{\boldsymbol {v}}}\right]\otimes {\boldsymbol {w}}={\boldsymbol {v}}\otimes \left[{k{\boldsymbol {w}}}\right]=\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]k\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d417fe19ba3a1742b45c53cee65c1496b26db99e)

Anmerkung: Die eckigen Klammern dienen hier und im Folgenden dazu, die Reihenfolge der Multiplikationen festzulegen.

2. Produkte eines Vektors mit einer Dyade

Auch hier müssen wir zwischen Vorprodukt und Nachprodukt unterscheiden.

2.1. Das Vorprodukt

Unter dem Vorprodukt des Vektors u mit der Dyade  verstehen wir das Produkt

verstehen wir das Produkt

![{\displaystyle {\boldsymbol {u}}\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5e62357c697481b2db4f453404b0b2d1b30e9ffb)

Wir gehen aus von Gleichung (1.10) und ersetzen darin v durch u und A durch die Dyade. In der Komponentendarstellung ist dann (vi) durch (ui) und (aik durch (viwk) zu ersetzen.

Die Matrizendarstellung des Vorprodukts ist dann

(1.27)

![{\displaystyle {\boldsymbol {u}}\left[{\boldsymbol {v}}\otimes {\boldsymbol {w}}\right]=\left({u_{i}}\right)^{T}\left[{\boldsymbol {v}}\otimes {\boldsymbol {w}}\right]={\begin{pmatrix}{u_{1}}&{u_{2}}&{u_{3}}\end{pmatrix}}{\begin{pmatrix}{v_{1}w_{1}}&{v_{1}w_{2}}&{v_{1}w_{3}}\\{v_{2}w_{1}}&{v_{2}w_{2}}&{v_{2}w_{3}}\\{v_{3}w_{1}}&{v_{3}w_{2}}&{v_{3}w_{3}}\end{pmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/10f55ca54c63ecef91f720ef2fd3336cccd1514b)

Das Ergebnis ist analog zu Gleichung (1.10) ein Vektor t (statt w), für den gilt:

(1.28)

Dafür kann man mit Hilfe von Skalarprodukten schreiben

(1.29)

![{\displaystyle {\boldsymbol {t}}=\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]w_{1}{\boldsymbol {e}}_{1}+\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]w_{2}{\boldsymbol {e}}_{2}+\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]w_{3}{\boldsymbol {e}}_{3}=\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]{\begin{pmatrix}{w_{1}}&{w_{2}}&{w_{3}}\end{pmatrix}}{\begin{pmatrix}{\boldsymbol {e}}_{1}\\{\boldsymbol {e}}_{2}\\{\boldsymbol {e}}_{3}\end{pmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ee26b1dfa3f058760b164db64a643f0ef26e811a)

und schließlich

![{\displaystyle {\boldsymbol {t}}=\left[{{\boldsymbol {u}}\cdot {\boldsymbol {v}}}\right]{\boldsymbol {w}}=k\,{\boldsymbol {w}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1922baf9caa2eea54aa6965855412b18fbdc6921)

da das Skalarprodukt u·v eine reelle Zahl k ist.

Also ist

(1.30)

![{\displaystyle {\boldsymbol {u}}\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]=k\,{\boldsymbol {w}}\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1bf6d1d118471a48435fa1a9187bfb849c3c7d2d)

Das Vorprodukt eines Vektors und einer Dyade ist also ein Vektor vom k-fachen Betrag des zweiten Vektors der Dyade, wobei k gleich dem Skalarprodukt aus dem »Vorvektor« und dem ersten Vektor der Dyade ist.

2.2 Das Nachprodukt

Unter dem Nachprodukt eines Vektors mit einer Dyade verstehen wir das Produkt

![{\displaystyle \left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]{\boldsymbol {u}}\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d35c57d8320c980b19f535a8d7a70079893218ec)

Die Matrizendarstellung dieses Produkts ist

(1.31)

![{\displaystyle \left[{\boldsymbol {v}}\otimes {\boldsymbol {w}}\right]{\boldsymbol {u}}={\begin{pmatrix}{v_{1}w_{1}}&{v_{1}w_{2}}&{v_{1}w_{3}}\\{v_{2}w_{1}}&{v_{2}w_{2}}&{v_{2}w_{3}}\\{v_{3}w_{1}}&{v_{3}w_{2}}&{v_{3}w_{3}}\end{pmatrix}}{\begin{pmatrix}{u_{1}}\\{u_{2}}\\{u_{3}}\end{pmatrix}}={\begin{pmatrix}{v_{1}w_{1}u_{1}+v_{1}w_{2}u_{2}+v_{1}w_{3}u_{3}}\\{v_{2}w_{1}u_{1}+v_{2}w_{2}u_{2}+v_{2}w_{3}u_{3}}\\{v_{3}w_{1}u_{1}+v_{3}w_{2}u_{2}+v_{3}w_{3}u_{3}}\end{pmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/11593d8157cace79896c422d091e5385ec3bf2d3)

Das Ergebnis ist analog zu Gleichung (1.18) ein Vektor t, für den gilt

(1.32)

und nach Ausklammern von vi

(1.33)

![{\displaystyle {\boldsymbol {t}}=\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]v_{1}{\boldsymbol {e}}_{1}+\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]v_{2}{\boldsymbol {e}}_{2}+\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]v_{3}{\boldsymbol {e}}_{3}=\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]{\begin{pmatrix}{v_{1}}&{v_{2}}&{v_{3}}\end{pmatrix}}{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6469b3e4c8f6cc2bff9a88ec8f423ea291c05f07)

und schließlich

(1.34)

![{\displaystyle {\boldsymbol {t}}=\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]{\boldsymbol {v}}=k{\boldsymbol {v}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3f67717b64a409d10b72206bd8a37c62e38fef49)

Also ist

(1.35)

![{\displaystyle \left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]{\boldsymbol {u}}=k{\boldsymbol {v}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bad248dd45c0eef669426829426e45c9e78de523)

Das Nachprodukt ist also ein Vektor vom k-fachen Betrag des ersten Vektors der Dyade, wobei k das Skalarprodukt des zweiten Vektors der Dyade und des »Nachvektors« ist.

Tensoren vom Rang 2 (Tensoren 2. Stufe)[Bearbeiten]

Das Nachprodukt einer Dyade mit einem Vektor u hat eine Anzahl besonderer Eigenschaften, von denen hier zunächst vier genannt werden sollen. Vorab führen wir für die Dyade folgende Abkürzung ein:

(2.1)

1. Das Produkt Tu ist das k-fache des Vektors v:

(2.2)

![{\displaystyle \left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]{\boldsymbol {u}}=k\,{\boldsymbol {v}}\quad \quad {\text{oder}}\quad \quad {\boldsymbol {T}}{\boldsymbol {u}}=k{\boldsymbol {v}}\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b312ba09797839ec9958a814579f935c64ae9acd)

2. Das Produkt Tu ist nach Gleichung (1.32) ein Vektor t mit den Komponenten

(2.3)

Ersetzt man den Vektor u durch die Summe r + s zweier Vektoren r und s, so wird

Analoges gilt für t2 und t3. Daraus folgt

(2.4)

3. Genauso lässt sich zeigen, dass

(2.5)

4. In Gleichung (1.35) sind u und v Vektoren, die als solche von der benutzten Basis (Koordinatensystem) unabhängig sind. (Sie sind invariant gegenüber Basiswechsel.) Das bedeutet, dass unabhängig von der benutzten Basis aus dem Vektor u durch Multiplikation mit der Dyade T immer derselbe Vektor k v entsteht. Daher bezeichnet man auch T als invariant gegenüber Basiswechsel oder als unabhängig von der benutzten Basis.

Ein mathematischer Operator mit diesen Eigenschaften heißt »Tensor vom Rang 2«.

Also sind Dyaden Tensoren vom Rang 2. Da wir es künftig nur mit Tensoren vom Rang 2 zu tun haben werden, lassen wir den Zusatz fort.

Andererseits muss ein Tensor nicht notwendig eine Dyade sein. Da in der Matrizendarstellung einer Dyade ausschließlich Produkte von je zwei Vektorkomponenten auftreten, genügt es, wenn bei Basiswechsel die Komponenten des Tensors genau so transformiert werden wie diese Produkte. Unter dieser Bedingung bleiben nämlich alle oben abgeleiteten Eigenschaften erhalten. (Lediglich ist in Gleichung (2.2) der Vektor v im Ergebnis nicht zu identifizieren.) Durch diese Verallgemeinerung des Tensorbegriffs ist es möglich, später weitere wichtige Tensoreigenschaften nachzuweisen.

Es ist hier nützlich, sich daran zu erinnern, dass auch in der Vektoranalysis solche Produkte auftreten: grad U, div v, rot v, wobei grad, div und rot als Faktoren aufgefasst werden, die aus bestimmten Differentialoperatoren stehen, mit denen ein Skalar U oder ein Vektor v nach den Regeln der Algebra multipliziert werden. Auch diese Operatoren und ihre Produkte sind von der benutzten Basis unabhängig.

Beispiele:

1. Der Vektor grad U ist als solcher von der Basis unabhängig. Er gibt für jeden Punkt eines Skalarfeldes Richtung und Größenwert des steilsten Anstiegs der Feldfunktion U an. In einem bestimmten Punkt P hat der Vektor grad U eine bestimmte Länge und eine bestimmte Richtung; beide werden durch einen Wechsel der Basis nicht beeinflusst, wenn auch die Komponenten des Vektors sich dabei verändern.

2. Der Skalar div v gibt für jeden Punktes eines Vektorfeldes die so genannte Quelldichte des Feldvektors an. Auch diese Größe bleibt beim Wechsel des Koordinatensystems unverändert.

Genau so ist der Tensor T ein Faktor, der mit einem beliebigen Vektor v multipliziert werden kann (und multipliziert werden muss, damit man ein definiertes Ergebnis – einen Vektor – erhält). Was der Tensor T für sich allein genommen bedeutet, wissen wir (zunächst) noch nicht, jedoch kann diese Bedeutung erschlossen werden.

Übung 2.1:

Welche der Differentialoperatoren grad, div, rot, Laplace-Operator Δ und Hamiltonscher Differentialoperator (Nablaoperator) sind nach diesen Kriterien ein Tensor oder können ein Tensor sein? Begründen Sie Ihre Entscheidung.

Zeigen Sie, dass die Ergebnisse der jeweiligen Operation invariant gegen Basiswechsel (Koordinatentransformation) sind.

Wir definieren noch den Nulltensor 0 durch die Eigenschaft Ov = o (Nullvektor) und den Identitätstensor I durch die Eigenschaft Iv = v.

Schließlich definieren wir: Zwei Tensoren T und U sind genau dann gleich, wenn gilt Tv = w und zugleich Uv = w (kurz: Tv = Uv).

Darstellung eines Tensors vom Rang 2 in einem Koordinatensystem[Bearbeiten]

Gegeben sei eine kartesische Basis mit den Basisvektoren e1, e2, e3.

Es soll nun untersucht werden, wie sich ein Tensor T in dieser Basis darstellen lässt. (Die Analogie dazu ist die bekannte Darstellung eines Vektors durch seine skalaren Komponenten bezüglich einer Basis.)

Wir gehen dabei von der Gleichung (2.1) aus:

Dann stellen wir die Vektoren v und w in der Basis dar:

Damit wird aus Tv der Vektor w:

Nach Gleichung (2.2) ist

und nach Gleichung (2.3)

(2.4)

Nun sind die T ei auf der linken Seite nach Gleichung (2.1) Vektoren ti, die sich ebenfalls in der benutzten Basis darstellen lassen.

Bezeichnen wir ihre skalaren Komponenten in der Basis mit tik (i, k = 1, 2, 3), dann ist

(2.5)

Die neun skalaren Komponenten dieser drei Gleichungen lassen sich in einer Matrix MT anordnen, die eine besondere Bedeutung hat (siehe unten):

(2.6)

Mit den Gleichungen (2.5) lässt sich Gleichung (2.4) wie folgt schreiben:

Durch Ausmultiplizieren, Umordnen und Ausklammern von ei auf der linken Seite erhält man

Durch Vergleich der Koeffizienten gleicher Basisvektoren links und rechts ergibt sich

Diese drei Gleichungen lassen sich mit zwei Matrizen als eine einzige Gleichung schreiben:

Die linke Seite kann man als (Nach-)Produkt der Matrix

mit der Matrix

schreiben (siehe dazu die Gleichungen (1.13) und (1.14)):

Der T im benutzten Basissystem (!) durch die obige Matrix dargestellt werden kann:

Diese »Äquivalenz« soll bedeuten, dass in der Gleichung Tv = w der Operator T durch die Matrix (tik) ersetzt werden kann. Der Tensor ist jedoch nicht gleich der Matrix. Vielmehr ist die Matrix eine (von vielen) basisabhängigen Darstellungsformen des Tensors.

Bezeichnen wir wie bei den Vektoren mit (T) die Matrix des Tensors im jeweils benutzten Basissystem, dann ist

Die Elemente der Matrix heißen dann »Komponenten der Tensormatrix« oder kurz »Komponenten des Tensors«.

Die Matrix (T) des Tensors ist gleich der transponierten Matrix aus Gleichung (2.6):

Also: Ein Tensor vom Rang 2 kann stets durch eine 3x3-Matrix dargestellt werden.

Analog zu einem Vektor hängen die Komponenten des Tensors in dieser Darstellung von der benutzten Basis ab, obwohl der Tensor selbst invariant ist gegenüber Basiswechsel. Anders als bei der Komponentendarstellung eines Vektors treten aber die Basisvektoren selbst nicht auf. Sie haben jedoch implizit Einfluss auf die Matrix MT und damit auch auf die Komponenten-Matrix (T) des Tensors T. Wechselt man die Basis, auf die die Tensormatrix bezogen ist, so ändern sich – siehe Gleichung (2.5) – auch ihre Komponenten. Die Forderung, dass ein Tensor invariant gegen Basiswechel sein soll, bedeutet zunächst Folgendes: Beim Wechsel der Basis müssen seine Komponenten nach einem allgemein gültigen Gesetz so transformiert werden können, dass der Tensor mit den transformierten Komponenten im neuen Koordinatensystem einen Vektor v auf denselben Vektor w abbildet, wie es der Tensor mit den ursprünglichen Komponenten in der ursprünglichen Basis getan hat. Das bedeutet: Wenn die transformierte Matrix des Tensors in der neuen Basis gleich

ist, dann muss

sein, wobei

die Matrizen der Vektorkomponenten von v und w in der neuen Basis sind.

Diese Aufgabe wird uns später noch beschäftigen.

Beispiele und Übungen[Bearbeiten]

Beispiel 2.1: Die Projektion eines Vektors auf einen anderen Vektor als Tensoroperation

Ein Vektor v soll senkrecht auf einen anderen Vektor u projiziert werden.

Gesucht ist der Operator P, der dieses leistet. Damit meinen wir einen Operator, der – auf den Vektor v angewendet - dessen Projektion w auf u ergibt. Es sei also

wobei e der auf u liegende Einheitsvektor ist. Dann liefert nämlich das Skalarprodukt v·e die Länge (Betrag) des projizierten Vektors und der Faktor e dessen Richtung.

Der zu u gehörige Einheitsvektor ist

Damit wird

(2.7)

Da v und u basisunabhängige Vektoren sind, ist auch P basisunabhängig.

Ferner gilt:

1. Das Produkt Pv stellt offensichtlich einen Vektor k u dar, wobei

2. Es ist P(r + s) = Pr + Ps, wie man graphisch leicht zeigen kann, indem man v in zwei beliebige Summanden r und s zerlegt,

3. Es ist die Länge der Projektion des Vektors v proportional zur Länge von v.

Daraus folgt: Der Operator P ist ein Tensor.

Um die Matrix des Tensors P bezüglich der Basis {e1, e2, e3} zu ermitteln, drücken wir das Skalarprodukt v·u und den Vektor u durch ihre Komponenten aus:

(2.8)

Nach den Gleichung (1.16) und (1.15) stellt die rechte Seite einen Vektor w dar mit der Komponentenmatrix

Nach Gleichung (1.14) ist dieser Vektor gleich dem Produkt

Andererseits ist dieser Ausdruck nach Gleichung (2.8) gleich Pv und somit ist

woraus folgt

Beispiel 2.2: Spiegelung eines Vektors an einer Ebene als Tensoroperation

Der Einheitsvektor der Flächennormalen der Ebene sei e.

Dann ist

Begründung: Vom Vektor v muss zweimal seine Projektion (v · e)e auf den Einheitsvektor e subtrahiert werden, um w zu erhalten.

Übung 2.2 Beweisen Sie, dass der Operator S aus Beispiel 2.2 ein Tensor ist.

Übung 2.3 Berechnen Sie unter Verwendung des Ergebnisses aus Beispiel 2.1 die Komponentendarstellung des Tensors S aus Übung 2.2.

Wie lautet das Ergebnis, wenn der Vektor e mit dem Basisvektor e1 zusammenfällt?

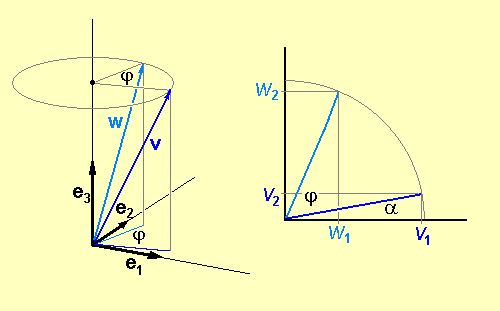

Beispiel 2.3: Die Drehung eines Vektors als Tensoroperation

Ein Vektor v soll bezüglich einer definierten Achse um den Winkel φ gedreht werden. So entstehe der Vektor w. Es soll nun untersucht werden, ob sich der Vektor w als Tensoroperation

darstellen lässt. Wir betrachten den vereinfachten Fall, in dem die Drehachse mit einem der Basisvektoren (hier: e3) zusammenfällt. (Im allgemeinen Fall kann man eine Koordinatentransformation durchführen, um diesen Fall zu verwirklichen.) Bei diesem Beispiel ist es zweckmäßig, gleich mit der Komponentendarstellung der Vektoren zu arbeiten.

Der rechte Teil der Abbildung zeigt die Projektionen der Vektoren v und w in die Grundrissebene.

Es ist nun

oder

und daher gilt für die Matrix des Vektors w:

Wie oben (Beispiel 2.1) gezeigt wurde, ist dann der Vektor w:

und daher

Auch D erfüllt alle Kriterien eines Tensors. Wie man erkennt, ist hier sogar die Matrix des Tensors basisunabhängig.

Beispiel 2.4: Das Vektorprodukt als Tensoroperation

Das Vektorprodukt u x v ist ein Vektor w vom Betrag u v sin φ , der auf u und v senkrecht steht und so orientiert ist, dass u, v, w in dieser Reihe ein Rechtssystem bilden. Dabei ist φ der Winkel zwischen den beiden Vektoren.

Wir wollen untersuchen, ob die Bildung des Vektorprodukts als Tensoroperation am Vektor v aufgefasst werden kann, wenn man u als konstant (oder als Parameter) betrachtet.

Nennen wir den Operator, der dieses leisten soll, Su ≡ (u x ), so ist

(2.9)

Für das Vektorprodukt u x v gilt die Koordinatendarstellung

und für seine Matrix

Diese Matrix soll nun als Matrizenprodukt dargestellt werden. Dazu nehmen wir zunächst eine identische Umformung vor:

Für den Vektor gilt dann

Ein Vergleich mit Gleichung (2.9) zeigt, dass für die Matrix des Operators Su gilt

Übung 2.4 Zeigen Sie, dass der Operator S ein Tensor ist.

Beispiel 2.5: Das dyadische Produkt als Tensor

Nach Gleichung (1.25) ist das dyadische Produkt zweier Vektoren v und w bezüglich des benutzten Basissystems durch eine 3x3-Matrix darstellbar:

(2.10)

Wie sich leicht zeigen lässt (was als Übung empfohlen wird) erfüllt diese Matrix die Kriterien 2.1 bis 2.3 für einen Tensor. Da die Vektoren v und w vom benutzten Basissystem unabhängig sind, gilt dies auch für ihr dyadisches Produkt. Folglich stellen die Dyade und ihre Matrix einen Tensor dar. Daraus lassen sich zwei neue Tensor-Kriterien herleiten, von denen jedes für sich hinreichend (aber nicht notwendig) ist.

1. Eine Matrix, deren Elemente wie oben angegeben Produkte von je zwei Vektorkomponenten sind, kann als Matrix eines dyadischen Produkts aufgefasst werden und hat daher Tensoreigenschaft.

2. Es genügt jedoch bereits, wenn sich die Elemente der Matrix bei Wechsel des Koordinatensystems genau so transformieren wie die Produkte von je zwei Vektorkomponenten von der oben dargestellten Art. Dann transformiert sich nämlich auch die Matrix insgesamt wie die Matrix einer Dyade und besitzt daher Tensoreigenschaft.

Beispiel 2.5 Der Vektorgradient

Mit dem Gradienten-Operator kann die Änderung dU einer skalaren Ortsfunktion U berechnet werden, die beim Voranschreiten um eine gerichtete Strecke ds (»Verschiebung«) im Skalarfeld eintritt. (Siehe dazu Wikibook Vektoranalysis, Teil II)

Es soll nun untersucht werden, wie sich eine vektorielle Ortsfunktion v beim Voranschreiten im Vektorfeld ändert. Dazu berechnen wir die Änderungen der skalaren Komponenten vx, vy, vz des Vektors v mit Hilfe des Gradienten-Operators:

(2.11)

Damit ergibt sich das Differential dv

(2.12)

Wir bilden nun das dyadische Produkt aus dem Nablaoperator (einem symbolischen Vektor)

und dem Vektor v (Siehe Gleichung (1.25 ))

Dieser Tensor heißt Vektorgradient von v (geschrieben: grad v):

Multipliziert man diesen Tensor mit dem Verschiebungsvektor ds als Vorfaktor (siehe Gleichung (1.27)) so erhält man gemäß Gleichung (1.28) den Vektor dv:

![{\displaystyle {\begin{aligned}\operatorname {d} {\boldsymbol {s}}\ \operatorname {grad} \ {\boldsymbol {v}}=\operatorname {d} {\boldsymbol {s}}\left[{\nabla \otimes {\boldsymbol {v}}}\right]=\left({{\frac {\partial v_{x}}{\partial x}}\operatorname {d} x+{\frac {\partial v_{x}}{\partial y}}\operatorname {d} y+{\frac {\partial v_{x}}{\partial z}}\operatorname {d} z}\right){\boldsymbol {e}}_{1}+\left({{\frac {\partial v_{y}}{\partial x}}\operatorname {d} x+{\frac {\partial v_{y}}{\partial y}}\operatorname {d} y+{\frac {\partial v_{y}}{\partial z}}\operatorname {d} z}\right){\boldsymbol {e}}_{2}\\+\left({{\frac {\partial v_{z}}{\partial x}}\operatorname {d} x+{\frac {\partial v_{z}}{\partial y}}\operatorname {d} y+{\frac {\partial v_{z}}{\partial z}}\operatorname {d} z}\right){\boldsymbol {e}}_{3}.\\\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0e5c4cc50d3c6e331d8a69934df48468b5056e48)

Dies ist genau die gesuchte Änderung dv. Also gilt:

![{\displaystyle \operatorname {d} {\boldsymbol {v}}=\operatorname {d} {\boldsymbol {s}}\ \operatorname {grad} \ {\boldsymbol {v}}=\operatorname {d} {\boldsymbol {s}}\left[{\nabla \otimes {\boldsymbol {v}}}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d3b462cc73412b18eb78d418650a33639ed6ec6)

1. Beispiel:

Das Vektorfeld sei definiert durch v = r. (Man denke sich also an jeden Punkt P(x, y, z) des Feldes seinen Ortsvektor angeheftet.) Der Vektorgradient dieses Feldes ist dann

Dann ist

Interpretation: Wenn man vom Punkt P um die Strecke ds im Feld voranschreitet, ändert sich der Ortsvektor um ds.

2. Beispiel:

Der Vektor der elektrischen Feldstärke im Punkt P(x, y, z) des Feldes einer Punktladung Q, die sich im Ursprung eines kartesischen Koordinatensystems befindet, ist

Die Komponenten von E sind

woraus folgt

und weiter

Daraus ergibt sich schließlich

Einführung eines neuen Basissystems[Bearbeiten]

Bislang haben wir alle auftretenden Vektoren auf dasselbe kartesische Koordinatensystem mit den Basis(einheits)vektoren e1, e2, e3 bezogen. Nun führen wir zusätzlich ein neues kartesisches Koordinatensystem mit den Basis(einheits)vektoren e' 1, e' 2, e' 3 ein, das gegenüber dem alten System um den (gemeinsamen) Ursprung gedreht ist und eventuell anschließend parallel verschoben worden sein kann. (Eine solche Parallelverschiebung macht sich in den Transformationsgleichungen nicht bemerkbar.)

Die Basisvektoren des neuen Systems stellen wir nun – genau wie wir es bisher mit anderen Vektoren getan haben – im alten System dar. Die Komponenten der neuen Basisvektoren bezüglich des alten Systems erhalten wir – wie üblich –, indem wir die neuen Einheitsvektoren auf die alten projizieren. So erhalten wir durch Bildung der Skalarprodukte die skalaren Komponenten des neuen Basisvektors e' 1:

(3.1)

Dabei sind cos αi (i = 1, 2, 3) die »Richtungskosinus« des Vektors e' 1 bezüglich der Basisvektoren des alten Systems, die wir mit ai abkürzen.

Genau so findet man

Damit können die neuen Basisvektoren so dargestellt werden:

(3.2)

Dafür können wir schreiben:

Diese drei Gleichungen können zu einer einzigen zusammengefasst werden:

(3.3)

Übung 3.1: Bestätigen Sie diese Gleichung durch Ausmultiplizieren der Matrizen und weisen Sie nach, dass Gleichung (3.3) mit dem Gleichungssystem (3.2) äquivalent ist.

Bezeichnen wir die Matrix der Koeffizienten a1 ... c3 mit K, so können wir die Gleichung (3.3) so schreiben:

(3.4)

Umkehrung:

Es sollen nun die alten Basisvektoren durch die neuen ausgedrückt werden. Die Komponenten der alten Basisvektoren bezüglich der neuen Achsen erhalten wir analog zu oben, indem wir die alten Basisvektoren auf die neuen projizieren und dabei beachten, dass

So erhalten wir

(3.5)

Die Matrix der Koeffizienten ist offensichtlich gleich der transponierten Matrix der Koeffizienten aus Gleichung (3.3), sodass wir analog zur Gleichung (3.4) schreiben können:

(3.6)

Transformation der Vektorkomponenten bei Basiswechsel[Bearbeiten]

Es soll nun die Komponenten eines Vektors v in einer neuen Basis berechnet werden.

Die Komponentendarstellung des Vektors v bezüglich der Basis {e1, e2, e3} sei

(3.7)

seine Darstellung bezüglich der Basis {e' 1, e' 2, e' 3} sei

(3.8)

Die Komponenten des Vektors ändern sich beim Wechsel der Basis, der Vektor selbst ändert sich nicht. Es wäre daher irreführend, den Vektor im neuen System etwa mit v' zu bezeichnen.

Der Zusammenhang zwischen den Komponenten im neuen und im alten System ergibt sich, indem wir mittels der Gleichungen (3.5) die alten Basisvektoren durch die neuen ausdrücken:

Durch Ausmultiplizieren und Umordnen nach den Basisvektoren ergibt sich daraus

(3.9)

und durch Koeffizientenvergleich

(3.10)

Die Komponenten des Vektors bezüglich der neuen Basis sind also lineare homogene Funktionen seiner Komponenten bezüglich der alten Basis. (Linear und homogen bedeutet, dass die Gleichungen nur erste Potenzen der alten Komponenten enthalten.)

Dafür kann man auch schreiben

(3.11)

oder

Entsprechend findet man für die inverse Transformation die Gleichungen

(3.12)

oder

(3.13)

und

Dieses Kapitel zeigt, wie die Komponenten eines Tensors vom Rang 2 (also die Elemente seiner 3x3-Matrix) beim Übergang von einem Basissystem zu einem anderen transformiert werden. (Im nächsten Kapitel werden damit Tensoren unabhängig von einem Koordinatensystem dargestellt, analog zur koordinatenunabhängigen Darstellung eines Vektors durch einen Pfeil.) Zur Lösung dieser Aufgabe betrachten wir zunächst eine lineare homogene Vektorfunktion.

Lineare Vektorfunktionen[Bearbeiten]

Eine Vektorfunktion ist eine Funktion, bei der die unabhängige Variable v und die abhängige Variable w Vektoren sind:

(4.1)

Bei einer linearen homogenen Vektorfunktion sind die Komponenten von w lineare und homogene Funktionen der Komponenten von v:

(4.2)

Die Koeffizienten μik sind reelle Zahlen.

Solche Funktionen haben die wichtige Eigenschaft der »Distributivität zur Addition«:

(4.3)

ferner gilt

(4.4)

Übung 4.1: Bestätigen Sie die Gleichungen (4.3) und (4.4).

Die Koeffizienten μ11 ... μ33 des Gleichungssystems (4.2) bilden eine 3x3-Matrix:

(4.5)

mit der man die Funktionsgleichungen (4.2) auch so schreiben kann:

(4.6)

Übung 4.2: Bestätigen Sie diese Gleichung.

Aus Gleichung (4.6) folgt (siehe Gleichung (1.18)), dass der Vektor w das Nachprodukt der Matrix M und des Vektors v ist:

(4.7)

Fassen wir die Matrix (μik) als die Koeffizientenmatrix (F) eines Operators F für das benutzte Basissystem auf, dann ist

(4.8)

Dies ist eine – was v und w betrifft – koordinatenfreie Gleichung der Funktion. Folglich ist auch der Operator F von der benutzten Basis unabhängig. Da der Operator auch sonst alle Kriterien eines Tensors erfüllt, ist F ein Tensor. Eine lineare Vektorfunktion kann somit als Tensoroperation aufgefasst werden, durch die v auf w abgebildet wird.

Übung 4.3: Zeigen Sie, dass der Operator F die Bedingungen der Gleichungen (2.2) und (2.3) erfüllt.

Transformation der Komponenten eines Tensors vom Rang 2[Bearbeiten]

Ein Tensor vom Rang 2 ist nach Definition ein basisunabhängiger Operator mit bestimmten Eigenschaften, der bezüglich eines Basissystems durch eine 3x3-Matrix dargestellt werden kann. Die Elemente dieser Matrix (also die Tensorkomponenten) sind – genau wie die Komponenten eines Vektors – vom benutzten Basissystem abhängig.

Es soll nun gezeigt werden, wie sich die Komponenten des Tensors mit der Matrix (T) beim Wechsel des Basissystems transformieren. Dazu betrachten wir eine lineare Vektorfunktion

(4.9)

Wenn wir eine bestimmte Basis B benützen, ist

(4.10)

wobei

- (wi) die Komponentenmatrix des Vektors w zur Basis B,

- (vi) die Komponentenmatrix des Vektors v zur Basis B und

- (T) die Matrix des Tensors T zur Basis B ist.

Bei Benutzung einer anderen Basis B' sei

- die Komponentenmatrix des Vektors w gleich (w'i),

- die Komponentenmatrix des Vektors v gleich (v'i), und

- die Matrix des Tensors T gleich (T)'.

Dann ist

(4.11)

wobei die durch ihre Matrizen dargestellten Vektoren w und v in beiden Gleichungen jeweils dieselben sind. Anders ausgedrückt: Durch den Tensor T wird unabhängig von der benutzten Basis ein bestimmter Vektor v immer auf denselben Vektor w abgebildet.

Die Komponenten der Vektoren v und w im System B' sind nach dem Gleichungssystem (3.12)

(4.12)

und

(4.13)

Für die inversen Transformationen gilt dann

(4.14)

usw.

Bezeichnen wir die Komponenten des Tensors T im System B' mit μ'ik, dann lautet das Gleichungssystem der Vektorfunktion im neuen System analog zu Gleichung (4.2)

(4.15)

Wir bestimmen nun die Koeffizienten dieses Systems so, dass im System B' ein bestimmter Vektor v auf den denselben Vektor w abgebildet wird wie im System B.

Wenn wir in (4.2) die erste Zeile mit a1 multiplizieren, die zweite Zeile mit a2, die dritte Zeile mit a3 und dann die drei Ergebnisse addieren, dann erhalten wir auf der linken Seite

(4.16)

Diese Summe aber ist nach (4.13) gleich w' 1.

Für die Summe auf der rechten Seite findet man (nach Ausmultiplizieren und Umordnen)

(4.17)

Also gilt

(4.18)

Nun ersetzen wir mittels (4.10) die Komponenten vi (i = 1, 2, 3) durch v' i. Der erste Summand wird dann

(4.19)

Der zweite Summand ist

(4.20)

und der dritte

(4.21)

Führt man die drei Multiplikationen aus, addiert die Ergebnisse und bildet neue Produkte durch Ausklammern von v' 1 bzw. v' 2 bzw. v' 3 (»Umordnen nach v' 1 ...«), so erhält man für den Koeffizienten von v' 1 den Ausdruck

(4.22)

Analog findet man den Koeffizienten von v' 2:

(4.23)

und den von v' 3

(4.24)

Diese Terme müssen identisch sein mit den entsprechenden Koeffizienten in Gleichung (4.10), 1. Zeile, also muss sein

(4.25)

usw.

Die Komponenten der neuen Matrix sind also lineare homogene Funktionen der Komponenten der ursprünglichen Matrix. Die Koeffizienten der μik in diesen Gleichungen sind Produkte aus je zwei Komponenten der Matrix der Basistransformation.

Das Tensorellipsoid[Bearbeiten]

Tensoren vom Rang 0 (Skalare) lassen sich als Punkte auf der Zahlengeraden darstellen, Tensoren vom Rang 1 (Vektoren) durch Pfeile im Raum. Gibt es eine analoge Möglichkeit zur Darstellung von Tensoren vom Rang 2?

Die Komponenten eines Tensors in einer bestimmten kartesischen Basis {e1, e2, e3} seien μ11, μ12, ... μ33 (siehe Gleichung (4.5)).

Wir denken uns nun einen beliebigen, vom Ursprung O ausgehenden Strahl auf dem der Einheitsvektor e' 1 liegt. Dieser Einheitsvektor sei der erste Basisvektor einer neuen Basis (von der wir jedoch nur diesen einen Vektor brauchen). Die Richtungskosinus dieses Vektors bezüglich des ersten Basissystems seien a1, a2, a3 (siehe Gleichung (3.1)). Die erste Komponente μ' 11 des Tensors in Bezug auf die neue Basis ist dann (siehe Gleichungen (4.15) und (4.18))

(5.1)

Wir denken uns nun auf dem Strahl von O aus eine Strecke der Länge l LE (LE steht für Längeneinheiten, sodass l der Zahlenwert der Strecke ist.) angetragen, deren Quadrat l2 der Tensorkomponente μ' 11 reziprok sei:

(5.2)

Die Koordinaten des Endpunktes dieser Strecke seien ξ, η und ζ. Da die Strecke ebenfalls die Richtungskosinus a1, a2, a3 hat, ist

Wegen Gleichung (5.2) ist dann

Die Gleichung (5.1) kann nach Division durch μ' 11 dann wie folgt geschrieben werden:

(5.3)

In dieser Gleichung kommen die Richtungskosinus der Strecke nicht vor; also gilt sie für jede beliebige Gerade durch den Ursprung. Nimmt die Gerade nun alle möglichen Richtungen an,

dann überstreicht der Endpunkt der Strecke dabei eine Fläche 2. Ordnung, die durch die Gleichung (5.3) mathematisch beschrieben wird. Die Gestalt dieser Fläche wird durch die Komponenten des Tensors (und zwar durch sämtliche) eindeutig bestimmt. Sie bildet daher den Tensor ebenso eindeutig ab, wie ein Pfeil einen Vektor eindeutig abbildet. Und sie ist – ebenso wie ein Vektorpfeil - vom benutzten Koordinatensystem unabhängig, weil der Tensor selbst vom Koordinatensystem unabhängig ist. Diese Fläche wird daher – nicht ganz korrekt – Tensorellipsoid genannt, obwohl sie ohne zusätzliche Annahmen über die Tensorkomponenten auch ein Hyperboloid sein kann.

Ein Ellipsoid hat drei durch seinen Mittelpunkt gehende Achsen:

- eine von der Richtung des größten Durchmessers,

- eine von der Richtung des kleinsten Durchmessers, der immer auf dem größten senkrecht steht,

- eine, die auf diesen beiden senkrecht steht.

Durch die drei Achsen des Ellipsoids sind drei Richtungen im Raum festgelegt. Diese heißen die Hauptachsen des Tensors.

Ist das Tensorellipsoid ein Rotationsellipsoid, so ist nur die Richtung einer Hauptachse bestimmt, nämlich die der Rotationsachse; eine zweite Achse ist (senkrecht zur ersten) frei wählbar, die dritte liegt dann fest.

Wählt man ein Koordinatensystem so, dass seine Achsen mit den Achsen des Tensorellipsoids (also mit den Hauptachsen des Tensors) zusammenfallen, dann wird die Gleichung des Ellipsoids rein quadratisch, d. h., die Variablen ξ, η, ζ treten nur in der zweiten Potenz auf.

Übungen

5.1 Wie muss ein Tensor beschaffen sein, damit seine Hauptachsen mit den Koordinatenachsen zusammenfallen?

5.2 Unter welchen zusätzlichen Bedingungen ist das Tensorellipsoid

- 1. ein Rotationsellipsoid,

- 2. eine Kugel?

Reziproke Systeme von Basisvektoren[Bearbeiten]

Wir führen in O ein dreidimensionales schiefwinkliges UVW-Koordinatensystem ein, das durch drei nicht-komplanare (d. h.: nicht in einer gemeinsamen Ebene liegende) Einheitsvektoren e1, e2, e3 bestimmt ist. Diese drei Vektoren bestimmen außer der U-, V- und W-Achse auch eindeutig eine UV-Ebene, eine VW-Ebene und eine WU-Ebene.

Dann können wir in jedem Punkt P des Raumes ein »lokales Koordinatensystem« installieren, dessen Achsen zu denen des Basissystems parallel sind. Wir bezeichnen dessen Einheitsvektoren zur Unterscheidung von denen des Basissystems mit

wobei natürlich - wenn man von der Parallelverschiebung absieht -

ist.

Nun definieren wir in P ein zweites lokales System von Einheitsvektoren

der Art, dass

ist. Da e*1 auf der VW-Ebene senkrecht steht, ist der Vektor auch orthogonal zur V- und zur W-Achse. Analoges gilt für die beiden anderen Vektoren des Systems. (Beachte: Dies trifft zu, obwohl beide Systeme schiefwinklig sind, also die Vektoren ein und desselben Systems nicht orthogonal sind.)

Sonderfall: Ist das Basissystem in O mit den Vektoren ei (i = 1, 2, 3) rechtwinklig, dann sind es die beiden anderen Systeme auch und dann ist auch

Definition: In diesem Fall heißen die beiden lokalen Systeme reziprok (zueinander).

Da jeder Vektor aus dem einen System dann zu jedem Vektor aus dem anderen (reziproken) System entweder parallel oder orthogonal ist, gilt für die Skalarprodukte von je zwei Vektoren aus verschiedenen Systemen

Setzt man nach einem Vorschlag von Kronecker (1923-1991)

dann kann man schreiben

δik heißt Kroneckers delta.

Verallgemeinerung:

Alle Vektorsysteme, die dieser Bedingung genügen, werden reziprok (zueinander) genannt. Selbst wenn die Basisvektoren keine Einheitsvektoren sind, können sie diese Bedingung erfüllen, nämlich genau dann, wenn ihre Längen so gewählt werden, dass die entsprechenden Skalarprodukte den Wert 1 haben. Die Beträge dieser Vektoren müssen dann reziprok zueinander sein, woraus sich ihr Name erklärt.

Kontravariante und kovariante örtliche Basissysteme[Bearbeiten]

Nun richten wir in O zwei verschiedene Koordinatensysteme ein:

1. ein kartesisches XYZ-System mit den Basisvektoren i, j, k,

2. ein schiefwinkliges UVW-System mit den Basisvektoren e1, e2 und e3, die keine Einheitsvektoren sein müssen.

Ein beliebiger Punkt P hat dann bezüglich des kartesischen Systems die Koordinaten x, y, z, bezüglich des schiefwinkligen Systems die Koordinaten u, v, w.

Wieder gilt, dass je zwei Achsen der beiden Systeme eine Koordinatenebene bestimmen.

Man kann nun Transformationsgleichungen aufstellen, aus denen die Koordinaten, die der Punkt P im XYZ-System hat, aus denen berechnet werden können, die er im UVW-System hat und umgekehrt. Dabei ergeben sich zwei Systeme von je drei Gleichungen:

Dann sind u, v und w lineare homogene Funktionen von x, y und z und umgekehrt:

(7.1)

Diese Transformationsgleichungen sind linear und homogen.

»Linear« bedeutet, dass in den Funktionsgleichungen die Koordinaten nur in der 1. Potenz auftreten. »Homogen« bedeutet in diesem Zusammenhang, dass in den Gleichungen keine konstanten (additiven) Glieder auftreten.

Übungen:

7.1 Zeigen Sie, dass die Gleichungen homogen sein müssen.

7.2 Berechnen Sie die Funktionen x = x(u, v, w), y = y(u, v, w), z = z(u, v, w). Anleitung: Dies ist relativ einfach, weil das XYZ-System rechtwinklig ist und daher x, y, z die senkrechten Projektionen des Ortsvektors r von P auf die drei kartesischen Achsen sind. Führen Sie dazu die Richtungskosinus der drei schiefwinkligen Achsen ein: αi, βi und γi, wobei i = 1, 2, 3 ist und projizieren Sie den Vektor

auf die kartesischen Achsen. Überzeugen Sie sich, dass die Gleichungen linear sind.

Danach ist es prinzipiell möglich – wenn auch etwas mühsam – die Umkehrfunktionen u = u(x, y z) usw. zu finden. Wie wäre das anzustellen?

Der Ortsvektor r eines Punktes P im kartesischen XYZ-System mit den Basisvektoren i, j, k ist

Die partiellen Ableitungen von r nach x, y und z sind dann

Im schiefwinkligen UVW-System ist der Ortsvektor r von P:

und seine partiellen Ableitungen sind

(7.2)

Wenn wir nun in P ein lokales Koordinatensystem einführen, dessen Achsen zu den Basisvektoren des schiefwinkligen Systems parallel sind, dann heißt dieses System »ein zum UVW-System (mit den Achsen ei ) kontravariantes System«. Es ist daran zu erkennen, dass seine Achsen zu denen des Basissystems in O parallel sind. Ein solches wird durch eingeklammerte und hochgestellte Indices bezeichnet. Für die Achsen des kontravarianten Systems in P gilt also:

Durch Bildung der partiellen Ableitungen können die Basisvektoren des kontravarianten Systems auf das XYZ-System bezogen werden, wobei auch für die partiellen Ableitungen der Basisvektoren des kontravarianten Systems die Gleichungen (8.2) gelten.

Übung 7.3: Woher kann man die für diese Darstellung benötigten partiellen Ableitungen von x, y, z nach u, v, w bekommen?

Als nächstes führen wir in P ein System mit den Basisvektoren e(i) ein, die auf den Koordinatenebenen des UVW-Systems senkrecht stehen sollen. Ein solches System heißt »kovariant«.

Wir finden seine Basisvektoren, indem wir berücksichtigen, dass die VW-Ebene auch als die Ebene beschrieben werden kann, in der u = konst. ist. Ein darauf senkrechter Vektor ist der Vektor grad u.

Übungen:

7.4 Rekapitulieren Sie, wie der Vektor grad u definiert ist und welche Eigenschaften er hat. Zeigen Sie, dass er für unsere Zwecke auch die richtige Richtung besitzt, also von der positiven Seite der VW-Ebene ausgeht.

7.5 Machen Sie sich an einer Skizze eines zweidimensionalen schiefwinkligen Koordinatensystems klar, dass die Richtung des stärksten Anstiegs der Koordinate u nicht etwa parallel zur U-Achse verläuft, sondern senkrecht zur V-Achse.

Diesen Vektor grad u führen wir als kovarianten Basisvektor e(1) ein und analog zwei weitere Basisvektoren e(2) und e(3):

Im XYZ-System können diese Vektoren so beschrieben werden (Definition des Gradienten):

Durch Bildung der entsprechenden Skalarprodukte können wir nun bestätigen, dass das kontravariante und das kovariante System nach obiger Definition reziproke Systeme sind, obwohl sie nicht notwendig aus Einheitsvektoren bestehen:

Es ist nämlich

und

usw.

Übung 7.6: Die partielle Ableitung von u nach u ist offensichtlich gleich 1, aber warum ist die partielle Ableitung von v nach u (und die analogen Ableitungen) gleich 0?

Ein beliebiger Vektor V kann nun in jedem der beiden reziproken Systeme dargestellt werden. Seine kontravariante Darstellung wird geschrieben:

seine kovariante Darstellung dagegen ist

Die Indizes der Vektorkomponenten im kontravarianten Systems werden dabei der Einfachheit halber nicht in Klammern gesetzt; eine Verwechslung mit Hochzahlen (Exponenten) kann wohl ausgeschlossen werden.

Da der Vektor vom Koordinatensystem und der Form seiner Darstellung unabhängig ist, gilt natürlich

Zur Berechnung des Betrages von V bilden wir das Skalarprodukt V·V. Dabei benutzen wir für den ersten Faktor die kontravariante und für den zweiten Faktor die kovariante Darstellung des Vektors und berücksichtigen beim Multiplizieren, dass die beiden Faktoren zwar identisch sind, weil sie beide denselben Vektor V darstellen, ihre Darstellungsformen aber sind reziprok. Dabei erhalten wir ein interessantes Ergebnis:

In abgekürzter Schreibweise:

Die Regel zur Berechnung eines Skalarproduktes kann also auch auf reziproke Komponenten angewendet werden.

Übung 1.1

Nach Gleichung (1.10) ist

Nach Gleichung (1.11) ist dann

also

Übung 1.2

Wir setzen

Dann ist nach Gleichung (1.10)

und wegen

![{\displaystyle {\boldsymbol {t}}=\left({t_{i}}\right)^{T}{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}=\left[{v_{1}\left({a_{11}+b_{11}}\right)+v_{2}\left({a_{21}+b_{21}}\right)+v_{3}\left({a_{31}+b_{31}}\right)}\right]{\boldsymbol {e}}_{1}+{\mbox{usw}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bca2f1dbfed6bfd6c7ea0af3bc007f44b28e6b2b)

Addiert man die Komponentendarstellungen von u und w, erhält man die gleichen Komponenten. Also ist

Übung 1.3

Es ist (siehe Übungen 1.1 und 1.2)

Übung 1.4

Es ist

und folglich Ev = v.

Übung 1.5

Wir setzen

und berechnen und vergleichen wie bei Übung 1.2 die Komponentenmatrizen (ui), (vi) und (ti).

Übung 1.6

Es ist wegen der Distributivität des Nachprodukts

Übungen 1.7 und 1.8

Setzt man

so ist

und

Aus diesen homogenen Gleichungen können nur die Quotienten

der Vektorkomponenten bestimmt werden, nicht aber diese selbst. Daraus folgt:

Genau eine Komponente der beiden Vektoren kann frei gewählt werden, die übrigen ergeben sich dann daraus. Das bedeutet, dass durch die Matrix die Richtungen der beiden Vektoren bestimmt sind, nicht aber deren Beträge. Ferner: Der Betrag von v ist bei gegebener Matrix dem Betrag von u umgekehrt proportional.

Übung 1.9

Die Summe der Komponenten in der Hauptdiagonalen ist gleich dem Skalarprodukt der Vektoren v und w:

Übung 1.10

Wegen

ist

Übung 2.1

1. Gradient: Der Operator »grad« kann definitionsgemäß nur auf skalare Größen angewendet werden, ist also kein Tensor.

2. Divergenz: Der Operator »div« wird zwar auf Vektoren angewendet, erzeugt aber einen Skalar. Also ist »div« kein Tensor.

3. Rotation: Der Operator »rot« wird auf Vektoren angewendet und erzeugt wieder einen Vektor (Bedingung (1)). Ferner gilt rot (u + v) = rot u + rot v (Bedingung (2)) und rot (a v) = a rot v (Bedingung (3)). Also ist »rot« ein Tensor vom Rang 2. Der Vektor w = rot v ist (als solcher) invariant gegen Koordinatentransformation. - Allerdings ist Folgendes zu beachten: Der Operator rot ist ein Differentialoperator. Seine Anwendung auf konstante Vektoren ergibt immer den Nullvektor, also ein triviales Ergebnis. Haben wir dagegen ein »Vektorfeld« vorliegen, in dem v = v(x, y, z), dann kann rot v ≠ o sein.

4. Laplace-Operator: Der Laplace-Operator

kann auf skalare und vektorielle Funktionen angewendet werden. Bei Anwendung auf einen konstanten Vektor werden schon die 1. Ableitungen zu null. Bei Anwendung auf einen Feldvektor v = v(x, y, z) kann ein von null verschiedener Vektor entstehen. Für die partiellen Ableitungen gilt:

Folglich kann Δ ein Tensor sein.

5. Nablaoperator: Bei Anwendung des Nablaoperators

auf einen konstanten Vektor v werden die Ableitungen zu null. Bei Anwendung auf einen Feldvektor entsteht ein Skalar, da die beim Multiplizieren entstehenden Produkte alle einen Faktor ei · ek enthalten, der entweder 0 oder 1 ist. Der Nablaoperator ist kein Tensor.

Übung 2.3

Es ist (Beispiel 2.1) Pv = (v · e)e und (Beispiel 2.2) Sv = v - 2(v · e)e, also ist

wobei E die 3 x 3 Einheitsmatrix ist.

Damit ergibt sich für die Matrix von S:

![{\displaystyle {\begin{matrix}\left({\boldsymbol {S}}\right)={\frac {2}{u^{2}}}\left[{\begin{pmatrix}{\frac {u^{2}}{2}}&0&0\\0&{\frac {u^{2}}{2}}&0\\0&0&{\frac {u^{2}}{2}}\end{pmatrix}}-{\begin{pmatrix}{u_{1}u_{1}}&{u_{1}u_{2}}&{u_{1}u_{3}}\\{u_{2}u_{1}}&{u_{2}u_{2}}&{u_{2}u_{3}}\\{u_{3}u_{1}}&{u_{3}u_{2}}&{u_{3}u_{3}}\end{pmatrix}}\right]\\\\={\frac {2}{u^{2}}}{\begin{pmatrix}{\frac {u^{2}}{2}}-u_{1}u_{1}&-u_{1}u_{2}&-u_{1}u_{3}\\-u_{2}u_{1}&{\frac {u^{2}}{2}}-u_{2}u_{2}&{-u_{2}u_{3}}\\{-u_{3}u_{1}}&{-u_{3}u_{2}}&{\frac {u^{2}}{2}}-u_{3}u_{3}\end{pmatrix}}\,.\end{matrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4d435ba62fb0ff8604a13093be71ddf8670e2b5e)

Wenn e mit dem Basisvektor e1 zusammenfällt, wird u2 = u3 = 0 und u1 u1 = u2. Damit wird

Übung 2.4

Für jedes Vektorprodukt gilt:

1. Es ist ein Vektor,

2. (a + b) x c = a x c + b x c

3. (na) x b = n(a x b).

Also ist S ein Tensor.

Übung 3.1

Das Ergebnis der Multiplikation ist

Wenn zwei Matrizen gleich sind, müssen ihre einander entsprechenden Elemente gleich sein. Also ist

Übung 4.3

1. Für eine lineare Funktion f gelten nach Gleichungen (4.3) und (4.4):

Ferner ist nach Gleichung (4.8) und Gleichung (4.1)

(Lies: F mal v1 ist gleich f von v1 und beachte den Unterschied!)

Mit u = v1 + v2 und f(u) = Fu gilt dann

2. Mit k v = w folgt aus

Übung 5.1

Da in der Gleichung keine linearen Glieder auftreten sollen, muss sein:

Übung 5.2

1.

Die Gleichung eines Ellipsoids, dessen Hauoptachsen mit den Koordinatenachsen zusammenfallen, lautet

Rotationsellipsoid hat zwei gleiche Hauptachsen, also muss sein

woraus wegen

folgt

2. Wenn des Ellipsoid eine Kugel ist, sind alle drei Hauptachsen gleich, also

Übung 7.1 Da die Systeme denselben Ursprung haben, muss für x = y = z = 0 auch u = v = w = 0 sein. Die Transformationsgleichungen dürfen daher kein Konstantglied haben.

Übung 7.2 Der Ortsvektor eines Punktes P(x, y, z bzw. u, v, w) ist im XYZ-System

(Ü 7.2.1)

im UVW-System

(Ü 7.2.2)

Da x, y, z die senkrechten Projektionen von r auf die Koordinatenachsen sind und diese sich aus den entsprechenden Skalarprodukten ergeben, ist

und mit Gleichung (Ü 7.2.2)

(Ü 7.2.3)

Bezeichnen wir die Richtungskosinus von ei mit αi, dann wird aus Gleichung (Ü 7.2.3):

(Ü 7.2.4)

wobei ei der Betrag des Vektors ei ist.

Analog findet man

(Ü 7.2.5)

(Ü 7.2.6)

Es handelt sich also um drei lineare homogene Funktionen.

Aus den Gleichungen (7.2.4, 7.2.5 und 7.2.6) können mit den Methoden der Algebra (Einsetzungsmethode, Gleichsetzungsmethode, Additionsmethode) oder mit einem Rechenprogramm Gleichungen für u, v und w gewonnen werden.

Übung 7.3 Die partiellen Ableitungen ergeben sich aus den Gleichungen (7.1).

Übung 7.4 Der Vektors grad u weist in die Richtung der größten Steigung (des steilsten Anstiegs der skalaren Feldgröße u. Der Betrag von grad u ist gleich dem Maß dieser größten Steigung. Der Vektor grad u steht auf der positiven Seite der VW-Ebene senkrecht, weil nur in dieser Richtung die u-Werte zunehmen.

Übung 7.5

![{\displaystyle {\boldsymbol {w}}=\left({\boldsymbol {w}}\right)^{\mathsf {T}}{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}=\left[\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {A}}\right]{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a62c6b03410e8bf51bc9f241b9a5ae22ec7322b8)

![{\displaystyle \left({\boldsymbol {v}}\right)^{\mathsf {T}}\left[{\boldsymbol {A}}+{\boldsymbol {B}}\right]=\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {A}}+\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {B}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b508ac774bf9a461e4a48cb7f414d803c8f20a2a)

![{\displaystyle \left({\boldsymbol {v}}\right)^{\mathsf {T}}\left[{\boldsymbol {E}}+{\boldsymbol {A}}\right]=\left({\boldsymbol {v}}\right)^{\mathsf {T}}+\left({\boldsymbol {v}}\right)^{\mathsf {T}}{\boldsymbol {A}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/79e92cb73821b9b8150ef0f340a676ce682d63e8)

![{\displaystyle \left[{\boldsymbol {A}}+{\boldsymbol {B}}\right]\left({\boldsymbol {v}}\right)={\boldsymbol {A}}\left({\boldsymbol {v}}\right)+{\boldsymbol {B}}\left({\boldsymbol {v}}\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3df46eaf634007baff4a0970f03eb10e3c43952b)

![{\displaystyle \left[{{\boldsymbol {E}}+{\boldsymbol {A}}}\right]\left({\boldsymbol {v}}\right)=\left({\boldsymbol {v}}\right)+{\boldsymbol {A}}\left({\boldsymbol {v}}\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/04829d76be8a8be35757f30214d2e8049dd3fde7)

![{\displaystyle k\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]=\left[{k{\boldsymbol {v}}}\right]\otimes {\boldsymbol {w}}={\boldsymbol {v}}\otimes \left[{k{\boldsymbol {w}}}\right]=\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]k\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d417fe19ba3a1742b45c53cee65c1496b26db99e)

![{\displaystyle {\boldsymbol {u}}\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5e62357c697481b2db4f453404b0b2d1b30e9ffb)

![{\displaystyle {\boldsymbol {u}}\left[{\boldsymbol {v}}\otimes {\boldsymbol {w}}\right]=\left({u_{i}}\right)^{T}\left[{\boldsymbol {v}}\otimes {\boldsymbol {w}}\right]={\begin{pmatrix}{u_{1}}&{u_{2}}&{u_{3}}\end{pmatrix}}{\begin{pmatrix}{v_{1}w_{1}}&{v_{1}w_{2}}&{v_{1}w_{3}}\\{v_{2}w_{1}}&{v_{2}w_{2}}&{v_{2}w_{3}}\\{v_{3}w_{1}}&{v_{3}w_{2}}&{v_{3}w_{3}}\end{pmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/10f55ca54c63ecef91f720ef2fd3336cccd1514b)

![{\displaystyle {\boldsymbol {t}}=\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]w_{1}{\boldsymbol {e}}_{1}+\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]w_{2}{\boldsymbol {e}}_{2}+\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]w_{3}{\boldsymbol {e}}_{3}=\left[{\boldsymbol {u}}\cdot {\boldsymbol {v}}\right]{\begin{pmatrix}{w_{1}}&{w_{2}}&{w_{3}}\end{pmatrix}}{\begin{pmatrix}{\boldsymbol {e}}_{1}\\{\boldsymbol {e}}_{2}\\{\boldsymbol {e}}_{3}\end{pmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ee26b1dfa3f058760b164db64a643f0ef26e811a)

![{\displaystyle {\boldsymbol {t}}=\left[{{\boldsymbol {u}}\cdot {\boldsymbol {v}}}\right]{\boldsymbol {w}}=k\,{\boldsymbol {w}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1922baf9caa2eea54aa6965855412b18fbdc6921)

![{\displaystyle {\boldsymbol {u}}\left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]=k\,{\boldsymbol {w}}\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1bf6d1d118471a48435fa1a9187bfb849c3c7d2d)

![{\displaystyle \left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]{\boldsymbol {u}}\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d35c57d8320c980b19f535a8d7a70079893218ec)

![{\displaystyle \left[{\boldsymbol {v}}\otimes {\boldsymbol {w}}\right]{\boldsymbol {u}}={\begin{pmatrix}{v_{1}w_{1}}&{v_{1}w_{2}}&{v_{1}w_{3}}\\{v_{2}w_{1}}&{v_{2}w_{2}}&{v_{2}w_{3}}\\{v_{3}w_{1}}&{v_{3}w_{2}}&{v_{3}w_{3}}\end{pmatrix}}{\begin{pmatrix}{u_{1}}\\{u_{2}}\\{u_{3}}\end{pmatrix}}={\begin{pmatrix}{v_{1}w_{1}u_{1}+v_{1}w_{2}u_{2}+v_{1}w_{3}u_{3}}\\{v_{2}w_{1}u_{1}+v_{2}w_{2}u_{2}+v_{2}w_{3}u_{3}}\\{v_{3}w_{1}u_{1}+v_{3}w_{2}u_{2}+v_{3}w_{3}u_{3}}\end{pmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/11593d8157cace79896c422d091e5385ec3bf2d3)

![{\displaystyle {\boldsymbol {t}}=\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]v_{1}{\boldsymbol {e}}_{1}+\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]v_{2}{\boldsymbol {e}}_{2}+\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]v_{3}{\boldsymbol {e}}_{3}=\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]{\begin{pmatrix}{v_{1}}&{v_{2}}&{v_{3}}\end{pmatrix}}{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6469b3e4c8f6cc2bff9a88ec8f423ea291c05f07)

![{\displaystyle {\boldsymbol {t}}=\left[{{\boldsymbol {w}}\cdot {\boldsymbol {u}}}\right]{\boldsymbol {v}}=k{\boldsymbol {v}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3f67717b64a409d10b72206bd8a37c62e38fef49)

![{\displaystyle \left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]{\boldsymbol {u}}=k{\boldsymbol {v}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bad248dd45c0eef669426829426e45c9e78de523)

![{\displaystyle \left[{{\boldsymbol {v}}\otimes {\boldsymbol {w}}}\right]{\boldsymbol {u}}=k\,{\boldsymbol {v}}\quad \quad {\text{oder}}\quad \quad {\boldsymbol {T}}{\boldsymbol {u}}=k{\boldsymbol {v}}\,.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b312ba09797839ec9958a814579f935c64ae9acd)

![{\displaystyle {\begin{aligned}\operatorname {d} {\boldsymbol {s}}\ \operatorname {grad} \ {\boldsymbol {v}}=\operatorname {d} {\boldsymbol {s}}\left[{\nabla \otimes {\boldsymbol {v}}}\right]=\left({{\frac {\partial v_{x}}{\partial x}}\operatorname {d} x+{\frac {\partial v_{x}}{\partial y}}\operatorname {d} y+{\frac {\partial v_{x}}{\partial z}}\operatorname {d} z}\right){\boldsymbol {e}}_{1}+\left({{\frac {\partial v_{y}}{\partial x}}\operatorname {d} x+{\frac {\partial v_{y}}{\partial y}}\operatorname {d} y+{\frac {\partial v_{y}}{\partial z}}\operatorname {d} z}\right){\boldsymbol {e}}_{2}\\+\left({{\frac {\partial v_{z}}{\partial x}}\operatorname {d} x+{\frac {\partial v_{z}}{\partial y}}\operatorname {d} y+{\frac {\partial v_{z}}{\partial z}}\operatorname {d} z}\right){\boldsymbol {e}}_{3}.\\\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0e5c4cc50d3c6e331d8a69934df48468b5056e48)

![{\displaystyle \operatorname {d} {\boldsymbol {v}}=\operatorname {d} {\boldsymbol {s}}\ \operatorname {grad} \ {\boldsymbol {v}}=\operatorname {d} {\boldsymbol {s}}\left[{\nabla \otimes {\boldsymbol {v}}}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d3b462cc73412b18eb78d418650a33639ed6ec6)

![{\displaystyle {\boldsymbol {t}}=\left({t_{i}}\right)^{T}{\begin{pmatrix}{{\boldsymbol {e}}_{1}}\\{{\boldsymbol {e}}_{2}}\\{{\boldsymbol {e}}_{3}}\end{pmatrix}}=\left[{v_{1}\left({a_{11}+b_{11}}\right)+v_{2}\left({a_{21}+b_{21}}\right)+v_{3}\left({a_{31}+b_{31}}\right)}\right]{\boldsymbol {e}}_{1}+{\mbox{usw}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bca2f1dbfed6bfd6c7ea0af3bc007f44b28e6b2b)

![{\displaystyle {\begin{matrix}\left({\boldsymbol {S}}\right)={\frac {2}{u^{2}}}\left[{\begin{pmatrix}{\frac {u^{2}}{2}}&0&0\\0&{\frac {u^{2}}{2}}&0\\0&0&{\frac {u^{2}}{2}}\end{pmatrix}}-{\begin{pmatrix}{u_{1}u_{1}}&{u_{1}u_{2}}&{u_{1}u_{3}}\\{u_{2}u_{1}}&{u_{2}u_{2}}&{u_{2}u_{3}}\\{u_{3}u_{1}}&{u_{3}u_{2}}&{u_{3}u_{3}}\end{pmatrix}}\right]\\\\={\frac {2}{u^{2}}}{\begin{pmatrix}{\frac {u^{2}}{2}}-u_{1}u_{1}&-u_{1}u_{2}&-u_{1}u_{3}\\-u_{2}u_{1}&{\frac {u^{2}}{2}}-u_{2}u_{2}&{-u_{2}u_{3}}\\{-u_{3}u_{1}}&{-u_{3}u_{2}}&{\frac {u^{2}}{2}}-u_{3}u_{3}\end{pmatrix}}\,.\end{matrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4d435ba62fb0ff8604a13093be71ddf8670e2b5e)