Einführung in die Fotografie/ Grundlagen der Bildgestaltung

Das Bildformat

[Bearbeiten]Grundlagen

[Bearbeiten]Da Bilder Elemente des zweidimensionalen Raums sind, haben sie eine Länge und Breite. Das Verhältnis aus Länge und Breite ergibt dabei das Bildformat. Beim Verhältnis von Breite zu Höhe spricht man auch vom Aspektverhältnis des Bildes.

Ist das Bild breiter als lang, so spricht man vom Querformat. Im anderen Fall spricht man vom Hochformat. Das Bildformat kann man eindeutig angeben, indem man die Breite des Bildes ins Verhältnis zur Höhe setzt. Das geschieht mit einem Bruch (beziehungsweise einer Verhältnisrelation). Ein Format 7:5 heißt also, dass das Photo 7 Einheiten breit und 5 Einheiten hoch ist. Da man solche Brüche gedanklich nicht so gut vergleichen kann, rechnet man diesen Bruch oft auch in das Verhältnis x:1 um. Das heißt, man setzt die Höhe des Bildes 1 und schaut, um das wieviel-fache das Bild breiter als höher ist. Das Format 7:5 entspricht dem Format (7/5) : 1, also 1,4 : 1. Daran erkennt man, dass das Bild 1,4 mal breiter ist als hoch. Das Photo könnte beispielsweise 10 cm hoch und 14 cm breit sein (oder 1000 Pixel hoch und 1400 Pixel breit etc.).

Ist ein Photo im Hochformat aufgenommen, so gibt man meist trotzdem das Format an, wie es im Querformat ist. Statt 9:16 sagt man also dennoch, das Photo ist im Format 16:9 aufgenommen, eben nur im Hochformat. Statt der allgemeinen Vorschrift Breite:Höhe, ist somit die Bezeichnung längere Seite : kürzere Seite eigentlich treffender.

Querformat, Hochformat, Quadrat

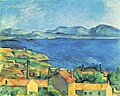

[Bearbeiten]Das Querformat kommt dem menschlichen Seheindruck am nächsten und ist deswegen die primäre Formatwahl für viele Aufnahmen. Letztlich bestimmt allerdings das Motiv die optimale Formatwahl. In der Landschaftsphotographie wird das Querformat besonders häufig verwendet. Bei Panorama-Aufnahmen wird dabei oft ein Seitenverhältnis von deutlich mehr als 2:1 erreicht.

Das Hochformat wird für Motive verwendet, die eher hoch als breit sind, um größere ungenutzte Flächen auf dem Photo zu vermeiden. Es wird sehr häufig in der Porträtphotographie verwendet (vor allem, wenn Personen nah oder halbnah abgebildet werden) sowie in der Architekturphotographie.

Das quadratische Format wird seltener verwendet und besitzt einen recht eigensinnigen, künstlerisch durchaus interessanten Charakter. Es ist das klassische Format für Passbilder und wird vielleicht noch am häufigsten in der Sach- und Stilllebenphotographie verwendet.

Abmessung

[Bearbeiten]Kantenlängen analoger Bilder (zum Beispiel Abzüge) werden im deutschen Raum normalerweise in Zentimeter oder Millimeter gemessen, etwa 70 mm x 115 mm. In einigen anderen Ländern wie den USA wird nach wie vor das an sich veraltete Inch (Zoll) verwendet, wobei Zoll heute eine vom internationalen Standard Meter abgeleitete Größe ist (früher wurde das Zoll von der Daumenbreite eines bestimmten Königs abgeleitet, was spätestens nach dessen Tod Probleme mit sich brachte). Es gilt 1 Inch = 25,4 mm.

Digitale Bilder werden hingegen in Pixeln gemessen. Eine Umrechnung von Pixel nach Zentimeter ist dabei zunächst nicht möglich. Beim Drucken eines Bildes wird der Drucker das Bild jedoch in einer bestimmten Druckauflösung drucken, die meist in dpi (dots per inch, also Druckpunkte je Inch) angegeben wird. Hier lässt sich dann aus der Pixelzahl die Bildgröße des zu druckenden Bildes berechnen. Auch wenn das digitale Bild auf einem Monitor dargestellt wird, ergibt sich gemäß der Auflösung des Monitors eine Darstellung mit Abmessungen in Zentimetern. Die Auflösung eines Monitors liegt häufig im Bereich 70 bis 130 dpi.

Eine gängige Druckauflösung ist 300 dpi, die für gewöhnliche Ansprüche meist völlig ausreichend ist. Ein Photo der Größe 1500x2000 Pixel wäre bei dieser Druckauflösung 5 Inch x 6,66 Inch groß, also 12,7 cm x 16,9 cm. Möchte man es auf A4-Format drucken, so müsste man die Druckauflösung fast halbieren. Bei einer Druckauflösung von 150 dpi wäre das Bild dann rund 25 cm x 34 cm groß, also etwa 6 Pixel pro Millimeter. Einzelne Pixel können sichtbar werden. Ob das geschieht, hängt vom Betrachtungsabstand und von der Sehfähigkeit des Betrachters ab. Kinder und Jugendliche mit sehr guter Sehfähigkeit und der Möglichkeit, auch sehr nahe Objekte zu fokussieren, sollten ohne Hilfsmittel Strukturen von einem zehntel Millimeter noch erkennen können, diese können also vermutlich einen Druck mit 150 dpi von einem mit 300 dpi unterscheiden.

Je nach Betriebssystem und verwendetem Programm kann es schwierig sein, bei der Darstellung auf Monitoren die korrekte Auflösung zu verwenden. Zwar gibt es schon seit vielen Jahren Standards, nach denen prinzipiell die Auflösungen von Monitoren korrekt auslesbar sind. Zahlreiche Darstellungsprogramme verwenden trotzdem Phantasiewerte, früher gerne 72 dpi oder 90 dpi, heute eher 96 dpi. Das hat dann zur Folge, dass oft Bilder mit absoluten Größenangaben in Zentimetern falsch dargestellt werden. Weil digitale Photos eigentlich immer in Pixelmaßen vorliegen, ist dies bei diesen allenfalls bei einer Druckvorschau problematisch. Bei anderen Dateiformaten mit Abmessungen in Zentimetern kann es allerdings mit großer Wahrscheinlichkeit zu unsinnigen und falschen Anzeigen kommen. Obgleich dies Problem bei Druckern eigentlich nicht auftritt, kann sich bei einigen Programmen übrigens der Auflösungsfehler über die Druckvorschau bis hin zum Druckergebnis fortpflanzen.

Typische Photoformate

[Bearbeiten]Da Photographie seit jeher das Ziel hatte, Eindrücke möglichst realistisch wiederzugeben, hat man auch das Bildformat realistischen Verhältnissen angepasst. Der Mensch hat für bewußtes, scharfes Sehen etwa einen horizontalen Blickwinkel von 45 bis 50° (wobei hier wiederum dieser mittlere Bereich am stärksten wahrgenommen wird und die Wahrnehmung zu den Rändern hin abnimmt). Der vertikale Winkel ist deutlich geringer; der vom menschlichen Auge wahrgenommene Bereich liegt etwa bei 1:2. Mit anderen Worten, wenn wir etwas betrachten und dabei nicht die Augen bewegen, dann sehen wir von der Szene einen relativ breiten, aber nicht besonders hohen Streifen klar. Das ist biologisch vermutlich so zu erklären, dass der Mensch seine Augen unter anderem zur Erkennung von Gefahren benutzt und diese für ihn eher von links oder rechts, als von oben oder unten kommen. Im Detail ist die Sache allerdings deutlich komplizierter, weil die Menschen zwei Augen haben, um räumlich zu sehen. Die Blickwinkel der beiden Augen überlappen nur teilweise. Der horizontale Blickwinkel für beide Augen zusammen oder für das Bildergebnis im Gehirn beträgt fast 180°, was man leicht selbst testen kann, indem man die zunächst nach vorne ausgestreckten Arme langsam voneinander weg zur Seite bewegt. Allerdings kann das Gehirn ohnehin nur einen schmalen Bereich des Blickwinkels auf einmal bewußt analysieren, der Rest unterliegt nur einer sehr eingeschränkten Beachtung, wobei insbesondere Änderungen der Szenerie schnell wahrgenommen werden. Hat das Objektiv einer Kamera allerdings einen Blickwinkel von 45 bis 50°, so erscheinen im optischen Sucher einer Spiegelreflexkamera Objekte gleich groß wie vom Auge wahrgenommen, wenn ein Objektiv mit dem gleichen Aufnahmewinkel verwendet wird.

Zusätzlich wird der Vergleich zwischen Auge und Kamera verkompliziert, weil beim Auge die Projektionsfläche näherungsweise ein Teil einer Kugelfläche ist, beim Kamerasensor eine flache Ebene. Zudem filtert das Gehirn auf subtile Weise den Datenstrom vom Auge, um mit den großen Datenmengen fertig zu werden. Dafür können Auge und Hirn aber die Schärfeebene oder eher Schärfefläche sehr schnell ändern, dass anders als bei einem Photo im Gehirn nicht so stark der Eindruck entsteht, man könne nur einen engen Bereich vor dem Auge scharf abbilden. Insgesamt ist somit ein Bild weder im Format noch im Seheindruck besonders realistisch in dem Sinne, dass es mit dem von den Augen vermittelten Eindrücken vergleichbar wäre.

Weil jedenfalls der horizontale Blickwinkel größer als der vertikale ist, sind Photos oft im Querformat und spiegeln somit wenigstens grob wider, was wir auch in der Natur sehen würden. Das klassische Photoformat war eine lange Zeit 3:2 (1,5:1). Bedingt durch die Dimensionierung klassischer Computermonitore ist dann jedoch das Verhältnis 4:3 (1,33:1) ein häufiges Format der Digitalphotographie gewesen. Daran erkennt man, dass man hierbei nicht ganz den menschlichen Blickwinkel erreicht. Viele Kameras bieten daher heute auch ein breiteres Format an, zum Beispiel das relativ moderne 16:9 (1,77:1), welches dem menschlichen Blickwinkel relativ nahekommt. Für Kinofilme verwendet man oft sogar das Format 21:9 (2,35:1). Das besonders breite Kinoformat könnte auch daraus resultieren, weil im Kino die Menschen eher nebeneinander sitzen als übereinander, der Kinosaal also meist breiter als hoch ist, und so mit einem sehr breiten Format allen Besuchern ein akzeptables Ergebnis geboten werden kann. Somit wäre das breite Kinoformat für den Einzelbetrachter auf dem Monitor eher belanglos. Solch breite Verhältnisse wählt man in der Photographie daher eher selten, sie können aber bei Panorama-Aufnahmen in diesem Bereich, oder gar größeren Bereichen, auftreten.

Das Format 1,33:1 wird dennoch sehr oft, wahrscheinlich sogar am häufigsten verwendet. Viele Computermonitore haben das Verhältnis 4:3 und das Photo kann somit auf einem solchen Bildschirm in der Art angezeigt werden, dass es ihn vollständig ausfüllt und dabei nicht verzerrt wird. Laptops und Breitbildschirme verwenden hingegen oft ein breiteres Format (z.B. 1200 x 800 Pixel, also 3:2) und hier würde das Photo im Vollbildmodus entweder in die Breite gezerrt werden, oder es kann den Bildschirm nicht voll ausfüllen (es würden dann zwangsläufig schwarze Streifen am rechten und linken Rand des Bildschirms auftreten).

Was die Bildschirme angeht, so scheint sich der Trend in Richtung 16:9 zu bewegen; viele Laptops und Fernseher werden heute nur noch in diesem Format angeboten, was offenbar daran liegt, dass sich viele Menschen Videos in diesem Format auf ihrem Rechner angucken, anstatt daran zu arbeiten, wofür sich das Format 4:3 zumeist deutlich besser eignet. Interessanterweise sprechen sich jedoch viele Photographen gerade gegen dieses neue Format aus, was vermutlich unter anderem daran liegt, dass 16:9 ein Photo bereits ungewöhnlich breit erscheinen lässt.

Welches Format man bei der Aufnahme wählen kann, hängt von der Kamera ab. Es ist nur ein Sensor eingebaut. Die drei vorgestellten Formate (4:3, 16:9, 3:2) werden unterdessen von vielen Kompaktkameras angeboten. Bei professionelleren Modellen wird auf die Formatwahl meist verzichtet, man verläßt sich da im Bedarfsfalle auf die Nachbearbeitung und bietet für die Aufnahme nur ein Format an, welches dem eingebauten Sensor entspricht.

Ist eine Formatwahl vorhanden, ergibt sich nun die einfache Möglichkeit, dass die Bilder des Sensors passend am Rand abgeschnitten werden. Der Sensor kann jedoch auch gezielt größer gewählt werden und es wird dann jeweils nur ein an das Verhältnis angepasster Ausschnitt ausgelesen. Dies wird dann so organisiert, dass unabhängig vom Format ungefähr gleichviele Pixel für das Bild verwendet werden, variiert wird lediglich im Randbereich des Sensors, welche Pixel dafür verwendet werden.

Letztere Möglichkeit wird relativ selten umgesetzt, weswegen es meist sinnvoll ist, bei dem Format des Sensors zu bleiben und eine Optimierung des Aspektverhältnisses eines Bildes der Nachbearbeitung zu überlassen.

Es spricht im Grunde nichts gegen das klassische 4:3-Format. In diesem Buch werden wir im 4:3-Format bleiben.

-

4:3-Format (1,33:1)

-

3:2-Format (1,50:1)

-

16:9-Format (1,77:1)

Photoformate in der analogen Photographie

[Bearbeiten]In der analogen Photographie ging es zunächst weniger um das Seitenverhältnis, als vielmehr um die Größe des Films, da dieser ausschlaggebend dafür war, wie groß das resultierende Photo am Ende ist. Vor der Entwicklung der Kleinbildkamera entsprach die Größe des Films der Größe des später entwickelten Photos und man musste relativ große Filme verwenden, um einen einigermaßen großen Abzug zu erhalten. Um ein Bild der Größe 6 cm x 9 cm zu bekommen, ein zugegebener Maßen recht kleines Format, brauchte man immerhin einen Film, der 6 cm in der Höhe maß. Das wiederum erforderte ein relativ großes Kameraobjektiv und lange Brennweiten.

Typische Filmformate waren zunächst Mittelformate, die von Mittelformatkameras verwendet wurden. Bekannte Größen waren dabei 6 cm x 6 cm, 6 cm x 7 cm, 6 cm x 8 cm und 6 cm x 9 cm. Das kleinste Mittelformat war 4,5 cm x 6 cm. Das etwas sonderbar anmutende Format 6 cm x 6 cm (1:1) war dabei gar nicht so unüblich, wie man heute vielleicht vermuten würde. Das Bild war quadratisch und mit nur 6 cm x 6 cm Größe ziemlich klein. Weil Abbildungsfehler von Objektiven zum Rand hin größer werden, ist das quadratische Format in Hinsicht auf die Bildqualität sogar die optimale Wahl. Wer alte Photos im Familienalbum durchstöbert, wird eventuell noch solche Aufnahmen finden. Die Photos der Großformate waren oft 12,5 cm x 10 cm oder 25 cm x 12,5 cm. Hier ist das Verhältnis immerhin 1,25:1.

Später wurden dann die Kleinbildkameras eingeführt. Die Größe eines Photos war hierbei 36 mm x 24 mm, das Seitenverhältnis war also 1,5:1 und ähnelt damit etwa den heute gängigen Formaten (1,33:1, 1,5:1 und 1,77:1). Dieses auch als Kleinbildformat bekannte Format wurde zum Quasi-Standard und spielt selbst heute noch eine große Rolle, wie später bei der Diskussion der Brennweite gezeigt werden wird. Daneben gab es aber auch noch kleinere Formate, zum Beispiel das APS-Format mit 17 mm x 30 mm (Verhältnis 1,76:1) und das Halbformat mit 18 mm x24 mm.

Größe der Aufnahmefläche und Bildqualität

[Bearbeiten]Generell - also unabhängig davon, ob analog oder digital photographiert wird - kann mit einer großen Aufnahmefläche viel Licht gesammelt werden, tendenziell werden damit also die Bilder von Motiven besser, die größer als die Aufnahmefläche sind. Mit der Kantenlänge der Aufnahmefläche skaliert auch der Durchmesser des Objektivs, um wirklich bessere Bilder aufnehmen zu können. Ist das Motiv größer als der Objektivdurchmesser, skaliert die mit dem Objektiv sammelbare Lichtmenge mit dem Quadrat des Durchmessers. Wird viel Licht gesammelt, so kann das Rauschen im Bildergebnis niedrig gehalten werden. Ferner ist es sehr aufwendig, Objektive zu bauen, bei denen der Durchmesser, der zur Belichtung beiträgt, viel größer ist als der Durchmesser der Aufnahmefläche (Film oder Sensor). Vereinfacht gesagt skaliert also die mögliche Aufnahmequalität mit der Kantenlänge der Aufnahmefläche.

Das Volumen und damit das Gewicht der Ausrüstung steigt allerdings ungefähr mit der dritten Potenz der Kantenlänge der Aufnahmefläche, bei einer doppelten Kantenlänge steigt also das Gewicht ungefähr auf das Achtfache an. Damit ist gut zu erklären, warum Mittelformatkameras heute vorrangig in Studios verwendet werden und das Kleinbildformat einen guten Kompromiß zwischen Aufwand und Bildergebnis darstellt, Bilder von Kameras in Mobiltelephonen mit winzigem Sensor und Objektiv aber oft erbärmlich verrauschte Aufnahmen liefern, dafür aber nicht nennenswert zum Gewicht des Mobiltelephons beitragen.

Die Bilddatei

[Bearbeiten]Grundlagen

[Bearbeiten]Das digitale Photo wird als Bilddatei auf der Kamera abgespeichert und kann damit sofort auf einen Rechner übertragen und von diesem gelesen werden. Von Laien werden Photos besonders von Kompaktkameras oft im JPEG/JFIF-Format gespeichert, es gibt aber auch einige andere Formate, die manche Kameras anbieten.

Auflösung

[Bearbeiten]Als Auflösung oder Auflösungsvermögen werden in der Physik oder in der Optik Größen bezeichnet, die bestimmen, welche benachbarten Details mit einem Gerät noch getrennt dargestellt werden können, man sagt dann auch aufgelöst werden können.

Die zur Auflösung in der Photographie beitragenden Komponenten sind vor allem das Objektiv, die Blende und das Filmmaterial, beziehungsweise der Sensor. Die Auflösung eines Bildes hängt somit nicht allein an der Bilddatei, sondern an der gesamten Ausrüstung, mit welcher das Bild aufgenommen wurde.

Abbildungsfehler im Objektiv sorgen dafür, dass Objekte in der Schärfeebene nicht exakt punktförmig abgebildet werden. Bei einer kleinen Blendenöffnung kommt es zu Beugungseffekten. Statt der punktförmigen Abbildung wird ein Beugungsscheibchen abgebildet.

Bei analogem Filmmaterial ist der entscheidende Faktor die Korngröße des lichtempfindlichen Materials, bei digitalen Sensoren sind es die Pixel. Dabei ist zu beachten, dass bei den meisten Farbsensoren benachbarte Pixel unterschiedlich empfindlich auf verschiedene Farben sind. Zudem kann es zwischen den Pixelreihen des Sensors auch Platz für Leitungen und sonstige Elektronik geben, die kein Licht empfangen. Dies hat nicht nur negative Auswirkungen auf die Empfindlichkeit der Kamera, sondern kann bei bestimmten Motiven einerseits die Auflösung erhöhen, bei anderen Motiven andererseits aber auch dazu führen, dass Details komplett ignoriert werden, statt sie nur aufgrund mangelnder Auflösung unscharf darzustellen.

Bei gleichfarbigen Objekten ist die Auflösung also schlechter als ein Pixel, ansonsten ist der Pixel aber jedenfalls ein charakteristisches Maß für die Auflösung des Sensors. Die Anzahl der Pixel kann man nun auf ein bestimmtes Maß beziehen, um einen brauchbaren Eindruck von der Auflösung zu bekommen. Sind die Abbildungsfehler des Objektivs oder die Beugungsscheibchen größer als die Pixelabstände, sind dies die entscheidenden Größen für die Auflösung.

Um die Auflösung von Sensor oder Kamera zu diskutieren, kann man die Anzahl der Pixel auf die Länge oder Breite des Sensors beziehen. In dem Falle wird etwa davon gesprochen, dass ein Sensor oder eine Kombination von Sensor und Objektiv eine bestimmte Anzahl von Linien auflösen kann, zum Beispiel 2000 Linien, was dann bedeutet, dass mit der Kombination ein Linienmuster formatfüllend aufgenommen und aufgelöst werden kann, welches aus 2000 schwarzen Linien auf weißem Grund besteht, wobei Liniendicke und Zwischenraum zwischen den Linien gleichgroß sind. Damit die Kombination von Objektiv und Sensor das hinbekommen können, kann man abschätzen, dass der Sensor mindestens 4000 Pixel in der Breite (senkrecht zu den Linien) haben sollte - unabhängig davon kann ein schlechtes Objektiv aber dazu führen, dass der Wert trotzdem nicht erreicht werden kann. Wird solch ein Linienmuster nicht aufgelöst, bekommt man statt des Musters auf dem Bild eine graue Fläche zu sehen. Sind die Linien ferner etwas schräg zum Sensor angeordnet, kann es auffällige Artefakte der Digitalisierung geben (Moiré-Effekt). Es wird dann also etwas anderes auf dem Bild dargestellt als das eigentliche Linienmuster als Motiv. Die bereits angesprochenen Lücken zwischen den Pixelreihen können bei solchen Strichmotiven allerdings auch zu einem höheren Kontrast führen und damit bei diesem Motiven zu einer höheren Auflösung im Bildergebnis, die man aber bei 'normaleren' Motiven nicht wirklich nutzen kann.

Eine andere Größe für die Auflösung kann mit Pixeln pro Längeneinheit angegeben werden, also etwa 12 Pixel pro Millimeter oder im alten englischen Maßsystem 300 Pixel pro Zoll (englisch: dots per inch, dpi, siehe oben). Charakteristisch ist dafür also offenbar der Abstand zweier Pixel auf dem Sensor. Sofern die Lücken zwischen den Pixeln vernachlässigbar klein sind (was oft nicht der Fall ist), ist die Pixelgröße eine ähnlich nützliche Angabe für die Auflösung. Besonders bei der Makrophotographie ist diese Auflösungsbezeichnung nützlich, weil da Vergrößerungen immer unabhängig von den Eigenschaften des Sensors und der Darstellung angegeben werden. Bei der späteren Darstellung kann man also mit Kenntnis des Pixelabstandes und der Vergrößerung bestimmen, wie groß das aufgenommene Objekt ist. Häufig ist aufgrund von Beugung an der Blende des Objektivs und anderen Einflüssen die Auflösung des Bildes besonders bei der Makrophotographie hingegen schlechter als der Pixelabstand, weswegen dort die Blende gezielt so eingestellt werden muß, daß die Beugung nicht größer als der Pixelabstand wird, um eine optimale Auflösung zu erreichen, diese liegt dann meist bei zwei oder drei Pixeln.

Die gesamte Anzahl der Pixel des Sensors ist hingegen kein genaues Maß für die Auflösung, es ist also mindestens anzugeben, wieviele Pixel für die Höhe und die Breite des Sensors vorliegen. Um die Information allgemein nützlich zu machen, ist zudem noch entweder der Pixelabstand oder Höhe und Breite des Sensors in Längeneinheiten wie Millimeter erforderlich.

Werbewirksam sinnlos vereinfacht wird teils trotzdem nur die Gesamtzahl der Pixel angegeben - oder bei Monitoren auch gerne die Bildschirmdiagonale ohne Angabe von Breite und Höhe oder Aspektverhältnis. Da gerade bei Kompaktkameras die Objektive sicherlich nicht immer die Grenzen der klassischen Optik ausloten werden, sagt diese Angabe nicht zwangsläufig viel über die tatsächliche Auflösung der Kombination von Sensor und Objektiv aus.

Ein Beispiel: Das Photo besteht aus 800 horizontalen Punkten und 600 vertikalen Punkten. Die Gesamtzahl der Pixel ist dann 800 * 600, also 480.000 Pixel oder 0,48 MP (1 MP = 1 Million Pixel, ein Megapixel).

Als ästhetisch zufriedenstellend wird ein dargestelltes digitales Bild meist empfunden, wenn das Auge zwei benachbarte Pixel nicht mehr auflösen kann, die Auflösung des Bildes also größer ist als die des Auges bei gegebenem Betrachtungsabstand. Dann ist die Digitalisierung des Bildes nicht mehr auffällig. Das Bild wirkt fließend. Ist wiederum die Auflösung des Objektivs deutlich schlechter als der Sensor und später das Auge auflösen können oder wird die Blende so weit zugezogen, dass Beugungseffekte relevant werden, so wirkt das Bild unscharf, unabhängig von der Digitalisierung des Bildes. Das Bild wirkt fließend, bietet aber trotzdem keine gute Auflösung des Motivs.

Daher spielt die Auflösung eine besonders große Rolle; ein Photo, das eine so geringe Pixelzahl hat, dass einzelne Bildpunkte noch gesehen werden können, wirkt sehr unschön (umgangssprachlich "verpixelt"). Ist die Auflösung des Objektivs viel schlechter als der Pixelabstand auf dem Sensor beziehungsweise die Auflösung des Auges bei der späteren Betrachtung oder sind Beugungseffekte deutlich größer als der Pixelabstand auf dem Sensor oder die Auflösung des Auges, wirkt das Bild unscharf.

Dabei ist zu beachten, dass eine zu niedrige Auflösung im Nachhinein nicht mehr behoben werden kann, auch nicht mit Bildbearbeitungsprogrammen. Daher sollte stets sichergestellt werden, dass mit ausreichend hoher Auflösung photographiert wird (beziehungsweise standardmäßig eine hohe Auflösung des Sensors eingestellt wird). Unschärfe oder Beugungseffekte können im Nachhinein auch nur in sehr engen Grenzen mit speziellen Filtern reduziert werden.

Je größer die Pixelzahl ist, umso größer wird dadurch die Bilddatei. Kleine Pixel erhöhen zudem meist den Rauschpegel der Bilder und vergrößern zusätzlich die Bilddatei durch Rauschartefakte. In der heutigen Zeit ist Speicherplatz jedoch relativ günstig; mit einer Speicherkarte mit der Kapazität von 8 GB und mehr, kann problemlos mit der größten Pixelzahl photographiert werden, ohne rasche Engpässe befürchten zu müssen.

Die nachfolgende Tabelle stellt einige bekannte Pixelgrößen von Sensoren vor und die dazugehörigen Abmessungen des Photos in cm bei einer Druckauflösung von 300 dpi.

| Bezeichnung | Breite mal Höhe in Pixeln | Pixelzahl | Abmessung in cm (300 dpi) |

|---|---|---|---|

| 160 x 120 | 19.200 | 1,3 x 1,0 | |

| 320 x 240 | 76.800 | 2,7 x 2,0 | |

| 0,3 MP | 640 x 480 | 307.200 | 5,4 x 4,0 |

| 0,5 MP | 800 x 600 | 480.000 | 6,7 x 5,8 |

| 0,8 MP | 1024 x 768 | 786.432 | 8,6 x 6,5 |

| 1,0 MP | 1152 x 864 | 995.328 | 9,7 x 7,3 |

| 1,3 MP | 1290 x 960 | 1.238.400 | 10,9 x 8,1 |

| 2,0 MP | 1600 x 1200 | 1.920.000 | 13,5 x 10,1 |

| 3,0 MP | 2048 x 1536 | 3.145.728 | 17,3 x 13,0 |

| 4,0 MP | 2272 x 1704 | 3.871.488 | 19,2 x 14,4 |

| 5,0 MP | 2592 x 1944 | 5.038.848 | 21,9 x 16,4 |

| 8,0 MP | 3264 x 2448 | 7.990.272 | 27,6 x 20,7 |

| 10,0 MP | 3648 x 2736 | 9.980.928 | 30,8 x 23,1 |

| 12,0 MP | 4000 x 3000 | 12.000.000 | 33,8 x 25,4 |

- Hinweise

- Je größer die Auflösung ist, umso mehr kann auch ein Photo vergrößert werden, ohne dass es dabei verpixelt wirkt. Umso mehr Details bleiben also erhalten.

- Mit größeren Druckformaten (z.B. A4 oder A3) kann oft der dpi-Wert gesenkt werden, weil große Bilder meist mit größeren Betrachtungsabstand angesehen werden, das Auflösungsvermögen des menschliches Auges hängt ja ebenfalls vom Betrachtungsabstand ab. So lässt sich ein 12-MP-Photo auch problemlos im A3-Format, gegebenenfalls auch A2-Format drucken. Für Formate unterhalb von A4 sollte aber der Richtwert von 300 dpi eingehalten werden.

- Hinweis: Beim Beschneiden des Photos wird auch die Anzahl der verbleibenden Pixel reduziert. Vor dem Speichern sollte dabei stets sichergestellt werden, dass nach dem Schneidevorgang immer noch eine ausreichende Pixelzahl vorhanden ist.

Dateiformate

[Bearbeiten]Einführung

[Bearbeiten]Die meisten einfachen digitalen Kameras verwenden standardmäßig das JPEG/JFIF-Format zur Speicherung der Photos (JPEG/JFIF: Joint Photographic Experts Group File Interchange Format). Dieses Format hat eine hohe Verbreitung, wird von jedem Photoverarbeitungsprogramm interpretiert und bietet eine relativ gute Qualität. Bei der Speicherung des Bildes beinhaltet das JPEG/JFIF-Format jedoch immer eine verlustbehaftete Kompression, es geht also Information bei der Speicherung unwiederbringlich verloren. Manche Kameras bieten daher auch das TIFF-Format an (Tagged Image File Format). Hochwertige Kameras bieten meist statt TIFF ein eigenes Format an, welches für den Kamerahersteller spezifisch ist. Damit können die Bildinformationen des Sensors verlustfrei abgespeichert werden. Diese Formate sind für jegliche Art der Nachbearbeitung zu empfehlen.

Die Bitmap

[Bearbeiten]Noch bis vor etwa einem Jahrzehnt war die Bitmap (bmp) das gängige Format zum Speichern von Bildern (Windows Bitmap; device-independent bitmap). Es war ein recht einfaches, verlustfreies Format, das jedes einzelne Pixel separat mehr oder weniger ohne Kompression gespeichert hat. Bitmaps gibt es in unterschiedlicher Farbauflösung (etwa 8 Bit, 16 Bit, 24 Bit, 32 Bit). Da zum Photographieren mindestens 24 Bit notwendig scheinen (also theoretisch rund 8 Millionen Farben) und 24 Bit immerhin 3 Byte entsprechen, hat jedes gespeicherte Pixel einen Speicherbedarf von 3 Byte. Ein Photo mit der eher geringen Pixelzahl von 2 MP hat damit also 6 MB Speicher in Anspruch genommen. Bei 12 MP wären es immerhin schon 36 MB. Das ist sehr sperrig, zumal die Speicherkapazitäten damals noch ziemlich gering waren; eine übliche Speicherkarte bot oft nur 128 oder 256 MB. Digitalkameras bieten daher das Bitmap-Format nicht an.

JPEG/JFIF

[Bearbeiten]Das bereits zu Beginn der 90er Jahre vom Fraunhofer Institut entwickelte JPEG-Format (jpg, jpeg; Joint Photograph Expert Group) bietet eine adäquate Lösung zu dem Speicherproblem. Durch spezielle Kompressionstechniken konnte die Bildgröße enorm gesenkt werden (zum Beispiel von 6 MB auf 250 KB). Ein Nachteil, der sich bei solchen Kompressionsverfahren immer einstellt, ist ein Verlust an Qualität. Da JPEG-Bilder nicht mehr die Informationen über einzelne Pixel speichern, sondern zusammenhängende Bereiche des Bildes (Blöcke) als Einheit betrachten und dann beim Laden beziehungsweise Anzeigen des Bildes die einzelnen Pixel rekonstruieren, können insbesondere an Farbübergängen und Kanten gewisse Störungen auftreten. Man kann die Kompression jedoch beim JPEG-Format einstellen; eine niedrige Kompression ermöglicht eine bessere Qualität als eine höhere, fordert dafür aber auch mehr Speicherplatz. Zudem ist der Qualitätsverlust meist nur auf Pixelebene zu sehen; wenn man mit ausreichend großer Pixelzahl photographiert, braucht man keine formatbehafteten Qualitätsstörungen befürchten. Oft ist allerdings die Bildinformation pro Pixel bei modernen Sensoren größer als mit JPEG abgespeichert werden kann, von daher treten auch hier Informationsverluste auf, die sich besonders bemerkbar machen, wenn Bilder mit starken Kontrasten aufgenommen werden.

Beim JPEG-Format wird das Bild in Blöcke von jeweils 8x8 Pixeln aufgeteilt. Diese werden dann jeweils komprimiert und es werden zusammenhängende Informationen zu den einzelnen Blöcken annotiert. Unter Anwendung zahlreicher mathematischer Verfahren kann somit die Größe drastisch reduziert werden. Kameras bieten oft auch eine Qualitätseinstellung an (meist Normal, Fein und Super-Fein). Obwohl die normale Qualität oft ausreichend ist, kann also eine niedrigere Kompression verwendet werden, welche die Qualität erhöht (aber eben auch den Speicherbedarf).

TIFF-Format

[Bearbeiten]Einige Kameras bieten neben dem JPEG-Format auch das TIFF-Format (tif, tiff; Tagged Image File Format) an, welches Bilder meistens komprimiert aber verlustfrei abspeichert. Bilder im TIFF-Format sind damit auch um einiges größer als im JPEG-Format, so dass das Format nur bei hohen Qualitätsanforderungen angemessen scheint, die sich etwa ergeben, wenn das Bild nachbearbeitet werden soll. Insbesondere im Verlagswesen und in Druckereien wird mit dem TIFF-Format gearbeitet, da hier eine sehr hohe Qualität zum sauberen Drucken gefordert ist.

RAW-Formate

[Bearbeiten]Die RAW-Formate sind eine Art "digitales Negativ". Jeder Kamerahersteller bietet meist ein eigenes Format an. Es gibt zwar Bemühungen zur Standardisierung, die sich bislang aber leider nicht durchgesetzt haben (DNG, digitales Negativ).

In diesen Dateiformaten wird kein direktes Bild erstellt, das sich sofort ansehen lässt, stattdessen werden die Rohdaten gespeichert, die der Bildsensor bei der Aufnahme erfasst. Bilder in einem RAW-Format muss man mit einem speziellen Programm öffnen, das oft zu der Kamera mitgeliefert wird. Die Formate bekannterer Hersteller sind jedoch entschlüsselt, können also auch mit unabhängigen Programmen dekodiert und nachbearbeitet werden.

Bilder in solchen Rohformaten dienen meist der Nachbearbeitung, weil sie noch die komplette Bildinformation des Sensors enthalten. Während die als JPEG abgespeicherten Ergebnisse meist mit mehr oder weniger leistungsfähigen Prozessoren direkt in der Kamera aus den Rohdaten erzeugt werden, wobei diverse Korrekturen und Filter angewendet werden, werden RAW-Dateien zumeist ohne weitere Manipulation oder Korrektur durch den Prozessor der Kamera abgespeichert. Manipulationen und Korrekturen werden dann dem Photographen selbst in der Nachbearbeitung überlassen. Die Ergebnisse der Nachbearbeitung lassen sich dann in andere Formate konvertieren (etwa JPEG, DNG, PNG etc). Die RAW-Formate zeichnen sich dadurch aus, dass sie für die digitale Nachbearbeitung eine Vielzahl an Möglichkeiten bieten, weil sie die Sensorinformation verlustfrei speichern, welches andere Formate ("fertige Bilder") nicht bieten. Bilder im RAW-Formaten benötigen sehr viel Speicherplatz, selbst eine verlustfreie Kompression wird nicht unbedingt bei der Speicherung in der Kamera vorgenommen. Der Umgang mit den RAW-Formaten erfordert allerdings etwas Erfahrung. Für den Einsteiger ist das kleine, einfache JPEG-Format daher meist geeigneter, auch weil die Kamera bei der Erzeugung des JPEG bereits versucht, bekannte Abbildungsfehler des Objektivs (auf Kosten höheren Rauschens oder reduzierter Auflösung) zu kompensieren. Bei suboptimalen Bildergebnissen stellt sich allerdings recht schnell das Bedürfnis ein, Bilder nachbearbeiten zu wollen, weswegen es sich von Anfang an lohnt, neben den JPEG-Bildern die Rohdaten auf einer entsprechend größeren Speicherkarte gleich mit abzuspeichern, um später im Bedarfsfalle darauf zurückgreifen zu können oder diese dann auch zu löschen, wenn die JPEGs ausreichen.

Andere Formate

[Bearbeiten]Zwei weitere bekannte Bildformate sind GIF und PNG. Diese werden vor allem im Netz verwendet. Digitalkameras bieten sie nicht an. Der Vollständigkeit halber seien sie hier jedoch mit erwähnt.

GIF (Graphic Interchange Format) ist ein Format, das nur eine Farbpalette mit maximal 256 Farben verwenden kann. Das Format bietet eine bedingt durch das Alter des Formates recht einfache verlustfreie Komprimierung. Mit 256 Farben lassen sich jedoch keine Photos in ausreichender Qualität darstellen. Darum werden Kameras niemals das GIF-Format anbieten. GIF wird eher im Netz für Navigationselemente (zum Beispiel Knöpfe) verwendet, wo man mit 256 Farben meist problemlos auskommt. Im letzten Jahrhundert war GIF auch wegen einer Erweiterung beliebt als einfaches Videoformat ('animierte GIFs').

PNG (Portable Network Graphics) ist ein Format, das GIF zunehmend abgelöst hat. Es ist bietet eine effektivere verlustfreie Kompression an und neben den bereits von GIF bekannten Farbpaletten bietet es eine Farbtiefe von 24 oder gar 48 Bit. Da es sich zudem um ein internationales Standardformat handelt, eignet es sich von daher auch gut, um die hochauflösenden Rohdaten zu archivieren, wenn man sich nicht darauf verlassen mag, dass die herstellerspezifischen Formate in einigen Jahrzehnten noch dekodierbar sind. Einmal abgesehen von den zwangsläufigen einmaligen kleinen Konversionsverlusten hat man mit Photos, die nach PNG konvertiert werden, also eine ideale Kombination von verlustfreier, effizienter Kompression mit einem vom Hersteller unabhängigen internationalen Standard, der voraussichtlich noch sehr lange Zeit lesbar sein wird.

Aufgrund der verlustfreien Kompression sind die Bilder meist deutlich größer als jene, die mit JPEG komprimiert sind. Im Vergleich zu GIF hängt der Größenunterschied vor allem davon ab, in welchem Modus man PNG abspeichert. Bei gleicher Wahl einer Farbpalette wie beim Vergleichs-GIF sollte das moderne Kompressionsverfahren von PNG meist kleinere Dateien bei gleicher Qualität bieten oder eben bei einem anderen Modus bessere Qualität bei größeren Dateien.

PNG eignet sich wie GIF ansonsten eher für Computergraphik, die heute allerdings zunehmend mit Vektorgraphik (SVG) realisiert wird. Die Kompression ist recht effektiv bei Bildern, die größere Bereiche gleicher Farbe aufweisen, wie es bei Computergraphik oft der Fall ist - auf diese Weise bleiben sie von den Speicherbedarf her relativ klein. Da dies bei Photos nicht der Fall ist, würde das PNG-Format zu sehr großem Speicherbedarf führen, aber vermutlich etwas effektiver als die Rohdatenformate der Hersteller, die bei Verwendung eines Standards aber ein Mittel der Kundenbindung verlieren würden, daher wird PNG von den Herstellern nicht verwendet.

Farben

[Bearbeiten]Einleitung

[Bearbeiten]Bis in die Mitte des 20. Jahrhunderts gab es, technisch bedingt, ausschließlich Schwarz-Weiß-Photos (eigentlich Grauwerte). Mit der Erfindung des Farbfilms in den 30er und 40er Jahren schwenkte die Photographie in relativ kurzer Zeit zur Farbphotographie um, wobei Schwarz-Weiß-Photographie noch immer praktiziert wird und oft einen ganz eigenen künstlerischen Charme besitzt.

Dennoch werden die meisten Photos heute in Farbe aufgenommen. Ein farbiges Photo wirkt realistischer und Farben haben stets ihre ganz besondere Wirkung. Neben dem Motiv und der Komposition, spielen Farben vermutlich die wichtigste Rolle in einem Photo und sollen in diesem Abschnitt näher erläutert werden.

Filme oder Sensoren, die nur Grauwerte aufnehmen, haben zudem meist eine bessere Auflösung oder eine deutlich höhere Empfindlichkeit als Aufnahmematerial für farbige Bilder. Bei digitalen Kameras ist in dem Zusammenhang also zu beachten, dass diese meistens spezielle Filter einsetzen, um mit dem Sensor Farbbilder aufnehmen zu können. Dies kostet sowohl Auflösung als auch Empfindlichkeit. Sensoren, die nur Helligkeitsunterschiede aufnehmen können, sind bei ansonsten gleicher Pixelzahl und -größe also deutlich günstiger herzustellen, haben eine höhere Auflösung und eine deutlich größere Empfindlichkeit als Sensoren für Farbbilder. Zwar kann man die Bilder letzterer Sensoren auch nachträglich oder gleich in der Kamera in Grauwertbilder konvertieren, kann damit aber natürlich die Verluste an Empfindlichkeit und Auflösung nicht wieder rückgängig machen.

Die Entstehung der Farben

[Bearbeiten]

Die Sonne strahlt permanent Licht aus, wobei Sonnenlicht (und allgemein weißes Licht) aus einer Überlagerung von Lichtwellen unterschiedlichster Wellenlängen besteht. Die Wellenlänge ist, wie der Name schon sagt, eine Längenangabe und wird in Nanometer (nm) angegeben. Es gilt dabei: . Wie immer bei Wellen kann man auch eine Frequenz angeben, also im Wesentlichen Wellen pro Zeiteinheit. Im Rahmen der Quantenmechanik läßt sich auch jeder Frequenz eine Energie zuordnen, die proportional zur Frequenz ist und damit umgekehrt proportional zur Wellenlänge.

Beim weißen Licht sind die verschiedenen Wellenlängen zunächst vermischt. Lässt man es jedoch durch ein Prisma fallen, so wird das Licht gemäß der verschiedenen Wellenlängen aufgetrennt. Zu jeder Wellenlänge gibt es also einen etwas anderen Austrittswinkel des Lichtes aus dem Prisma. Man sagt auch, das Licht wird räumlich dispergiert, was zuvor vermischt war, läßt sich nun auf einem Schirm nebeneinander betrachten. So wird sichtbar, was als Farben bezeichnet wird. Farbe in dem Sinne ist eine physiologische Wahrnehmung, hervorgerufen durch Rezeptoren im Auge - verschiedene Lebewesen haben unterschiedliche Rezeptortypen, daher auch eine unterschiedliche Farbwahrnehmung. Die objektive Maße sind immer Wellenlänge, Frequenz und Energie.

Beispielsweise erscheinen den meisten Menschen Lichtwellen der Länge 400 nm violett, Wellen der Länge 700 nm erscheinen rot. Das 'normale' menschliche Auge kann dabei Wellenlängen zwischen 380 und 800 nm wahrnehmen, alles was darüber oder darunter liegt ist für das menschliche Auge nicht mehr sichtbar. Die Wellen zwischen 380 und 800 nm, welche wir als Farben wahrnehmen können, sind die uns bekannten Regenbogenfarben, einschließlich aller dazwischenliegenden Abstufungen. Diese Farben heißen auch Spektralfarben. Das menschliche Auge hat jedoch nur Sinnesreize oder Rezeptoren für die Farbbereiche rot, grün und blau; die anderen Farbeindrücke errechnet das Gehirn aus der Mischung dieser drei Rezeptorwerte (aus dem Anteil an rot, grün und blau errechnet es einen Farbeindruck).

Jeder Wellenlänge zwischen 380 und 800 nm kann somit einer Farbe zugeordnet werden. Folgende Farben haben die einzelnen Wellenlängen:

- 380 nm bis 400 nm: blau-violett

- 400 nm bis 470 nm: blau

- 470 nm bis 560 nm: grün

- 560 nm bis 600 nm: gelb

- 600 nm bis 630 nm: orange

- 630 nm bis 800 nm: rot

Blau wird dabei auch als kurzwelliges Licht, grün als mittelwelliges und gelb/orange/rot als langwelliges Licht bezeichnet.

Der Farbeindruck kann dabei nach Beschaffenheit und Alter des Auges des menschlichen Betrachters etwas unterschiedlich sein, ebenso die Grenzen des sichtbaren Bereiches, der wiederum auch von der Intensität der Strahlung abhängt. Besonders wenn Licht unterhalb von 400 nm auf Material wie Papier oder weiße Farbe trifft, kann sich die Wellenlänge des vom Material zurückgeworfenen Lichtes ändern, mehr zu längeren Wellenlängen hin, weswegen das Licht oft einheitlich blau wirkt. Während die Zuordnung nach Wellenlängen eine meßbare Größe ist, sind die Namen und Farbeindrücke spezifisch für menschliche Augen. Andere Lebewesen können etwas anders funktionierende Augen haben und haben daher keinen oder einen anderen Farbeindruck. Auch der Sensor der digitalen Kamera oder das Filmmaterial kann andere Empfindlichkeitsbereiche haben. Teilweise werden Filter eingesetzt, um unerwünschte Wellenlängenbereiche herauszufilten, um mit der Kamera einen Farbeindruck ähnlich dem des menschlichen Auges zu erreichen.

Natürlich verlaufen die Farbwerte fließend. Licht der Wellenlänge 400 nm ist ein Blau das eher in Richtung violett tendiert; Licht der Wellenlänge 470 nm ist eher schon ein Blaugrün. Es lässt sich damit erkennen, dass diese Wellenlängen dem allgemein bekannten Farbkreis entsprechen (beziehungsweise der Farbkreis auf den Farbwerten der Wellenlängen aufbaut). Andere wird diese Abstufung an einen Regenbogen erinnern – ein Regenbogen ist im Grunde nichts anderes, als Licht, das durch Prismen (die Regentropfen) strahlt und somit in seine Spektralfarben zerfällt.

Es sei noch erwähnt, dass es auch Lichtwellen unter 380 nm und über 800 nm gibt. Diese kann das menschliche Auge nicht sehen. Lichtwellen unter 380 nm werden als Ultraviolett bezeichnet (kurz UV), Lichtwellen über 800 nm als Infrarot (kurz IR). Ultraviolettes Licht läßt sich leicht in sichtbares Licht konvertieren, das passiert mit sogenannten optischen Aufhellern, die heute oft in Papier und Waschmitteln zu finden sind, aber auch in speziellen Farben oder als Leuchtstoff in Leuchtstoffröhren oder weißen LEDs. Spezielle Farben werden mit Verwendung von ultravioletten Lampen teils für spezielle Effekte genutzt (Stichwort: Schwarzlicht).

Trifft Licht auf einen Gegenstand, zum Beispiel eine Tomate, so kann mit den jeweiligen Lichtwellen folgendes passieren:

- Sie können von dem Gegenstand reflektiert (zurückgeworfen) werden.

- Sie können von dem Gegenstand absorbiert (aufgenommen) werden. Absorbiertes Licht wird meist wieder (in einer anderen Wellenlänge) emittiert (ausgesendet)

- Sie können gestreut (abgelenkt) werden

- Sie können durch den Gegenstand hindurchdringen.

Bei realen Objekten tritt praktisch immer eine Mischung aller Möglichkeiten auf. Wenn Objekte anderweitig mit Energie versorgt werden, können sie auch selbst Licht erzeugen und aussenden, was man etwa von Lampen kennt.

Der letzte Fall der Durchdringung bezeichnet einen Spezialfall; hier ist der Gegenstand durchsichtig (zum Beispiel Glas oder Luft). Wir wollen diesen Fall für die Farbwahrnehmung aber vernachlässigen, da er im Grunde nichts dazu beiträgt. Wie am durchsichtigen Prisma sichtbar, können durchsichtige Materialen gleichwohl das Licht dispergieren, was bei bestimmten Objekten auch auftreten kann, wenn sie Licht reflektieren, man denke etwa an CDs oder dünne Ölfilme auf einer Wasserfläche.

Wenn das Licht reflektiert wird, dann wird es für uns sichtbar und eine Lichtquelle wird im Gegenstand als Spiegelbild erkennbar.

Auf die bereits erwähnte Tomate fällt also das gesamte Sonnenlicht mit all seinen verschiedenen Wellenlängen. Die Tomate absorbiert das meiste Licht. Ein kleiner Reflex ist auf der Oberfläche der glatten Schale jedoch meist erkennbar. Ansonsten erscheint die reife Tomate rot. Ein großer Teil Licht wird absorbiert und es wird hauptsächlich als für uns nicht sichtbares infrarotes Licht ausgesendet. Teile des Lichtes werden auch gestreut, was gut erkennbar ist, wenn man durch eine dünne Tomatenscheibe guckt. Im Fleisch der Tomate wird das Licht vielfach gestreut, der rote Anteil, der nicht so absorbiert wird, tritt irgendwo wieder aus der Tomate aus. Einmal abgesehen von dem schwachen Reflex an der Schale gibt es also kein Bild der Lichtquelle und der Umgebung, sondern ein rotes Objekt. Hat die Lichtquelle hingegen etwa nur blaues Licht, so bleibt nahezu nur der schwache Reflex an der Oberfläche und die Tomate erscheint nicht rot.

Die Farbe eines Gegenstandes entsteht also aus den Farbwerten der Lichtwellen, welche reflektiert werden oder durch Streuung und Emission wieder aus dem Gegenstand austreten. Falls der Gegenstand mehrere Farben reflektiert, so entsteht der Farbeindruck aus der Mischung der Farben. Man nennt dies auch additive Farbmischung. Ein Gegenstand, der die roten und grünen Wellenlängen zu gleichen Mengen reflektiert, erscheint gelb, da die additive Mischung aus grün und rot gelb ergibt. Solch ein Gegenstand ist dann nicht wirklich gelb, was einem anderen Wellenlängenbereich zwischen rot und grün entspricht, aber das menschliche Auge kann den Unterschied nicht erkennen, ein geeignetes Meßinstrument schon, wie man den Unterschied etwa auch erkennen kann, wenn man das Licht wieder durch ein Prisma in seine Bestandteile aufteilt. Das menschliche Auge hat drei verschiedene Sorten von Rezeptoren für farbliches Sehen, eine ist besonders für blau empfindlich, eine für grün, eine für rot. Die Empfindlichkeit eines Rezeptors erstreckt sich aber auch mit geringerer Empfindlichkeit über die benachbarten Bereiche. Der Farbeindruck wird im Gehirn zusammengesetzt aus den relativen Intensitäten der unterschiedlichen Rezeptoren, daher ist Rot+Grün nicht von intensivem Gelb zu unterscheiden.

Schwarze Gegenstände absorbieren das meiste Licht, das heißt, fast kein sichtbares Licht tritt wieder aus solch einem Gegenstand aus. Da Licht eine Energiequelle darstellt, geht dann fast die gesamte Energie in den Gegenstand über; das ist der Grund, warum sich schwarze beziehungsweise dunkle Gegenstände im Sonnenlicht stark aufwärmen. Sie senden infrarotes Licht aus. Spiegel hingegen absorbieren kaum Lichtstrahlen; sie reflektieren so gut wie alle Wellenlängen zwischen 380 und 800 nm und wärmen sich im Sonnenlicht daher weniger auf (oder nur wenig, denn natürlich können Wellenlängen unter 380 nm oder über 800 nm absorbiert werden - die tragen aber nicht zur Farbwahrnehmung bei). Weiße Gegenstände absorbieren auch kaum Licht, dies wird hauptsächlich an der unregelmäßigen Oberfläche oder kurz darunter gestreut, anders als beim Spiegel ist die Lichtquelle so nicht im weißen Gegenstand erkennbar.

Zum besseren Verständnis seien hier hoch die Entstehung ausgewählter Farben zusammenfassend erläutert:

- Kräftiges rot: Alle Wellen außer rot werden absorbiert, rot wird reflektiert, gestreut oder ausgesendet.

- Kräftiges blau: Alle Wellen außer blau werden absorbiert, blau wird reflektiert, gestreut oder ausgesendet.

- Kräftiges gelb: Der Fall ist für das menschliche Auge nicht eindeutig, entweder von dem Gegenstand wird gelbes Licht

reflektiert, gestreut oder ausgesendet oder rotes und grünes.

- Dunkelrot: Rot wird teilweise reflektiert, gestreut oder ausgesendet und teilweise absorbiert, der Rest wird vollständig absorbiert.

- Rosa (helles rot): Rot wird vollständig reflektiert, gestreut oder ausgesendet, aber nicht die anderen Farben, diese werden teils auch absorbiert.

- Lila/Violett: In der Praxis handelt es sich meist um eine Mischung von rotem und blauem Licht, der grüne Anteil fehlt. Ein kräftiges violett ist für das menschliche Auge mit Wellenlängen unter 400 nm meist nicht erreichbar.

- Schwarz: Alle Farben werden vollständig absorbiert.

- Weiß: Alle Farben werden vollständig reflektiert, gestreut oder ausgesendet, nichts wird absorbiert.

- Grau: Alle Farben werden im gleichen Maß teilweise reflektiert, gestreut oder ausgesendet und teilweise absorbiert.

Spezielle Filter können auch so mit Material beschichtet sein, dass sie je nach Einfallsrichtung bestimmte Wellenlängenbereiche reflektieren und den Rest durchlassen oder umgekehrt, das ist eine weitere Möglichkeit, wie sich der Farbeindruck verändern kann, je nachdem, und unter welchem Winkel man solch einen Filter betrachtet und ob durchgelassenes oder reflektiertes Licht betrachtet wird, ist der Farbeindruck vom betrachteten Gegenstand also ein komplett anderer.

Tipp: Man kann die Entstehung von Farben mit Computerprogrammen problemlos simulieren, da die Farbmischung am Computer (RGB beziehungsweise additive Mischung) dem des menschlichen Auges entspricht.

In fast allen Photobearbeitungs- und Zeichenprogrammen, bereits in Paint von Microsoft, gibt es Menüs, wo die Farbe per RGB-Wert festlegt werden kann.

Hierbei wird jeder der drei Farben rot, grün und blau ein Wert von 0 bis 255 zugewiesen.

Wie eben erläutert, ist 0 vergleichbar damit, dass kein Anteil in dieser Farbe vorhanden ist; 255 bezeichnet die mit dem Monitor maximal erzielbare Intensität.

(255, 0, 0) ist also ein kräftiges rot, (0, 0, 0) ist schwarz und (255, 255, 255) ist weiß, da alle Farbbereiche maximal gestellt sind.

Möchte man wissen, was passiert, wenn ein Gegenstand rot zu 30 % aussendet, grün zu 50 % und blau zu 100 %, so muss man etwa den Wert (80, 128, 255) eingeben.

Es kommt ein sanftes Blau heraus, das zum Hellblau tendiert.

Wenn man dies mit bunten Lichtquellen und realen Objekten probiert, hängt es von den Eigenschaften dieser Objekte ab, ob diese Farbmischung wie gewünscht funktioniert. Hat man etwa ein wirklich gelbes Objekt und bestrahlt es präzise mit rotem und grünem Licht, kann es komplett dunkel bleiben. Meist können reale Objekte aber breite Farbbereiche aussenden, so dass solche Objekte dann doch wieder schwach gelb erscheinen werden.

Farbmischung und Farbdefinition

[Bearbeiten]Grundlagen der Farbmischung

[Bearbeiten]Wenn es um Farbmischung geht, unterscheidet man für gewöhnlich die additive Farbmischung und die subtraktive Farbmischung. Das liegt daran, dass man die Farbmischung aus zwei verschiedenen Blickwinkeln betrachten kann, einmal als Mischung von ausgesendetem Licht und einmal als Mischung von Substanzen. Die beiden Methoden werden in diesem Abschnitt vorgestellt, ebenso der HSV-Farbraum zur Definition von Farben.

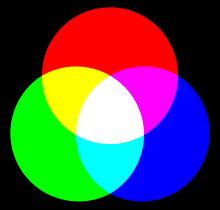

Additive Mischung – RGB

[Bearbeiten]

Wie bereits erwähnt, entsteht die Farbe eines Gegenstands aus der Mischung der Lichtwellen, die von dem Gegenstand ausgesendet werden (warum ein Gegenstand bestimmte Farben reflektiert, streut, aussendet oder absorbiert, geht auf seine Beschaffenheit und Oberfläche zurück). Das menschliche Auge nimmt diese vom Gegenstand ausgehenden Lichtwellen wahr und ermittelt auf diese Weise einen Farbeindruck des Gegenstands. Man nennt dies additive Farbmischung, manchmal auch physiologische Farbmischung. Es ist die Farbmischung wie sie im Auge und Gehirn geschieht bzw. physisch-biologisch bedingt ist. Je mehr Licht ein Gegenstand aussendet, umso heller erscheint er.

Die additive Farbmischung wird vor allem in der Computer- und Fernsehtechnik und somit auch in der Digitalkameratechnik angewendet. Hierbei arbeitet man mit den drei Grundfarben Rot, Grün, Blau (RGB), da nur 3 der 6 Spektralfarben notwendig sind, um jeden beliebigen Farbeindruck mischen zu können. Bei der 24-Bit-Farbtiefe hat jede Farbe einen Farbraum von 8 Bit, also 256 Stufen. Rot, Grün und Blau können also jeweils einen Wert zwischen 0 und 255 annehmen. 0 heißt dabei, es wird kein Licht dieser Farbe ausgesendet (schwarz), 255 heißt, der Wert wird mit voller Intensität ausgestrahlt (voller Wert). Der RGB-Wert (255, 0, 0) liefert somit ein natürliches, kräftiges rot, während (150, 0, 0) ein dunkles rot und (50, 0, 0) ein sehr dunkles rot liefern. Der RGB-Wert (255, 255, 0) besagt, dass rot und grün mit maximaler Intensität ausgesendet werden. Die Mischung aus rot und grün ergibt ein kräftiges Gelb. Der RGB-Wert (120, 120, 0) besagt, dass rot und grün nur mit mittlerer Intensität ausgesendet werden. Die Farbe ist damit ein dunkleres Gelb, das auch als ocker bezeichnet wird.

Subtraktive Mischung - CMY/CMYK

[Bearbeiten]

Die Subtraktive Mischung spielt vor allem im Druckgewerbe aber auch in der Malerei eine große Rolle. Hierbei werden die Farben durch Mischen der drei Grundfarben Cyan, Magenta, Gelb gemischt (manchmal auch: Blau, Rot, Gelb). Entsprechend heißt das Farbmodell auch CMY-Modell. Manchmal wird als weiterer Parameter ein Key-Wert mit betrachtet, welcher einen bestimmten Schwarzanteil darstellt, um den Farben eine bessere Tiefe geben zu können. Dieses Farbmodell heißt dann auch CMYK-Modell (für Cyan, Magenta, Yellow und Key, wobei Key den Schwarzanteil bestimmt).

Anders als bei der additiven Farbmischung, wo der Farbeindruck durch die Mischung aus ausgesendeten Lichtwellen unterschiedlicher Länge geschieht, entsteht die subtraktive Farbmischung aus der Mischung unterschiedlicher Substanzen, so wie eben im Druckgewerbe Farben durch Mischen unterschiedlicher Farbsubstanzen entsteht. Jede Farbsubstanz emittiert oder absorbiert dabei einen bestimmten Anteil an Lichtwellen. Rote Farbe sendet beispielsweise die rotes Licht aus, absorbiert aber blau und grün. Werden mehrere Farben gemischt, so wird mehr Licht absorbiert und die Farbe erscheint dunkler. Bei der subtraktiven Farbmischung wird die resultierende Farbe also dunkler, je mehr verschiedene Farbtöne miteinander vermischt werden, während bei der additiven Farbmischung die Farbe dabei heller wird.

HSV-Farbraum

[Bearbeiten]Additive und Subtraktive Farbmischung können, nicht nur vom Verstehen her, recht kompliziert sein. Aus dem RGB-Farbwert (90, 184, 17) werden wohl nur wenige sofort erschließen können, um was für eine Farbe es sich handelt (es ist ein dunkles Grasgrün). Daher bieten Bildbearbeitungsprogramme auch den HSV-Farbraum an. Hierbei handelt es sich nicht um eine Mischung um Farben im eigentlichen Sinne, sondern rein um eine Definition von Farben aus 3 Parametern: Farbton, Sättigung und Helligkeit.

Eine im HSV-Farbraum kodierte Farbe kann dabei über eine Formel eindeutig in eine RGB-Farbe umgerechnet werden und umgekehrt. Es ist also am Ende egal, mit welchen Werten man arbeitet. Der zu RGB = (90, 184, 17) analoge HSV-Wert ist: (63, 199, 95). Leider ist es recht kompliziert, aus dem RGB-Wert den HSV-Wert zu berechnen und umgekehrt, Photobearbeitungsprogramme berechnen diese aber oft automatisch.

Was sagt nun der HSV-Wert?

- Der erste Parameter gibt den Farbton auf dem Farbkreis an. 0 ist dabei rot.

- Der zweite Parameter gibt die Sättigung an. 0 ist dabei reines grau (farblos), 240 ist eine vollständig satte Farbe.

- Der dritte Parameter gibt die Helligkeit an. 0 ist dabei schwarz, 240 ist weiß. Werte in der Mitte (zum Beispiel 120) geben eine natürliche Helligkeit wieder (natürlich wirkendes rot, blau, grün etc.).

Der Farbwert (0, 50, 240) ist demnach ein dunkles, aber kräftiges Rot.

Verschiedene Arten von Farben

[Bearbeiten]Primärfarben

[Bearbeiten]

Primärfarben (Grundfarben) sind drei Farben auf dem Farbkreis, mit denen sich alle weiteren Farben durch Mischen erstellen lassen. In der additiven Farbmischung (RGB) sind die Grundfarben rot, grün und blau. In der subtraktiven Farbmischung, auf die hier nicht weiter eingegangen wird, sind sie cyan, gelb und magenta (manchmal sagt man auch: rot, gelb, blau).

Sekundärfarben

[Bearbeiten]Sekundärfarben sind die Farben, die direkt aus den Primärfarben gemischt werden können, also im ersten Mischvorgang entstehen. Dies sind in der additiven Farbmischung grün, gelb und violett. Primärfarben und Sekundärfarben bilden zusammen die "Regenbogenfarben", also die sechs Farbbereiche, in die man die Spektralfarben oft einteilt.

Die Mischung aus Sekundärfarben ergeben dann die Tertiärfarben. Der heute allgemein bekannte zwölfteilige Farbkreis besteht damit aus drei Primärfarben, drei Sekundärfarben und sechs Tertiärfarben.

Komplementärfarben

[Bearbeiten]Komplementärfarben sind die Farben, die sich im Farbkreis gegenüberstehen. Das sind zum Beispiel gelb und blau, rot und cyan, grün und magenta. Komplementärfarben wirken besonders kontrastreich.

Von Komplementärfarben kann man auch sprechen, wenn sich die Farben nicht ganz exakt im Farbkreis gegenüberstehen (zum Beispiel rot/grün oder gelb/violett).

Wirkung von Farben

[Bearbeiten]Farbton

[Bearbeiten]Farben werden oft als Symbole betrachtet und stehen für bestimmte Eigenschaften. Dabei ist es wichtig zu wissen, dass die Bedeutung von Farben von Kulturkreis zu Kulturkreis verschieden sein kann. Die hier vorgestellten Bedeutungen einiger wichtiger Farben beziehen sich etwa auf den europäischen Raum – sie können sich zum Beispiel im asiatischen und afrikanischen Raum deutlich unterscheiden.

Farben haben oft mehrere verschiedene Bedeutungen, auch in Abhängigkeit mit welchen weiteren Farben beziehungsweise in welchem Kontext sie vorkommen. Die nachfolgende Auflistung kann damit nur als grober Überblick dienen.

Rot ist eine sehr wirkungsvolle, ausdrucksstarke Farbe. In der Natur kommt sie oft als Signalfarbe vor und steht damit für Gefahr und Warnung. Im Alltag verbinden wir rot meist mit Liebe, Leidenschaft, Lebensenergie, Dynamik. Oft wird rot auch mit dem Blut assoziiert ("rot wie Blut") und steht dann auch für Gewalt, Krieg und Brutalität. Die Wirkung des Rots ist demnach impulsiv, energisch und auch aggressiv. Auf Grund der Signalwirkung können Photos, die rote Elemente enthalten, die Aufmerksamkeit des Betrachters deutlich auf sich lenken.

Gelb ist ebenso eine Signalfarbe, jedoch nicht so ausdrucksstark und impulsiv wie rot. Auf Skalen steht gelb vor rot, ist also gewissermaßen eine Vorstufe zu einer Gefahr. Gelb ist aber vor allem die Farbe der Wärme (Sonne), Helligkeit und Freude, ebenso der Lebensenergie und Spontanität. Ein dunkles Gelb steht oft für Neid, Habgier und Überheblichkeit, während ein helles Gelb oft auch für Geist, Verstand und Intelligenz steht.

Orange steht zwischen gelb und rot und entsprechend ähnlich sind seine Bedeutungen. Es steht für Mut, Selbstvertrauen, Energie, Elan, Aufregung und Wärme. Es ist ebenso eine recht ausdrucksstarke Signalfarbe.

Grün ist eine Farbe, die meist mit der Natur verbunden wird. Sie steht daneben auch für Wachstum, Reife, Jugend, Frühling, Hoffnung und Leben. Grün wirkt entspannend, natürlich und ausgleichend.

Blau steht oft für Ruhe, Freundschaft, Treue und hat wie das Grün eine entspannende und beruhigende Wirkung. Mit Blau wird oft das Wasser und der Himmel verbunden. Im Zusammenhang mit letzterem steht Blau auch für Ferne und Unendlichkeit. Es steht aber auch für Melancholie, Traurigkeit und Depression (das englische Wort "blue" bedeutet gleichzeitig auch melancholisch, depressiv). Blau kann auch für die Nacht stehen (dunkles Blau) und insbesondere auch für Kälte, Frost (helles Blau). Letzteres ist insofern recht erstaunlich, weil blaues Licht deutlich energiereicher als rotes ist.

Mit Schwarz verbindet man meist negative Eigenschaften wie Tod, Unglück ("ein schwarzer Tag"), Boshaft, Tragik, Schicksal. Positive Assoziationen sind hingegen Ernsthaftigkeit und Seriosität (z.B. schwarzer Anzug). Neben dem Dunkelblau steht schwarz auch für die Nacht und damit im übertragenen Sinne für Angst, Bedrohung etc. Da schwarz eigentlich gleichbedeutend mit dem Fehlen von Licht ist, ist es selbst an sich keine Farbe des Lichtes. Mit dem Auftrag einer schwarzen Substanz ('Farbe') kann gleichwohl verhindert werden, dass Objekte sichtbares Licht aussenden.

Weiß steht für Reinheit, Unschuld, Unberührtheit, Sauberkeit. Mit der Farbe werden oft Hochzeiten verbunden, aber auch mit Winter und Schnee (dann kann die Farbe auch für Kälte und Eis stehen).

Grau steht meist für Neutralität. Es hat auch einige negative Eigenschaften wie Trübnis, Melancholie, Eintönigkeit, Langweile, Lustlosigkeit ("ein grauer Tag", "eine graue Wand").

Rosa steht zwischen rot und weiß; von der Bedeutung her tendiert es eher zum weiß. Es steht für Kindlichkeit, Zärtlichkeit, Weiblichkeit und hat eine sehr beruhigende Wirkung. Rosa wird oft als romantisch empfunden, im negativen Sinne aber auch als kitschig oder albern. Besondere Varianten von rosa sollen besondere psychologische Effekte haben, weswegen in einigen Gefängnissen renitente Sträflinge in rosa Zellen untergebracht werden oder sogar rosa Kleidung zu tragen haben.

Violett wirkt meist mystisch, zauberhaft und magisch. Es ist die Farbe des Geistes und der Spiritualität und wird auch für psychotherapeuthische Maßnahmen angewendet. Auch mit Phantasie und Traum wird violett oft verbunden. Im negativen Sinn kann es für Unnatürlichkeit und Mehrdeutigkeit stehen. Auch einige Beerdigungsinstitute haben kräftiges Violett neben dem Schwarz für sich entdeckt, damit kann es über den mystischen Eindruck hinaus auch morbide wirken.

Gold steht meist für Pracht, Reichtum und Wonne, kann aber wie das Gelb auch für Wärme und Lebensfreude ("goldene Tage") stehen. Mit Gold werden fast nur (übermäßig) positive Dinge verbunden (zum Beispiel "goldenes Oktoberwetter", "goldene Gehwege"). Gold ist ja ein Metall. Der Seheindruck von Metallen besteht aus einer Mischung von Reflektion und Emission, ist damit eigentlich nicht einfach durch eine simple Farbmischung zu erreichen. Bei Autolacken etwa werden metallische Eigenschaften simuliert, indem reflektierende Partikel beigemischt werden, was mit Farben auf einem Computer-Monitor nicht umsetzbar ist.

Die Farben rot, gelb, orange, magenta und gelbgrün werden auch als warme Farben bezeichnet. Sie erzeugen Wärme, Nähe, Behaglichkeit, Gemütlichkeit. Grün, türkis, blau und violett sind kalte Farben. Sie wirken kühl, sachlich, abweisend, funktional.

Helligkeit

[Bearbeiten]Die Helligkeit einer Farbe spielt ebenfalls eine wichtige Rolle, unabhängig vom Farbton. Helle Farben wirken beruhigender als Farben mittlerer Helligkeit; sie wirken dezent und freundlich und fallen nicht so stark auf. Räume wie Schlafzimmer und Wohnzimmer werden oft in hellen Farben (helles Blau, Gelb, Grün etc.) gestrichen, um eine beruhigende, gemütliche Wirkung zu erzielen.

Sehr helle Farben wirken besonders sanft und zart. Sie werden als Pastellfarben bezeichnet.

Dunkle Farben wirken bedrückend, düster, melancholisch oder bedrohlich, können manchmal aber auch ein Gefühl der Geborgenheit erzeugen. Anders als helle Farben, die freundlich wirken und Nähe ausdrücken, wirken dunkle Farben distanziert.

Sättigung

[Bearbeiten]Satte Farben wirken auffällig, dominant und zum Teil aggressiv (vor allem Gelb und Rot). Sie lenken die Aufmerksamkeit auf sich und können zu starken Kontrasten führen.

Weniger satte Farben wirken hingegen unauffällig, gedämpft und dezent. Sie wirken eher romantisch und verträumt; Aufnahmen bei Nebel werden beispielsweise ein hohes Maß an weniger satten Farben aufweisen. Eine zu hohe Sättigung wirkt meist unnatürlich, da in der Natur kaum vollständig satte Farben auftreten; eine zu niedrige Sättigung tendiert hingegen zum Schwarzweiß-Bild und kann das Bild langweilig und matt erscheinen lassen.

Farbharmonie

[Bearbeiten]Farbharmonie spielt eine wichtige Rolle im Bereich der Farbgestaltung. Die Farben eines Bildes sollten zueinander passen, sie sollten harmonisch und ansprechend sein. Ist dies nicht der Fall, kann das Foto schnell unschön und abstoßend wirken.

Farbharmonie kann man beispielsweise erzeugen durch...

- Wahl ähnlicher Farben (zum Beispiel rote Töne überwiegen).

- Wahl kalter oder warmer Farbtöne (z.B. rote, gelbe, orange Töne überwiegen).

- Verwendung von hellen Farben und den entsprechenden Vollfarben (Helligkeitsabstufungen) oder Verwendung von satten Farben und den entsprechend weniger satten Farben (Grauabstufungen).

Einer Theorie zufolge wirken drei Farben besonders harmonisch, wenn sie sich im Farbkreis durch ein gleichschenkliges Dreieck verbinden lassen, zum Beispiel orange, rot, türkis. Es ist bei der Farbharmonie jedoch stets zu berücksichtigen, dass die Farben erst in ihrer Gesamtheit und zusammen mit der Komposition beurteilt werden können - eine ungeschickte Anordnung von orange, rot und türkis kann trotzdem leicht zu Disharmonie führen.

Farbklänge sind ein weiteres Mittel um Farbharmonie darzustellen. Unter einem Farbklang versteht man eine Menge von Farben, die in gleicher Helligkeit und Sättigung auftreten und dabei den selben Abstand zueinander auf dem Farbkreis haben. Beim Farbdreiklang hat man also drei Farben, die denselben Abstand zueinander haben und in gleicher Intensität in dem Bild vorhanden sind (zum Beispiel rot, grün, blau). Beim Farbvierklang hat man entsprechend vier Farben. Farbklänge haben die besondere Eigenschaft, dass sie sowohl harmonisch als auch kontrastreich wirken.

Kontrast

[Bearbeiten]Grundlagen

[Bearbeiten]Der Kontrast bezeichnet die farblichen Differenzen in einem Bild. Während zuvor nur einzelne Farben betrachtet wurden, werden beim Kontrast also Farben untereinander betrachtet. Der Bereich zwischen hellsten und dunkelsten Stellen eines Bildes heißt Kontrastumfang.

Als Formel gilt allgemein mit min dem minimalen Wert und max dem maximalen Wert für den Kontrast K:

K = (max - min) / (max + min)

Je nachdem, wofür ein Kontrast bestimmt werden soll, sind für min und max also (skalare) Zahlenwerte zu bestimmen, damit ein Kontrast quantitativ berechnet werden kann.

Meist meint man mit Kontrast die Unterschiede zwischen hellen und dunklen Bereichen eines Bildes.

Ein Bild mit sehr hellen und sehr dunklen Bereichen wird als kontrastreich empfunden; ein Bild mit wenig Helligkeitsunterschieden als wenig kontrastreich.

Es gibt jedoch mehrere Arten von Kontrast, die im nächsten Abschnitt vorgestellt werden.

Die Wirkung des Kontrasts erhöht sich umso mehr, je kleiner der Raum ist, auf dem sich die unterschiedlichen Farb- und Helligkeitswerte befinden. So wirkt der Kontrast größer, wenn dunkle und Helle Töne eng aneinander liegen, als wenn sie im Bild verstreut auftreten.

Ausgewählte Farbkontraste

[Bearbeiten]Vermutlich am bekanntesten ist der Hell-Dunkel-Kontrast. Dieser bezeichnet die Differenzierung der Helligkeitswerte in einem Bild. Existieren weiße und schwarze Farben, so ist er maximal. Besteht das Bild aus nur einer Farbe, so ist er null.

Der Farbe-an-sich-Kontrast bezeichnet den Kontrast auf der Basis von Farbwerten (statt von Helligkeitswerten). Je mehr verschiedene Farbtöne in dem Bild vorkommen, umso größer ist der Kontrastumfang. Das Bild wirkt besonders kontrastreich, wenn stark unterschiedliche Farbtöne unmittelbar nebeneinander auftreten (zum Beispiel grün, blau, gelb und rot statt rot, rosa, lila, violett) und die Sättigung der Farben groß ist (bei geringer Sättigung neigen die Farben zum Grau und damit sinkt der Farbkontrast). Ein hohes Farbspektrum in einem Photo macht dieses oft lebendig und impulsiv. Eine Vielzahl an Farben führt aber auch zu Unordnung und Chaos. Kommen nur wenige Farbtöne vor, wirkt es dezent und beruhigend - es entsteht eine gewisse Ordnung.

Der Komplementärkontrast bezeichnet den Kontrast, der durch komplementäre Farben entsteht, also Farben, die sich im Farbkreis gegenüberstehen (zum Beispiel rot und grün oder violett und gelb). Komplementärfarben sorgen für einen gewissen Ausgleich.

Der Kalt-Warm-Kontrast bezeichnet den Kontrast zwischen kalten Farben (blau, grün) und warmen Farben (orange, rot).

Der Bunt-Unbunt-Kontrast bezeichnet den Kontrast zwischen bunten und unbunten Farben (schwarz, weiß und vor allem Graustufen) in einem Bild.

Der Qualitätskontrast ist der Kontrast zwischen gesättigten und ungesättigten Farben. Ungesättigte Farben (Grautöne) haben die besondere Eigenschaft, daneben befindliche gesättigte Farben besonders kräftig wirken zu lassen.

Der Quantitätskontrast (auch Mengenkontrast) bezeichnet den Kontrast, der zwischen verschieden großen Farbflächen entsteht. Er ist beispielsweise groß, wenn eine große Fläche blau und nur eine kleine Fläche weiß ist. Treten sehr viele Farben auf, ohne dass eine dominiert, ist er hingegen klein. Die weniger vorhandene Farbe lenkt dabei die Aufmerksamkeit auf sich und sollte etwa im Goldenen Schnitt liegen (oft handelt es sich hierbei um das Hauptmotiv).

-

Hell-Dunkel-Kontrast

-

Farbe-an-sich-Kontrast

-

Komplementär-Kontrast

-

Kalt-Warm-Kontrast

-

Qualitäts-Kontrast

-

Quantitäts-Kontrast

Farbwahrnehmung und Farbdarstellung

[Bearbeiten]Das menschliche Auge kann rund 100 Helligkeitsabstufungen von einander abgrenzen, wobei es hellere Töne grundsätzlich besser von einander abgrenzen kann als dunkle Töne. In der digitalen Photographie wird meist eine Farbtiefe von 24 Bit verwendet, das heißt für jede Grundfarbe stehen 8 Bit (256 Abstufungen) zur Verfügung. Aus dieser Sicht sollte die Farbtiefe vollkommen ausreichend sein - mit 24 Bit lassen sich immerhin 16,7 Millionen verschiedene Farben darstellen (das menschliche Auge kann hingegen nur deutlich weniger Farbabstufungen unterscheiden).

In der Realität sieht dies jedoch ein klein wenig anders aus. Hier entscheidet im Grunde der Kamerasensor, ob er überhaupt sensibel genug ist, 256 Abstufungen je Farbton zu erkennen. Die meisten Kameras kommen somit nur auf 150 bis 200 Abstufungen. Ein weiteres Problem ist die Optimierung von Photos, die teilweise bereits in der Kamera beginnt. Mit jedem Optimierungs- und Nachbearbeitungsschritt sind für gewöhnlich Abstufungsreduktionen verbunden. Es kann dann schnell passieren, dass ein Foto unter den 100 Abstufungen liegt und der Verlauf der Farben unnatürlich wirkt, weil einzelne Abstufungen plötzlich sichtbar werden.

Einige Kameras bieten heute auch 48-Bit-Farbdarstellung an (16 Bit je Farbton, also 65.536 Abstufungen). Da das JPEG-Format jedoch auf 24 Bit Farbtiefe ausgelegt ist, wird die Abstufung beim Speichern automatisch auf 256 reduziert und ein Großteil der Vorteile dieser Farbtiefe geht verloren. Daher ist es immer sinnvoll, für die Nachbearbeitung die Rohdatenbilder zu verwenden, um mit der vollen Farbtiefe des Sensors arbeiten zu können und nicht nur mit der mit JPEG abspeicherbaren Farbtiefe.

Wieviele Farben der Mensch tatsächlich unterscheiden kann, wird sehr unterschiedlich angegeben. Man ging früher von einigen Zehntausend aus, neuere Untersuchungen korrigieren den Wert wohl eher nach oben. Wie beim HSV-Modell kann das Auge eine gewisse Anzahl an Farbtönen, Sättigungswerten und Helligkeitswerten unterscheiden. Eine Angabe, die sich auf 400.000 Farben bezieht, begründet den Wert damit, dass das menschliche Auge wohl rund 130 Farbtöne, 130 Sättigungswerte und 25 Helligkeitswerte voneinander unterscheiden kann - multipliziert man diese Angaben, erhält man etwa die 400.000 Farben. In jedem Fall liegt die Zahl der wahrnehmbaren Farben deutlich unter den 16,7 Millionen theoretisch möglichen Farben – wie aber oben ausgeführt, wird diese hohe Farbdifferenzierung in der Digitalen Photographie nicht erreicht und droht im Extremfall unter den Schwellwert von einigen Zehntausend bis Hunderttausend Farben zu fallen. Die Fähigkeit, Farben zu unterscheiden, hängt zudem auch vom betrachteten Wellenlängenbereich ab - im grünen Bereich ist einerseits das menschliche Auge am empfindlichsten, zudem sind dort auch jeweils die blauen und die roten Rezeptoren noch geringfügig empfindlich. Dort können Farben also am besten aufgelöst werden. Unterhält man sich mit Menschen, die mit oft mit schmalbandigen, durchstimmbaren Lasern arbeiten, wo man also die Wellenlänge des ausgesendeten Lichtes präzise einstellen kann, stellt sich heraus, dass es zudem möglich erscheint, für bestimmte Bereiche eine präzisere Differenzierung durch Erfahrung zu erreichen. Forscher, die etwa lange mit Wellenlängen um die Natrium-D-Linien (589.158 nm und 589.756 nm, dieses Gelb sieht man oft, wenn man Salz in offenen Flammen verbrennt) arbeiten, können oft recht gut abschätzen, wie weit ihr Laser gerade von diesen Resonanzen verstimmt ist.