Information: quantitativ

Zurück zur Übersicht

Quantitative Beschäftigung mit dem Begriff Information

[Bearbeiten]Eine Folge von Zeichen, die man nicht lesen kann, die aber nicht zufällig hingestreut ist, ist als eine Information erkennbar, obwohl ihr Inhalt zunächst unbekannt bleibt.

Beispiel:

qwertzuiopasdghjkl

Man muss also unterscheiden:

- Die Informationsmenge, die man messen kann, und

- Der Informationsgehalt, der schwerer quantifizierbar ist.

Will man Informationsmengen betrachten, ganz unabhängig von ihrer Bedeutung, sollte man besser von Datenmenge sprechen, das deckt sich besser mit dem allgemeinen Verständnis von Information. Information ohne Bedeutung ist in der Alltagsvorstellung schwer verständlich zu machen. Eine zufällige Folge von Zeichen ist eine solche Information ohne Bedeutung.

Die kleinste Informationseinheit = Dateneinheit kann man sich unabhängig von einem speziellen Inhalt oder einer bestimmten Bedeutung vorstellen als eine Entscheidung zwischen zwei gleichberechtigten Wahlmöglichkeiten.

Bit

[Bearbeiten]

Zitat Leibniz Eine der biblischen Grundlehren ist die erschaffung aller dinge aus nichts durch die allmacht Gottes. Nun kann man wohl sagen daß nichts in der welt sie beßer vorstelle, ja gleichsam demonstrire, als der ursprung der zahlen wie er alhier vorgestellet, durch deren ausdrückung bloß und allein mit Eins und Null oder Nichts, und wird wohl schwehrlich in der Natur und Philosophi ein beßeres vorbild dieses geheimnißes zu finden seyn.

Die kleinste Informationseinheit ist das Bit. Bit ist die Kurzform für Binary digit, bedeutet also Binärziffer oder einstellige Zahl aus dem Zweiersystem. Man kann auch sagen, eine Binärzahl ist eine Zahl aus mehreren Bit, die also nur aus Einsen und Nullen besteht. Die Information, die in einer Ja-Nein Entscheidung steckt, ist ein Bit.

binär = digital = Zahl aus 0 und 1 bestehend

Ein Informationsspeicher mit 1 Bit Speicherkapazität hat also nur einen Speicherplatz mit 2 Möglichkeiten

- z. B. besetzt oder leer

- an und aus

- Kerbe oder keine Kerbe.

In einer Münze steckt die Zufallsinformation ein Bit, wenn sie geworfen wird, denn es wird ja die Entscheidung zwischen 2 Möglichkeiten getroffen.

Wenn man jemanden an einer Weggabel nach dem richtigen Weg fragt, enthält die Antwort meist die Informationsmenge ein Bit, nämlich die Auswahl rechts oder links. Auch hier wieder ist die Informationsmenge unabhängig von ihrem Inhalt, denn die Antwort könnte auch falsch sein. Keine Information enthält die Antwort, wenn der Gefragte den richtigen Weg nicht weiß.

Die größten Informationsmengen stecken in unserem Gehirn, in unseren Bibliotheken, Büchern, Filmen, Bildern und Computern, im Erbgut und den Molekülstrukturen der belebten Natur, in den Gesetzen der unbelebten und belebten Natur, in der Struktur des gesamten Weltraumes und die maximal denkbare Information in der Geschichte des gesamten Weltraumes.

1 Bit (binary digit) ist eine "Ja-Nein-Entscheidungen", für "Ja" (Strom) wird die Zahl 1 gesetzt für "Nein" (kein Strom) die 0.

1 Byte umfasst die Länge eines speicherbaren Zeichens und besteht aus 8 Bits. Alle 8 Bit gleichzeitig betrachtet ergeben -je nach Zustand- eine Reihe von Einsen und Nullen. Insgesamt sind 256 verschiedene Zustände möglich. Jedem dieser Zustände wird z. B. durch den ASCII-Code ein Zeichen eindeutig zugeordnet. z.B. 01000001 entspricht dem A bzw. 01100010 dem B.

- 1 Byte = 8 Bit = 2^3 Bit

- 1 Kilobyte = 1 KB = 2^10 Byte = 1 024 Byte

- 1 Megabyte = 1 MB = 2^20 Byte = 1 048 576 Byte

- 1 Gigabyte = 1 GB = 2^30 Byte = 1 073 741 824 Byte

Das ^ - Zeichen ist das Hoch Zeichen. Meistens kann man es auch im Textformat angeben:

Beispiel: 2^3 = 2 hoch 3 = 2*2*2 = 8

Wer mit der Informationsmenge rechnen will, der sollte sich mit dem Logarithmus auskennen, denn es gilt:

Information I = lg2 Z (bit)

Die Informationsmenge I ist gleich dem Logarithmus zur Basis 2 der Zahl Z der möglichen Ereignisse.

Aus der Informationsmenge kann man auch zurückschließen auf die Zahl Z der zugrundeliegenden möglichen Ereignisse:

- 0 bit => Z = 1 da lg2 1 = 0, da 20 = 1

- 1 Bit => Z = 2 da lg2 2 = 1, da 21 = 2

- 8 bit = 1 Byte => Z = 256, da lg2 256 = 8, da 28 = 2*2*2*2*2*2*2*2 = 256

- 1 Kilobyte = 1kB = 2hoch10Byte = 210Byte = 1024Byte= 8 * 1024 Bit = 8192 Bit= ca. 1000 Byte

- Bei 1 kB ist die Zahl Z der möglichen Ereignisse bereits riesig groß: 1,09074813561941592946298424473 * 10hoch2466 = 2hoch8192

- 1 Megabyte = 1 MB = 2hoch20Byte = 220Byte = 1048576 Byte = 8 * 1048576 Bit = 8388608Bit = ca. 1 Mio Byte

- 1 Gigabyte = 1 GB = 2hoch30Byte = 230Byte = 1073741824 Byte = 8* 1073741824 Bit = 8589934592 Bit = ca. 1 Milliarde Byte

Die Zahl Z kann man auch bestimmen, wenn man weiß, wie viele Ja - Nein Entscheidungen notwendig sind, um aus einer gegebenen Zahl von Möglichkeiten genau eine einzige zu wählen.

Frage: Warum ist ein Kilobyte = 1024 Byte und nicht 1000 Byte?

Tabelle zum Vergleich der Zahlensysteme

[Bearbeiten]|

Dezimal |

Binär |

Hexadezimal |

|

Stellen |

Stellen |

Stellen |

|

3210 |

9876543210 |

210 |

|

0 |

0 |

0 |

|

1 |

1 |

1 |

|

2 |

10 |

2 |

|

3 |

11 |

3 |

|

4 |

100 |

4 |

|

5 |

101 |

5 |

|

6 |

110 |

6 |

|

7 |

111 |

7 |

|

8 |

1000 |

8 |

|

9 |

1001 |

9 |

|

10 |

1010 |

A |

|

11 |

1011 |

B |

|

12 |

1100 |

C |

|

13 |

1101 |

D |

|

14 |

1110 |

E |

|

15 |

1111 |

F |

|

16 |

10000 |

10 |

|

17 |

10001 |

11 |

|

31 |

11111 |

1F |

|

32 |

100000 |

20 |

|

63 |

111111 |

3F |

|

64 |

1000000 |

40 |

|

255 |

11111111 |

FF |

|

256 |

100000000 |

100 |

|

1000 |

1111101000 |

3E8 |

|

10n |

2n |

16n |

Im Binärsystem sind viel mehr Stellen nötig als im Zehner - oder Hexadezimalsystem. Im Hexadezimalsystem findet sich in einer Stelle die Information von 4 Binärstellen. Hexzahlen = 16erZahlen sind sehr leicht in Binärzahlen umzurechnen und deswegen sehr beliebt.

Codierung

[Bearbeiten]Natürlich kann man Information nicht nur als Folge von 0 und 1 darstellen, sondern man kann auch andere Darstellungsarten = Codes benutzen. So erhält man dann eine Abwandlung des obigen Lehrsatzes: Alles was codierbar ist, ist Information. Zu fragen ist dann natürlich: Ist jegliche Information codierbar? Gibt es nichtcodierbare Informationen?

Was ist überhaupt ein Code?

Beispiel eines Codes :

Oft verläuft eine Codierung auf verschiedenen Ebenen ab. Als Beispiel einer solchen stufenweisen Codierung kann man unsere gesprochene Sprache anführen:

- Laut oder Buchstabe

- Silbe

- Wort

- Satz

- Wort

- Silbe

Als Beispiel einer stufenweisen Computercodierung kann man anführen:

- Codierung eines Buchstabens im ANSI Code

- ( ANSI Code=genormte Zahlendarstellung von Buchstaben)

- Codierung des ANSI Codes in einer Folge von 0 und 1

Weitere verbreitete Codes sind das Morsealphabet und die Brailleschrift.

Obwohl für die Messung von Informationsmengen, für Informationsströme und für die Informationsspeicherung das Bit und das Byte als Basiseinheiten vorliegen, wird die Informationsmenge immer noch gerne an Hand des jeweiligen Informationsträgers quantifiziert. So kann man die digitale Informationsmenge, die in einem Buch steht, leicht und anschaulich an der Seitenzahl oder an der Zahl der Wörter ablesen.

Zusammenhang zwischen Information und Entropie

[Bearbeiten]Über den genauen Zusammenhang zwischen der Information und der Entropie wird heftig diskutiert. Entropie ist dabei ein Maß für die zufällige, ungeordnete Information, die in einer Informationssequenz oder einem System steckt.

Vorschläge

[Bearbeiten]I = k * E

- Shannon

- Information und Entropie sind direkt proportional

I = - k * E

- Schrödinger, Wiener , Slizard, Brillouin

- Information und Entropie sind indirekt proportional

- beispielsweisen in Léon Brillouin

- Science and Information Theory (New York: Academic Press, 1956)

Brillouin [1951a] p. 335 : Shannon, however compares information with positive entropy, a procedure which seems difficult to justify since information is lost during the process of transmission, while entropy is increased.

I = Io* e^(-k*E)

- Tom Stonier

- Information und Entropie sind negativ korreliert, es gibt negative Entropie

- http://www.madeasy.de/2/stonier.htm

Wer hat hier recht?

Gesamtinformation = Entropie + geordnete Information

[Bearbeiten]Ein weiterer Vorschlag wäre folgender:

Wenn man die Entropie als die Menge an Zufallsinformation betrachtet, die in einem System steckt, dann kann man sagen, dass die Gesamtinformation des Systems immer größer oder gleich der Entropie des Systems ist.

Es gilt wahrscheinlich folgende Formel:

Menge an Gesamtinformation = Menge an Zufallsinformation

+ Menge an nichtzufälliger Information

Beispiele

[Bearbeiten]Am besten kann man sich die Bedeutung dieser Formel an Beispielen klar machen, bei denen ein System zwischen verschiedenen Ordnungszuständen hin und her pendelt.

Eis und Wasser

[Bearbeiten]Die Information eines Eisblockes, der auftaut und wieder gefriert, bleibt in seiner Gesamtinformation konstant. Die Menge an Zufallsinformation pendelt dabei zwischen einem hohen und einem geringen Wert hin und her. Die Menge an nichtzufälliger Information verhält sich dazu gegensinnig. Nicht zu vernachlässigen ist dabei natürlich der Zu- und Abstrom von Wärme von außen, ohne die kein Wechsel zwischen den Aggregatszuständen des Wassers stattfinden würde.

Planetensystem

[Bearbeiten]Betrachtet man das Sonnensystem, dann hat es gegenüber dem Eisblock den Vorteil, dass man es sich in grober Näherung von außen isoliert vorstellen kann. Stehen dann alle Planeten in einer Reihe auf einer Seite der Sonne, dann ist die Entropie sicher niedriger und der Anteil an geordneter Information größer, als bei einem Zustand der zufälligen Verteilung der Planeten um die Sonne. Das System der Planeten unterliegt zwar im Gegensatz zum Eisblock zumindest theoretisch keinem äußeren Einfluss durch eine periodische Energiezufuhr oder -abführung. Dennoch ist es physikalisch nicht ideal, da die Sonne ständig durch die Fusion Energie erzeugt und das Gesamtsystem so einen Massen- und Energieverlust erleidet.

Erkaltetes Planetensystem

[Bearbeiten]Um das Problem schwer berechenbarer Einflüsse durch die Kernfusion zu vermeiden, kann man ein Planetensystem mit einem erkalteten, ruhigen Zentralkörper betrachten der von 2,3 oder mehreren kleinen Planeten umkreist wird. Hier kann man dann, unter Vernachlässigung aller äußeren Einflüsse, die Entropie einer geordneten Konstellation, in der alle Planeten in einer Reihe auf einer Seite des Zentralgestirns stehen mit der Entropie einer weniger geordneten Konstellation vergleichen. So kann man eine einfache Formel für das hin und her pendeln zwischen Ordnung und Entropie finden und die Gesamtinformation errechnen.

Gesamtes Universum

[Bearbeiten]Vielleicht ist auch das gesamte Universum so etwas wie ein Entropiependel. Dann wäre zumindest einigermaßen erklärbar, warum am Anfang ein Zustand so niedriger Entropie vorlag und die Entropie momentan ständig zunimmt. Der Urknall war dann nur der eine Umschlagspunkt des Entropiependels mit maximaler Ordnung und minimaler Entropie. Dieser strebt über Jahr Milliarden zum Punkt maximaler Entropie und minimaler Ordnung. Um dann wieder in die andere Richtung umzukehren. Dies wäre eine angenehme Vorstellung für alle, die sich mit der Vorstellung des Wärmetodes des Universums nicht abfinden können.

Basisbegriffe der Natur- und Strukturwissenschaften

[Bearbeiten] Materie ------------ Energie

\ /

\ /

\ /

\ /

Information

/ \

/ \

/ \

/ \

/ \

Entropie geordnete

| Information

| |

| |

| |

Beispiel: Beispiel:

01101100110111100010 10101010101010101010

| |

| |

| |

Stochastik Restliche Mathematik

Statistik

Da diese Ascii Grafik im Pdf Format schlecht zur Darstellung kommt, wird es hier noch einmal wiederholt. Physikalische Grundkategorien:

- Materie

- Energie

Eine wichtige Eigenschaft dieser beiden

- Information ( = Struktur)

Erste wichtige Einteilung des Begriffes Information

- geordnete Information

- Zufallsinformation ( = Entropie)

Simple Beispiele

- geordnet 10101010101010101010

- zufällig 01101100110111100010

Fachgebiete, die sich mit diesen Unterkategorien befassen

- Mathematik ohne Stochastik

- Stochastik, statistische Mathematik

- Hohe Entropie ist eher langweilig.

- Eine Ordnung ohne jeden Zufall ist auch eher langweilig.

>> Interessant ist die Mischung aus Entropie und Ordnung.

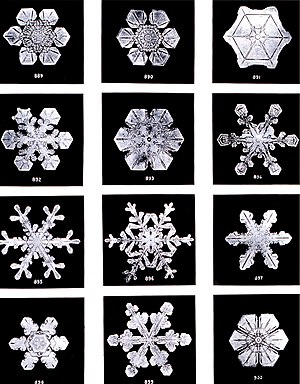

Wenn man 1 Gramm Wasser betrachtet, dann ist ein Wassertropfen mit Zufallsstruktur der Wassermoleküle eher langweilig. Ein geordneter Einkristall des Wassers ist auch langweilig (wenn es so etwas gibt). Interessant ist es zwischen drin: beispielsweise ein Schneekristall. Hier gibt es eine unendliche Vielfalt der Formen.

Zwei Arten von geordneter Information

[Bearbeiten]Betrachtet man 01 Folgen und untersucht sie statistisch auf ihren Ordnungsgrad, dann kann man zwei einfache Arten von Ordnung unterscheiden:

- wiederholende Ordnung: 10101010101010

- symmetrische Ordnung: 00000001111111

Dies ist eine sehr einfache, aber grundlegende Unterscheidung. Daneben gibt es viele andere Arten von geordneter Information. Es kann natürlich auch Zufallsinformation, symmetrisch geordnete Information und wiederholend geordnete Information in einer einzigen Sequenz auftreten. Man könnte das dann didaktische Information nennen.