Sensorisches System/ Computermodelle/ Auditorisches System Simulation

Computersimulation des auditorischen Systems

[Bearbeiten]Arbeiten mit Audio

[Bearbeiten]Audiosignale werden in einer Vielzahl von Formaten gespeichert. Sie unterscheiden sich hauptsächlich in der verwendeten Kompression und Kodierung, welche offen oder proprietär sein kann. Auf Windows-Systemen ist das gängigste Format das WAV-Format (w: WAV). Es enthält einen so genannten Header mit Informationen über die Anzahl der Kanäle, die Abtastrate, die Bits pro Abtastung usw. Nach dem Header folgen die eigentlichen Audiodaten. Die gängigste Bitstream-Kodierung ist das LPCM-Format (w: Pulse-code_modulation, lineare Pulscodemodulation).

Viele Programmiersprachen verfügen bereits in der Standard-Bibliothek über Funktionen zum Lesen und Schreiben von WAV-Dateien. Wenn man mit einem anderen Format arbeitet, hat man grundsätzlich zwei Möglichkeiten:

- Konvertierung der Audiodatei in das WAV-Format. Eine sehr umfassende, kostenlose und plattformübergreifende Lösung zum Aufnehmen, Konvertieren und Streamen von Audio und Video ist ffmpeg (http://www.ffmpeg.org/).

- Spezialisierte Bibliotheken oder Module zum Lesen/Schreiben des gewünschten Formats. Die Verfügbarkeit von solchen Erweiterungen ist abhängig von der verwendeten Programmiersprache.

Repetition zu Fourier Transformationen

[Bearbeiten]

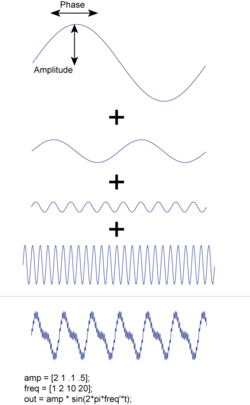

Um eine stetige Funktion zu transformieren, verwendet man das Fourier-Integral:

wobei für die Frequenz steht. Man beachte, dass es sich bei um komplexwertige Koeffizienten handelt, deren Absolutwert der Amplitude der Funktion und deren Phase der Phasenverschiebung zwischen Kosinus- und Sinuskomponenten entspricht.

Die Rücktransformation ist gegeben durch

Bei diskreter und äquidistanter Abtastung der Daten ergeben sich N Samples, wobei

Die Koeffizienten können wie folgt berechnet werden:

Da eine endliche Anzahl von Datenpunkten eine diskrete Menge von Wellen beschreibt, wird diese Transformation als Diskrete Fourier-Transformation (engl. Discrete Fourier Transform, DFT) bezeichnet. Die schnelle Fourier-Transformation (engl. Fast Fourier Transform, FFT) ist ein Spezialfall der DFT, bei der die Anzahl der Samples eine Potenz von 2 ist: .

Bei den meisten Messdaten handelt es sich um reell wertige Funktionen im Zeitbereich . Daraus ergibt sich folgende Einschränkung für die entsprechenden Frequenzkomponenten:

Bei N Samples und einem Abtastintervall , ist die n-te Frequenz gegeben durch

Die Grundfrequenz ist demnach [Hz], während die höchste unabhängige Frequenz aufgrund des Nyquist-Shannon-Theorems beträgt.

Spektralanalyse von biologischen Signalen

[Bearbeiten]Leistungsspektrum von stationären Signalen

[Bearbeiten]Die meisten FFT-Funktionen und -Algorithmen liefern komplexwertigen Fourier-Koeffizienten . Das Leistungsspektrum ist gegeben durch

und widerspiegelt, wie groß der Beitrag der verschiedenen Frequenzen ist.

Leistungsspektrum von nicht-stationären Signalen

[Bearbeiten]

Üblicherweise ändert sich die Zusammensetzung eines Audiosignals über die Zeit. Bei diesen sogenannten nicht-stationären Signalen ist man demnach daran interessiert, wie sich das Leistungsspektrum über die Zeit verändert. Am einfachsten ist es, jeweils nur ein kurzes Segment der Daten isoliert zu betrachten und das entsprechende Leistungsspektrum zu berechnen. Dieser Ansatz wird als Kurzzeit-Fourier-Transformation (engl. Short Time Fourier Transformation, STFT) bezeichnet. In diesem Fall können jedoch Flanken-Artefakte die Signale erheblich verzerren, da wir davon ausgehen, dass unser Signal periodisch ist.

Um Flanken-Artefakte zu eliminieren, kann man das Signal filtern oder mit Fenstern arbeiten (w: Window_function). Ein Beispiel für ein solches Fenster ist in der obigen Abbildung dargestellt. Während einige Fenster eine bessere Frequenzauflösung bieten (z. B. das Rechteckfenster), weisen andere weniger Artefakte wie den spektralen Leakage-Effekt auf (z. B. das Hanning-Fenster).

Durch Multiplikation des Signals mit dem Filter erhält man das gefilterte Signal, welches als Grundlage für die STFT dient (linke Abbildung). Die Auswirkung eines Fensters auf die spektrale Leistungsverteilung ist in der rechten Abbildung dargestellt.

|

|

Der entsprechende Python-Code ist zu finden unter [1]. Man beachte, dass eine Verringerung der Breite des Zeitfensters die Breite des entsprechenden Leistungsspektrums erhöht.

Stimulationsstärke pro Zeitfenster

[Bearbeiten]Um das Leistungsspektrum für ein ausgewähltes Zeitfenster zu erhalten, wird zunächst durch eine FFT des Zeitsignals das Leistungsspektrum berechnet. Dies resultiert in der Schallintensität pro Frequenz. Der zweite Schritt besteht darin, diese Intensitäten auf einige wenige Frequenzen zu konzentrieren (engl. Binning). Das Ergebnis ist ein Schallsignal im Frequenzbereich, das aus einigen wenigen dedizierten Frequenzen besteht, welche mit der Position der Elektroden in der simulierten Cochlea übereinstimmen. Die Rückkonvertierung in den Zeitbereich ergibt das simulierte Schallsignal für dieses Zeitfenster.

Die folgende Python-Funktion verarbeitet ein gegebenes Signal:

import numpy as np

def pSpect(data, rate):

'''Berechnung des Frequenzspektrums und der zugehörigen Frequenzen mithilfe eines Hamming Fensters'''

nData = len(data)

window = np.hamming(nData)

fftData = np.fft.fft(data*window)

PowerSpect = fftData * fftData.conj() / nData

freq = np.arange(nData) * float(rate) / nData

return (np.real(PowerSpect), freq)

def calc_stimstrength(sound, rate=1000, sample_freqs=[100, 200, 400]):

'''Berechnung der Stimulationsintensität für einen gegebenen Ton'''

# Berechnung des Frequenzspektrums

Pxx, freq = pSpect(sound, rate)

# Generiere Matrix um über die Bins zu summieren

num_electrodes = len(sample_freqs)

sample_freqs = np.hstack((0, sample_freqs))

average_freqs = np.zeros([len(freq), num_electrodes])

for jj in range(num_electrodes):

average_freqs[((freq>sample_freqs[jj]) * (freq<sample_freqs[jj+1])),jj] = 1

# Berechne die Stimulationsstärke (Wurzel ziehen, um die Amplitude zu erhalten)

StimStrength = np.sqrt(Pxx).dot(average_freqs)

return StimStrength

Schallweiterleitung durch Ohrmuschel und Außenohr

[Bearbeiten]Das äußere Ohr ist in zwei Teile unterteilt: den sichtbaren Teil an der Seite des Kopfes (die Ohrmuschel) und den äußeren Gehörgang, welcher zum Trommelfell führt. Diese Gesamtstruktur trägt die "spektralen Hinweise" für die Schalllokalisierung bei, so dass neben der Schallerkennung und -Identifizierung auch eine Ortung der Schallquelle möglich wird [2]

Funktion der Ohrmuschel

[Bearbeiten]Durch die konische Form der Ohrmuschel werden Schallwellen gesammelt und in den äußeren Gehörgang geleitet. Darüber hinaus wirkt die Ohrmuschel durch ihre verschiedenen Falten als Resonanzraum, der bestimmte Frequenzen verstärkt. Ferner sind die Interferenzen, die sich aus der von der Ohrmuschel verursachten Schallreflexion ergeben, richtungsabhängig und schwächen andere Frequenzen ab. Folglich kann die Ohrmuschel als eine Filterfunktion simuliert werden, die auf den eintreffenden Schall angewendet wird und dessen Amplituden- und Phasenspektrum moduliert.

Die Resonanz des Ohrmuschelhohlraums kann durch die ersten 6 Eigenmoden gut approximiert werden [4]. Unter ihnen dominiert der erste Mode, der hauptsächlich von der Tiefe der Ohrmuschel (d. h. der Tiefe des schalenförmigen Teils der Ohrmuschel, der dem Gehörgang am nächsten liegt) abhängt.

Wie in der rechten Abbildung [3] dargestellt, durchläuft der von der Ohrmuschel übertragene Schall zwei unterschiedliche Pfade; einen direkten und einen längeren reflektierten Pfad. Die beiden Pfade sind unterschiedlich lang und erzeugen dadurch Phasenunterschiede. Wenn die Phasendifferenz die Hälfte der Schall-Wellenlänge beträgt, wird die Interferenz von Schall über den direkten und den reflektierten Pfad destruktiv. Die resultierende Auslöschung bestimmter Frequenzen durch die Ohrmuschelreflexion wird als "Pinna Notch" bezeichnet [4]. Betroffen sind insbesondere Frequenzen im Bereich von 6 kHz bis 16 kHz, je nach Form und Orientierung der Ohrmuschel. Dadurch trägt die Ohrmuschel zu den räumlichen Anhaltspunkten für die Schalllokalisierung bei.

Funktion des Gehörgangs

[Bearbeiten]Der äußere Gehörgang ist etwa 25 mm lang bei einem Durchmesser von 8 mm und verläuft gewunden vom Eingang des Kanals bis zum Trommelfell. Der äußere Gehörgang lässt sich somit als einseitig geschlossener Zylinder modellieren, was zu einer Resonanzfrequenz um 3k Hz führt. Auf diese Weise verstärkt der äußere Gehörgang Töne in einem für die menschliche Sprache wichtigen Frequenzbereich [5].

Simulation des Außenohrs

[Bearbeiten]Basierend auf den wesentlichen Funktionen des Außenohrs ist es möglich, die Schallübertragung durch die Ohrmuschel und den äußeren Gehörgang mit einem Filter oder einer Filterbank zu simulieren, sofern die Eigenschaften des Filters bekannt sind.

Viele Wissenschaftler befassen sich mit der Simulation des menschlichen Gehörs, einschließlich der Simulation des Außenohrs. Im nächsten Kapitel wird zunächst ein Modell der Ohrmuschel-bezogenen Übertragungsfunktion vorgestellt, gefolgt von zwei MATLAB-Toolboxen, die von finnischen bzw. britischen Forschungsgruppen entwickelt wurden.

Modell der Ohrmuschel-bezogenen Übertragungsfunktion nach Spagnol

[Bearbeiten]

Der nachfolgende Abschnitt ist vollständig dem von S. Spagnol, M. Geronazzo und F. Avanzini veröffentlichten Artikel entnommen [6].

Darin präsentieren Spagnol et. al. ein Modell, welches den Frequenzgang der Ohrmuschel abbildet (engl. Pinna-Related Transfer Function, PRTF). Das Modell besteht aus zwei seriellen Filterblöcken, welche zum einen die Resonanz und zum anderen die Reflexion der Ohrmuschel modellieren.

Im relevanten Frequenzbereich der Ohrmuschel[6] gibt es zwei wesentliche Resonanzen, welche durch schmale Bandpassfilter zweiter Ordnung (peak filter) mit dargestellt werden können [7].

wobei

und der Abtastfrequenz, der Mittenfrequenz und G der Kerbentiefen (engl. Notch depth) entspricht.

Die Reflexion wird mit drei seriellen Bandsperr-Filter zweiter Ordnung [8] modelliert, deren Parameter die Mittenfrequenz , Kerbentiefe , und Bandbreite umfassen.

Durch Kaskadierung der beiden parallelen Bandpass-Filter mit den drei seriellen Bandsperr-Filter einsteht ein Filter achter Ordnung. Spagnol et. al. konnten zeigen, dass dieser Filter den realen RPTF effektiv abbildet. Das Modell kann jedoch aufgrund der Beschränkung der Grenzfrequenz fehlende Bandsperren aufweisen. Weiter führen nicht modellierte Resonanzen zu Näherungsfehlern.

HUTear MATLAB Toolbox

[Bearbeiten]

HUTear ist eine MATLAB-Toolbox für die Gehörmodellierung, welche vom Labor für Akustik und Audiosignalverarbeitung der Technischen Universität Helsinki entwickelt wird[9]. Die Open-Source-Toolbox kann von hier heruntergeladen werden.

Das Modell enthält ein Modul für die Simulation des Außen- und Mittelohrs (engl. Outer and Middle Ear simulation, OME). Das OME-Modul wurde auf der Grundlage von Glassberg und Moor [10] entwickelt. Der verwendete Filter ist üblicherweise linear und wird unter Einbeziehung der Korrekturen Equal Loudness Curves at 60 dB (ELC), Minimum Audible Field (MAF) und Minimum Audible Pressure at ear canal (MAP) erstellt. Durch Parametrisierung lassen sich die MAP-IIR-Näherung und die MAP-Daten vergleichen, wie in der Abbildung unten dargestellt.

MATLAB MODEL der auditiven Peripherie

[Bearbeiten]Das MATLAB MODEL der auditiven Peripherie (engl. Model Auditory Periphery, MAP) wurde von Forschern des Hearing Research Lab an der University of Essex in England entwickelt [11]. Es handelt sich um ein Computermodell der Gehör-Physiologie und ist ein offen zugängliches Software-Paket, das von hier heruntergeladen werden kann. Die Struktur des Modells ist in der rechten Abbildung dargestellt.

MAP enthält das Untermodul Outer Middle Ear (OME), welches die Resonanzfunktion des äußeren Mittelohrs modelliert. Diese setzt sich zusammen aus zwei parallelen Bandpassfiltern, welche die Concha-Resonanz und die Resonanz des äußeren Gehörgangs abbilden. Beide Filter werden über ihren jeweiligen Durchlass-Frequenzbereich, die Verstärkung und die Ordnung spezifiziert. Durch Addition des gefilterten Signals zur ursprünglichen Schalldruckwelle resultiert das "Ausgangssignal" des äußeren Mittelohrs. Um das OME-Modell zu testen, muss die Funktion testOME.m ausgeführt werden. Es wird eine Abbildung angezeigt, die die Außenohrresonanzen und die maximale Verschiebung des Steigbügels darstellt. (wie in der Abbildung links dargestellt)

Zusammenfassung

[Bearbeiten]Die Resonanz- und Reflexionswirkung auf den ankommenden Schall durch das Außenohr, einschließlich Ohrmuschel und äußerem Gehörgang, kann als linearer Filter oder als Filterbank simuliert werden. Da die Form der Ohrmuschel von Person zu Person unterschiedlich ist, sind auch die Modellparameter wie Resonanzfrequenzen individuell zu wählen.

Ein Aspekt, der in den oben beschriebenen Modellen nicht berücksichtigt wird, ist die kopfbezogene Übertragungsfunktion (engl. Head-Related Transfer Function, HRTF). Die HRTF beschreibt, wie das Ohr den Schall von einer punktförmigen Schallquelle im Raum empfängt. Sie wird hier nicht weiter erläutert, da sie über die Wirkungsweise des Außenohrs hinausgeht und auch die komplexe Filterwirkung von Kopf und Rumpf beschreibt. Es gibt eine Menge an Literatur und Publikationen zu HRTF, z.B.: wiki, tutorial 1, 2 und reading list for spatial audio research including HRTF

Simulation des Innenohrs

[Bearbeiten]Die Form und der Aufbau der Basilarmembran führen dazu, dass einzelne Membranabschnitte durch dedizierte Frequenzen besonders stark in Resonanz versetzt werden. Dies führt zu einer tonotopischen Organisation der Empfindlichkeit für Frequenzbereiche entlang der Membran, welche als eine Reihe sich überlappender Bandpassfilter modelliert werden kann: die "Auditorischen Filter" [12]. Die auditorischen Filter sind Punkten entlang der Basilarmembran zugeordnet. Sie modellieren die Frequenzselektivität der Cochlea und damit die Unterscheidung zwischen verschiedenen Tönen durch den Hörer [13]

Filter mit einer Selektivität für hohe Frequenzen korrespondieren mit der Basis der Cochela, während Filter für tiefe Frequenzen dem oberen Ende der Cochlea zugeordnet werden. Alle Filter sind nichtlinear und pegelabhängig [14] Die Bandbreite der auditiven Filter wird auch als Frequenzgruppe oder kritische Frequenzbandbreite bezeichnet.

Ein weiteres Konzept im Zusammenhang mit dem auditorischen Filter ist die äquivalenten Rechteckbandbreite (engl. Equivalent Rectangular Bandwidth, ERB). Die ERB zeigt die Beziehung zwischen dem auditorischen Filter, der Frequenz und der kritischen Bandbreite auf. Ein ERB lässt dieselbe Energiemenge durch wie der entsprechende auditorische Filter und zeigt, wie dieser sich in Abhängigkeit von der Eingangsfrequenz verändert [13]. Bei niedrigem Schallpegel wird das ERB nach Glasberg und Moore durch die folgende Gleichung angenähert:

wobei ERB in Hz und die Zentralfrequenz F in kHz ist.

Man geht davon aus, dass jede ERB etwa 0,9 mm auf der Basilarmembran entspricht [14].

Gammatonfilter

[Bearbeiten]

Ein Filtertyp, der zur Modellierung der auditorischen Filter verwendet wird, ist der "Gammatone-Filter". Er nutzt einen einfachen linearen Filter zur Beschreibung der Dislokation des korrespondierenden Basilarmembran-Abschnitts bei einem bestimmten Schalleingang. Lineare Filter werden gerne zur Modellierung verschiedener Aspekte des auditorischen Systems eingesetzt, da diese leicht zu implementieren ist.

Im Allgemeinen handelt es sich dabei um IIR-Filter (engl. Infinite Impulse Response, IIR) mit Vorwärts- und Rückkopplung, die wie folgt definiert sind:

mit .

Die Koeffizienten ai und bj bestimmen diesen Filtertyp eindeutig. Der Rückkopplungscharakter wird deutlicher, wenn man die Gleichung umformt

Im Gegensatz dazu sind FIR-Filter, also Filter mit endlicher Impulsantwort, nur vorwärts gerichtet: für sie gilt für i>1*)

Lineare Filter können die nichtlinearen Aspekte des auditorischen Systems nicht berücksichtigen. Dennoch werden sie in einer Vielzahl von Modellen des auditorischen Systems verwendet. Die Impulsantwort des Gammatons ist gegeben durch

wobei für die Frequenz, für die Phase des Trägersignals, für die Amplitude, für die Ordnung des Filters, für die Bandbreite des Filters und für die Zeit steht.

Dies ergibt eine Sinuskurve mit einer Amplitudenhüllkurve, die einer skalierten Gammaverteilungsfunktion entspricht.

Als Variationen und Verbesserungen des Gammatone-Filter sind unter anderem der Gammachirp-Filter, der Ganzpol- und der 0-1-Gammatone-Filter, der zweiseitige Gammatone-Filter und Filterkaskadenmodelle sowie verschiedene pegelabhängige und dynamisch nichtlineare Versionen dieser Modelle zu nennen [15]. Für Computersimulationen stehen effiziente Implementierungen von Gammatone-Modellen in Matlab und Python [16] zur Verfügung.

Mit Hilfe der Gammatone-Filtern und dem Parseval-Theorem lässt sich ausserdem die Energie in einem bestimmten Frequenzband bestimmen:

Perzeptive Audiokodierung und Filtereigenschaften der Cochlea

[Bearbeiten]Der folgende Abschnitt diskutiert die grundlegenden Mechanismen der perzeptiven Audiokodierung. Die zugrundeliegenden psychoakustischen Prinzipien werden erläutert und die Beziehung zu den Filtereigenschaften der Cochlea und höheren kortikalen Verarbeitungsstufen aufgezeigt.

Perzeptive Audiokodierung

[Bearbeiten]Mp3 (MPEG-1 Layer 3, Vorgänger von MPEG-2 und MPEG-4 Advanced Audio Coding (AAC)) ist das wohl bekannteste Audioformat, das die perzeptive Kodierung von Audiosignalen nutzt. AAC ist eine effizientere Erweiterung, erzielt im Allgemeinen eine bessere Klangqualität und ermöglicht eine größere Bandbreite, beruht aber auf denselben Kodierungsprinzipien wie Mp3. Beide Formate sind von ISO und IEC genormt, aber nur der Decoder ist vollständig spezifiziert, die Implementierung des Encoders bleibt offen. Dies führte zu einer Vielzahl von verfügbaren Encodern, die sich in der Wiedergabequalität, der erzielten Bitrate, der Leistung und der Kodiereffizienz unterscheiden [17].

Klassische Komprimierungs-Algorithmen verfolgen in der Regel das Ziel, Informationen mit einer minimalen Anzahl von Bits darzustellen und dabei die Qualität der Signalwiedergabe beizubehalten. Im Gegensatz dazu berücksichtigt die perzeptive Audiokodierung das Wissen um das menschliche Gehör und reduziert die Bitrate durch das Entfernen von Informationen, die für die meisten Hörer irrelevant sind. Diese verlustbehaftete Komprimierung wird durch Ausnutzung der Eigenschaften des menschlichen Gehörs und statistischer Redundanzen erreicht. Die übliche Bitrate für MP3 ist 128 kbit/s, und effiziente Kodierer erreichen bei der Komprimierung von Audiodaten in CD-Qualität (16bit PCM, 44.1 kHz, ~1411kBit/s) in der Regel eine Datenreduzierung um den Faktor 10. Anders ausgedrückt: Etwa 90 % der auf einer CD gespeicherten Daten können vom Hörer nicht wahrgenommen werden.

CD-Qualität ist das, was die Nutzer beim Musikhören in der Regel erwarten. Es gibt eine lange Debatte darüber, ob CD-Qualität gut genug ist, um den analogen Originalton zu reproduzieren. Unter den vielen verschiedenen Expertenmeinungen sind diese beiden Referenzen [17][18]. für die weitere Lektüre interessant. Die Notwendigkeit einer effizienteren Audiokodierung ergibt sich aus Netzwerk-, Multimediasystem- und Speicheranwendungen, und Mp3 wurde ursprünglich für die effizientere Übertragung von audiovisuellen Inhalten entwickelt.

Das theoretische Limit der perzeptiven Audiokodierung wurde von Johnston [19] untersucht, was zu dem Begriff der perzeptiven Entropie führte. Auf der Grundlage von Messungen wurde die perzeptive Entropie für Audio in CD-Qualität auf etwa 2 Bit pro Sample geschätzt. Moderne Kodierer bestätigen dies und erreichen eine vergleichbare Effizienz. Die Qualität eines perzeptiven Kodierungsalgorithmus wird in der Regel durch Hörtests und jüngst auch in Kombination mit einem standardisierten Algorithmus für die objektive Messung der wahrgenommenen Audioqualität, der Perceptual Evaluation of Audio Quality (PEAQ), bewertet.

Grundlegende Architektur eines perzeptiven Audiokodierers

[Bearbeiten]

Die für perzeptiven Audiokodierer übliche Grundarchitektur ist in der Abbildung rechts dargestellt. Die Filterbank abstrahiert die zeitlichen und spektralen Signalverarbeitung des menschlichen Gehörs. Die Audioeingabe wird in Segmente unterteilt, die in eine Reihe von Parametern umgewandelt werden, welche wiederum quantisiert und kodiert werden können. Die Quantisierungs- und Kodierungsphase nutzt statistische Redundanzen und stützt sich auf Schwellenwerte, die vom perzeptiven Wahrnehmungsmodell abgeleitet sind. Weiter liefert das perzeptive Wahrnehmungsmodell Schwellen für die Maskierung als Funktion der Frequenz. In der abschliessenden Kodierungsphase werden verlustfreie Kodierungstechniken wie die Huffman Kodierung verwendet. Für eine technische Erklärung des Algorithmus und eine Beispielimplementierung wird hiermit auf die Online-Bücher von J.O.Smith verwiesen.

Psychoakustisch Prinzipien der perzeptiven Audiokodierung

[Bearbeiten]Auditive Maskierung beschreibt ein Phänomen, bei dem die Wahrnehmung eines Geräuschs durch die Anwesenheit eines anderen Geräuschs beeinträchtigt wird. Maskierungseffekte treten sowohl im Frequenzbereich (simultane Maskierung) als auch im Zeitbereich (nicht-simultane Maskierung) auf. Die grundlegende Idee der perzeptiven Audiokodierung besteht darin, das Quantisierungsrauschen so zu verändern, dass es durch das eigentliche Audiosignal maskiert wird und daher vom Hörer nicht wahrgenommen werden kann.

Dies wird durch die Nutzung psychoakustischer Prinzipien wie der Schwelle des absoluten Gehörs, der Analyse der kritischen Frequenzbänder und der auditorischen Maskierung erreicht [20]. Da der Wiedergabepegel in der Kodierungsphase oft nicht bekannt ist, werden in der Regel konservative Schätzungen der absoluten Hörschwelle zur Signalnormalisierung verwendet.

Simultane Maskierung

[Bearbeiten]

Bei der simultanen Maskierung spielt die Frequenzauflösung der Cochlea eine zentrale Rolle. In der Cochlea findet eine Frequenz-Ort-Umwandlung statt, und es ergeben sich unterschiedliche Bereiche, die auf verschiedene Frequenzbänder abgestimmt sind. Diese unterschiedlichen Frequenzbereiche werden als kritische Bandbreite des Hörens oder Frequenzgruppe bezeichnet. Die kritische Bandbreite bleibt in der Regel konstant ≈ 100 Hz bis 500 Hz und steigt oberhalb von 500 Hz auf etwa 20 % der Zentralfrequenz an [20]. Die ersten 24 Frequenzgruppen werden durch die Bark-Skala beschrieben. Ein Ton führt zur Erregung der Basilarmembran, was die Erkennungsschwelle für einen zweiten Ton innerhalb derselben Frequenzgruppe beeinflusst (Intrabandmaskierung). Darüber hinaus werden auch benachbarte Frequenzgruppen beeinflusst (Interbandmaskierung). Die Beeinflussung benachbarter Gruppen wird durch die Spreading-Funktion beschrieben.

Die Abbildung auf der rechten Seite zeigt eine empirisch ermittelte Spreading-Funktion. Wie in der Abbildung dargestellt, ist die Maskierung von höheren Frequenzgruppen effizienter als die von niedrigeren Frequenzgruppen, was als upward spreading der Maskierung bezeichnet wird. Es wird vermutet, dass diese Ausbreitung ein Nebenprodukt der mechanischen Filtereigenschaften der Cochlea ist, bei der die äußeren Haarzellen die Bewegung der Basilarmembran verstärken um so die Frequenzauflösung zu erhöhen [21]. Der Grund für die Ausbreitung der Maskierung ist allerdings nicht abschliessend geklärt, und neben der mechanischen Anregung könnte auch Unterdrückung eine Rolle spielen [22]. Weiter zeigt die ermittelte Spreading-Funktion auch nichtlineare Übertragungscharakteristik des Innen- und Mittelohrs, wodurch bei höheren Schalldruckpegeln ein zweiter Ausschlag um 2 kHz (die zweite Harmonische von 1 kHz) auftritt.

Das Vorliegen eines starken Rausch- oder Tonmaskierers erzeugt somit eine ausreichend starke Anregung an der Basilarmembran, um die Übertragung eines schwächeren Signals in seiner Frequenzgruppe wirksam zu blockieren. Weiter sind durch die Ausbreitung der Maskierung auch benachbarte Gruppen betroffen.

Es werden zwei Arten von simultaner Maskierung beobachtet:

- Rauschen wird durch das Signal maskiert. Es lässt sich einen unteren Schwellenwert für das Rauschen ermitteln, sodass es durch ein gegebenes Signal gerade noch maskiert wird.

- Das Signal wird durch Rauschen maskiert. Es lässt sich einen oberen Schwellenwert für das Rauschen ermitteln, sodass es ein Signal vollständig maskiert.

Bei der perzeptiven Kodierung werden diese Schwellenwerte basierend auf der Zeit-Frequenz-Analyse interpoliert. Anschliessend wird die Spreading-Funktion berücksichtigt. Das objektive Signal-Rausch-Verhältnis (SNR) kann sehr niedrig sein während das subjektive SNR hoch genug ist, um eine für den Höhrer transparente Kodierung zu erreichen [21].

Nicht-simultanes Maskieren

[Bearbeiten]

Akustische Reize in Musik oder Sprache sind oft charakterisiert durch einen Einschwingvorgang: Einen kurzen, hochfrequenten und nicht-periodischen Ausschlag zu Beginn des Tones, der beispielsweise beim Klavier durch den Anschlag einer Taste entsteht.

Diese sogenannten Transiente können Maskierungseffekte im Zeitbereich verursachen. Die Wahrnehmung vor und nach dem Einschwingvorgang ist betroffen, wie in der Abbildung dargestellt. Der Bereich der Rückwärtsmaskierung dauert in der Regel wenige Millisekunden, der Bereich der Vorwärtsmaskierung dauert deutlich länger [20].

Dieses Phänomen ist nicht vollständig verstanden und ein aktives Forschungsthema. Es gibt jedoch Hinweise darauf, dass eine höhere kortikale Verarbeitungsstufe daran beteiligt ist. Es ist jedoch unklar, ob dieser Effekt mit der Integration von Geräuschen, der Unterbrechung oder Hemmung der neuronalen Verarbeitung und/oder Unterschieden in den Übertragungsgeschwindigkeiten zusammenhängt. Vorwärts- und Rückwärtsmaskierung weisen unterschiedliche Merkmale auf und sind daher vermutlich auf unterschiedliche Eigenschaften des menschlichen Hörsystems zurückzuführen [23].

Maskierung und Joint Stereo Kodierung (Kanalkoppelung)

[Bearbeiten]Eine effiziente Technik, die bei der Audiokodierung häufig zum Einsatz kommt, ist die Kanalkopplung. Da der linke und der rechte Audiokanal eines Audiosignals in der Regel stark korreliert sind, ist es manchmal effizienter, eine Summen- bzw. Differenzkodierung (L-R, L+R) des Audiosignals durchzuführen. Im Fall von MP3 wurde dieses Potenzial leider nicht voll ausgeschöpft.

Ein effizientes Verfahren würde die Schwellenwerte für Links/Rechts- und Summen-/Differenzkodierung vergleichen und dynamisch den effizientesten Schwellenwert wählen. Bei der Berechnung der Schwellenwerte ist besondere Vorsicht geboten, da die Kanalkoppelung beim binauralen Hören wahrnehmbare Artefakte verursachen kann [21].

Da der Kompressionsfaktor inhaltsabhängig ist, wird bei Mp3 und AAC stattdessen die Kodier-Bitrate festgelegt: Eine niedrigere Bitrate führt zu einem höheren Kompressionsverhältnis und eine höhere Bitrate zu einem niedrigeren Kompressionsverhältnis. Letztere verringert die Wahrscheinlichkeit für mögliche Artefakte. Als Folge ergibt sich ein optimaler Arbeitsbereich (Bitrate), in dem ein bestimmter Algorithmus am besten funktioniert, während sich bei noch höherer Bitrate die Qualität nur geringfügig verbessert [17].

Im Gegensatz zu Rausch- und Verzerrungsartefakten von Abspielgeräten, an die wir alle beim Hören von CDs gewöhnt sind, können Artefakte von perzeptiven Encodern als störend empfunden werden. Wenn die Bitrate für eine transparente Kodierung zu niedrig ist, lassen sich Rauschen und Verzerrungen als zeitvariantes Signal beschreiben. Aufgrund der sich von Frame zu Frame ändernden Bandbreite sind die Verzerrungen nicht mehr harmonisch zusammenhängend. Das Ergebnis kann daher grob klingen [17].

Bandbreitenverlust

[Bearbeiten]Um eine gegebene Bitrate zu erreichen, suchen Kodierer einen Kompromiss zwischen der Frequenzbandbreite und der Abdeckung von niedrigen Frequenzen. Da grosse Unterschiede in der Bandbreite zwischen den Frames als störend empfunden wird, wirken Kodierer diesem Artefakt im Allgemeinen durch eine Begrenzung der maximalen Bandbreite entgegen.

Preecho (Vorhall)

[Bearbeiten]Der Vorhall wird durch die Framegröße des perzeptiven Encoders bestimmt und ist das am schwierigsten zu vermeidende Artefakt. Abrupte Transiente in der Mitte eines Frames können sich über die Rückwärtsmaskierung ausbreiten und somit hörbar werden. Es gibt verschiedene Techniken, um das Auftreten von Vorhall zu minimieren, z. B. eine Analysefilterbank mit variabler Framegröße [17].

Beziehung zu den Filtereigenschaften der Cochlea

[Bearbeiten]Die perzeptive Kodierung nutzt aktuelle Erkenntnisse über die Eigenschaften des menschlichen Gehörs. Die Cochlea sowie akustischen und mechanischen Eigenschaften des Mittel- und Außenohrs bestimmen die absolute Hörschwelle. Bei der simultanen Maskierung ergeben sich die Maskierungsschwellen innerhalb und zwischen den kritischen Bändern (die Spreading Funktion) aus den Filtereigenschaften der Cochlea.

Andere Phänomene, wie das "upward spreading" der Maskierung, sind jedoch nicht abschliessend durch die Eigenschaften der Cochlea zu erklären. Der Effekt der zeitlichen Maskierung sowie Artefakte bei der lassen auf den Einfluss einer höheren kortikalen Verarbeitung im Hörsystem schliessen.

Menschliche Sprache

[Bearbeiten]Terminologie

[Bearbeiten]Die Schallintensität wird in der Regel in Dezibel (dB) ausgedrückt, definiert als

wobei der Schalldruckpegel (engl. Sound Pressure Level, SLP) in dB und dem Referenzdruck entspricht. Man beachte, dass dieser Wert deutlich kleiner ist als der Luftdruck (ca. 105 N/m2). Oft wird Schall relativ zur Hörschwelle angegeben:

- 0 - 20dB SPL ...Hörschwelle (0dB für sinusoidale Töne von 1 kHz - 4 kHz)

- 60 dB SPL ...mittellauter Ton, gesprochene Sprache

Die Grundtonfrequenz, die sich aus den Schwingungen der Stimmbänder im Kehlkopf ergibt, beträgt bei erwachsenen Männern etwa 120 Hz, bei erwachsenen Frauen 250 Hz und bei Kindern bis zu 400 Hz.

Die dominanten Frequenzen in der menschlichen Sprache werden als Formanten bezeichnet. Sie werden durch Resonanz und Interferenzeigenschaften des Mundes verstärkt und zeigen sich als deutliche Ausschläge der Energie im Frequenzspektrum. Sie sind in aufsteigender Reihenfolge nummeriert, beginnend mit dem Formant der niedrigsten Frequenz.

Sprache wird oftmals als eine Abfolge von akustischen Einheiten betrachtet, die Phon genannt werden und sprachlichen Einheiten, den Phonemen, entsprechen. Phoneme sind die kleinsten Lauteinheiten, anhand derer verschiedene Wörter unterschieden werden können. Das Wort "dog" zum Beispiel enthält drei Phoneme. Änderungen am ersten, zweiten und dritten Phonem ergeben die Wörter "log", "dig" und "dot". Die deutsche und englische Sprache verfügen über etwa 40 verschiedene Phoneme, die als /d/, /o/, /g/ für das Wort "dog" angegeben sind.

Sprachwahrnehmung

[Bearbeiten]Während die automatische Spracherkennung in Umgebungen mit hohem Signal-Rausch-Verhältnis recht erfolgreich ist, nimmt die Leistung der existierenden Algorithmen im Vergleich zu Menschen überproportional ab, sobald die Bedingungen nicht mehr ideal sind. Es scheint demnach, dass die heute verwendeten Algorithmen zur Spracherkennung noch nicht annähernd an den "Algorithmus" herankommen, den der Mensch zur Spracherkennung verwendet.

Es ist erwiesen, dass im Gehirn die Wahrnehmung von Sprache auf einem anderen Verarbeitungspfad beruht als die Wahrnehmung anderer Klänge. Studien haben gezeigt, dass die Reaktion auf nicht-sprachliche Geräusche im Allgemeinen mit dem Stimulus korreliert, während bei der Verarbeitung von Sprache eine Diskretisierung der Reaktion festgestellt werden konnte.

Lisker und Abramson [24] konnten zeigen, dass die temporale Organisation eines Lautes dessen Identifizierung beeinflusst. So scheint das Einsetzen der Stimme nach dem Abspielen der Phonemen /b/ oder /p/ (Voice Onset Time, VOT) massgeblich für deren korrekte Klassifizierung. Bei einer gleichmäßigen Variation der VOT konnte ein Schwellenwert von ~20 ms festgestellt werden, bei dem die Versuchspersonen ihre Identifizierung von /b/ auf /p/ umstellten. Dies belegt, dass eine Art von Kategorisierungsschema vorliegt.

Die Herausforderung bei der Modellierung der Sprachwahrnehmung ist die so genannte "fehlende Invarianz" (engl. Lack of Invariance) im Sprachsignal. Die Varianz entsteht insbesondere durch die Position eines Phonems im gesprochenen Wort, wie beispielsweise /p/ in "Position" respektive "Sprache". Ein einzelnes Phonem kann somit einer Vielzahl von Wellenformen zugeordnet werden. Umgekehrt ist die Zuordnung einer Wellenform zu einem bestimmten Phonem stark kontextabhängig. Weiter kann eine Wellenform aufgrund von Faktoren wie dem Sprechtempo, der Identität des Sprechers und dem Ton, in dem er spricht, sehr unterschiedlich ausfallen. Dennoch ist der menschliche Hörer in der Lage, zuverlässig das richtige Ergebnis zu ermitteln.

Existierende Modelle der Sprachwahrnehmung lassen sich in zwei Klassen einteilen.

Passive Wahrnehmungsmodelle

[Bearbeiten]Passive Wahrnehmungstheorien definieren das Konzept der Sprachwahrnehmung im Allgemeinen auf dieselbe Weise wie die meisten Algorithmen zur Verarbeitung sensorischer Signale: Ein Eingangssignal wird an eine Verarbeitungs-Hierarchie übergeben, in der jeder Schritt ein zunehmend abstrakteres Signal aus dem Eingangssignal extrahiert.

Ein früher Vertreter der passiven Modelle war die Theorie der distinktiven Merkmale (engl. distinktive Feature). Aus dem Spektogramm des Eingangssignal werden dabei eine Reihe von artikulatorischen Merkmalen extrahiert, zum Beispiel ober der Laut nasal/oral oder stimmhaft/nicht stimmhaft gesprochen ist. Diese Merkmale werden als binärer Vektor zusammengefasst und als die wesentlichen Eigenschaften eines Phonems verstanden.

Andere passive Modelle, wie die von Selfridge[25] und Uttley [26] beschriebenen, beruhen auf einer Art Musterabgleich. Auch hier extrahiert eine Hierarchie von Verarbeitungsebenen Merkmale, die zunehmend abstrakt und bezüglich irrelevanten Eigenschaften (wie der Identität des Sprechers bei der Klassifizierung von Phonemen) invariant sind.

Aktive Wahrnehmungsmodelle

[Bearbeiten]Die Theorien der aktiven Wahrnehmung stellen eine völlig andere Sichtweise auf die Sprachwahrnehmung dar. Vertreter dieser Theorien argumentieren, dass es für das Gehirn energetisch ungünstig wäre, getrennte Systeme für die Sprach-Wahrnehmung und -Produktion zu verwenden. Als Schlussfolgerung wäre die Fähigkeit der Sprachwahrnehmung sehr eng mit der Sprachsynthese verbunden: Es wird vermutet, dass der initiale Versuch einer simplen Replikation des Gehörten essenziell für die Sprachwahrnehmung ist und die entsprechenden neuralen Schaltkreise sowohl für die Identifizierung als auch die Synthese der Phoneme zuständig sind.

Die motorische Theorie der Sprachwahrnehmung (Liberman et al., 1967) besagt, dass Sprachlaute nicht durch irgendeine Art Musterabgleich identifiziert werden, sondern indem die sprachgenerierenden Mechanismen eine möglichst ähnliche Version des gehörten Sprachsignals erzeugen. Phoneme wären demnach nicht als distinktives Merkmal für die Spracherkennung, sondern als Anhaltspunkte (engl. Cue) im prämotorischen Signal für den sprachgenerierenden Mechanismus zu verstehen. Die Theorie postuliert, dass die sprachgenerierenden Regionen des Gehirns durch Rückkoppelung mit dem Hörzentrum lernen, welches prämotorische Signal zu welchem Laut führt. Das Lallen von Babys, so wird argumentiert, diene dem Erlernen der Synthese dieser "Cue"-Laute aus dem prämotorischen Signal[27].

Eine ähnliche Idee wird im Modell der Analyse durch Synthese von Stevens und Halle verfolgt[28]. Die Autoren beschreiben ein generatives Modell, das versucht, ein zum eingehenden Ton ähnliches Signal zu erzeugen. Dieser Ansatz macht sich die Tatsache zunutze, dass die Mechanismen der Spracherzeugung bei allen Menschen ähnlich sind und dass die charakteristischen Merkmale der Sprache vom Sprecher reproduziert werden können.

Während man den Ton hört, versuchen die Sprachzentren, das eintreffende Signal zu reproduzieren. Komparatoren liefern ein ständiges Feedback über die Qualität der Reproduktion. Die Wahrnehmung basiert demnach nicht auf der Abstraktion des ankommenden Schalls sondern vielmehr auf den prämotorischen Befehlen zur Erzeugung derselben Sprache.

Die motorischen Theorien erhielten einen schweren Schlag durch eine Reihe von Studien bezüglich der Broca-Aphasie. Diese neurologische Erkrankung verhindert die Sprachsynthese, ohne dabei das Sprachverständnis und damit die Fähigkeit der Sprachwahrnehmung zu beeinträchtigen. Die Existenz der Broca-Aphasie scheint demnach der Vorhersage der motorischen Theorie zu widersprechen, dass Produktion und Wahrnehmung von denselben Schaltkreisen gesteuert werden [29]

Aktuelle Modelle

[Bearbeiten]

Eines der einflussreichsten Computermodelle der Sprachwahrnehmung ist TRACE [30], welches im Aufbau einem rückgekoppelten neuronalen Netz mit drei Schichten gleicht.

Die erste Schicht extrahiert temporale Merkmale aus dem Spektrogramm und simuliert damit im Grunde die Cochlea. Die zweite Schicht extrahiert Phoneme und die dritte Schicht bildet Wörter. Das Modell enthält exzitatorische Feed-Forward-Verbindungen (bottom-up, blau), laterale inhibitorische Verbindungen (rot) und exzitatorische Feedback-Verbindungen (top-down, grün). Im Modell entspricht jedes "Neuron" einer Wahrnehmungseinheit (zum Beispiel dem Phonem /p/ oder dem Wort "Phonem").

Die Architektur des Modells ist so ausgelegt, dass die Einheiten innerhalb einer Schicht auf der Grundlage ihres Inputs um den stärksten Output konkurrieren. Die lateralen inhibitorischen Verbindungen führen zu einer Art "Winner-takes-all"-Schaltung, bei der die Einheit mit dem stärksten Input ihre Nachbarn hemmt. Die Rückkopplungsverbindungen wiederum modellieren den Kontext, sodass beispielsweise Anfang und Ende eines Wortes die Erkennung eines Phonems beeinflussen können.

Referenzen

[Bearbeiten]Dieses Kapitel ist eine reine Übersetzung von https://en.wikibooks.org/wiki/Sensory_Systems/Computer_Models/Auditory_System_Simulation, für eine komplette Auflistung der Quellen wird auf den englischen Text/Link verwiesen.

- ↑ Thomas Haslwanter (2012). "Short Time Fourier Transform [Python]". private communications

- ↑ Semple, M.N. (1998), "Auditory perception: Sounds in a virtual world", Nature (Nature Publishing Group) 396 (6713): 721-724, doi:10.1038/25447

- ↑ 3,0 3,1 http://tav.net/audio/binaural_sound.htm

- ↑ 4,0 4,1 Shaw, E.A.G. (1997), "Acoustical features of the human ear", Binaural and spatial hearing in real and virtual environments (Mahwah, NJ: Lawrence Erlbaum) 25: 47

- ↑ Federico Avanzini (2007-2008), Algorithms for sound and music computing, Course Material of Informatica Musicale (http://www.dei.unipd.it/~musica/IM06/Dispense06/4_soundinspace.pdf), pp. 432

- ↑ 6,0 6,1 6,2 6,3 Spagnol, S. and Geronazzo, M. and Avanzini, F. (2010), "Structural modeling of pinna-related transfer functions", In Proc. Int. Conf. on Sound and Music Computing (SMC 2010) (barcelona): 422-428

- ↑ S. J. Orfanidis, ed., Introduction To Signal Processing. Prentice Hall, 1996.

- ↑ U. Zölzer, ed., Digital Audio Effects. New York, NY, USA: J.Wiley & Sons, 2002.

- ↑ http://www.acoustics.hut.fi/software/HUTear/

- ↑ Glasberg, B.R. and Moore, B.C.J. (1990), "Derivation of auditory filter shapes from notched-noise data", Hearing research (Elsevier) 47 (1-2): 103-138

- ↑ http://www.essex.ac.uk/psychology/department/research/hearing_models.html

- ↑ Munkong, R. (2008), IEEE Signal Processing Magazine 25 (3): 98--117, doi:10.1109/MSP.2008.918418, Bibcode: 2008ISPM...25...98M

- ↑ 13,0 13,1 13,2 Moore, B. C. J. (1998). Cochlear hearing loss. London: Whurr Publishers Ltd.. ISBN 0585122563.

- ↑ 14,0 14,1 Moore, B. C. J. (1986), "Parallels between frequency selectivity measured psychophysically and in cochlear mechanics", Scand. Audio Suppl. (25): 129–52

- ↑ R. F. Lyon, A. G. Katsiamis, E. M. Drakakis (2010). "History and Future of Auditory Filter Models". Proc. ISCAS. IEEE.

- ↑ T. Haslwanter (2011). "Gammatone Toolbox". private communications.

- ↑ 17,0 17,1 17,2 17,3 17,4 Karlheinz Brandenburg. Mp3 and aac explained. In Audio Engineering Society Conference: 17th International Conference: High-Quality Audio Coding. Audio Engineering Society, 1999.

- ↑ J. R. Stuart for Acoustic Renaissance for Audio. A proposal for the high-quality audio application of high-density CD carriers. 1995.

- ↑ James D Johnston. Estimation of perceptual entropy using noise masking criteria. In Proceedings of the International Conference on Acoustics, Speech, and Signal Processing of the IEEE 1988.

- ↑ 20,0 20,1 20,2 Ted Painter and Andreas Spanias. A review of algorithms for perceptual coding of digital audio signals. In Proceedings of the 13th International Conference on Digital Signal Processing of the IEEE 1997.

- ↑ 21,0 21,1 21,2 21,3 Nikil Jayant, James Johnston, and Robert Safranek. Signal compression based on models of human perception. Proceedings of the IEEE, 81(10):1385-1422, 1993.

- ↑ Andrew J Oxenham and Christopher J Plack. Suppression and the upward spread of masking. The Journal of the Acoustical Society of America, 104(6):3500-3510, 1998.

- ↑ Renata Filippini. Unmasking auditory temporal masking, 2015. http://hearinghealthmatters.org/pathways/2015/unmasking-auditory-temporal-masking/

- ↑ Lisker, L.; Abramson (1970). "The voicing dimension: Some experiments in comparative phonetics". in B. Hála, M. Romportl and P. Janota. Proceedings of the 6th International Congress of Phonetic Sciences. Prague: Academia.

- ↑ Selfridge, O.C (1959) "Pandemonium: a paradigm for learning". in Proceedings of the Symposium on Mechanisation of Thought Process. National Physics Laboratory.

- ↑ Uttley, A.M. (July 1966). "The transmission of information and the effect of local feedback in theoretical and neural networks". Brain Research 2 (1): 21–50. doi:10.1016/0006-8993(66)90060-6.

- ↑ Liberman, A. M.; Mattingly, I. G.; Turvey (1967). "Language codes and memory codes". in Melton, A. W.; Martin, E.. Coding Processes in Human Memory. V. H. Winston & Sons. pp. 307-334.

- ↑ Stevens, K. N.; Halle, M. (1967). "Remarks on analysis by synthesis and distinctive features". in Wathen-Dunn, W.. Models for the perception of speech and visual form: proceedings of a symposium. Cambridge, MA: MIT Press. pp. 88–102.

- ↑ Hickok, Gregory (January 2010). "The role of mirror neurons in speech and language processing". Brain and Language 112 (1): 1–2. doi:10.1016/j.bandl.2009.10.006.

- ↑ McClelland, James L; Elman, Jeffrey L (January 1986). "The TRACE model of speech perception". Cognitive Psychology 18 (1): 1–86. doi:10.1016/0010-0285(86)90015-0.