Physikalische Grundlagen der Nuklearmedizin: Druckversion

Dieser Text ist sowohl unter der „Creative Commons Attribution/Share-Alike“-Lizenz 3.0 als auch GFDL lizenziert.

Eine deutschsprachige Beschreibung für Autoren und Weiternutzer findet man in den Nutzungsbedingungen der Wikimedia Foundation.

Atom-und Kernstruktur

Einleitung

Der Großteil der Inhalte dieses Kapitels entspricht dem Stoff des Fachs Physik an Gymnasien. Um die Grundlage für die nachfolgenden Kapitel zu bilden, wird dieser Stoff hier nochmals behandelt. Dieses Kapitel soll also vorrangig dazu dienen, bereits Erlerntes wieder aufzufrischen.

Atomstruktur

Das Atom ist ein grundlegender Baustein der gesamten Materie. Ein einfaches Modell des Atoms besagt, dass es aus zwei Komponenten besteht: Einem Atomkern, welcher von einer Hülle aus Elektronen (siehe auch Elektronenhülle) umgeben ist.

Der Atomkern ist elektrisch positiv geladen, die Elektronen sind hingegen negativ geladen. Weil sich positive und negative Ladungen gegenseitig anziehen, ist die Elektronenhülle an den Kern gebunden.

Diese Situation hat eine gewisse Ähnlichkeit mit der „Hülle“ aus Planeten, die unsere Sonne umkreisen und durch die Schwerkraft an sie gebunden sind.

Der Radius eines Atoms beträgt ungefähr 10-10 Meter, während der Radius eines Atomkerns circa 10-14 Meter beträgt. Der Kern ist also etwa zehntausend mal kleiner als die Hülle. Analog dazu kann man sich einen Golfball in der Mitte eines Fußballstadions vorstellen. Der Golfball ist der Atomkern, das Stadion das Atom, und die Elektronen schwirren irgendwo im Bereich der Zuschauerplätze um das Stadion herum. Das bedeutet, dass das Atom hauptsächlich aus leerem Raum besteht. Jedoch ist die Situation weitaus komplexer als dieses einfache Modell, und wir werden uns später mit den physikalischen Kräften beschäftigen, welche das Atom zusammenhalten.

Chemische Phänomene sind die Wechselwirkungen zwischen den Elektronen verschiedener Atome. Verbinden sich zum Beispiel zwei Wasserstoffatome zu einem Wasserstoffmolekül so sind nur die Elektronen an der Bindung beteiligt, die Kerne bleiben von der Bindung weitgehend unbehelligt und tragen auch nicht zu ihr bei. Radioaktivität entsteht dagegen durch Veränderungen innerhalb eines Kerns . An ihr sind die Elektronen daher üblicherweise nicht beteiligt. (Eine Ausnahme ist der Zusammenstoß eines Elektrons mit einem Kern, den wir später unter Begriff Elektroneneinfang behandeln werden.)

Der Atomkern

Eine einfache Beschreibung des Atomkerns besagt, dass er aus Protonen und Neutronen zusammengesetzt ist. Diese zwei Bausteine werden kollektiv Nukleonen genannt, was bedeutet, dass sie Bausteine des Atomkerns (Latein. nucleus „Kern“) sind.

Wenn man die Massen der Nukleonen vergleicht, hat ein Proton etwa gleich viel Masse wie ein Neutron, aber beide sind 2000 mal schwerer als ein Elektron. Also ist der Großteil der Masse eines Atoms in seinem kleinen Kern konzentriert.

Elektrisch gesehen ist das Proton positiv geladen und das Neutron hat keine Ladung. Insgesamt ist ein Atom für sich gesehen elektrisch neutral (wobei freie Atome praktisch nur in Edelgasen vorkommen). Die Anzahl Protonen im Kern muss daher gleich der Anzahl der Elektronen, die den Atomkern umkreisen, sein.

Klassifikation der Atomkerne

Der Begriff Ordnungszahl (oder auch Kernladungszahl) ist in der Kernphysik als die Anzahl der Protonen im Atomkern definiert und hat das Symbol Z. Da es in einem Atom gleich viele Elektronen wie Protonen gibt, ist die Ordnungszahl gleich der Anzahl Elektronen im Atom. Ebenfalls werden in der Chemie die Elemente nach dieser Zahl im Periodensystem geordnet.

Die Massenzahl ist definiert als die Anzahl Nukleonen, also der Anzahl Protonen plus der Anzahl Neutronen. Sie hat das Symbol A.

Es ist möglich, dass Atomkerne eines bestimmten Elements zwar die gleiche Anzahl Protonen haben (was ja ein Element definiert), aber nicht unbedingt die gleiche Anzahl Neutronen, das heißt, dass sie dieselbe Ordnungszahl haben, aber nicht unbedingt die gleiche Massenzahl. Solche Atome nennt man Isotope. Alle Elemente haben Isotope und die Anzahl reicht von drei Wasserstoffisotopen bis zu über 30 Isotopen für Cäsium und Barium. Die Chemie bezeichnet die verschiedenen Elemente auf eine relativ einfache Art mit Symbolen wie H für Wasserstoff (engl. hydrogen) oder He für Helium. Das Klassifikationsschema zur Identifikation unterschiedlicher Isotope basiert darauf, vor das Elementsymbol die hochgestellte Massenzahl und die tiefgestellte Kernladungszahl zu schreiben; die Kernladungszahl kann auch weggelassen werden, weil sie durch das Elementsymbol bereits festgelegt ist. Man verwendet also folgende Schreibweise, um ein Isotop vollständig zu identifizieren:

wobei X das Elementsymbol des chemischen Elementes bezeichnet.

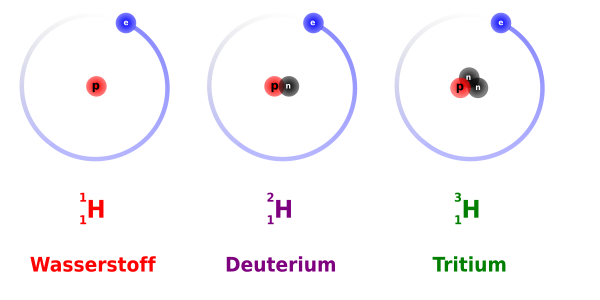

Wir nehmen den Wasserstoff als Beispiel. Wie bereits gesagt, hat er drei Isotope:

- Das häufigste Isotop besteht aus einem einzigen Proton, welches von einem Elektron umkreist wird,

- das zweite Isotop hat im Atomkern ein zusätzliches Neutron,

- und das dritte hat zwei Neutronen im Kern.

Eine einfache Illustration dieser drei Isotope ist in der Abbildung unten gezeigt. Sie ist jedoch nicht maßstabsgetreu, man beachte die obige Bemerkung bezüglich der Größe des Kerns im Vergleich zur Größe des Atoms. Nichtsdestotrotz ist diese Abbildung nützlich, um zu zeigen wie Isotope klassifiziert und benannt werden.

Das erste Isotop, bekannt als Wasserstoff, hat die Massenzahl 1, die Ordnungszahl 1 und wird folgendermaßen geschrieben:

Das zweite Isotop, genannt Deuterium, hat die Massenzahl 2, die Ordnungszahl 1 und wird so geschrieben:

Und als dritten im Bunde haben wir ein Isotop namens Tritium mit (Massenzahl 3, Ordnungszahl 1):

Genau nach dem selben Schema bezeichnet man alle anderen Isotope. Der Leser sollte nun in der Lage sein, zu erkennen, dass das Uranisotop 92 Protonen, 92 Elektronen und 236 - 92 = 144 Neutronen hat.

Zum Abschluss dieser Klassifikation müssen wir noch eine weitere Notation erklären. Man bezeichnet Isotope auch mit dem ausgeschriebenen Namen ihres Elements gefolgt von ihrer Massenzahl. Zum Beispiel können wir Deuterium ebenso gut als Wasserstoff-2 und als Uran-236 bezeichnen.

Bevor wir das Thema der Klassifikationsschemata abschließen, wollen wir uns noch mit den Unterschieden zwischen Chemie und Kernphysik beschäftigen. Man erinnert sich, dass ein Wassermolekül aus zwei an ein Sauerstoffatom gebundenen Wasserstoffatomen besteht. Die chemische Bindung zwischen diesen Atomen entsteht, indem die Elektronenhüllen der Atome miteinander wechselwirken. Theoretisch könnten wir ein Glas Wasser herstellen, wenn wir Sauerstoff und Wasserstoffatome millionenfach zu solchen Molekülen zusammenfügten. Wir könnten auf dieselbe Art und Weise auch ein Glas mit schwerem Wasser herstellen, indem wir Deuterium anstelle von Wasserstoff verwenden. Chemisch betrachtet wäre das zweite Wasserglas dem ersten sehr ähnlich. Aus der Sicht des Physikers fiele jedoch sofort auf, dass das zweite Glas schwerer ist als das erste, da der Deuteriumkern zweimal so schwer wie der Wasserstoffkern ist. Deshalb wird diese Art von Wasser in der Tat auch schweres Wasser genannt.

Vereinfacht gesagt, befasst sich der Chemiker mit der Veränderung und Interaktion von Elektronenhüllen als Voraussetzung für den Aufbau komplexer Moleküle, während sich der Kernphysiker eher für die Eigenschaften der Atomkerne interessiert.

Atommasseneinheit

Die SI-Einheit der Masse ist das Kilogramm. Zur Beschreibung der Eigenschaften von Atomen und Kernen ist es jedoch zu groß. Daher verwendet man die Atomare Masseneinheit (amu), die der Einheit Dalton entspricht. Sie kann als ein Zwölftel der Masse eines Kohlenstoffatoms (12C) definiert werden und entspricht damit ungefähr der Masse eines Protons oder Neutrons. Ihr Zahlenwert in Kilogramm ist 1,6605387313 · 10 -27. Dies ist ein Millionstel Millionstel Millionstel Millionstel Tausendstel Kilogramm.

Die Massen des Protons mp und des Neutrons mn sind:

und

wobei ein Elektron lediglich eine Masse von nur 0,00055 amu besitzt.

Bindungsenergie

Wir müssen uns nun mit der Stabilität der Kerne auseinandersetzen. Bisher wissen wir, dass ein Kern ein winzig kleines Gebiet im Zentrum eines Atoms füllt und aus neutralen und positiv geladenen Teilchen besteht. Bei großen Kernen wie zum Beispiel Uran (Z=92) befindet sich also eine große Anzahl von Protonen im einem winzigen Gebiet im Zentrum des Atoms. Man kann sich daher fragen warum ein Kern mit so einer großen Anzahl von positiven Ladungen auf so engem Raum nicht auseinander fliegt. Wie kann ein Kern bei so einer starken Abstoßung zwischen seinen Komponenten stabil sein? Sollten die negativ geladenen Elektronen in der Atomhülle nicht die Protonen vom Kern wegziehen?

Betrachten wir zum Beispiel den Kern Helium-4 (4He). Er besteht aus zwei Protonen und zwei Neutronen, so dass wir uns aus dem bisher Gelernten seine Masse wie folgt berechnen würden:

plus die

Somit würden wir eine

erwarten.

Die experimentell bestimmte Masse von 4He ist etwas geringer - nämlich nur 4,00260 amu. Es gibt also einen Unterschied von 0,03038 amu zwischen unserer Erwartung und der tatsächlich gemessenen Masse. Man kann diesen Unterschied von lediglich 0,75% als vernachlässigbar ansehen. Jedoch sollte man bedenken, dass dieser Massenunterschied immerhin der Masse von 55 Elektronen entspricht und somit Anlass zur Verwunderung bietet.

Man kann sich die fehlende Masse als eine Form von umgewandelter Energie vorstellen, welche den Kern zusammenhält. Diese nennt man Bindungsenergie.

Wie das Kilogramm als Einheit der Masse im Bezug auf Kerne, ist auch das Joule als Einheit zu groß, um die Energien zu beschreiben, die den Kern zusammenhalten. Die Einheit um Energien in der atomaren Größenordnung zu messen ist das Elektronenvolt (eV).

Ein Elektronenvolt ist definiert als die Menge an Energie, die ein Teilchen mit der Ladung 1 e (Elementarladung) gewinnt, wenn es durch ein Potential von einem Volt beschleunigt wird. Diese Definition ist für uns hier von geringem Nutzen und wird lediglich aus Gründen der Vollständigkeit mit angegeben. Man denke hierüber nicht zu viel nach, sondern nehme nur zur Kenntnis, dass es sich um eine Einheit zur Darstellung sehr kleiner Energien handelt, die jedoch nichtsdestoweniger auf atomaren Skalen sehr nützlich ist. Für nukleare Bindungsenergien ist sie jedoch ein wenig zu klein, daher wird häufig das Megaelektronenvolt (MeV) verwendet.

Albert Einstein beschrieb die Äquivalenz von Masse und Energie auf atomaren Skalen durch folgende Gleichung:

mit der Lichtgeschwindigkeit c

Man kann berechnen, dass einer Masse von 1 amu eine Energie von 931.48 MeV entspricht. Daher entspricht die oben gefundene Differenz zwischen der berechneten und gemessenen Masse eines 4He Atoms von 0,03038 amu einer Energie von 28 MeV. Dies entspricht ca. 7 MeV für jeden der vier Nukleonen im Kern.

Stabilität der Kerne

Bei den meisten stabilen Isotopen liegt die Bindungsenergie pro Nukleon zwischen 7 und 9 MeV. Da diese Bindungsenergie von der Anzahl der Nukleonen im Kern abhängt, also der Massenzahl A, und die elektrostatische Abstoßung vom Quadrat der Kernladungszahl Z2, kann man schließen, dass für stabile Kerne Z2 von A abhängig seien muss.

Erhöht man die Anzahl der Protonen im Kern, so erhöht sich auch die elektrostatische Abstoßung der Protonen untereinander, daher muss die Anzahl der Neutronen überproportional ansteigen um diesen Effekt durch Erhöhung der Bindungsenergie ausgleichen zu können, damit der Kern stabil gebunden bleiben kann.

Wie wir schon früher bemerkt haben gibt es eine Reihe von Isotopen für jedes Element im Periodensystem. Für jedes Element, findet man, dass das stabilste Isotop eine bestimmte Anzahl von Neutronen im Kern hat. Trägt man die Anzahl der Protonen im Kern gegen die der Neutronen für diese stabilsten Isotope auf so erhält man die Nukleare Stabilitätskurve:

Man sieht, dass die Anzahl der Protonen für kleine Kerne der Anzahl der Neutronen entspricht. Jedoch steigt die Anzahl der Neutronen mit zunehmender Größe des Kerns stärker an als die Anzahl der Protonen, so dass die Stabilität größerer Kerne gewährleistet ist. Anders ausgedrückt müssen mehr Neutronen vorhanden sein um durch ihre Bindungsenergie der elektrostatischen Abstoßung der Protonen entgegen zu wirken.

Radioaktivität

Es gibt etwa 2450 bekannte Isotope von etwa einhundert Elementen im Periodensystem. Man kann sich leicht die Größe der Liste der Isotope im Vergleich zu der des Periodensystems vorstellen. Die instabilen Isotope liegen oberhalb oder unterhalb der Stabilitätskurve. Diese instabilen Isotope entwickeln sich zur Stabilitätskurve hin, indem sie sich durch einen Prozess namens Spaltung teilen oder indem sie Teilchen und/oder Energie in Form von Strahlung aussenden. Alle diese Prozesse werden unter dem Begriff Radioaktivität zusammengefasst.

Es macht Sinn sich ein wenig näher mit dem Thema Radioaktivität zu beschäftigen. Was soll denn zum Beispiel die Stabilität von Atomkernen mit einem Radio zu tun haben? Aus historischer Sicht führe man sich vor Augen, dass man um 1900 als man diese Strahlungen entdeckte nicht genau wusste womit man es zu tun hatte. Als Leute wie Henri Becquerel und Marie Curie anfangs an seltsamen Aussendungen natürlicher Materialien arbeiteten glaubte man, dass diese Strahlungen etwas mit einem anderen damals noch nicht recht verstandenem Phänomen, dem der Radiokommunikation, zu tun hätten. Es scheint daher verständlich, dass einige Leute damals annahmen, das diese Phänomene irgendwie verwandt waren und die Materialien die Strahlung aussandten die Bezeichnung radioaktiv erhielten. (Anm. d. Ü: γ-Strahlung ist genauso wie Radiowellen elektromagnetische Strahlung, Radioaktivität umfasst jedoch noch viele weitere Strahlungen außer der elektromagnetischen.)

Heute wissen wir, dass diese Phänomene nicht direkt verwandt sind, behalten jedoch den Begriff Radioaktivität bei. Es sollte jedoch bis hierhin klar geworden sein, dass sich der Begriff Radioaktivität auf Teilchen oder Energie bezieht, die von instabilen Isotopen emittiert werden. Instabile Isotope, z.B. solche mit zu wenigen Protonen um stabil zu bleiben heißen radioaktive Isotope oder Radioisotope. Der Begriff Radionuklid wird auch gelegentlich verwendet.

Man findet nur etwa 300 der 2450 Isotope in der Natur. Alle anderen wurden von Menschen künstlich erzeugt. Die 2150 künstlichen Isotope wurden seit 1900, die meisten von ihnen sogar nach 1950 erstmalig erzeugt.

Wir werden auf die Produktion von Radioisotopen im letzten Kapitel dieses Wikibooks zurückkommen und werden uns nun die Arten der Strahlung näher anschauen, die von Radioisotopen emittiert werden.

Weiterführende Links (englisch)

- Marie and Pierre Curie and the Discovery of Polonium and Radium - an historical essay from The Nobel Foundation.

- Natural Radioactivity - an overview of radioactivity in nature - includes sections on primordial radionuclides, cosmic radiation, human produced radionuclides, as well as natural radioactivity in soil, in the ocean, in the human body and in building materials - from the University of Michigan Student Chapter of the Health Physics Society.

- The Particle Adventure - an interactive tour of the inner workings of the atom which explains the modern tools physicists use to probe nuclear and sub-nuclear matter and how physicists measure the results of their experiments using detectors - from the Particle Data Group at the Lawrence Berkeley National Lab, USA and mirrored at CERN, Geneva.

- www.t-pse.de/index-en.html - a smart, interactive Periodic Table of the Elements for offline and online use; also available in German (www.t-pse.de) and French (www.t-pse.de/index-fr.html)

- WebElements - an excellent web-based Periodic Table of the Elements which includes a vast array of data about each element - originally from Mark Winter at the University of Sheffield, England.

Radioaktiver Zerfall

Einleitung

Wir haben im letzten Kapitel gesehen, dass Radioaktivität Prozesse beschreibt, in denen instabile Atomkerne in stabile übergehen, wobei instabile Zwischenstufen auftreten können. Das bedeutet, dass solche Atomkerne, die zerfallen, entweder sofort oder nach einigen Zwischenschritten Stabilität erreichen. Ein alternativer Titel für dieses Kapitel wäre also nukleare Zerfallsprozesse.

Ebenfalls sahen wir im letzten Kapitel, dass wir die Vorgänge anhand der Stabilitätskurve der Kerne verstehen können. Somit ist ein weiterer möglicher Titel dieses Kapitels Wege zur Stabilitätskurve

Wir werden einen beschreibenden phänomenologischen Weg wählen und auf ziemlich einfache Art und Weise verstehen, was über die wichtigsten Zerfallsmechanismen bekannt ist. Wiederum wurde dieser Stoff schon einmal im Physikunterricht des Gymnasiums behandelt. Dieses Thema hier noch einmal zu bearbeiten, wird uns die Arbeit in den folgenden Kapiteln erleichtern.

Zerfallsarten

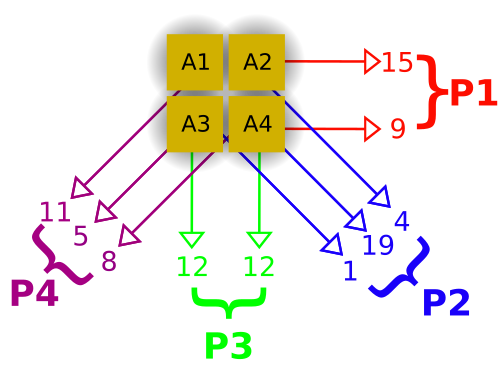

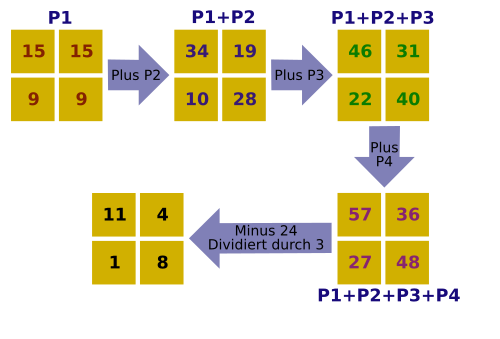

Anstatt zu fragen, was mit bestimmten Typen von Kernen passiert, ist es vielleicht einfacher einen hypothetischen Kern zu betrachten, der allen wichtigen Zerfallsprozessen unterliegen kann. Dieser hypothetische Kern ist unten gezeigt.

Zunächst sehen wir, dass zwei Neutronen zusammen mit zwei Protonen emittiert werden können. Dieser Prozess heißt Alpha-Zerfall. Als zweites sehen wir, dass ein Proton in einem Prozess namens Beta-Plus-Zerfall ein Positron freisetzen kann und dass ein Neutron ein Elektron in einem Beta-Minus-Zerfall genannten Prozess freisetzen kann. Weiterhin kann ein Elektron der Hülle von einem Proton des Kerns eingefangen werden, dies nennt man Elektroneneinfang. Drittens kann die Energie eines nuklearen Übergangs beim Gamma-Zerfall in Form eines Photons abgestrahlt werden.

Ferner kann ein Elektron aus der Elektronenhülle des Atoms direkt mit dem Kern wechselwirken und die Energie eines nuklearen Übergangs aufnehmen und somit das Atom verlassen. Als letztes kann der Kern in zwei oder mehr größere Bruchstücke zerfallen, dies bezeichnet man als spontane Spaltung.

Wir werden diese Prozesse nun nacheinander behandeln.

Spontane Spaltung

In diesem sehr destruktiven Prozess spaltet sich ein schwerer Kern in zwei bis drei Teile, wobei zusätzlich einige Neutronen emittiert werden. Die Bruchstücke sind im allgemeinen wieder radioaktiv. In Kernkraftwerken wird dieser Prozess zur Herstellung von Radioisotopen verwendet. Weiterhin findet er in der nuklearen Energieerzeugung und im Bereich der Nuklearwaffen Anwendung. Dieser Prozess ist für uns hier von geringem Interesse und wir werden darauf nicht weiter eingehen.

Alpha-Zerfall

In diesem Prozess verlassen zwei Protonen und zwei Neutronen den Kern zusammen als so genanntes Alphateilchen. Ein Alphateilchen ist tatsächlich ein 4He Kern (Helium-Kern).

Warum nennt man es daher nicht einfach 4He Kern? Warum sollte man es anders bezeichnen? Die Antwort hierauf liegt in der Geschichte der Radioaktivität. Zur Zeit ihrer Entdeckung war nicht bekannt worum es sich bei dieser Strahlung tatsächlich handelte. Man bemerkte zunächst nur die zweifach positive Ladung und erkannte erst später dass es sich um 4He Kerne handelte. In der ersten Phase ihrer Entdeckung erhielt die Strahlung den Namen Alpha-Strahlung (und die anderen beiden Strahlenarten wurden Beta- und Gamma-Strahlung genannt), wobei Alpha(α), Beta(β) und Gamma(γ) die ersten drei Buchstaben des griechischen Alphabets sind. Heute nennen wir diesen Typ Strahlung immer noch Alpha-Strahlung. Diese Bezeichnung trägt auch zur Fachsprache des Gebietes bei und führt bei Außenstehenden zum Eindruck eines stark spezialisierten Arbeitsgebiets!

Man mache sich jedoch bewusst, dass diese Strahlung wirklich aus 4He-Kernen besteht, die von einem größeren Kern emittiert werden. 4He ist ein auf der Erde recht häufig vorkommendes Element und daher eigentlich nichts besonderes. Warum also ist diese Strahlung für Menschen so gefährlich? Die Antwort hierauf liegt in der großen Energie mit der diese Teilchen emittiert werden, sowie in ihrer großen Masse und ihrer zweifach positiven Ladung. Daher können sie, wenn sie mit lebender Materie wechselwirken, einen erheblichen Schaden an den Molekülen anrichten, mit denen sie zusammentreffen, zumal sie bestrebt sind, Elektronen einzufangen und neutrales 4He zu bilden.

Ein Beispiel für den Alpha-Zerfall ist der Kern Uran-238. Die folgende Gleichung beschreibt den Zerfallsprozess:

Hier emittiert 238U einen 4He-Kern (ein Alpha-Teilchen) und der ursprüngliche Kern wandelt sich in 234 Thorium um. Man beachte, dass sich die Massenzahl des ursprünglichen Kerns um vier und seine Kernladungszahl um zwei verringert haben, was ein allgemeines Charakteristikum eines jeden Alpha-Zerfalls bei jeglichen Kernen ist.

Beta-Zerfall

Es gibt im wesentlichen drei Formen des Beta-Zerfalls:

(a) Beta-Minus-Zerfall

Einige Kerne haben einen Überschuss an Neutronen und werden stabil, indem sie ein Neutron in ein Proton umwandeln, wobei ein Elektron frei wird. Dieses Elektron heißt Beta-Minus-Teilchen, wobei das Minus die negative Ladung des Elektrons andeutet. Wir können dies durch folgende Formel ausdrücken:

wobei ein Neutron in ein Proton und ein Elektron umgewandelt wird. Man beachte, dass die Gesamtladung auf beiden Seiten der Gleichung dieselbe ist. Wir sagen, dass die Ladung erhalten bleibt.

Wir können behaupten, dass das Elektron nicht im Kern existieren kann und daher herausgeschleudert wird[1]. Wieder ist nichts sonderbares an einem Elektron. Wichtig für den Strahlenschutz ist jedoch die Energie mit der es aus dem Kern emittiert wird, sowie der chemische Schaden, den es anrichten kann, wenn es mit lebender Materie wechselwirkt.

Ein Beispiel, in dem dieser Zerfall auftritt ist der 131I Kern, welcher in 131Xe zerfällt und dabei ein Elektron emittiert:

Das entstehende Elektron wird Beta-Minus-Teilchen genannt. Man beachte, dass die Massenzahl in der obigen Gleichung konstant bleibt und sich die Kernladungszahl um eins erhöht, was ein Charakteristikum eines jeden Beta-Minus-Zerfalls ist. Man mag sich vielleicht wundern, wie ein Elektron innerhalb eines Kerns erzeugt werden kann, wenn man die vereinfachte Beschreibung des Kerns als nur aus Protonen und Neutronen bestehend, wie sie im letzten Kapitel angegeben wurde, zugrunde legt. Dies ist nur eine der Beschränkungen dieser vereinfachten Beschreibung und kann dadurch erklärt werden, dass man die zwei fundamentalen Teilchen, nämlich die Neutronen und Protonen, als wiederum aus noch kleineren Teilchen, den Quarks aufgebaut versteht. Wir werden uns hier nicht näher mit diesen Teilchen auseinandersetzen, sondern bemerken lediglich, dass gewisse Kombinationen von Quarks ein Proton und andere ein Neutron ergeben. Wir möchten am Anfang dieses einführenden Textes ein vereinfachtes Bild verwenden, obwohl der tatsächliche Sachverhalt komplizierter als der beschriebene ist. Dasselbe trifft auf die oben angegebene Behandlung des Beta-Zerfalls zu, wie wir in den folgenden Kapiteln sehen werden.

(b) Beta-Plus-Zerfall

Wenn die Anzahl der Protonen im Kern zu groß wird, so dass der Kern nicht mehr stabil ist, kann es passieren, dass er stabiler wird, indem er ein Proton in ein Neutron umwandelt und dabei ein positiv geladenes Antielektron emittiert. Dies ist kein Tippfehler. Ein Antielektron hat positive Ladung und wird auch Positron genannt. Das Positron ist das Beta-Plus-Teilchen

Die Geschichte ist hier recht interessant. Ein hervorragender Italienischer Physiker, Enrico Fermi entwickelte eine Theorie des Beta-Zerfalls, in der er vorhersagte, dass sowohl negativ als auch positiv geladene Teilchen von instabilen Kernen emittiert werden können. Die positiv geladenen wurden Antimaterie genannt und später experimentell nachgewiesen. Antielektronen leben nicht sehr lange, da sie recht schnell mit einem normalen Elektron rekombinieren. Diese Reaktion heißt Paarvernichtung und führt zur Aussendung von Gamma-Strahlen. Science-Fiction-Autoren, wie auch einige Wissenschaftler, spekulierten nach der Entdeckung der Antimaterie darüber, dass es in Teilen des Universums negativ geladene Anti-Protonen geben könnte, die Kerne bildeten, welche von positiv geladenen Elektronen umkreist wurden[2]. Aber dies führt zu weit vom eigentlichen Thema weg. Die Reaktion in unserem instabilen Kern, welcher zwei oder mehr Protonen enthält, kann wie folgt dargestellt werden.

Man beachte wiederum, dass die Ladung auf beiden Seiten der Gleichung dieselbe ist. Ein Beispiel für diesen Zerfall ist 22Na, welches in 22Ne zerfällt und dabei ein Positron abstrahlt.

Man beachte, dass die Massenzahl konstant bleibt und sich die Kernladungszahl um eins vermindert.

(c) Elektroneneinfang

Bei dieser dritten Form des Beta-Zerfalls wird das innerste Hüllenelektron vom Kern eingefangen und rekombiniert mit einem Proton zu einem Neutron. Die Reaktion kann wie folgt dargestellt werden.

Dieser Prozess heißt K-Einfang da das Elektron häufig aus der K-Schale des Atoms eingefangen wird. Wie können wir wissen, dass ein solcher Prozess auftritt, wenn doch keine Strahlung emittiert wird? Anders gefragt: Wenn ein solcher Prozess ausschließlich innerhalb eines Atoms auftritt, wird wohl keine Information darüber das Atom verlassen. Oder doch? Die Charakteristik dieses Effekts kann aus Effekten in der den Kern umgebenden Elektronenhülle gefunden werden, wenn nämlich die in der K-Schale entstandene Lücke durch ein Elektron einer äußeren Schale aufgefüllt wird. Das Auffüllen der Lücke geht mit der Aussendung eines Röntgenstrahls aus der Elektronenhülle einher. Dieser Röntgenstrahl dient als charakteristisches Merkmal dieser Form des Beta-Zerfalls. Der beim Elektroneneinfang entstehende Kern befindet sich häufig in einem angeregten Zustand und sendet bei Übergang in den Grundzustand Gammastrahlung aus, welche auch zum Nachweis des Elektroneneinfangs verwendet werden kann. Ein Beispiel für diese Art des radioaktiven Zerfalls ist 55Fe, welches durch Elektronen-Einfang in 55Mn zerfällt. Die Reaktion schreibt sich wie folgt:

Man beachte, dass die Massenzahl bei dieser Zerfallsart wiederum unverändert bleibt und sich die Kernladungszahl um eins erniedrigt.

- ↑ Physikalisch kann ein Elektron durchaus für kurze Zeit im Kern existieren, das Elektron aus dem Zerfall besitzt jedoch wegen Energie- und Impulserhaltung beim Zerfall eine hohe kinetische Energie und kann daher den Anziehungskräften des Kerns entkommen.

- ↑ Im Labor gelang es 1995 Antiwasserstoff herzustellen.

Gamma-Zerfall

Beim Gamma-Zerfall wird Energie von einem instabilen Kern in Form von elektromagnetischer Strahlung ausgesandt.

Aus der Schulphysik sollte noch bekannt sein, dass elektromagnetische Strahlung eines der wichtigsten bisher gefundenen Phänomene ist. Die Strahlung kann in Begriffen der Frequenz, Wellenlänge oder Energie charakterisiert werden. In Begriffen der Energie hat man sehr niederenergetische Strahlung namens Radiowellen, dann Infrarotstrahlung dann bei etwas höherer Energie sichtbares Licht, bei noch höherer Energie ultraviolette Strahlung und bei den höchsten Energien schließlich Röntgenstrahlen und Gammastrahlen. Wie man sich erinnert, gehören alle diese Strahlen zum elektromagnetischen Spektrum.

Bevor wir weitermachen, wollen wir einen Moment verweilen und uns den Unterschied zwischen Röntgenstrahlen und Gammastrahlen klarmachen. Diese beiden Strahlenarten sind hochenergetische Formen elektromagnetischer Strahlung und daher im Wesentlichen gleich. Der Unterschied besteht nicht darin, woraus sie bestehen, sondern wobei sie entstehen. Im allgemeinen können wir sagen, dass Strahlung, die von einem Kern emittiert wird, als Gammastrahlung und solche, die außerhalb des Kerns z. B. aus der Elektronenhülle entsteht, als Röntgenstrahlung bezeichnet wird.

Die letzte Frage, die wir noch klären müssen, bevor wir uns um die unterschiedlichen Formen der Gammastrahlen kümmern können, ist die nach der Natur der hochenergetischen Röntgenstrahlung. Es wurde experimentell gefunden, dass Gammastrahlen (sowie in diesem Zusammenhang auch Röntgenstrahlen) sich manchmal als Welle und manchmal als Teilchen manifestieren. Dieser Welle-Teilchen-Dualismus kann durch die Äquivalenz von Masse und Energie auf atomaren Skalen verstanden werden. Wenn wir einen Gammastrahl als Welle auffassen, ist es sinnvoll ihn mit Begriffen der Frequenz und Wellenlänge wie eine gewöhnliche Welle zu beschreiben. Beschreiben wir ihn jedoch als Teilchen müssen wir die Begriffe Masse und Ladung verwenden. Ferner wird der Begriff Photon für diese Teilchen verwendet. Eine interessante Eigenschaft von Photonen ist jedoch, dass sie weder Masse noch Ladung aufweisen.

Es gibt zwei wichtige Arten des Gamma-Zerfalls:

(a) Isomerieübergang

Ein Kern in einem angeregten Zustand kann seinen Grundzustand (nicht-angeregten Zustand) durch Aussendung eines Gammastrahls erreichen. Ein Beispiel für diese Art des Zerfalls ist 99mTc (Halbwertszeit 6h) - welches das wohl am häufigsten verwendete Radioisotop in der medizinischen Diagnostik ist. Die Reaktion schreibt sich wie folgt:

Hier ist der 99mTc-Kern in einem angeregten Zustand, dass heißt er besitzt überschüssige Energie. Dieser angeregte Zustand heißt hier metastabiler Zustand und der Kern daher Technetium-99m wobei das m für metastabil steht. Dieser angeregte Kern gibt seine überschüssige Energie ab, indem er einen Gammastrahl emittiert und in den Grundzustand Technetium-99 übergeht.

(b) Innere Konversion

Hierbei geht die überschüssige Energie eines angeregten Kerns direkt auf ein Elektron der Atomhülle (z.B. ein Elektron der K-Schale) über.

Zerfallsschemen

Zerfallsschemen werden häufig verwendet um radioaktive Zerfälle graphisch darzustellen. Ein Schema für einen relativ einfachen Zerfall ist unten angegeben.

Diese Abbildung zeigt das Zerfallsschema von 3H welches zu 3He mit einer Halbwertszeit von 12,3 Jahren unter Emission eines Beta-Minus-Teilchens mit einer Energie von 0,0057 MeV zerfällt.

Ein Beispiel für einen komplizierteren Zerfall ist 137Cs:

Dieses Isotop kann durch zwei Beta-Minus-Prozesse zerfallen. Der eine in 5% der Fälle auftretende Zerfall führt zu einem Beta-Minus-Teilchen mit einer Energie von 1,17 und erzeugt 137Ba. Der zweite mögliche Zerfall tritt mit einer Wahrscheinlichkeit von 95% auf und führt zu einem Beta-Minus-Teilchen der Energie 0,51 MeV und erzeugt 137mBa - also Barium in einem metastabilen Kernzustand. 137mBa zerfällt dann über einen Isomerieübergang unter Emission eines Gammastrahls mit einer Energie von 0,662 MeV.

Der generelle Aufbau eines Zerfallsschemas ist in der folgenden Abbildung gezeigt:

Die Energie wird auf der vertikalen, die Kernladungszahl auf der horizontalen Achse aufgetragen - wenngleich diese Achsen normalerweise nicht mit eingezeichnet werden. Das Isotop, für welches das Schema erzeugt wurde (X - in unserem Falle), wird zuoberst eingetragen. Dieses Isotop wird als Elternisotop bezeichnet. Es verliert Energie, wenn es zerfällt, und die entstehenden Produkte werden daher bei niedrigeren Energieniveaus eingetragen und als Tochternuklide bezeichnet.

Das Diagramm zeigt die Vorgänge für die gängigsten Formen radioaktiver Zerfälle. Der Alpha-Zerfall ist links dargestellt: Die Massenzahl wird um vier und die Kernladungszahl um 2 reduziert und es entsteht der Tochterkern A. Zu seiner rechten ist das Schema des Beta-Plus-Zerfalls dargestellt, wobei der Tochterkern B erzeugt wird. Die Situation für den Beta-Minus-Zerfall gefolgt vom Gamma-Zerfall ist auf der rechten Seite des Diagramms dargestellt, wobei die Tochterkerne C bzw. D entstehen.

Weiterführende Links (englisch)

- Basics about Radiation - overview of the different types of ionising radiation from the Radiation Effects Research Foundation - a cooperative Japan-United States Research Organization which conducts research for peaceful purposes.

- Radiation and Life - an essay by Eric J Hall, Professor of Radiology, Columbia University with sections on the unstable atom, ionising radiation, background radiation, man-made radiation and radioactive decay - from the Uranium Information Centre website.

- Radiation and Radioactivity - a self-paced lesson developed by the University of Michigan's Student Chapter of the Health Physics Society, with sections on radiation, radioactivity, the atom, alpha radiation, beta radiation and gamma radiation.

Das Zerfallsgesetz

Einleitung

Dies ist das dritte Kapitel des Wikibooks Physikalische Grundlagen der Nuklearmedizin

Wir haben den radioaktiven Zerfall von einem phänomenologischen Standpunkt aus im letzten Kapitel betrachtet. In diesem Kapitel werden wir einen allgemeineren analytischen Zugang wählen.

Der Grund hierfür ist, dass wir so eine Denkweise entwickeln können in der wir die Vorgänge quantitativ mathematisch fassen können. Wir werden uns mit den Konzepten der Zerfallskonstante und der Halbwertszeit sowie mit den für die Messung der Radioaktivität verwendeten Einheiten vertraut machen. Ferner besteht die Möglichkeit das erworbene Verständnis durch Übungen am Ende des Kapitels zu vertiefen.

Annahmen

Üblicherweise beginnt man eine physikalische Analyse mit dem Aufstellen einiger vereinfachender Annahmen über das System. Dadurch können wir unwichtige Effekte, die das Verständnis erschweren loswerden. Manchmal kann es jedoch auch vorkommen, dass wir die Situation so stark vereinfachen, dass sie zu abstrakt und damit schwer verständlich wird. Daher werden wir versuchen das Thema des radioaktiven Zerfalls mit einem aus dem Alltag bekannten Phänomen in Beziehung zu setzten welches wir als Analogie benutzen und so hoffentlich die abstrakten Probleme umschiffen können. Wir werden hier die Herstellung von Popcorn als Analogie verwenden. Man denke also an einen Topf in den man Öl gibt, anschließend Mais hinzufügt, ihn dann auf einer Herdplatte erhitzt und schaut, was passiert. Der geneigte Leser mag dies auch praktisch ausprobieren wollen. Für den radioaktiven Zerfall betrachten wir eine Probe, die eine große Zahl radioaktiver Kerne enthält, die alle von der selben Art sind. Dies entspricht den noch nicht geplatzten Maiskörnern im Topf. Als zweites nehmen wir an, dass alle radioaktiven Kerne durch den gleichen Prozess zerfallen sei es nun Alpha-, Beta- oder Gamma-Zerfall. Anders ausgedrückt platzen die intakten Maiskörner zu bestimmten Zeitpunkten während des Heizprozesses. Drittens nehmen wir uns einen Moment lang Zeit, um uns darüber klar zu werden, dass wir die Vorgänge nur in einem statistischen Sinne beschreiben können. Wenn wir ein einzelnes Maiskorn betrachten, können wir dann vorhersagen wann es platzen wird? Nicht wirklich. Wir können uns jedoch überlegen dass eine große Anzahl von ihnen nach einer bestimmten Zeit geplatzt sein wird. Aber dies ist ungleich komplizierter als die Frage bezüglich eines einzelnen Maiskorns. Anstatt uns also mit einzelnen Einheiten zu beschäftigen, betrachten wir das System auf einer größeren Skala und hier kommt die Statistik ins Spiel. Wir können den radioaktiven Zerfall statistisch als „Ein Schuss“-Prozess betrachten, das heißt, wenn ein Kern zerfallen ist, so kann er nicht noch einmal zerfallen. In anderen Worten, wenn ein Maiskorn geplatzt ist kann es nicht noch einmal platzen.

Weiterhin ist die Zerfallswahrscheinlichkeit für noch nicht zerfallene Kerne zeitlich konstant. Anders ausgedrückt ist die Wahrscheinlichkeit für ein noch nicht geplatztes Maiskorn in der nächsten Sekunde zu platzen genauso groß wie in der vorherigen Sekunde.

Lassen wir uns diese Popcorn Analogie nicht zu weit treiben. Machen wir uns bewusst, dass die Rate mit der das Popcorn platzt über die Wärme die wir dem Topf zuführen kontrollieren können. Auf die Zerfallsprozesse von Kernen haben wir jedoch keine derartigen Einflussmöglichkeiten. Die Rate mit der Kerne zerfallen kann nicht durch Heizen der Probe beeinflusst werden. Auch nicht durch Kühlung, oder Erhöhung der Drucks oder durch Änderung der Gravitation (indem man die Probe in den Weltraum bringt), auch nicht durch Änderung irgendeiner anderen Eigenschaft seiner physikalischen Umgebung. Das einzige was die Halbwertszeit eines individuellen Kerns bestimmt scheint der Kern selbst zu sein. Aber im Mittel können wir sagen, dass der Kern innerhalb einer gewissen Zeitspanne zerfallen wird.

Gesetz des radioaktiven Zerfalls

Führen wir nun einige Symbole ein um den Schreibaufwand zu reduzieren, den wir treiben müssen, um die Vorgänge zu beschreiben, und machen uns einige mathematische Methoden zu eigen, mit denen wir die Situation erheblich einfacher als zuvor beschreiben können.

Nehmen wir an wir hätten eine Probe eines radioaktiven Materials mit Kernen, welche zu einem bestimmten Zeitpunkt noch nicht zerfallen sind. Was passiert dann in einem kurzen Zeitabschnitt? Einige Kerne werden mit Sicherheit zerfallen. Aber wie viele?

Aufgrund unserer obigen Argumentation können wir sagen, dass die Anzahl der zerfallenden von der Anzahl der insgesamt vorhandenen Kerne abhängen wird und weiterhin von der Dauer der betrachteten kurzen Zeitspanne. In anderen Worten, je mehr Kerne da sind, um so mehr Kerne werden auch zerfallen. Und je länger die Zeitspanne ist, um so mehr Kerne werden zerfallen. Lassen wir uns diese Zahl der Kerne, die zerfallen mit und die Dauer des kurzen Zeitintervalls mit bezeichnen.

Somit haben wir begründet, dass die Anzahl der radioaktiven Kerne, die im Zeitintervall von bis zerfällt proportional zu und zu ist. Als Formel schreibt sich diese Tatsache wie folgt:

Das negative Vorzeichen deutet an, dass abnimmt.

Wandeln wir nun die proportionale Beziehung in eine Gleichung um, so können wir schreiben:

wobei die Proportionalitätskonstante λ Zerfallskonstante heißt.

Nach Division durch können wir diese Gleichung umschreiben zu:

Also beschreibt diese Gleichung den Vorgang für ein kurzes Zeitintervall . Um herauszufinden, was zu beliebigen Zeitpunkten los ist, können wir einfach die Vorgänge in kurzen Zeitintervallen addieren. Anders ausgedrückt müssen wir die obige Gleichung integrieren. Drücken wir dies etwas formaler aus so können wir sagen, dass in der Zeit von bis zu einem späteren Zeitpunkt die Anzahl der radioaktiven Kerne von auf gefallen sein wird, so dass:

Dieser letzte Ausdruck heißt Gesetz des radioaktiven Zerfalls. Es besagt, dass die Anzahl der radioaktiven Kerne exponentiell mit der Zeit abnimmt, wobei die Geschwindigkeit des Zerfalls durch die Zerfallskonstante λ festgelegt ist.

Bevor wir uns diese Gleichung näher anschauen betrachten wir noch einmal welche Mathematik wir oben benutzt haben. Zunächst haben wir die Integralrechnung verwendet um herauszufinden was über einen längeren Zeitraum geschieht, wobei wir wussten was über kurze Zeiträume geschieht. Zweitens verwendeten wir folgende Beziehung aus der Analysis:

wobei den natürlichen Logarithmus von x darstellt. Drittens verwendeten wir die Definition des Logarithmus also:

und damit

Kehren wir nun zum Gesetz des radioaktiven Zerfalls zurück. Das Gesetz sagt aus, dass die Anzahl der Kerne exponentiell abnimmt wobei die Rate durch die Zerfallskonstante festgelegt wird. Das Gesetz ist in der Abbildung unten als Graph dargestellt:

Aufgetragen ist die Anzahl radioaktiver Kerne gegenüber der Zeit t. Wir sehen, dass die Anzahl der radioaktiven Kerne von (der Anzahl der radioaktiven Kerne zum Zeitpunkt ) anfangs sehr schnell und später etwas langsamer abnimmt, also klassisch exponentiell verläuft.

Den Einfluss der Zerfallskonstante kann man an der folgenden Abbildung erkennen:

Alle drei Kurven werden durch Exponentialgesetze beschrieben, lediglich die Zerfallskonstanten sind unterschiedlich gewählt. Man beachte, dass die Kurve mit kleiner Zerfallskonstante relativ langsam und die Kurve mit großer Zerfallskonstante recht schnell abfällt.

Die Zerfallskonstante ist eine Eigenschaft des jeweiligen Radionuklids. Einige wie Uran-238 haben einen recht geringen Wert und das Material zerfällt daher langsam über einen langen Zeitraum. Andere Kerne wie Technetium-99m haben eine relativ hohe Zerfallskonstante und zerfallen daher schneller.

Es ist auch möglich das Zerfallsgesetz aus einer anderen Perspektive zu betrachten indem man den Logarithmus von Nt gegen die Zeit aufträgt. Anders ausgedrückt können wir von unserer obigen Analyse ausgehend die folgende Gleichung graphisch auftragen:

in anderer Form

Beachte, dass dieser Ausdruck eine einfache Gleichung der Form mit und ist. Die Gleichung beschreibt also eine Gerade mit der Steigung wie man in der folgenden Abbildung sieht. Eine solche Darstellung ist häufig hilfreich, wenn man einen Zusammenhang ohne die Komplikationen eines direkten exponentiellen Verhaltens verstehen möchte.

Halbwertszeit

Die meisten von uns haben nicht gelernt instinktiv in logarithmischen oder exponentiellen Skalen zu denken, wenngleich viele natürliche Phänomene exponentiell verlaufen. Die meisten Denkweisen, die wir in der Schule erlernt haben basieren auf linearen Änderungen, dies macht das intuitive Verständnis des radioaktiven Zerfalls etwas schwieriger. Aus diesem Grund gibt es eine wichtige vom Zerfallsgesetz abgeleitete Größe die es uns leichter macht zu verstehen was passiert.

Diese Größe heißt Halbwertszeit und drückt die Länge der Zeit aus die es dauert, bis sich die Radioaktivität eines Radioisotops auf die Hälfte reduziert hat. Graphisch können wir dies wie folgt ausdrücken:

die benötigte Zeit ist die Halbwertszeit, für die gilt:

Man beachte, dass die Halbwertszeit nicht beschreibt wie lange ein Material radioaktiv bleibt, sondern lediglich die Länge der Zeit die es dauert bis sich seine Radioaktivität halbiert. Beispiele für Halbwertszeiten einiger Radioisotope sind in der Tabelle unten angegeben. Man beachte, dass einige von ihnen recht kurze Halbwertszeiten haben. Diese werden gerne für Zwecke der medizinischen Diagnostik verwendet, weil so ihre Radioaktivität nach der Anwendung am Patienten nicht sehr lange im Körper verweilt, was zu relativ geringen Strahlendosen führt.

| Radioisotop | Halbwertszeit (ca.) |

|---|---|

| 13 Sekunden | |

| 6 Stunden | |

| 8 Tage | |

| 1 Monat | |

| 30 Jahre | |

| 462 Tage | |

| 1620 Jahre | |

| 4.51 · 109 Jahre |

Diese kurzlebigen Radioisotope stellen jedoch ein logistisches Problem da, wenn sie an einem Ort verwendet werden sollen, der nicht in unmittelbarer Nähe einer Herstellungsanlage für Radioisotope liegt. Wenn wir zum Beispiel 99mTc für eine Untersuchung an einem Patienten 5.000 Kilometer von der nächsten Herstellungsanlage einsetzen möchten. Die Herstellungsanlage könnte sich zum Beispiel in Sydney und der Patient in Perth befinden. Nachdem wir das Isotop in einem Kernkraftwerk erzeugt haben würde es mit einer Halbwertszeit von 6 Stunden zerfallen. Würden wir als das Material in einen Transporter packen und zum Flughafen von Sydney fahren. Dann würde das Isotop zerfallen während der Transporter im Verkehr von Sydney fest steckt, dann noch mehr während auf den Flug nach Perth gewartet wird. Dann noch mehr wenn es nach Perth geflogen wird und so weiter. Wenn es endlich bei unserem Patienten ankommt, wird sich seine Radioaktivität sehr stark reduziert haben und möglicherweise für die Untersuchung nutzlos geworden sein. Und wie wäre es, wenn wir 81mKr anstelle von 99mTc für unseren Patienten verwenden würden? Im letzten Kapitel dieses Wikibooks werden wir sehen, dass diese logistischen Herausforderungen zu recht innovativen Lösungen Anlass gegeben haben. Mehr dazu jedoch später!

Aus der Tabelle ist ersichtlich, dass andere Isotope sehr lange Halbwertszeiten haben. Zum Beispiel hat 226Ra eine Halbwertszeit von mehr als 1.500 Jahren. Dieses Isotop wurde für therapeutische Anwendungen in der Medizin verwendet. Man denke an die damit verbundenen logistischen Probleme. Offensichtlich ist das Transport vom Herstellungsort zum Anwendungsort hierbei unproblematisch. Jedoch muss man beachten wie lange das Material an seinem Bestimmungsort gelagert werden muss. Man braucht einer Lagereinheit in der das Material sicher über einen langen Zeitraum gelagert werden kann. Aber wie lange? Eine Faustregel für Größen der Radioaktivität in der Medizin besagt, dass die Radioaktivität für ca. 10 Halbwertszeiten erheblich sein wird. Somit bräuchten wir eine sichere Umgebung zur Lagerung von 226Ra über einen Zeitraum von ca. 16.000 Jahren. Diese Lagereinrichtung müsste sicher gegen nicht vorhersehbare Ereignisse, wie Erdbeben, Bombenangriffe usw. aufgebaut sein und von unseren Nachfahren als solche erkennbar sein. Eine in der Tat ausgesprochen delikate Aufgabe.

Beziehung zwischen Zerfallskonstante und Halbwertszeit

Auf Basis des oben gesagten kann man erahnen, dass es eine Beziehung zwischen Halbwertszeit und Zerfallskonstante geben müsste. Ist die Zerfallskonstante klein, so sollte die Halbwertszeit groß sein und entsprechend sollte bei großer Zerfallskonstante die Halbwertszeit klein sein. Aber wie genau sieht nun diese Beziehung aus?

Wir können diese Frage sehr leicht beantworten indem wir die Definition der Halbwertszeit in das Zerfallsgesetz einsetzen. Dieses Gesetz besagt dass zu jeder beliebigen Zeit t:

und aus der Definition der Halbwertszeit wissen wir, dass:

genau dann wenn

Wir können daher das Radioaktive Zerfallsgesetz umschreiben indem wir Nt und t wie folgt ersetzen:

Somit:

und

Diese letzten beiden Gleichungen drücken die Beziehung zwischen Halbwertszeit und Zerfallskonstante aus. Diese sind sehr nützlich zur Lösung von Rechenaufgaben im Gebiet der Radioaktivität und bilden meist den ersten Schritt zu deren Lösung.

Einheiten der Radioaktivität

Die SI (oder auch metrische) Einheit der Radioaktivität ist nach Henri Becquerel, als Ehrung für seine Entdeckung der Radioaktivität, das Becquerel mit dem Symbol Bq. Das Becquerel ist definiert als die Menge einer radioaktiven Substanz die zu einer Zerfallsrate von einem Zerfall pro Sekunde führt. In der medizinischen Diagnostik stellt ein 1 Bq eine recht geringe Menge an Radioaktivität dar. In der Tat ist es einfach sich seine Definition mit Hilfe des englischen Begriffs bugger all (zu Deutsch: rein gar nichts) zu merken. Daher werden das Kilobecquerel (kBq) sowie das Megabecquerel (MBq) häufiger verwendet. Die traditionelle (und heute veraltete) Einheit der Radioaktivität ist nach Marie Curie benannt und heißt Curie mit dem Symbol Ci. Das Curie ist definiert als die Menge einer radioaktiven Substanz die zu einer Zerfallsrate von 3.7 ·1010 Zerfällen pro Sekunde führt. In anderen Worten 37 Tausend Millionen Zerfälle pro Sekunde, was wie man sich denken kann eine erhebliche Menge an Radioaktivität darstellt. Für Zwecke der medizinischen Diagnostik werden daher das Millicurie (mCi) und das Mikrocurie (µCi) häufiger verwendet.

-

Marie Curie

-

Henri Becquerel

Warum also zwei Einheiten? Im Wesentlichen kommt es es hier wie auch sonst bei der Frage nach Maßeinheiten darauf an in welchem Teil der Welt man sich befindet. Der Kilometer wird zum Beispiel in Australien und Europa gerne als Entfernungseinheit verwendet, wohingegen man in den USA bevorzugt die Meile benutzt. So wird man in einem amerikanischen Lehrbuch häufig das Curie als Einheit der Radioaktivität und in einem australischen sehr wahrscheinlich das Becquerel und in einem europäischen häufig beide Einheiten antreffen. Daher ist es sinnvoll beide Einheiten zu kennen.

Übungen

Unten sind drei Übungsaufgaben angegeben die dabei helfen sollen das Verständnis des in diesem Kapitel behandelten Stoffs zu vertiefen. Die erste ist ziemlich einfach und übt die Anwendung des Zerfallsgesetzes sowie das Verständnis des Begriffs Halbwertszeit. Die zweite Aufgabe ist erheblich schwieriger und beschäftigt sich mit der Berechnung Anzahl der in einer Probe radioaktiven Materials pro Zeiteinheit zerfallenden Kerne und verwendet das Gesetz des radioaktiven Zerfalls. Die dritte Aufgabe ist der zweiten sehr ähnlich, fragt jedoch aus einem leicht anderen Blickwinkel.

Bevor man sich an die Fragen macht möge man sich diese Seite anschauen, die einem einige einfache Rechnungen abnehmen kann.

Aufgabe 1

(a) Die Halbwertszeit von 99mTc beträgt 6 Stunden. Nach welcher Zeit ist noch ein sechzehntel der ursprünglichen Menge des Radioisotops vorhanden?

(b) Verifiziere dein Ergebnis auf einem anderen Weg.

Lösung:

(a) Ausgehend von der ober erhaltenen Beziehung zwischen der Zerfallskonstante und der Halbwertszeit können wir nun die Zerfallskonstante wie folgt berechnen.

Wir wenden nun das Zerfallsgesetz an,

die können wir in folgende Form umschreiben:

Gefragt ist nun wann auf ein sechzehntel ihres Wertes zurückgegangen ist, das bedeutet:

Somit haben wir

was wir nach auflösen müssen. Eine Möglichkeit dies zu tun ist im folgenden angegeben:

Es wird also 24 Stunden dauern bis nur noch ein sechzehntel der ursprünglichen Radioaktivität vorhanden ist.

(b) Eine Möglichkeit die Antwort zu verifizieren benutzt die Definition der Halbwertszeit. Wir wissen aus der Aufgabenstellung, dass 99mTc eine Halbwertszeit von 6 Stunden hat. Daher ist nach sechs Stunden noch die Hälfte der Radioaktivität vorhanden. Nach 12 Stunden noch ein viertel, nach 18 Stunden noch ein achtel und nach 24 Stunden bleibt genau ein sechzehntel übrig. Und wir kommen zu selben Zahlenwert wie in (a). Also stimmt unser Ergebnis.

Man beachte dass dieser Ansatz sinnvoll ist da wir uns mit dem relativ einfachen Fall zu tun haben in dem Radioaktivität halbiert, geviertelt und so weiter wird. Aber mal angenommen die Frage wäre gewesen wie lange es dauert bis die Radioaktivität auf ein Zehntel ihres ursprünglichen Wertes gefallen ist. Die deutlich aufwendigere Ableitung im mathematischen Weg der in Teil (a) beschritten wurde, kann auch diese Frage leicht beantworten.

Aufgabe 2

Berechne die Radioaktivität von einem Gramm 226Ra, die Halbwertszeit betrage 1620 Jahre und die Avogadrozahl sei 6,023 · 1023.

Lösung:

Wir können genau wie bei Übung 1(a) ansetzen indem wir die Zerfallskonstante aus der Halbwertszeit mit Hilfe der folgenden Gleichung berechnen:

Man beachte, dass wir als Dauer eines Jahres 365,25 Tage angesetzt haben um für Schaltjahre zu kompensieren, als wir von 'pro Jahr' auf 'pro Sekunde' umrechneten. Ferner mussten wir in 'pro Sekunde' umrechnen, das die Einheit der Radioaktivität als Anzahl der pro Sekunde zerfallenden Kerne definiert ist.

Als zweites berechnen wir wie viele Kerne 1 g 226Ra enthält:

Als drittes müssen wir das Zerfallsgesetz in eine Form bringen in der wir die Anzahl der pro Zeiteinheit zerfallenden Kerne ablesen können. Wir können dies erreichen in dem wir die Gleichung wie folgt ableiten:

Der Grund dafür hier den Absolutbetrag zu verwenden ist, dass wir das Minuszeichen loswerden wollen, da wir ja wissen dass wir es mit einer zeitlich abnehmenden Größe zu tun haben. Wir können nun die Daten, die wir für λ und N oben abgeleitet haben einsetzen:

Also ist die Radioaktivität einer Probe von einem Gramm Radium-226 ungefähr 1 Ci.

Diese Antwort ist nicht verwunderlich, da die Definition des Curie ursprünglich auf der Radioaktivität von 1 g Radium-226 beruhte.

Übung 3

Was ist die minimale Masse eines 99mTc Strahlers, der eine Radioaktivität von 1 MBq hat. Nimm an, dass die Halbwertszeit 6 Stunden beträgt und die Avogadrozahl 6,023·1023 ist.

Lösung

Wir gehen von der Beziehung zwischen Halbwertszeit und Zerfallskonstante aus:

Zweitens sagt uns die Frage, dass die Radioaktivität 1 MBq beträgt. Daher haben wir wegen 1 MBq = 1 · 106 Zerfälle pro Sekunde:

Schließlich kann die Masse dieser Kerne wie folgt berechnet werden:

In anderen Worten also lediglich etwas mehr als fünf Pikogramm 99mTc werden benötigt um eine Million Gamma-Strahlen pro Sekunde ab zu strahlen. Dieses Ergebnis zeigt nochmal einen wichtigen Punkt den man über den Strahlenschutz lernen sollte. Nämlich, dass man radioaktive Materialien genauso behandeln sollte wie krankheitserregende Bakterien.

Einheiten der Strahlungsmessung

Einleitung

Dies ist das vierte Kapitel des Wikibooks Physikalische Grundlagen der Nuklearmedizin

Nach dem letzten recht langen und detaillierten Kapitel werden wir nun in etwas gemächlicherem Tempo die in diesem Gebiet wichtigen Maßeinheiten besprechen.

Bevor wir dies tun, ist es jedoch sinnvoll, sich mit einem typischen Strahlenexperiment zu beschäftigen. So werden wir eine erste Vorahnung von den vielen Größen bekommen, die gemessen werden können, bevor wir uns mit den Einheiten, in denen sie gemessen werden, beschäftigen. So werden wir als erstes nur ein typisches Strahlenexperiment betrachten und uns dann mit den Einheiten beschäftigen.

Ein typisches Strahlenexperiment

Ein typischer Aufbau eines Experiments zur Radioaktivität ist in der Abbildung unten gezeigt. Als erstes gibt es eine Strahlenquelle, als zweites einen Strahl und drittens einen Absorber, welcher Strahlung aufnimmt. Also können die zu messenden Größen mit der Quelle, dem Strahl oder dem Absorber in Zusammenhang gebracht werden.

Diese Art von Umgebung könnte eine solche sein, in der Strahlung von einer Quelle verwendet wird, um einen Patienten (der in diesem Falle den Absorber darstellt) zum Zwecke einer diagnostischen Untersuchung zu bestrahlen, wobei wir hinter dem Patienten ein Gerät anbrächten, welches ein Bild erzeugt, oder zur therapeutischen Anwendung, wobei die Strahlung dazu gedacht ist, Schaden in einem bestimmten Teil des Patienten hervorzurufen. Es ist also ein Aufbau, in dem wir mit einem Absorber und einer Strahlenquelle arbeiten.

Die Strahlenquelle

Bei einer radioaktiven Strahlenquelle ist ihre Radioaktivität eine wichtige Messgröße. Wir sahen im vorherigen Kapitel, dass die hierzu verwendeten Einheiten das Becquerel (SI Einheit) und auch das Curie (veraltete Einheit) sind.

Ionendosis

Eine messbare Eigenschaft radioaktiver Strahlung heißt Ionendosis. Diese Größe beschreibt, wie viel Ionisation ein Strahl in dem Medium, das er durchläuft erzeugt.

Im nächsten Kapitel werden wir sehen, dass einer der wichtigsten Effekte beim Durchgang von Strahlung durch Materie darin besteht, dass Ionen erzeugt werden, dies gilt natürlich auch für Luft als eine Form der Materie. Daher wird die Ionendosis, die eine radioaktive Strahlung erzeugt, in Einheiten der in der Luft erzeugten Ionisation ausgedrückt.

Der direkte Weg zur Messung dieser Ionisation besteht darin, die erzeugte Ladung zu messen. Aus der Schulphysik wird man sich erinnern, dass die SI Einheit der elektrischen Ladung das Coulomb ist.

Die SI Einheit der Ionendosis ist Coulomb pro Kilogramm und wird mit dem Symbol bezeichnet. Sie ist definiert als die Menge an radioaktiver Strahlung (Röntgen- oder Gamma-Strahlung), die beim Durchgang durch ein Kilogramm Luft unter Normalbedingungen so viele Ionenpaare erzeugt, dass die erzeugte Gesamtladung eines Vorzeichens 1 Coulomb beträgt.

Die veraltete Einheit der Ionendosis ist das Röntgen, zu Ehren von Wilhelm Röntgen (dem Entdecker der Röntgenstrahlung). Sie wird mit dem Symbol R bezeichnet. Das Röntgen ist definiert durch:

Also ist ein R im Vergleich zu einem eine kleine Strahlungsmenge – genau genommen eine 3876 mal kleinere. Man beachte, dass diese Einheit sich nur auf Röntgen- und Gamma-Strahlen bezieht. Oft ist nicht die Ionendosis, sondern die Ionisationsrate, also die Ionendosis pro Zeiteinheit, von Interesse. Die hier gebräuchlichen Einheiten sind (Coulomb pro Kilogramm und Sekunde) und (Röntgen pro Stunde).

Energiedosis

Strahlung hinterlässt beim Durchgang durch Materie Energie. Meist eine recht geringe Menge, die aber nicht zu vernachlässigen ist. Die zugehörige physikalische Messgröße heißt Energiedosis und gilt für alle Arten von Strahlen, seien es nun Röntgen- oder Gamma-Strahlen oder Alpha- oder Beta-Teilchen.

Die SI-Einheit der Energiedosis ist das Gray, nach dem berühmten Radiobiologen Louis Harold Gray und trägt das Symbol Gy. Das Gray ist definiert als Absorption von einem Joule Strahlungsenergie pro Kilogramm durchstrahlten Materials. Wenn also ein Joule Strahlungsenergie von einem Kilogramm des Absorbermaterials absorbiert wird, so beträgt die absorbierte Dosis 1 Gy.

Die veraltete Einheit der Energiedosis ist das rad, welche bezeichnenderweise für Radiation Absorbed Dose (englisch für absorbierte Strahlendosis) steht. Es ist definiert durch:

Wie man sich leicht überlegt, entspricht 1 Gy also 100 rad.

Es gibt noch weitere vom Gray oder vom rad abgeleitete Größen, die die biologischen Effekte von absorbierter Strahlung in belebter Materie, wie zum Beispiel in menschlichem Gewebe, ausdrücken. Hierunter fallen die Äquivalentdosis und die effektive Dosis .

Die Äquivalentdosis basiert auf Schätzungen der Ionisationsfähigkeit von unterschiedlichen Strahlenarten, die durch Strahlungswichtungsfaktoren , berücksichtigt werden. Man schreibt dann

wobei die Energiedosis ist. Die Effektive Dosis schließt die und Schätzungen der Anfälligkeit unterschiedlicher Gewebe so genannter Gewebewichtungsfaktoren mit ein, so dass

wobei die Summe über alle betroffenen Gewebe läuft. Sowohl die Äquivalentdosis als auch die effektive Dosis werden in SI-Einheiten namens Sievert (Sv) angegeben.

Verweilen wir hier ein wenig, um den Begriff der Dosis etwas genauer zu erläutern. Man fasst der Begriff normalerweise im medizinischen Sinne auf, indem man zum Beispiel sagt, der Arzt verschreibe eine gewisse Dosis eines Medikaments. Was hat diese Dosis mit der Energie zu tun, die ein radioaktiver Strahl in einem Absorber hinterlässt? Es könnte etwas mit den frühen Anwendungen von Strahlung Anfang des zwanzigsten Jahrhunderts zu tun haben, die damals verwendet wurde, um verschiedenste Krankheiten zu behandeln. Somit können wir spekulieren, dass der Begriff in der Umgangssprache geblieben ist. Es wäre viel sinnvoller, eine Bezeichnung wie absorbierte Strahlungsenergie zu verwenden, da wir es mit der Deposition von Strahlung in einem Absorber zu tun haben. Aber dann wäre das Fachgebiet bei weitem zu leicht verständlich!

Gammastrahlenkonstante

Abschließend wollen wir noch eine weitere Einheit einer radiologischen Messgröße kennen lernen. Es ist die Gammastrahlenkonstante eines Radioisotops. Diese Messgröße setzt sich aus Größen zusammen, die wir bereits kennen gelernt haben und beschreibt die durch die Gammastrahlung des Isotops hervorgerufene Ionisation.

Sie ist in praktischer Hinsicht ausgesprochen nützlich, wenn wir es mit einer Gammastrahlung emittierenden Quelle zu tun haben. Angenommen, man hat eine Gammastrahlenquelle (zum Beispiel 99mTc oder 137Cs) und steht, während man arbeitet, in einem gewissen Abstand von ihr. Dann wird man an der erhaltenen Ionendosis aus Gründen des Strahlenschutzes interessiert sein. Hierbei hilft die Gammastrahlenkonstante

Sie ist definiert als Ionendosisrate pro Aktivität in einem bestimmten Abstand von der Quelle. Die SI-Einheit ist daher:

;

eine veraltete Einheit ist

Diese Einheiten sind etwas unhandlich. Es wäre wohl sinnvoll gewesen, sie nach irgendwelchen berühmten Wissenschaftlern zu benennen, so das wir die SI Einheit das Smith und die veraltete Einheit das Jones hätten nennen können. Aber die Dinge sind mal wieder nicht so einfach.

Abstandsgesetz

Bevor wir dieses Kapitel abschließen können, werden wir uns damit beschäftigen, was passiert wenn wir den Absorber von der Strahlungsquelle wegbewegen. Anders ausgedrückt, werden wir uns Gedanken über den Einfluss des Abstands von der Strahlenquelle auf die Intensität der Strahlung machen. Wir werden hierbei ein sehr nützliches Ergebnis finden, das für den Strahlenschutz von großer Bedeutung ist.

Die in einer radioaktiven Quelle erzeugte Strahlung wird in alle Richtungen gleichermaßen abgestrahlt. Wir können uns dazu vorstellen, dass es Kugeln mit immer größer werdenden Radien um die Quelle gibt, auf welchen die Intensität konstant ist, und die Photonen als Teilchen, die von der Quelle im Zentrum weg fliegen.

Wir stellen uns die Oberfläche einer dieser Kugeln vor und nehmen an, dass eine bestimmte Anzahl von Photonen pro Zeiteinheit durch sie hindurch tritt. Wenn wir nun eine Kugeloberfläche in größerer Entfernung von der Quelle betrachten, so muss die gleiche Anzahl an Photonen pro Zeiteinheit durch sie hindurch treten, nur dass sie jetzt auf eine größere Fläche verteilt ist. Diesen Gedanken folgend können wir uns leicht vorstellen, dass die Strahlungsintensität mit dem Quadrat des Abstandes von der Quelle abnimmt. Als Formel schreibt man (mit der Symbolen für Intensität und für Abstand):

Dieser Effekt heißt Abstandsgesetz. Verdoppelt man demnach den Abstand von der Quelle, so reduziert sich die Intensität um einen Faktor von 22, also um 4. Wenn wir den Abstand verdreifachen, so reduziert sich die Intensität um einen Faktor 9, also 32, usw.

Dies ist eine sehr nützliche Information, wenn man sich mit einer Strahlenquelle beschäftigt und versucht, die Dosis, der man ausgesetzt ist, so klein wie möglich zu halten.

Externe Links (englisch)

- Radiation and Risk - covers the effect of radiation, how risks are determined, comparison of radiation with other risks and radiation doses.

- Radiation Effects Overview - results of studies of victims of nuclear bombs including early effects on survivors, effects on the in utero exposed, and late effects on the survivors - from the Radiation Effects Research Foundation, a cooperative Japan-United States Research Organization.

- The Radiation and Health Physics Home Page - all you ever wanted to know about radiation but were afraid to ask....with hundreds of WWW links - from the Student Chapter of the Health Physics Society, University of Michigan containing sections on general information, regulatory Information, professional organizations and societies, radiation specialties, health physics research and education.

- What You Need to Know about Radiation - to protect yourself to protect your family to make reasonable social and political choices - covers sources of radiation and radiation protection - by Lauriston S. Taylor.

Interaktion von Strahlung mit Materie

Einleitung

Dies ist das fünfte Kapitel des Wikibooks Physikalische Grundlagen der Nuklearmedizin

Im letzten Kapitel haben wir uns auf die Strahlenquellen und die unterschiedlichen Strahlenarten konzentriert. Nun können wir uns damit beschäftigen, was passiert, wenn diese Strahlung mit Materie wechselwirkt. Der Hauptgrund wozu wir dies tun, ist um zu verstehen, was genau passiert, wenn Strahlung durch Materie hindurch tritt, aber auch, um uns auf die Frage, wie man Strahlung detektieren kann, vorzubereiten. Da alle Strahlendetektoren aus irgendeiner Form von Materie bestehen, ist es nützlich, erst einmal zu verstehen, wie Strahlung mit Materie wechselwirkt, so dass wir die dabei auftretenden Effekte nutzen können um entsprechende Detektoren zu entwickeln.

Bevor wir dies im Detail angehen, wollen wir uns an die wesentlichen physikalischen Eigenschaften der wichtigsten Strahlungsarten erinnern. Wir haben dieses Thema im Detail im ersten Kapitel behandelt. Sie sind jedoch der Bequemlichkeit halber unten noch einmal zusammengefasst:

| Strahlentyp | Masse | Elektrische Ladung | Geschwindigkeit |

|---|---|---|---|

| Alphateilchen | ziemlich hoch | zweifach positiv | ziemlich gering |

| Beta-Minus-Teilchen | etwa 8000 mal leichter als Alphateilchen | einfach negativ | kleiner als Lichtgeschwindigkeit |

| Beta-Plus-Teilchen | etwa 8000 mal leichter als Alphateilchen | einfach positiv | kleiner als Lichtgeschwindigkeit |

| Gammastrahlen | Keine | Keine | Licht- geschwindigkeit |

Wir werden uns nun mit dem Durchgang jedes einzelnen Strahlentyps durch Materie beschäftigen, wobei wir das Hauptaugenmerk auf die Gammastrahlen legen werden, da sie in der Nuklearmedizin am häufigsten verwendet werden. Einer der wichtigsten Effekte die einem hierbei unabhängig vom Strahlentyp auffallen werden ist, dass Ionen entstehen, wenn Strahlung mit Materie wechselwirkt. Aus diesem Grund spricht man auch von Ionisierender Strahlung.

Bevor wir nun starten, mag es nützlich sein, sich noch kurz mit einer Analogie zu befassen. Diese Analogie basiert darauf, dass wir uns die Materie aus einer sehr großen Anzahl von Atomen (sprich Kernen mit sie umkreisenden Elektronen) aufgebaut denken und uns die Strahlung als Teilchen, die durch die Materie hindurch fliegen, vorstellen. In Analogie kann man sich ein Raumschiff vorstellen, dass durch einen Meteorsturm hindurch fliegt, wie man es von Science-Fiction-Filmen her kennt, wobei das Raumschiff die Strahlung und die Meteore die Atome des durchstrahlten Materials darstellen. Eine besondere Eigenschaft, die wir jedoch erwähnen müssen, ist die Tatsache, dass unser Raumschiff, abhängig von der Strahlenart, eine elektrische Ladung tragen kann.

Alpha-Teilchen

Wir können aus der oben abgebildeten Tabelle sehen, dass Alpha-Teilchen eine zweifach positive Ladung tragen und uns daher leicht vorstellen, dass sie eine erhebliche elektrostatische Anziehung auf die äußeren Hüllenelektronen von Atomen, an denen sie nahe vorbeifliegen, ausüben. Dies führt dazu, dass einige Elektronen von ihren Kernen weggezogen werden, sodass Ionen entstehen. Anders ausgedrückt treten Ionisationen auf.

Aus der Tabelle können wir ersehen, dass Alpha-Teilchen im Vergleich zu anderen Strahlenarten sehr schwer sind, genauso wie die Atome des Materials, das von der Strahlung durchlaufen wird. Daher durchfliegen sie die Materie, abgesehen von seltenen Zusammenstößen mit den Kernen des Materials, in gerader Linie.

Eine dritte wichtige Eigenschaft ist die hierbei emittierte Energie. Bei Alpha-Teilchen ist sie immer diskret. Zum Beispiel emittiert 221Ra Alpha-Teilchen mit einer Energie von 6,71 MeV. Jedes von diesem Radionuklid emittierte Alpha-Teilchen besitzt genau diese Energie. Ein weiteres Beispiel ist 230U, welches Alpha-Teilchen der Energien 5,66 MeV, 5,82 MeV und 5,89 MeV emittiert.

Schließlich ist es notwendig zu bemerken, dass Alpha-Teilchen große biologische Schäden anrichten, wenn sie mit lebender Materie wechselwirken. Daher werden sie bei diagnostischen in-vivo-Untersuchungen nicht verwendet. Aus diesem Grund werden wir sie in diesem Wikibook nicht näher betrachten.

Beta-Teilchen

Aus der Tabelle können wir sehen, dass Beta-Minus-Teilchen einfach negative Ladung tragen. Beachte, dass wir Positronen (Beta-Plus-Teilchen) hier nicht behandeln werden, da sie, wie wir aus Kapitel 2 wissen, nicht sehr lange in Materie überleben können, bevor sie annihiliert werden. Beta-Minus-Teilchen leben erheblich länger, weshalb wir uns hier darauf konzentrieren werden.

Wegen ihrer negativen Ladung werden sie von Kernen angezogen und von Elektronenwolken abgestoßen, wenn sie sich in Materie bewegen. Dies führt, ohne hier ins Detail zu gehen, zu Ionisationen.

Der Weg, den Beta-Teilchen zurücklegen, wird oft als gewunden beschrieben, da sie dazu tendieren, von Atom zu Atom zu prallen.

Als letzten jedoch wichtigen Punkt müssen wir bemerken, dass die Energie von Beta-Teilchen nicht diskret, wie bei Alpha-Teilchen, sondern kontinuierlich verteilt ist. Die Energien der Beta-Teilchen einer Quelle haben eine spektrale Verteilung bis zu einer maximalen Energie - siehe Abbildung unten. Beachte, dass sich die Energieverteilung über einen Bereich erstreckt und die Eigenschaften und eingezeichnet sind:

Die Frage, die wir uns hier stellen müssen ist: Warum sehen wir ein Spektrum an Energien? Sicherlich sollten Elektronen mit genau einer diskreten Energie entstehen, wenn ein Neutron im Kern in ein Proton und ein Elektron zerfällt. Die Antwort liegt in der Tatsache, dass in Wirklichkeit zwei neue Teilchen im Beta-Zerfall entstehen. Wir haben die in Kapitel 2 verschwiegen, da wir den Anfang diese Wikibooks nicht zu sehr verkomplizieren wollten. Aber wir werden es hier der Vollständigkeit halber behandeln.

Das zweite neue Teilchen, das im Beta-Zerfall entsteht heißt Neutrino und wurde von Enrico Fermi so benannt. Es ist ein etwas mysteriöses Teilchen, welches weder Masse noch Ladung besitzt und seine genauen Eigenschaften werden zur Zeit noch erforscht. Das größte Problem mit dieser Art von Teilchen ist, dass sie sehr schwer zu detektieren sind und diese Tatsache hat unser Wissen über sie bisher wesentlich beschränkt.

Das Energiespektrum der Beta-Teilchen kann man verstehen, wenn man sich klarmacht, das die Energie, die bei der Umwandlung des Neutrons in ein Proton frei wird, auf das Beta-Teilchen und das Neutrino aufgeteilt wird. Manchmal geht die gesamte Energie auf das Beta-Teilchen über, und dieses erhält somit seine maximal mögliche Energie Emax. Häufiger jedoch wird die Energie auf die beiden Teilchen verteilt, so dass das Beta-Teilchen zum Beispiel nur die mittlere Energie EMittel erhält, wobei die verbleibende Energie auf das Neutrino übergeht.

Schließlich ist es wichtig zu wissen, dass Beta-Teilchen einen recht hohen biologischen Schaden verursachen. Dies ist einer der Gründe warum sie nicht bei diagnostischen Untersuchungen am lebenden Objekt verwendet werden. Wir werden sie daher in diesem Wikibook nicht näher betrachten.

Gammastrahlung

Da wir oben schon über Energien geredet haben, wollen wir nun klarstellen, dass die Energien von Gammastrahlen die von einer radioaktiven Quelle emittiert werden immer diskret sind. Zum Beispiel emittiert 99mTc Gammastrahlung mit einer Energie von 140 keV und 51Cr emittiert Gammastrahlung bei einer Energie von 320 keV.

Gammastrahlen können auf verschieden Arten mit Materie wechselwirken. Einige von ihnen haben für die Nuklearmedizin keine Bedeutung und werden hier nicht näher behandelt.

Die für die nuklearmedizinische Bildgebung wichtigen Wechselwirkungen sind:

Wir werden sie unten beide nacheinander behandeln. Man beachte, dass die hier beschriebenen Effekte auch für die Wechselwirkung von Röntgenstrahlen mit Materie relevant sind, da wie wir bereits vorher erwähnt haben Röntgenstrahlen und Gammastrahlen im wesentlichen das selbe physikalische Phänomen darstellen (sich jedoch in ihrer Energie unterscheiden). Somit ist die unten angeführte Beschreibung auch für Röntgen-Radiographie von Bedeutung.

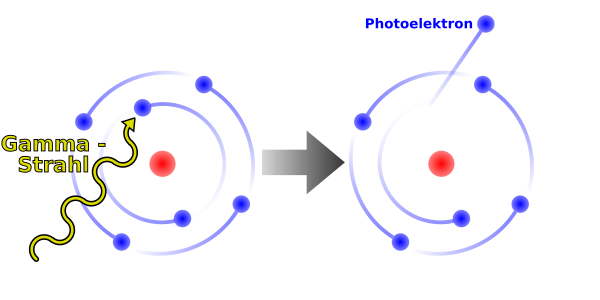

Photoelektrischer Effekt

Wenn ein Gamma-Strahl mit einem Hüllenelektron eines Atoms des Materials, durch das er sich hindurch bewegt, zusammen stößt, kann er dabei seine gesamte Energie an das Elektron abgeben und damit aufhören zu existieren - siehe Abbildung unten. Aufgrund des Energieerhaltungssatzes können wir ableiten, dass die kinetische Energie des aus dem Atom herausgeschlagenen Elektrons um seine Bindungsenergie (vor der Wechselwirkung) kleiner sein muss als die Energie des Gamma-Strahls. Eine solches Elektron wird auch Photoelektron genannt.

Man beachte, dass ein Ion zurückbleibt, wenn das Photoelektron das Atom verlässt und weiterhin dass der Gamma-Strahl in diesem Vorgang vollständig vernichtet wird.

Die beiden folgenden Punkte sind auch beachtenswert. Erstens kann ein Photoelektron, ähnlich einem Beta-Teilchen, Ionisationen entlang seiner Flugbahn verursachen. Weiterhin können Röntgenstrahlen emittiert werden, wenn die durch das Photoelektron entstandene Lücke in der Atomhülle durch ein Elektron einer äußeren Schale gefüllt wird. Wir erinnern uns das wir ein ähnliches Phänomen bereits in Kapitel 2 kennen gelernt haben, als wir uns mit dem Elektroneneinfang beschäftigt haben.

Compton-Effekt

Dieser Effekt ähnelt ein wenig dem Anspielen einer farbigen Kugel mit der weißen Kugel beim Billard. Hier gibt der Gammastrahl nur einen Teil seiner Energie an ein Valenzelektron, welches hier als freies Elektron betrachtet werden kann, ab - siehe Abbildung unten. Man beachte, dass das Elektron das Atom verlässt und sich wie ein Beta-Minus-Teilchen verhält und dass der Gammastrahl in eine andere Flugrichtung abgelenkt wird. Dieser abgelenkte Gammastrahl kann in weiteren Compton-Effekten mit den Elektronen des Materials wechselwirken. Wir bemerken, dass der Effekt auch als Compton-Streuung bezeichnet wird.

Dämpfung von Gamma-Strahlung

Die beiden oben beschriebenen Effekte führen zu Absorption und Streuung der radioaktiven Strahlen. Die Effekte werden unter dem Oberbegriff Dämpfung von Gamma-Strahlung zusammengefasst. Wir werden dieses Phänomen im nächsten Kapitel aus einer analytischen Perspektive untersuchen.

Strahlenbiologie

Es ist allgemein bekannt, dass ionisierende Strahlung lebende Zellen beschädigen kann. Wir haben oben die zugrundeliegenden atomaren Wechselwirkungen bereits behandelt. Für die Strahlenbiologie ist es wichtig, dass diese Wechselwirkungen komplexe Ketten biomolekularer Reaktionen auslösen können, die zu biologischen Schäden führen.

Wir haben weiter oben gesehen, dass die primären Wechselwirkungen von Strahlung und Materie zum Herausschleudern von Hüllenelektronen führen. Durch den Verlust eines oder mehrerer Hüllenelektronen bleibt das Atom positiv geladen zurück.

Andere Wechselwirkungen führen zur Anregung des Atoms und nicht zur Ionisation. Hierbei erhält ein (äußeres Valenz-) Elektron eine Energie, die ausreicht, um es in einen Anregungszustand zu heben. Ein solcher Zustand ist normalerweise nicht besetzt. Der mittlere Abstand des Elektrons vom Kern ist in diesen Zustand größer als in seinem ursprünglichen Zustand.

Dieser Effekt verändert die chemischen Kräfte, die Atome in Molekülen zusammen halten. Daher kann es zu einer Umstrukturierung der Atome zu einem neuen Molekül kommen. Daher ist die Anregung eine indirekte Methode chemische Veränderungen durch Modifikationen einzelner Atome (und damit ihrer Bindungen zu den Nachbaratomen) anzuregen.

Ionisationen und Anregungen können zu instabilen chemischen Systemen (Molekülbruchstücken) führen, welche als freie Radikale bezeichnet werden. Freie Radikale sind Atome (oder Moleküle), in denen es ungepaarte Elektronen gibt.

In Molekülen gibt es genauso wie in Atomen auch Zustände in denen sich die Elektronen des Moleküls befinden. Ein Zustand kann durch eine Gruppe von wenigen Zahlen beschrieben werden, welche man Quantenzahlen nennt. Eine von diesen heißt Spin. Alle anderen wollen wir hier als Grob-Quantenzahlen bezeichnen. Man hat experimentell gefunden, dass zwei Elektronen niemals im gleichen Zustand sind. Die Physiker Pauli und Fermi entwickelten daraufhin Theorien in denen zwei Elektronen niemals im gleichen Zustand seien dürfen. Eine Gruppe von Teilchen, zu denen auch das Elektron gehört, wurden daraufhin Fermionen genannt und die Aussage: „Zwei Fermionen befinden sich niemals im gleichen Zustand“ als Pauli-Verbot/Pauli(sches)-(Ausschließungs)-Prinzip bezeichnet. Stimmen also zwei Elektronen in allen ihren Grob-Quantenzahlen überein, so müssen Sie sich demnach in ihren Spinquantenzahlen unterscheiden. Stimmen zwei Elektronen in ihren Grobquantenzahlen überein, so bezeichnet man sie als gepaart. Gibt es in einem Atom (oder Molekül) ein Elektron, so kann es passieren, dass es kein weiteres Elektron im selben Atom (oder Molekül) gibt welches mit ihm in allen Grob-Quantenzahlen übereinstimmt. Ein solches Elektron bezeichnet man als ungepaartes Elektron und das Atom (oder Molekül) zu dem es gehört als ein Radikal.

Radikale sind chemisch sehr reaktionsfreudig und streben einen stabileren Zustand an indem sie Bindungen mit benachbarten Atomen und Molekülen eingehen. Die Entstehung freier Radikale führt daher meist zu Veränderungen der Moleküle in der Umgebung.

Aber schauen wir zuerst noch einmal die Wechselwirkungen selbst an.

Bei Wechselwirkungen mit Röntgen- und Gammastrahlen geht die Energie der Photonen (teilweise) auf die Hüllenelektronen über, zum Beispiel durch den Compton- und den Photoelektrischen Effekt. Diese Stahlen können tief in das Gewebe eindringen, da sie nur mit geringer Wahrscheinlichkeit mit Elektronen wechselwirken. In der Tat ist Nuklearmedizinische Bildgebung nur möglich, wenn die Energie der Gammastrahlen hoch genug ist, um den Körper des Patienten zu verlassen, aber zugleich klein genug ist, um mit dem Material des Detektors wechselwirken zu können und ein messbares Signal zu erzeugen.

Geladene Teilchen (z.B. Alpha- und Betateilchen) können jedoch auch durch anziehende oder abstoßende elektromagnetische Kräfte mit Atomkernen wechselwirken. Alphateilchen können auch mit Kernen kollidieren und sich oder den Kern dabei verändern. Bei der Wechselwirkung von Elektronen mit Kernen blieben beide in der Regel unverändert[1].

Die Rate, mit der ein geladenes Teilchen entlang seiner Bahn Energie verliert, hängt mit den Coulombkräften, durch die es mit den Teilchen in seiner Umgebung wechselwirkt, zusammen. Je größer die elektrische Ladung des Teilchens ist um so größer ist die Wahrscheinlichkeit Ionenpaare zu erzeugen, also soviel Energie auf (an Atome gebundene) Elektronen seiner Umgebung zu übertragen, dass sie ihre Atome verlassen. Langsamere Teilchen erzeugen ebenfalls mehr Ionenpaare, weil sie eine längere Zeit brauchen, um ihre Umgebung zu verlassen und daher länger mit dieser wechselwirken können.

Die Situation ist in der folgenden Abbildung, wo Spuren geladener Teilchen in Wasser abgebildet sind, dargestellt. Man sieht, dass die Bahn eines Alpha-Teilchens als relativ gerade Linie verläuft wie wir es bereits früher in diesem Kapitel besprochen haben. Wobei eine der große Anzahl an Wechselwirkungen (die als Kreuze entlang der Bahnkurven zu erkennen sind) pro Längeneinheit auftreten. Man sieht auch, dass die Bahnen der Elektronen stark gewunden verlaufen, wie wir bereits vorher besprochen haben, wobei die Anzahl der Wechselwirkungen pro Längeneinheit jedoch deutlich geringer ist (als bei Alpha-Teilchen).

Der Lineare Energietransfer (LET) ist definiert als die von einem ionisierenden Teilchen pro Längeneinheit an die Umgebung abgegebene Energie. Ein langsames Teilchen mit großer Ladung hat daher einen wesentlich höheren LET als ein schnelles Teilchen mit geringer Ladung. Ein Alpha-Teilchen von 5 MeV und ein Elektron von 1 MeV haben entsprechend LETs von 95 bzw. 0,25 keV/μm. Die Ionisationsdichte und damit das Muster der Wechselwirkungen, das durch die schweren stark geladenen Alpha-Teilchen hervorgerufen wird, ist viel dichter als das von den Elektronen erzeugte, wie man in der obigen Abbildung sieht.