Statistik: Regressionsanalyse

Einfaches lineares Regressionsmodell

Einführung mit Beispiel einer Preis-Absatz-Funktion

Eine renommierte Sektkellerei möchte einen hochwertigen Rieslingsekt auf den Markt bringen. Für die Festlegung des Abgabepreises soll zunächst eine Preis-Absatz-Funktion ermittelt werden. Dazu wurde in n = 6 Geschäften ein Testverkauf durchgeführt. Man erhielt sechs Wertepaare mit dem Ladenpreis x (in Euro) einer Flasche und die verkaufte Menge y an Flaschen:

| Laden | i | 1 | 2 | 3 | 4 | 5 | 6 |

| Preis einer Flasche | xi | 20 | 16 | 15 | 16 | 13 | 10 |

| verkaufte Menge | yi | 0 | 3 | 7 | 4 | 6 | 10 |

Modell

Man geht von folgendem statistischen Modell aus:

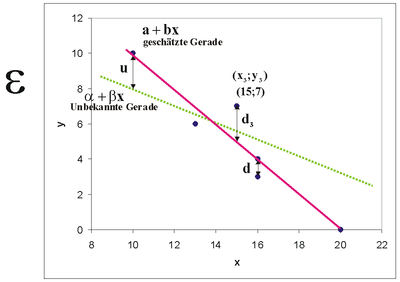

Man betrachtet zwei Variablen, die vermutlich ungefähr in einem linearen Zusammenhang

stehen. Dabei sind x als unabhängige und y als abhängige Variable definiert. Man nennt auch x erklärende oder exogene Variable und y Zielvariable oder endogene Variable. Es existieren von x und y je n Beobachtungen xi und yi (i = 1, ... , n). Der funktionale Zusammenhang y = f(x) zwischen x und y kann nicht exakt festgestellt werden, da α + βx von einer Störgröße u überlagert wird, die nichterfassbare Einflüsse (menschliches Verhalten, Messungenauigkeiten usw.) mit einschließt. Es ergibt sich also das Modell

mit den einzelnen Beobachtungen

Da α und βx nicht bekannt sind, kann y auch nicht in die Komponenten α + βx und u zerlegt werden.

Es soll eine mathematische Schätzung für die Parameter α und β durch zwei Konstanten a und b gefunden werden, und zwar so, daß sich ergibt

- ,

wobei di das Residuum bezeichnet, die Abweichung des beobachteten y- Wertes vom geschätzten. Es gibt verschiedene Möglichkeiten, die Regressiongerade zu schätzen. Man könnte eine Gerade so durch den Punkteschwarm legen, dass die Quadratsumme der Residuen, also der senkrechten Abweichungen di der Punkte von dieser Ausgleichsgeraden minimiert wird.

Beispiel zum Modell der Grundgesamtheit

In einem breit angelegten Versuch wird ein Flüssigdünger an in Nährlösung gezogenen Peperonis untersucht. Es wird wöchentlich jeder Pflanze eine bestimmte Menge Dünger verabreicht. Nach zwei Monaten wird der Gesamtertrag einer Pflanze gewogen. Die Abhängigkeit des Ertrags y (kg) von der Düngermenge x (ml) lässt sich beschreiben als

wobei natürlich kein Mensch diese Gerade kennt, wir können nur einzelne Versuche machen. In der Tabelle 1 sind für die Düngergaben 40, 50, ... ,120 ml für jeweils 8 Pflanzen die resultierenden Erträge aufgeführt. Man sieht, dass die Erträge um schwanken, was natürlich an der Störgröße liegt.

Betrachten wir die Störgröße bei einer Düngermenge von x3 = 60 ml. Es wurden hier die Erträge von 150 Peperoni-Pflanzen erfasst. Wenn man die Realisationen der Störgröße u3 in einem Dotplot abträgt (Grafik 2), erkennt man, dass die Werte normalverteilt sein könnten. Zu x3 gehört also eine eigene Wahrscheinlichkeitsverteilung der Störgröße, ebenso zu x1, x2 usw. In der Grafik 3 sind diese verschiedenen Verteilungen der u exemplarisch angedeutet.

|

|

Axiome des linearen Regressionsmodells

Damit dieses Verfahren sinnvolle Ergebnisse liefert, wurden für das Lineare Regressionsmodell bestimmte verteilungstheoretische Annahmen getroffen. Wir gehen aus von der Beziehung

und definieren die Störgröße ui als Zufallsvariable. Die Annahmen des linearen Regressionsmodell sind

- Alle ui haben den Erwartungswert Null: , (i = 1, ..., n) .

- Alle ui haben die gleiche Varianz (Homoskedastizität): (i,j = 1, ... , n, i ≠ j) .

- Die ui sind sämtlich stochastisch unabhängig voneinander.

Der Sinn dieser Axiome wird weiter unten erläutert.

Minimierung

Die herkömmliche Methode, die sich auf der Basis der Axiome ergibt, ist die Minimum-Quadrat-Methode oder Methode der kleinsten Quadrate. Man minimiert also die summierten Quadrate der Residuen,

bezüglich a und b.

Wir multiplizieren die Klammer aus:

Wir minimieren durch Ableiten

und Nullsetzen, was ein wenig optisch geschönt die Normalgleichungen

ergibt.

Wir erhalten die gesuchten Regressionskoeffizienten als die Lösungen

und

wobei der Mittelwert, also der Durchschnitt der x-Daten ist, y entsprechend. Wegen des Verschiebungssatzes kann man b auch darstellen als

oder, nach Erweiterung des Bruchs durch 1/(n-1),

mit sxy als Kovarianz zwischen den xiund yi und sx2 als Varianz der xi. Man nennt diese Schätzungen auch Kleinste-Quadrate-Schätzer, KQ- oder OLS-Schätzer.

Wir wollen nun für das obige Sektbeispiel die Regressionskoeffizienten bestimmen:

| Preis einer Flasche |

verkaufte |

xi- x |

yi- y |

|

|

|

|

|

xi |

yi |

x* |

y* |

x*y* |

x*x* |

y*y* |

ŷ |

|

20 |

0 |

5 |

-5 |

-25 |

25 |

25 |

0,09 |

|

16 |

3 |

1 |

-2 |

-2 |

1 |

4 |

4,02 |

|

15 |

7 |

0 |

2 |

0 |

0 |

4 |

5,00 |

|

16 |

4 |

1 |

-1 |

-1 |

1 |

1 |

4,02 |

|

13 |

6 |

-2 |

1 |

-2 |

4 |

1 |

6,96 |

|

10 |

10 |

-5 |

5 |

-25 |

25 |

25 |

9,91 |

|

90 |

30 |

0 |

0 |

-55 |

56 |

60 |

30,00 |

Wir berechnen in dem Beispiel zunächst die arithmetischen Mittel als die Koordinaten des Schwerpunktes der Messwerte bzw. der Punktwolke.

- entsprechend :,

und dann die Regressionskoeffizienten

- als die Steigung der Regressionsgeraden

und

Die geschätzte Regressionsgerade lautet , so dass man vermuten kann, dass bei jedem Euro mehr der Absatz im Durchschnitt um ca. 1 Flasche sinkt.

Für die gegebenen x-Werte erhalten wir als Schätzungen ŷ

Für die beobachteten Absatzwerte y bleibt das Residuum ri übrig:

Schätzung der Varianzen

Die Stichprobenvarianz der Residuen berechnet sich als:

Man schätzt damit die Varianz der Störgröße u (eigentlich U!).

Gesetzmäßigkeiten

Bezüglich der Zielvariablen und der Residuen gilt:

- und damit .

- Die Residuen sind im Mittel Null, sie enthalten also keine Information mehr.

- Die unabhängige Variable x und die Residuen sind orthogonal. Geometrisch bedeutet das, dass sie senkrecht aufeinander stehen. Sie sind daher unkorreliert. Die Residuen enthalten also keinerlei Information mehr, die in x steckt. Die Informationen aus x sind alle in a + bx. Nur, was von x nicht mehr erklärt werden kann, bleibt als Rest in d.

- Das arithmetische Mittel der ŷ ist gleich dem Mittel von y.

Vorteile der Minimum-Quadrat-Methode:

- Positive und negative Abweichungen heben sich bei Summenbildung nicht auf.

- Große Residuen werden im Verhältnis stärker gewichtet als kleine.

- Der Durchschnitt der Residuen ist Null.

- Die Regressionskoeffizienten können mit einer Formel berechnet werden.

Nachteil der Minimum-Quadrat-Methode:

- Nicht resistent gegenüber Ausreißern in den Daten.

Sekt-Beispiel:

Wegen eines Erhebungsfehlers wurde für x6 statt 10 der Wert 70 eingetippt. Die neue Regressionsgerade ergibt sich als ŷ = 2,51 + 0,10x. Dieser Ausreißer beeinträchtigt das Ergebnis so sehr, dass sogar das Vorzeichen der Steigung umgedreht wird. Eigentlich sollte die Regressionsgerade durch die Punktwolke auf der linken Seite der Grafik führen und fallend sein. Der Ausreißer hebelt die Gerade regelrecht aus: Man spricht von einem High-Leverage-Value, also einem Wert mit großer Hebelkraft. Wir erkennen sofort, dass dieser Ausreißer die Analyse völlig wertlos gemacht hat. In dem speziellen Sachzusammenhang könnte man sogar einen fatalen Fehlschluss machen: Bei Luxusgütern sind steigende Preis-Absatz-Funktionen denkbar, weil ein hoher Preis statusfördernd ist. Man könnte also fälschlicherweise annehmen, dass dieser Zusammenhang auch hier gilt. Man würde also einen sehr hohen Preis festlegen und am Markt scheitern.

Bestimmtheitsmaß

Ein Kriterium für die Beurteilung der Güte einer Regressionsschätzung ist das Bestimmtheitsmaß. Die Begründung für dieses Maß leitet sich aus der sog. Streuungszerlegung her. Die Gesamtvarianz von y läßt sich, ausgehend von der Beziehung

zerlegen in die durch a + bx erklärte Varianz von y und die nicht erklärte Varianz:

Einige Umformungen ergeben das Bestimmtheitsmaß

als Anteil der erklärten Streuung an der Gesamtstreuung von y. Es ist

wobei ersichlich ist, daß r2 das Quadrat des Korrelationskoeffizienten von x und y darstellt. Mit dem Verschiebungssatz erhalten wir

Es gilt:

Je näher r2 bei 1 ist, desto größer ist der Anteil der erklärten Streuung, desto besser wird y durch x erklärt. r2 = 0 bedeutet, dass x und y unkorreliert sind, und r2 = 1, dass x und y eine Gerade bilden.

Die Berechnung der Varianz der Residuen von Hand mit der Formel

ist aufwendig, weil zuerst die Residuen ermittelt werden müssen. Eine vereinfachte Form leitet sich aus der Beziehung

her. Es ist dann nämlich

Sekt-Beispiel

Da hier die arithmetischen Durchschnitte glatte Werte sind, wollen wir das Bestimmtheitsmaß mit der Formel

ermitteln. Die Quadratsummen wurden oben in der Tabelle bereits ausgerechnet. Wir erhalten

Man könnte also sagen, dass etwa 90% der Information in y von x stammen, die restlichen 10% haben andere Ursachen.

Anforderungen an das Regressionsmodell

Das Regressionsmodell kann nur optimale Ergebnisse liefern, wenn bestimmte Anforderungen erfüllt sind. Diese Anforderungen lassen sich aus dem Axiomensystem des klassischen linearen Regressionsmodells herleiten:

Die Residuen sollen nur rein zufällig streuen und keinerlei Systematik mehr enthalten, d.h. die Zielvariable y soll durch x vollständig erklärt werden. Systematik in den Residuen deutet daraufhin, daß das Modell möglicherweise falsch bestimmt wurde, d.h. es liegt ein Spezifikationsfehler vor.

Als bestes Mittel zur Überprüfung dieser Modellvoraussetzungen wird das (x;y)-Streudiagramm angesehen, das schnell einen optischen Eindruck von der Verteilung der Störgröße vermittelt.

Prognose

Ein Ziel der Regressionsanalyse ist die Prognose ŷ0, d.h. man fragt danach, welchen Wert y annimmt, wenn ein bestimmtes x0 vorgegeben ist:

Sekt-Beispiel: Wieviel Flaschen Sekt werden im Durchschnitt verkauft, wenn der Preis auf x0 = 11 Euros festgelegt wird? Es ergibt sich der Prognosewert

Das heißt jetzt aber nicht, dass in jedem Laden genau 8,93 Flaschen verkauft werden, was auch schwierig sein dürfte, sondern dass in einem Laden durchschnittlich 8,93 Flaschen abgesetzt werden.

Je weiter x0 vom „Zentrum“ x der Daten entfernt ist, desto unverläßlicher werden die Prognosen - ihre Varianz wird immer größer. Deshalb sollte man sich bei einer Prognose nicht zu weit von den Daten entfernen.

Multiple Regression

Beispiel mit demografischen Daten ausgewählter Länder:

| Row i | Country | popgrow | birth | mort | fertil | explife | infmort |

|---|---|---|---|---|---|---|---|

| y | x1 | x2 | x3 | x4 | x5 | ||

| 1 | Austria | 0,14 | 8,90 | 9,56 | 1,35 | 78,87 | 4,68 |

| 2 | Burkina Faso | 2,57 | 44,46 | 18,79 | 6,28 | 44,20 | 98,67 |

| 3 | Burma | 0,47 | 18,64 | 12,16 | 2,08 | 56,01 | 68,78 |

| 4 | Chile | 1,01 | 15,77 | 5,71 | 2,06 | 76,38 | 9,05 |

| 5 | Costa Rica | 1,52 | 18,99 | 4,32 | 2,33 | 76,63 | 10,26 |

| 6 | Iraq | 2,74 | 33,09 | 5,66 | 4,40 | 68,26 | 52,71 |

| 7 | Norway | 0,41 | 11,89 | 9,51 | 1,78 | 79,25 | 3,73 |

| 8 | Portugal | 0,41 | 10,90 | 10,37 | 1,46 | 77,35 | 5,13 |

| 9 | Singapore | 1,71 | 9,63 | 4,05 | 1,04 | 81,53 | 2,28 |

| 10 | United Kingdom | 0,29 | 10,88 | 10,19 | 1,66 | 78,27 | 5,22 |

Erklärung der Variablen:

| birth | Geburtenrate (Zahl der Geburten pro 1000 Einwohner) |

| explife | Lebenserwartung (Mittlere Zahl der Lebensjahre von Geburt an) |

| fertil | Fertilität (Durchschn. Kinderzahl pro gebärfähiger Frau) |

| infmort | Kindersterblichkeit (Zahl der verstorbenen Kinder unter einem Jahr pro 1000 Lebendgeburten) |

| mort | Sterblichkeit (Zahl der Verstorbenen pro 1000 Einwohner) |

| popgrow | Wachstumsrate der Bevölkerung (prozentuale Änderung der Einwohnerzahl gegenüber dem Vorjahr) |

Es wurden die demografischen Daten für n=10 zufällig ausgewählte Länder erhoben (Quelle: Worldfact-Book der CIA)

Es soll nun das Bevölkerungswachstum popgrow erklärt werden. Es wird zunächst als erklärende Variable die Geburtenrate birth versucht:

- bzw.

Wir erhalten die Regressionsgerade

mit einem Bestimmtheitsmaß von 66,4%. Die Information in popgrow wird also zu 66% durch birth erklärt, die restlichen 34% entstammen anderen Einflussgrößen. Wir machen einen zweiten Versuch und verwenden die Sterblichkeit als erklärende Variable:

- .

Hier ergibt sich als Regressionsgerade

mit einem Bestimmtheitsmaß von ca. 0%. Dieses Ergebnis ist enttäuschend und auch das vorherige war nicht gerade berauschend. Jetzt versuchen wir mal was Innovatives: Wir machen einen Regressionsansatz mit zwei unabhängigen Variablen

- bzw. .

Gesucht ist also die geschätzte Regressionsebene

- .

Wir erhalten das Gleichungssystem

Wir wollen nun die einzelnen Daten zu Matrizen zusammenfassen. Wir erhalten die (10x3)-Datenmatrix

und die Vektoren

- und

Mit diesen Matrizen können wir das Gleichungssystem in Matrixschreibweise darstellen als

wobei Vektoren und Matrizen unterstrichen sind.

Auch hier wird die Quadratsumme der Residuen minimiert, um die Regressionskoeffizienten zu erhalten. Diese berechnen sich mit der Formel

- .

Wir erhalten den Vektor der Regressionskoeffizienten

also

- bzw.

- .

Das Bestimmtheitmaß ist hier 88,8%. Die Anpassung hat sich beträchtlich verbessert. Hier scheint das Zusammenwirken der beiden Regressoren mehr bewirkt zu haben als die „Summe der Teile“.

Die Wurzel aus dem Bestimmtheitsmaß ergibt den multiplen Korrelationskoeffizienten r = 0,942. Der multiple Korrelationskoeffizient kann nur zwischen 0 und 1 liegen, wobei 1 wieder vollständige Korrelation bedeutet.

Die Regressionskoeffizienten 0,089 und 0,117 sind die partiellen Ableitungen der Regressionsebene. Man könnte die Koeffizienten so interpretieren: Steigt bei konstanter Sterblichkeit die Geburtenrate um einen Punkt, erhöht sich das Bevölkerungswachstum um ca. 0,1 Prozent. Steigt dagegen bei konstanter Geburtenrate die Sterblichkeit um einen Punkt, sinkt das Bevölkerungswachstum um ca. einen Punkt. Eine simultane Analyse der Regressionsebene bezüglich beider Regressionskoeffizienten ist kompliziert und meistens auch nicht sinnvoll interpretierbar. Die Analyse eines Regressionskoeffizienten bei Konstanthaltung der übrigen Regressoren nennt man eine Ceteris-Paribus-Analyse.

In der Regel ist die Berechnung der Regressionskoeffizienten im multiplen linearen Regressionsmodell so aufwendig, daß Computer eingesetzt werden müssen. Spezielle statistische Datenbanksysteme wie SPSS,SAS oder Minitab ermöglichen eine umfassende Regressionsanalyse.

Die Vor- und Nachteile der Minimum-Quadrat-Methode sind dieselben wie bei der Einfachregression: Es sei x8,2 = 100 statt 10,9. Man erhält

mit einem Bestimmtheitsmaß von 0,7%.

Literatur

[Bearbeiten]- Peter Schönfeld: Methoden der Ökonometrie, Berlin/Frankfurt, 1969

- Norman R. Draper und Harry Smith: Applied Regression Analysis, John Wiley & Sons Inc. 1998, ISBN 0471170828