Statistik: Druckversion

<< Statistik

Dieser Text ist sowohl unter der „Creative Commons Attribution/Share-Alike“-Lizenz 3.0 als auch GFDL lizenziert.

Eine deutschsprachige Beschreibung für Autoren und Weiternutzer findet man in den Nutzungsbedingungen der Wikimedia Foundation.

- 0. Einführung

- 3. Ausgewählte Verteilungen

- 3.1. Diskrete Verteilungen

- 3.1.1. Binomialverteilung

- 3.1.2. Hypergeometrische Verteilung

- 3.1.3. Poissonverteilung

- 3.2. Stetige Verteilungen

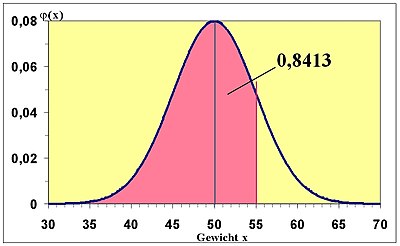

- 3.2.1. Normalverteilung

- 3.2.1.1. Zentraler Grenzwertsatz

- 3.2.1.2. Lineare Funktionen der Normalverteilung

- 3.2.1.3. Nichtlineare Funktionen der Normalverteilung

- 3.2.1.3.1. χ2-Verteilung

- 3.2.1.3.2. F-Verteilung

- 3.2.1.3.3. t-Verteilung

- 3.2.1. Normalverteilung

- 3.3. Approximation von Verteilungen

- 3.1. Diskrete Verteilungen

- 4. Deskriptive Statistik

- 4.1. Zentrale Begriffe in der deskriptiven Statistik

- 4.2. Analyse von Daten eines metrischen Merkmals mit wenigen verschiedenen Beobachtungen

- 4.2.1. Häufigkeitsverteilung

- 4.2.2. Lageparameter

- 4.2.3. Streuungsparameter

- 4.3. Daten, die in Häufigkeitstabellen zusammengefasst sind

- 4.3.1. Merkmale mit wenig Ausprägungen

- 4.3.1.1. Verteilung

- 4.3.1.1.1. Häufigkeit

- 4.3.1.1.2. Summenfunktion

- 4.3.1.2. Lageparameter

- 4.3.1.3. Streuungsparameter

- 4.3.1.1. Verteilung

- 4.3.2. Metrisches Merkmal mit vielen Ausprägungen

- 4.3.2.1. Verteilung

- 4.3.2.1.1. Klassierung

- 4.3.2.1.2. Summenkurve

- 4.3.2.2. Lageparameter

- 4.3.2.3. Streuungsparameter

- 4.3.2.1. Verteilung

- 4.3.1. Merkmale mit wenig Ausprägungen

- 5. Mehrere Merkmale

- 5.1. Korrelationsanalyse

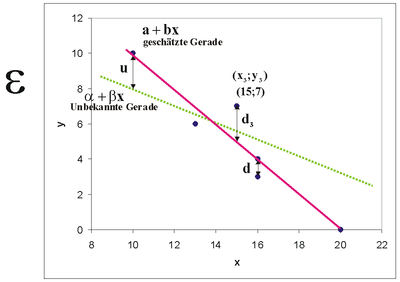

- 5.2. Regressionsanalyse

- 5.3. Zeitreihenanalyse

- 5.3.1. Trend und Saisonkomponente

- 5.3.2. Glättungsverfahren

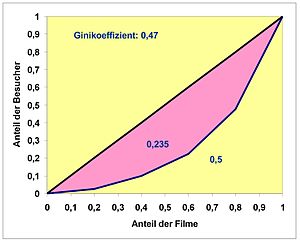

- 6. Maßzahlen

- 6.1. Konzentration

- 7. Schätzen und Testen

- 7.1. Konfidenzintervalle

- 7.2. Hypothesentests

- 7.2.1. Verteilungsgebundene Tests

- 7.2.1.1. Test auf Erwartungswert

- 7.2.1.2. Test auf Anteilswert

- 7.2.1.3. Test auf Varianz

- 7.2.1.4. Vergleich mehrerer Parameter

- 7.2.1.4.1. Vergleich zweier Lageparameter

- 7.2.1.4.2. Vergleich zweier Varianzen

- 7.2.1.5. Prüfung des Zusammenhangs zweier Merkmale

- 7.2.1. Verteilungsgebundene Tests

- 10. Literatur

- 11. Tabellen

- 11.1. Verteilungstabellen

- 11.1.1. Normalverteilung

- 11.1.2. Chi-Quadrat-Verteilung

- 11.1.3. F-Verteilung

- 11.1.4. t-Verteilung

- 11.2. Weltdaten

- 11.1. Verteilungstabellen

| 0. | Was ist Statistik? |

| ||||

|---|---|---|---|---|---|---|

Was ist Statistik?

Statistik begegnet uns überall im täglichen Leben:

- Die Lebenshaltungskosten sind gegenüber dem Vorjahr um 2 Prozentpunkte gestiegen.

- Im Januar 2005 erzielte die Firma Dachs im Durchschnitt die täglichen Aktienkurse, wie in der Grafik angegeben.

- Hochrechnung von Wahlergebnissen

- Wieviel Gewinn kann eine Lottogesellschaft auswerfen, damit ihr noch Überschuss bleibt?

Was haben diese Beispiele gemeinsam? Sie basieren auf Daten, und zwar sehr vielen Daten. In diese Daten wird Ordnung gebracht: Mit einer Grafik, mit Wahrscheinlichkeiten, mit Durchschnittsberechnungen, mit Vergleichen. Das ist angewandte Statistik.

Wir kommen damit zu einer Definition der Statistik, die relativ kurz und schnörkellos ist, aber im Wesentlichen alles sagt:

- Statistik ist die Gesamtheit der Methoden, die für die Untersuchung von Massendaten angewendet werden können.

Ziel der Statistik ist es also, Massendaten zu reduzieren und zu komprimieren, um Gesetzmäßigkeiten und Strukturen in den Daten sichtbar zu machen.

Anwendung im wirtschaftlichen Kontext

Die Lage der Unternehmen heute ist geprägt von Globalisierung, Konkurrenz und Kostendruck. Einsame Manager-Entscheidungen aus dem Bauch heraus führen häufig zum Ruin des Unternehmens. Die Analyse von Wirtschafts- und Unternehmensdaten erlaubt rationale und fundierte Unternehmensentscheidungen. In der Realität sind jedoch Informationen über Unternehmensprozesse nur teilweise bekannt. Gründe dafür sind beispielsweise

- Die Informationen sind zu komplex, um vollständig erhoben zu werden. Beispiel: Der Papierverbrauch in einem großen Unternehmen hängt von vielen Faktoren ab, wie der Zahl der Kopien eines Schreibens, der Neigung der Mitarbeiter, sich alles ausdrucken zu lassen (E-Mails!), dem Umfang des Verteilers für bestimmte Schreiben etc. Man kann den Verbrauch nicht analytisch bestimmen.

- Zukünftige Unternehmenszahlen sind nicht bekannt und müssen geschätzt werden, z. B. der Cash-Flow einer geplanten Investition für die Finanzierungsrechnung.

- Umwelteinflüsse können nicht vorherbestimmt werden, etwa die Möglichkeit einer Steuererhöhung oder die Akzeptanz eines neuen Produkts durch den Kunden.

In solchen Fällen können keine exakten Entscheidungsgrundlagen geliefert werden. Die resultierenden Lösungen sind „unscharf“. Ein Hilfsmittel für die Entscheidung unter Unsicherheit ist die Statistik.

Da in der heutigen informationsbasierten Gesellschaft eher zu viel als zu wenig Daten verfügbar sind, gewinnt die Statistik als Werkzeug der Entscheidungsfindung immer mehr an Bedeutung.

Einteilung der statistischen Methoden

- Deskriptive (beschreibende, empirische) Statistik: Man untersucht ein Phänomen und fasst die Daten zusammen, ordnet sie, stellt sie grafisch dar. Auf wissenschaftliche Aussagen wird verzichtet.

- Induktive (schließende, folgernde, mathematische, analytische) Statistik: Grundlage ist die Wahrscheinlichkeitstheorie. Ergebnisse der deskriptiven Statistik dienen häufig als Ausgangspunkt für verallgemeinernde Aussagen.

Die mathematische Statistik selbst ist wie die Wahrscheinlichkeitstheorie ein Teilgebiet der Stochastik.

| 1. | Wahrscheinlichkeitsrechnung |

| ||||

|---|---|---|---|---|---|---|

Was ist Wahrscheinlichkeit?

Das weiß niemand. Sie ist ein Produkt menschlicher Bemühungen, Ereignisse in der Zukunft vorherzusagen. Sie soll eine Vorstellung über den Grad der Sicherheit vermitteln, mit der ein Ereignis auftritt. Jeder weiß, was es bedeutet, wenn gesagt wird: Die Wahrscheinlichkeit, eine Sechs zu würfeln ist größer als die Wahrscheinlichkeit, beim Skat einen Grand zu gewinnen. Aber trotzdem kann man Wahrscheinlichkeit nicht exakt definieren. So könnte man Wahrscheinlichkeitstheorie als Stochern im Nebel bezeichnen. Das hat aber nichts mit dem Begriff Stochastik zu tun!

| 1.1. | Zufallsvorgang und Wahrscheinlichkeit |

| ||||

|---|---|---|---|---|---|---|

Pizzaecken-Beispiel zum Begriff der Wahrscheinlichkeit

Harry und Paula gehen in die Pizzeria. Sie sind frisch verliebt. Paula bestellt sich eine Pizzaecke mit Salami und Harry eine mit Schinken. Dann tauschen sie jeweils eine Hälfte, wobei anzumerken ist, dass die Ecken sich in Rand- und Mittelstück teilen lassen. Obwohl Harry normalerweise Randstücke lieber mag, achtet er in seinem aktuellen Zustand nicht darauf. Und auch Paula gibt ihre Hälfte rein nach Zufall ab.

Wie groß ist eigentlich die Wahrscheinlichkeit, dass Harry zwei Randstücke auf dem Teller hat?

Die Meisten antworten richtig: 1/4.

Aber wieso beträgt die Wahrscheinlichkeit ausgerechnet 1/4?

Betrachten wir den Vorgang:

Bei gleicher Ausgangslage (Bedingungskomplex) kann der Versuch, zwei halbe Pizzaecken zufällig auszutauschen, beliebig oft wiederholt werden. Jeder Versuch hat einen unsicheren Ausgang. Es handelt sich hier um einen Zufallsvorgang (Experiment, Versuch).

Der Zufallsvorgang wird also beschrieben durch:

- Gleicher Bedingungskomplex

- Unsicherer Ausgang

- Beliebig oft wiederholbar

Ein bestimmtes Paar Eckhälften auf Harrys Teller ist ein Ergebnis.

Ein Ergebnis wäre beispielsweise: Die erste Hälfte ist ein Randstück, die zweite Hälfte ist ein Mittelstück,

- (R;M) oder kurz RM,

wobei das „linke“ Stück von Harry stammt und das „rechte“ von Paula.

Alle möglichen Paare fasst man in der Ergebnismenge Ω zusammen:

- Ω = {RR, RM, MR, MM}.

Ω ist also die Menge aller möglichen Ergebnisse, die bei einem Zufallsvorgang auftreten können. Führt man diesen Zufallsvorgang unendlich oft durch, müssten vermutlich in 25% aller Versuche zwei Randstücke resultieren, denn man könnte davon ausgehen, dass jedes Paar die gleiche Wahrscheinlichkeit hat, gezogen zu werden. Die Zahl der Ergebnisse, |Ω| genannt, ist also vier. Deshalb ist die Wahrscheinlichkeit für ein Paar Randstücke

Wenn nun bei einem Versuch beispielsweise „RM“ resultiert, ist das ein Ereignis.

Bei „RM“ handelt es sich um ein Elementarereignis. Es ist ein Ereignis, das nur ein Element der Ergebnismenge enthält.

Es gibt auch kompliziertere, zusammengesetzte Ereignisse:

- A: Mindestens ein Mittelstück: A = {RM, MR, MM}

- B: Eine komplette Pizzaecke: B = {RM, MR}

Diese Ereignisse beinhalten mehrere Ergebnisse von Ω; ein Ereignis ist immer eine Teilmenge von Ω.

Das zusammengesetzte Ereignis A tritt also genau dann ein, wenn eines der Elementarereignisse {RM}, {MR} oder {MM}, die in A enthalten sind, eintritt.

Die Wahrscheinlichkeit als theoretisches Konzept

Kurzer geschichtlicher Überblick

Es werden vermutlich schon so lange Wahrscheinlichkeiten angewendet, wie es den Homo Sapiens gibt. Am letzten Tag der Schlacht im Teutoburger Wald (9 n. Chr.) gab es ein Gewitter. Die Römer deuteten es als warnenden Hinweis von Merkur, des Gottes von Blitz und Donner. Die Germanen sahen es als Aufmunterung des Kriegsgottes Thor. Wie man weiß, hatten beide Parteien recht.

Im 17. Jahrhundert, dem Zeitalter des Rationalismus, befasste sich Blaise Pascal (1623 - 1662) systematisch mit Wahrscheinlichkeiten im Glücksspiel und begründete so die Wahrscheinlichkeitsrechnung als eigenständige Disziplin.

Jakob Bernoulli (1654 - 1705) befasste sich ebenfalls mit Fragen der diskreten Wahrscheinlichkeiten und gab vermutlich das erste Buch über Wahrscheinlichkeitsrechnung heraus.

Mit Abraham de Moivre (1667 - 1754) und Pierre Simon Laplace (1749 - 1827) wurde bereits die Normalverteilung entwickelt und von Carl Friedrich Gauß (1777 – 1855) weiter bearbeitet.

Richard Edler von Mises (1883 - 1953) lieferte wertvolle Beiträge zur Schätzung von Wahrscheinlichkeiten und zur mathematischen Statistik.

1933 schlug der russische Mathematiker Andrej Nikolajewitsch Kolmogorow (1903 - 1987) eine axiomatische Definition der Wahrscheinlichkeit vor, auf der die heutige Wahrscheinlichkeitstheorie basiert. Diese Definition ist eine Anwendung der Maßtheorie.

Ergebnisse und Ereignisse

Das heutige Konzept der Wahrscheinlichkeitsrechnung präsentiert sich folgendermaßen:

Gegeben ist die Ergebnismenge (Ereignisraum, Stichprobenraum) Ω eines Zufallsvorgangs. Diese Menge enthält alle möglichen Ergebnisse, die ein Zufallsvorgang hervorbringen kann. Je nach Art des Zufallsvorgangs muss man verschiedene Ergebnismengen betrachten:

Ω enthält endlich viele Ergebnisse.

Beispiele:

- Zufallsvorgang: 1x Würfeln. Ω = {1, 2, 3, 4, 5, 6}.

- Zufallsvorgang: Augenfarbe der nächsten Person, die bei einem Casting vorspricht. Ω = {blau, grün, braun}.

Ω enthält abzählbar unendlich viele Ergebnisse.

Beispiele:

- Zufallsvorgang: Zahl der Autos, die eine Stunde lang ab 12 Uhr bei einer Fahrzeugzählung an einer bestimmten Zählstelle vorbeifahren. Ω = {0, 1, 2, 3, ...}.

- Zufallsvorgang: Zahl der Anforderungen an einen Server innerhalb einer Stunde. Ω = {0, 1, 2, ...}.

- Man kann zwar die Ergebnisse durchzählen, aber es kann keine vernünftige Obergrenze angegeben werden, deshalb lässt man die Obergrenze offen.

Ist Ω weder abzählbar noch abzählbar unendlich, so enthält Ω überabzählbar viele Ergebnisse. Man könnte auch sagen, die Ergebnismenge ist ein Intervall der reellen Zahlen.

Beispiele:

- Zufallsvorgang: Eine erwachsene Person wird gewogen (in kg). Ω = {x|30 ≤ x ≤ 200; x ∈ }.

- Zufallsvorgang: Cash-Flow eines Unternehmens (in €). Ω = .

- Cash-Flow bezeichnet übrigens die Differenz Einnahmen - Ausgaben, bzw. präziser: Einzahlungen - Auszahlungen.

- Hier können die Ergebnisse nicht mehr abgezählt werden. Ein beliebig kleines Intervall der Ergebnismenge enthält unendlich viele Elemente. Was ist das nächstgrößere Element von 50 kg: 51 kg, 50,01 kg oder 50,000000001 kg? Im Intervall [50, 51] sind also unendlich viele Elemente.

- Man könnte hier einwenden, dass doch beispielsweise Cash-Flow als kleinste Einheit Cent hat, also doch eigentlich abzählbar ist. Das stimmt natürlich, aber bei sehr vielen, nah zusammenliegenden Elementen vereinfacht man die Analyse, indem man die Menge als stetig annimmt. Man spricht hier von Quasistetigkeit.

Hat ein Zufallsvorgang ein konkretes Ergebnis erbracht, ist ein Ereignis eingetreten. Es gibt einfache Ereignisse, die lediglich ein Ergebnis enthalten, so genannte Elementarereignisse und es gibt komplexere Ereignisse, die sich aus mehreren Ergebnissen zusammensetzen. Ein Ereignis A ist immer eine Teilmenge der Ergebnismenge Ω.

Da Ereignisse Mengen sind, können alle Operationen der Mengenalgebra, die mit der Booleschen Algebra (auch Schaltalgebra) gleichgesetzt werden kann, angewendet werden. Grundlegende Operationen für Mengen der Booleschen Algebra sind - („nicht“ als Komplement), ∩ und ∪. Alle anderen Operationen können daraus hergeleitet werden.

Alle interessierenden Ereignisse fasst man nun in einer so genannten Ereignismenge (Ereignissystem) E zusammen. E ist also eine Menge von Teilmengen. Damit diese Menge mit der Booleschen Algebra bearbeitet werden kann, muss sie entsprechende Forderungen erfüllen:

- Wenn das Ereignis in enthalten ist, muss auch sein Komplement enthalten sein.

- Wenn und enthalten sind, muss auch enthalten sein (Man kann ausrechnen, dass dann auch A ∩ B enthalten ist).

- Es muss das „Null-Element“ Ø enthalten sein (Das impliziert, dass auch „1-Element“ Ω , welches das Komplement von Ø ist, enthalten ist).

Eine Ereignismenge, bei der die zweite Forderung auch für abzählbar viele Teilmengen erfüllt ist (die Vereinigung abzählbar vieler Teilmengen des Mengensystems ist in der Ereignismenge enthalten) nennt man -Algebra. Die umfassendste Ereignismenge ist die Potenzmenge P, die alle Teilmengen von Ω enthält. Die Potenzmenge wird in der Litatur zuweilen auch als bezeichnet.

Beispiel einer Potenzmenge:

Zufallsvorgang: Aus einer Urne mit einer blauen (b), einer roten (r) und einer gelben (g) Kugel wird eine Kugel gezogen. Wir interessieren uns für die Farbe der Kugel.

Ergebnismenge: Ω = {g, b, r}

Potenzmenge: P = {Ø, {r}, {g}, {b}, {r, g}, {r, b}, {g, b}, {r, g, b}}

Ausgehend von dieser Konstellation hat Kolmogorow mit seinen Axiomen ein Wahrscheinlichkeitsmaß konstruiert, d.h. eine Abbildung der Ergebnismenge Ω auf die Menge der reellen Zahlen im Intervall [0;1]:

- F: Ω → ; A → P(A)

Eine Funktion P, die jedem Ereignis A aus E eine reelle Zahl zuordnet, heißt Wahrscheinlichkeit, wenn sie folgende Axiome erfüllt:

Axiome der Wahrscheinlichkeiten:

Gegeben sind zwei Ereignisse A,B ⊂ Ω.

- Nichtnegativität

- Normiertheit

- falls A und B disjunkt sind. Additivität

Dieses Axiomensystem kann nur auf endlich viele Ereignisse angewendet werden. Für unendlich viele Ereignisse Ai (i = 1, 2, ...) erhält man statt der endlichen Ereignismenge die σ-Algebra. Sie enthält alle geforderten Eigenschaften der Ereignismenge auf unendlich viele Ereignisse Ai ausgeweitet. Hier wird das 3. Axiom entsprechend angepasst:

- 3. Sind die Ereignisse Ai sämtlich paarweise disjunkt, ist bei ihrer Vereinigung

- (σ-Additivität).

Berechnung der Wahrscheinlichkeit eines Ereignisses

Es müssen nun noch die Ereignisse mit Wahrscheinlichkeiten ausgestattet werden. Auf welche Weise das geschehen soll, ist in den Axiomen nicht angegeben. Es gibt hier verschiedene Verfahren. Man erhält schließlich die Wahrscheinlichkeitsverteilung.

Wie ordnen wir den Ereignissen am besten Wahrscheinlichkeiten zu?

Betrachten wir im Pizzaecken-Beispiel das Ereignis A: Mindestens ein Mittelstück. Es ist A = {RM, MR, MM}. A belegt in Ω drei von vier möglichen Ergebnissen, also ist die Wahrscheinlichkeit P(A) = 3/4. Diese Vorgehensweise entspricht der Klassischen Wahrscheinlichkeitsauffassung. Man bezeichnet sie als Symmetrieprinzip oder Prinzip nach LAPLACE:

Jedes Ergebnis ist gleich häufig. |A| ist die Zahl der Ergebnisse, die durch A belegt werden (Anzahl der günstigen Ergebnisse), |Ω| ist die Zahl aller möglichen Ergebnisse. Es ist

Das Symmetrieprinzip hat allerdings den Nachteil, dass es nicht bei allen Zufallsvorgängen angewendet werden kann, z.B. bei unendlich vielen Ergebnissen. Oft ordnet man auch Ergebnissen unterschiedliche Wahrscheinlichkeiten zu, z.B.

Zufallsvorgang: Wetter von heute.

Ergebnismenge Ω = {schön, schlecht}.

P(„schön“) = 0,6, P(„schlecht“) = 0,4.

Wie kommt man auf diese Wahrscheinlichkeiten 0,4 und 0,6? Man hat in diesem Fall etwa die Wetteraufzeichnungen der letzten 100 Jahre ausgewertet und hat festgestellt, dass der Anteil der schönen Tage 60 % betrug. Wir haben hier eine Anwendung der Statistischen Wahrscheinlichkeitsauffassung: Man führt ein Zufallsexperiment sehr oft durch. Mit steigender Zahl der Versuche nähert sich der Anteil der Versuche, die das Ereignis A hervorgebracht haben, der „wahren “ Wahrscheinlichkeit P(A), formal ausgedrückt

mit n(A) als Zahl der Versuche, die das Ereignis A hervorgebracht haben. Man bezeichnet diesen Zusammenhang als Gesetz der großen Zahlen. Er liefert die Begründung, dass man unbekannte Wahrscheinlichkeiten mit Hilfe von empirischen Beobachtungen schätzen kann, wobei hier gilt: Viel hilft viel!

Bei manchen Fragestellungen versagen die beiden obigen Wahrscheinlichkeitskonzepte. Z.B. bei Ereignissen, die sehr selten auftreten, für die man also auch keine Versuchsreihen zur Verfügung hat, etwa die Wahrscheinlichkeit für den Erfolg eines neu auf dem Markt platzierten Produkts. Es möchte beispielsweise ein Unternehmen ein neues Spülmittel auf den Markt bringen. Es steht vor der Alternative, Fernsehwerbung einzusetzen oder nicht. Es ist mit den Ereignissen konfrontiert: Wenn Fernsehwerbung eingesetzt wird, ist das Spülmittel ein Erfolg/kein Erfolg. Wenn keine Fernsehwerbung eingesetzt wird, ist das Spülmittel ein Erfolg/kein Erfolg. Für diese vier Ereignisse sollen Wahrscheinlichkeiten ermittelt werden. Da man keine verlässlichen Informationen darüber hat, wird man aus dem Bauch heraus, eventuell unter Berücksichtigung ähnlicher Erfahrungen bestimmte Wahrscheinlichkeiten zuordnen. Dieses Vorgehen entspricht der Subjektiven Wahrscheinlichkeitsauffassung.

Da Ereignisse als Mengen definiert sind, kann man auch in vielen Fällen Ereignisse und ihre Wahrscheinlichkeiten in Venn-Diagrammen veranschaulichen. Die Wahrscheinlichkeit ist dann die Fläche der entsprechenden Menge. Manchmal ist es hilfreich, das Venn-Diagramm maßstabsgetreu auf kariertes Papier abzutragen, indem die Mengen rechteckig dargestellt werden.

Pizzeria-Beispiel zur Berechnung von Wahrscheinlichkeiten

Jetzt schauen wir uns in der Pizzeria etwas genauer um: Der Inhaber Carlo Pommodore ist ein mitleidiger Mensch und duldet auch arme Gäste, die sich nichts bestellen. Deshalb ist das Lokal mit seinen 50 Gästen eigentlich schon überfüllt. 20 Personen haben sich Pizza bestellt und 10 Lasagne. Das Essen ist so reichlich, dass niemand zwei Mahlzeiten bestellt. 40 Gäste trinken Wein und 20 Gäste trinken Mineralwasser, aber 15 trinken Wasser und Wein.

Wir ziehen zufällig einen Gast aus der fröhlich lärmenden Menge. Wie groß ist die Wahrscheinlichkeit, einen Pizza-Esser zu erhalten?

Wir haben |Ω| = 50 verschiedene Ergebnisse. Man kann davon ausgehen, dass jeder Gast die gleiche Wahrscheinlichkeit hat, gezogen zu werden.

Wir definieren nun die Ereignisse:

- A: Der Gast isst Pizza; B: Der Gast isst Lasagne;

- C: Der Gast trinkt Wein; D: Der Gast trinkt Wasser.

Nach dem Symmetrieprinzip ist

- und

Wir können berechnen:

Wahrscheinlichkeit, dass jemand Wasser und Wein trinkt:

Wahrscheinlichkeit, dass ein zufällig ausgewählter Gast kein Wasser trinkt ():

Anteil der Leute, die Wasser oder Wein trinken:

Diese Beziehung gilt immer für zwei Ereignisse!

Wahrscheinlichkeit, dass ein Gast Pizza oder Lasagne isst:

Die Mengen A und B sind disjunkt.

Wahrscheinlichkeit, dass der zufällig ausgewählte Gast kein Wasser oder keinen Wein trinkt:

Hier ist die direkte Berechnung der Wahrscheinlichkeit analog zu oben umständlich. Man verwendet am besten die

DE MORGANsche Regel:

Was gelernt werden muss

Ein Ereignis A (A ⊂ Ω) :

Zwei Ereignisse A und B (A,B ⊂ Ω) :

A und B sind im allgemeinen nicht disjunkt, also ist die Wahrscheinlichkeit, dass A oder B eintritt, nach dem Additionssatz für zwei Ereignisse:

Falls A und B disjunkt sind, ist

DE MORGANsche Regeln:

und

Für drei Ereignisse Ai (i=1, 2, 3) aus Ω gilt analog zu obigen Überlegungen:

Mehrere Ereignisse Ai (i endlich oder unendlich):

Sind die Ereignisse Ai sämtlich paarweise disjunkt, ist bei ihrer Vereinigung

Übung

Zeigen Sie anhand eines Venn-Diagramms die Gültigkeit einer der DeMorganschen Regeln.

| 1.2. | Gemeinsame Wahrscheinlichkeit mehrerer Ereignisse |

| ||||

|---|---|---|---|---|---|---|

Stochastische Unabhängigkeit

Ein häufiges Untersuchungsobjekt in der Statistik ist, ob verschiedene Ereignisse abhängig oder unabhängig voneinander sind, d.h. ob das Zustandekommen eines Ereignisses durch ein anderes begünstigt wird. So untersucht man beispielsweise in der Marktforschung, ob Status und Bildung eines Konsumenten die Ausgaben für eine bestimmte Zeitschrift beeinflussen.

Beispiel zum Begriff der stochastischen Unabhängigkeit

Eine umfangreiche Marketingstudie über Zahnputzgewohnheiten von Konsumenten hat ergeben, dass 50 % der Studierenden einer kleinen Hochschule bei ihren Eltern wohnen. Ebenso, dass 50 % der Studierenden Zahnpasta mit roten Streifen und 50 % andersfarbige Zahnpasta bevorzugen.

Betrachten wir den Zufallsvorgang: Eine Studentin kommt in einen Laden und kauft Zahnpasta. Es seien folgende Ereignisse definiert:

- E: Die Studentin wohnt bei ihren Eltern.

- R: Die Studentin kauft Zahnpasta mit roten Streifen.

Frage: Hat der Wohnort der Studentin einen Einfluss auf die Farbpräferenz?

Vermutlich nein, die Ereignisse E und R sind stochastisch unabhängig, d.h. in wahrscheinlichkeitstheoretischer Hinsicht unabhängig.

Wir interessieren uns zunächst für den Wohnort der Studierenden. In der Grafik 1 ist die Ergebnismenge nach dem Wohnort aufgeteilt.

Frage: Wieviel Prozent der Studierenden wohnen bei ihren Eltern und werden voraussichtlich Zahnpasta mit roten Streifen kaufen?

Da sich bei Unabhängigkeit der Ereignisse die Studierenden in Bezug auf ihre Farbpräferenz gleichmäßig auf die Wohnorte verteilen, werden wohl 50 % der Rotkäufer bei ihren Eltern wohnen und 50 % woanders. Das heißt 50 % von 50 % der Studierenden wohnen bei ihren Eltern und bevorzugen rote Zahnpasta. Es gilt also:

Die Grafik 2 zeigt, wie sich bei Unabhängigkeit der Variablen Wohnort und Farbpräferenz die Wahrscheinlichkeiten der Farbpräferenz auf die Wohnorte aufteilen.

Ist nun beispielsweise P(E) = 40 % und P(R) = 60 %, ergibt sich bei Unabhängigkeit die Aufteilung wie in der Grafik 3, denn auch hier müssten 60 % der „Nesthocker” und 60 % der „Nestflüchter” gleichermaßen Zahnpasta mit roten Streifen kaufen.

|

|

Beispiel zum Begriff der stochastischen Abhängigkeit

Oben haben wir den Fall betrachtet, dass zwei Ereignisse unabhängig sind. Im Allgemeinen muss man aber davon ausgehen, dass Ereignisse, die man gemeinsam analysiert, abhängig sind.

Im Rahmen der Marketingstudie wurden Daten eines Gesundheitsamtes in Musterstadt verwendet, die die Zahngesundheit von Schulkindern betraf. Man weiß aus dieser Studie, dass 50 % der Schulkinder Karies haben und 50 % der Schulkinder sich regelmäßig die Zähne putzen.

Wir betrachten den Zufallsvorgang: Es wird ein Schulkind zufällig ausgewählt.

Wir definieren als Ereignisse

- Z: Das Schulkind putzt sich regelmäßig die Zähne.

- K: Das Schulkind hat Karies.

Ist nun

Ist also die Wahrscheinlichkeit, ein Kind zu erhalten, das sich regelmäßig die Zähne putzt und Karies hat, größer als die Wahrscheinlichkeit, ein Kind zu erhalten, das sich regelmäßig die Zähne putzt und keine Karies hat, oder ist es umgekehrt, oder sind vielleicht die Wahrscheinlichkeiten gleich?

Es ist vermutlich

denn Zähneputzen und Karies sind bekanntlich nicht unabhängig voneinander zu betrachten. Also sind Z und K stochastisch abhängige Ereignisse. Wir werden vermutlich eine Aufteilung der gemeinsamen Wahrscheinlichkeiten erhalten, die ähnlich der Grafik 4 ist. Besonders groß sind P(Z ∩ K) und P(Z ∩ K).

Die gemeinsamen Wahrscheinlichkeiten können allerdings nicht mit unseren Informationen bestimmt werden, sie hängen von der Stärke der Abhängigkeit ab.

Bei stochastisch abhängigen Ereignissen interessiert man sich häufig für das bedingte Auftreten eines Ereignisses, z.B. für die bedingte Wahrscheinlichkeit

dass ein zufällig ausgewähltes Schulkind Karies hat, wenn man weiß, dass es sich nicht regelmäßig die Zähne putzt.

Bedingte Wahrscheinlichkeiten

Beispiel

Einige Jahre später wurde in der Grundschule von Musterdorf zu Forschungszwecken wieder an 200 Kindern eine Reihenuntersuchung zur Zahngesundheit durchgeführt. Jetzt putzten sich 60 % der Kinder regelmäßig die Zähne. Von diesen Kindern hatten 40 Karies. Bei den Zahnputzmuffeln hatten 60 Kinder Karies.

Wir wollen ein maßstabsgetreues Venndiagramm konstruieren. Jedes Kästchen steht für 5 Kinder. Es sind

Wir interessieren uns nun für die bedingte Wahrscheinlichkeit, dass ein Kind Karies hat, wenn bekannt ist, dass es sich die Zähne putzt:

In andere Worte gekleidet: Der Anteil der Kinder mit Karies an den Kindern, die sich regelmäßig die Zähne putzen.

Es gilt für die bedingte Wahrscheinlichkeit

Wie ist diese Wahrscheinlichkeit zu verstehen?

Es werden zunächst alle Kinder, die sich regelmäßig die Zähne putzen, in die Aula geschickt. Aus diesen 120 Kindern wird nun zufällig eins ausgewählt. Mit welcher Wahrscheinlichkeit hat dieses Kind Karies? Wir betrachten also 120 zahnputzende Kinder, davon haben 40 Kinder Karies.

Genau diese Vorgehensweise ist das Prinzip der bedingten Wahrscheinlichkeiten!

Es ergibt sich:

Ein Drittel der zähneputzenden Kinder hat Karies: Dann haben natürlich zwei Drittel der zähneputzenden Kinder keine Karies. Wir sehen sogleich, dass die obige Rechnung die schon bekannte Formel

darstellt. Entsprechend erhalten wir

Vergleichen Sie das Venndiagramm mit dem vorhergehenden! Wieso unterscheiden sich beide Diagramme?

Übung

Es ist bekannt, dass die Aktienkurse des Unternehmens Dachs an 55% aller Börsentage gestiegen sind.

Ereignisse: K1: Der Kurs steigt am ersten Tag K2: Der Kurs steigt am zweiten Tag

Man hat folgende Gesetzmäßigkeit der Kursentwicklung festgestellt: In 40 % aller Beobachtungen stieg der Kurs am ersten Tag und am zweiten Tag, in 15 % der Beobachtungen stieg der Kurs am ersten Tag und fiel am zweiten Tag. Dagegen fiel in 15 % der Beobachtungen der Kurs am ersten Tag und stieg am zweiten Tag. An den restlichen Tagespaaren fiel der Kurs an beiden Tagen.

- Stellen Sie die gemeinsamen Wahrscheinlichkeiten im Venndiagramm grafisch dar.

- Sind die Ereignisse K1 und K2 stochastisch unabhängig? (Begründen Sie die Antwort formal mit Hilfe der Wahrscheinlichkeitstheorie.)

- Am heutigen Tag ist der Kurs gestiegen.

- Mit welcher Wahrscheinlichkeit wird er morgen steigen (Gesucht: P(K2|K1))?

- Mit welcher Wahrscheinlichkeit wird er dagegen fallen?

- Mit welcher Wahrscheinlichkeit wird der Kurs morgen steigen, wenn er heute gefallen ist?

Bayessches Theorem

Häufig liegen die Informationen über zwei Ereignisse nur als bedingte Wahrscheinlichkeiten vor. Wie kann man sie weiter verwenden?

Beispiel für zwei Ereignisse

Ein bekannter Vergnügungspark verbraucht täglich große Mengen an Glühbirnen für die Dekoration der Stände. Damit die Verbrauchskosten nicht so hoch werden, setzen sich die Glühbirnen nur zu 60% aus Markenware und zu 40 % aus markenfreier Ware zusammen. Aufgrund langjähriger Beobachtungen weiß man, dass von den Marken-Glühbirnen pro Monat 5% defekt werden. Jedoch werden von den markenfreien Glühbirnen monatlich 10% defekt.

Zunächst wollen wir das Gegebene grafisch (Grafik 5) darstellen: Wenn von den Markenglühbirnen 5 % defekt werden, bleiben 95% heil. 5% ist also Anteil der defekten Glühbirnen an den Markenglühbirnen, d.h. es handelt sich um die bedingte Wahrscheinlichkeit P(D|M) usw.

Der Betreiber des Vergnügungsparks braucht für die Kostenplanung des nächsten Sommers die Information, wie groß der Anteil der Markenglühbirnen an den defekten Glühbirnen ist, d.h. er sucht P(M|D). Das bedeutet: Alle defekten Glühbirnen eines Tages werden in einem Korb gesammelt. Es wird eine Glühbirne zufällig entnommen. Mit welcher Wahrscheinlichkeit erhält man eine Markenbirne?

Wir wissen, dass gilt:

- .

Leider sind aber die Komponenten des Bruchs unbekannt. Wir werden nun eine Methode finden, sie doch zu berechnen.

Zunächst suchen wir den Zähler P(M ∩ D): Wir kennen P(D|M). Bekanntlicherweise berechnet es sich als

- .

Also ist der gesuchte Zähler auch in P(D|M) enthalten und kann ganz einfach durch Auflösung der Gleichung berechnet werden als

- .

also

- .

Jetzt fehlt noch der Nenner P(D). Betrachten wir das Venndiagramm Grafik 6. D setzt sich aus den Schnittmengen und zusammen.

Die gesamte Wahrscheinlichkeit von D ist also die Summe

- .

eine Erkenntnis, die man auch als Satz der totalen Wahrscheinlichkeit bezeichnet, und das gibt, wie wir oben gesehen haben,

- ,

in unserem Beispiel

- .

Es sind also 7% aller Glühbirnen defekt.

Die gesuchte bedingte Wahrscheinlichkeit ist nun

- ,

Diese Formel wird als Bayessches Theorem bezeichnet.

Die gesuchte Wahrscheinlichkeit beträgt

- .

Diese Wahrscheinlichkeit fällt deshalb so überraschend hoch aus, weil 50% mehr Markenbirnen als markenfreie verwendet werden. Entsprechend ist der Anteil der markenfreien Glühbirnen an den defekten 0,5714.

Wir wollen nun mehr als zwei Ereignisse analysieren.

Beispiel für mehr als zwei Ereignisse

Eine Spedition beschäftigt drei LKW-Fahrer, die Herren Ahorn, Behorn und Zehorn. Ahorn fährt 50% aller Fuhren, Behorn 20% und Zehorn 30%. Aus Erfahrung weiß man, dass Ahorn bei 10% aller Fahrten eine Beule verursacht, Behorn bei 15% aller Fahrten und Zehorn bei 20% aller Fahrten (Grafik 7).

Wir definieren die Ereignisse:

- F1: Ahorn ist gefahren, F2: Behorn ..., F3: Zehorn ...

- B: Eine Beule wurde gefahren.

Wir wollen zuerst das Gegebene festhalten: Wenn Ahorn in 10 % aller Fahrten eine Beule fährt, wickelt er die restlichen 90 % ohne Schaden ab usw.

Man interessiert sich für die Wahrscheinlichkeit, dass Ahorn gefahren ist, wenn wieder ein Mal eine Beule in einem LKW auftaucht, d.h. für P(F1|B).

Es ist wieder

- .

Nach dem Multiplikationssatz der Wahrscheinlichkeiten muss

sein, also

- .

Aber wie erhalten wir P(B)? Auch hier gilt wieder der Satz von der totalen Wahrscheinlichkeit, z.B.:

- .

Wir erhalten dann für P(B)

-

- ,

also

- .

Unsere gesuchte Wahrscheinlichkeit beträgt

- .

Entsprechend sind

und

- .

Also hat Zehorn mit größter Wahrscheinlichkeit die Beule gefahren.

Wir fassen nun das Gelernte dieser Seite zusammen:

Theoretische Erkenntnisse

Zwei Ereignisse A und B aus Ω:

Sind zwei Ereignisse A und B stochastisch unabhängig, ist ihre gemeinsame Wahrscheinlichkeit gleich dem Produkt der Einzelwahrscheinlichkeiten:

Man beachte: Ereignisse sind grundsätzlich nicht als unabhängig zu betrachten!

Die bedingten Wahrscheinlichkeiten für A und B sind

Allgemeiner Multiplikationssatz der Wahrscheinlichkeiten:

- .

Theorem von BAYES:

- .

Verallgemeinerung für m Ereignisse Ai (i =1,...,m):

Diese m Ereignisse zerlegen die Ergebnismenge, d.h. sie sind disjunkt und füllen Ω aus. Enthält Ω noch ein Ereignis B, so schneidet B mindestens ein Ereignis Ai, und B ist dann

- .

Es gilt hier das Bayessche Theorem:

- .

Übung:

- Was ist P(A|B), falls A und B disjunkt sind?

- Was ist P(A|B), falls A und B stochastisch unabhängig sind?

Lösungen der Übungen

Beispiel mit den Kursverläufen

1. Darstellung der verschiedenen Wahrscheinlichkeiten

| aus Summe der Zeile |

|

|

| aus Summe der Zeile |

|

|

2. Bei stochastischer Unabhängigkeit müsste die gemeinsame Wahrscheinlichkeit gleich dem Produkt der Einzelwahrscheinlichkeiten sein.

- ,

aber

- .

Also sind die Ereignisse stochastisch abhängig.

3. Es ist

und

4.

Übungen zu Theoretische Erkenntnisse

Lösung: 0; P(A).

| 1.3. | Kombinierte Zufallsvorgänge |

| ||||

|---|---|---|---|---|---|---|

Kombinierte Zufallsvorgänge (insbesondere wiederholte oder mehrfache Versuche).

Allgemeines

Beispiele für kombinierte Zufallsvorgänge:

- Eine Münze werfen, dann einmal würfeln.

- Aus einer Urne ohne Zurücklegen 3 Kugeln ziehen.

- Aus einer Lostrommel 10 Gewinner ziehen.

- Gewinnspiel: Aus drei Toren eines wählen. Falls richtiges Tor, Wahl zwischen zwei Umschlägen.

- 5x auf ein Ziel schießen.

Beispiel für die formale Definition

Es sollen nacheinander drei Zufallsexperimente durchgeführt werden. Die Wahrscheinlichkeit, dass beim ersten Versuch das Ereignis A, beim zweiten Versuch das Ereignis B und beim dritten Versuch das Ereignis C resultiert, wird bezeichnet als P(A(1) ∧ B(2) ∧ C(3)). A, B und C können verschiedenen Ergebnismengen entstammen! Der hochgestellte Index kann unter Umständen weggelassen werden.

Beispiel für unabhängige Versuche

Wir betrachten den Zufallsvorgang: Wir werfen zuerst eine Münze und würfeln dann.

Die beiden Versuche haben jeweils die Ergebnismenge

- ΩM = {Wappen (W); Zahl (Z)} bzw. ΩW = {1,2,3,4,5,6}

Es ergibt sich für diesen kombinierten Versuch die Ergebnismenge Ω* als kartesisches Produkt von ΩM und ΩW :

- Ω* = {(W; 1), (W; 2), (W; 3), ... , (W; 6), (Z; 1), (Z; 2), ..., (Z; 6)}.

Ω* hat 12 Elemente. Jedes Element hat dieselbe Wahrscheinlichkeit, gezogen zu werden.

Wir suchen nun die Wahrscheinlichkeit für das Ereignis A*: Es wird erst Wappen geworfen und dann mindestens Fünf (F) gewürfelt:

Das Ereignis A* = W(1) ∧ F(2) belegt in Ω* 2 Elemente. Wir erhalten dann für die Wahrscheinlichkeit nach dem Symmetrieprinzip

Würfeln und Münzwurf sind jedoch stochastisch unabhängig und die Wahrscheinlichkeit muss nicht umständlich über die Ergebnismenge ermittelt werden. Also ist dann

Übung

Sie würfeln 3 mal. Mit welcher Wahrscheinlichkeit erhalten Sie zuerst zwei mal Sechs und dann höchstens Zwei?

Lösung: .

Wiederholte Versuche können aber oft stochastisch abhängig sein.

Aus einer Urne mit 2 roten und 1 schwarzen Kugeln sollen zwei Kugeln ohne Zurücklegen gezogen werden.

Das zweite Ergebnis ist vom ersten natürlich nicht mehr unabhängig, weil sich je nach erster gezogener Kugel der Inhalt der Urne ändert. Es sei: R: eine rote Kugel wird gezogen und S: eine schwarze Kugel wird gezogen.

Wir wollen zuerst die Ergebnismenge der abhängigen Versuche analysieren. Nummerieren wir die beiden roten Kugeln in R1 und R2. Man kann dann bei zwei mal ziehen folgende Ergebnisse erhalten:

- Ω* = {(R1; R2), (R1; S), (R2; R1), (R2; S), (S; R1), (S; R2)}

Ω* hat insgesamt 6 Ergebnisse.

Wir definieren das Ereignis A: Zuerst wird eine rote (R), dann eine schwarze Kugel (S) gezogen, also A = R(1) ∧ S(2).

Es gibt in Ω* zwei Ergebnisse, die A betreffen, also ist die Wahrscheinlichkeit

Dieses Beispiel war einfach. Aber kann jetzt bei abhängigen Versuchen auch die Wahrscheinlichkeit für das kombinierte Ereignis unter Verzicht auf die vollständige Darstellung der Ergebnismenge bestimmt werden?

Bei stochastisch abhängigen Versuchen können die Wahrscheinlichkeiten nicht mehr ohne weiteres als Produkt der Einzelwahrscheinlichkeiten der Ereignisse bestimmt werden. Man kann aber sukzessiv den Multiplikationssatz der Ereignisse anwenden, der von den bedingten Wahrscheinlichkeiten bekannt ist: P(A∩B) = P(A)·P(B|A). Die Wahrscheinlichkeit, dass beim ersten Mal A und beim zweiten Mal B resultiert, ist also

Es ist nach der obigen Formel

| Beim ersten Versuch sind 3 Kugeln in der Urne; zwei sind rot | Beim zweiten Versuch sind noch 2 Kugeln in der Urne; eine ist schwarz. |

Diese Regel lässt sich auch auf mehr als zwei Ereignisse erweitern:

Beispiel

Aus einer Urne mit 10 roten (R) und 5 schwarzen (S) Kugeln sollen ohne Zurücklegen nacheinander drei rote Kugeln gezogen werden. Die Wahrscheinlichkeit dafür ist

Für mehr als zwei Ereignisse kann der allgemeine Multiplikationssatz der Wahrscheinlichkeiten angewendet werden. Er gilt auch für Ereignisse, die nicht aus einer gemeinsamen Ergebnismenge stammen:

Falls die A(i) (i = 1, 2, ... ,m) stochastisch unabhängig sind, ist natürlich wieder

- .

Je nachdem, wie die Problemstellung ist, gibt es für die Berechnung von Wahrscheinlichkeiten kombinierter Zufallsvorgänge also verschiedene Möglichkeiten:

- Wir bestimmen alle Elemente von Ω*, falls das möglich und durchführbar ist. Dann wenden wir das Symmetrieprinzip an.

- Wir überlegen uns, beispielweise mit Hilfe der Kombinatorik, die Zahl der Elemente in Ω* und wenden dann das Symmetrieprinzip an.

- Wir verwenden den allgemeinen Multiplikationssatz der Wahrscheinlichkeiten und können vielleicht sogar stochastische Unabhängigkeiten ausnützen.

Urnenmodelle

Bei wiederholten Versuchen greift man häufig auf das so genannte Urnenmodell zurück: Dieses Modell funktioniert im Prinzip folgendermaßen: Eine Urne enthält N viele Kugeln, die sich voneinander unterscheiden lassen. Es werden n viele Kugeln gezogen. Man interessiert sich für die Zahl von Kugeln mit einem bestimmten Merkmal unter den n gezogenen.

Wir unterscheiden grundsätzlich

- das Urnenmodell mit Zurücklegen: Eine Kugel wird gezogen und wieder zurückgelegt

- das Urnenmodell ohne Zurücklegen: Eine Kugel wird gezogen und nicht wieder zurückgelegt

Viele Zufallsvorgänge, speziell die wiederholter Versuche, können auf das Urnenmodell zurückgeführt werden. Den Anfänger mag die Vorstellung, eine Kugel zu ziehen und wieder zurückzulegen, eigenartig anmuten, aber so kann man unabhängige Versuche modellieren: Betrachten wir den Zufallsvorgang, zwei mal zu würfeln, so kann man stattdessen auch aus einer Urne mit 6 verschiedenen Kugeln zwei mal jeweils eine ziehen und wieder zurücklegen.

Kombinatorik

Wir haben eine Urne mit N Kugeln gegeben. Es sollen n Kugeln gezogen werden. Wir befassen uns nun mit der Zahl der möglichen Ergebnisse bei wiederholten Versuchen. Hier müssen wir die verschiedenen Arten der Anordnung gezogener Kugeln im Urnenmodell berücksichtigen.

Zur Verdeutlichung dieser Aufgabenstellung betrachten wir eine Urne mit 3 Kugeln A, B, C. Es sollen n = 2 Kugeln gezogen werden. Wie viel verschiedene Paare würden wir erhalten?

Wir unterscheiden die Aufgabenstellungen

Mit Wiederholung - Mit Berücksichtigung der Reihenfolge

Die Buchstaben werden mit Zurücklegen gezogen; ein Buchstabe kann also mehrmals im Paar auftauchen. Es kommt auf die Reihenfolge der Buchstaben an. Es sind folgende verschiedene Paare möglich:

- (A,A), (A,B), (A,C), (B,A), (B,B), (B,C), (C,A), (C,B), (C,C).

Es gibt insgesamt viele verschiedene Ergebnisse, wie man leicht sieht.

Mit Wiederholung - Ohne Berücksichtigung der Reihenfolge

Es sind folgende verschiedene Paare möglich:

- (A,A), (A,B), (A,C), (B,B), (B,C), (C,C).

Es gibt insgesamt viele verschiedene Ergebnisse.

Ohne Wiederholung - Mit Berücksichtigung der Reihenfolge

Die Buchstaben werden ohne Zurücklegen gezogen; ein Buchstabe kann nur einmal im Paar auftauchen. Es sind folgende verschiedene Paare möglich:

- (A,B), (A,C), (B,A), (B,C), (C,A), (C,B).

Es gibt insgesamt viele verschiedene Ergebnisse.

Ohne Wiederholung - Ohne Berücksichtigung der Reihenfolge

Es sind folgende verschiedene Paare möglich:

- (A,B), (A,C), (B,C).

Es gibt insgesamt viele verschiedene Ergebnisse.

Übungsbeispiel

Aus vier Personen Anna (A), Balduin (B), Cäcilie (C), Dagobert (D) werden zwei zum Geschirrspülen ausgelost, wobei eine Person abspült und eine abtrocknet.

Handelt es sich um ein Modell mit oder ohne Zurücklegen? Theoretisch wäre auch ein Modell mit Zurücklegen denkbar. Da das aber als unfair empfunden wird, gehen wir vom Modell ohne Zurücklegen (M. o. Z.) aus.

- Mit welcher Wahrscheinlichkeit erwischt es zuerst Cäcilie und dann Balduin (Ereignis E)?

Hier kommt es auf die Reihenfolge der gezogenen „Kugeln“ an.

Methode a: Direkt über die Ergebnismenge

Die Ergebnismenge ergibt Ω* =

|

- |

(A,B) |

(A,C) |

(A,D) |

|

(B,A) |

- |

(B,C) |

(B,D) |

|

(C,A) |

(C,B) |

- |

(C,D) |

|

(D,A) |

(D,B) |

(D,C) |

- |

Jedes Paar hat die gleiche Wahrscheinlichkeit, gewählt zu werden. Es gibt insgesamt |Ω*| = 12 verschiedene Paare.

Methode b: Über die Zahl der Ergebnisse

- Es handelt sich um ein Modell ohne Zurücklegen mit Beachtung der Reihenfolge. Es gibt

verschiedene Paare. Es gibt nur ein Ergebnis für das Ereignis E. Es ist also

Methode c: Über den Multiplikationssatz der Wahrscheinlichkeiten

- Mit welcher Wahrscheinlichkeit müssen die zwei Männer abwaschen (Ereignis F)?

Methode a:

Es ist F = {(B,D), (D,B)}. Dieses Ereignis belegt in Ω* zwei Elemente. Also ist

Methode b:

M.o.Z, ohne Beachtung der Reihenfolge. Es gibt

verschiedene Paare . Es ist also

Methode c:

- .

| 2. | Zufallsvariablen |

| ||||

|---|---|---|---|---|---|---|

Beispiel zum Begriff der Zufallsvariablen

Die fränkische Druckerei Printzig nennt 10 multifunktionelle Hochleistungsdrucker ihr Eigen. Drei Drucker sind von der Firma Alpha, zwei sind von Beta, vier von Gamma und einer stammt von der Firma Delta. Da die Drucker auch von Kunden bedient werden, fallen sie aufgrund unsachgemäßer Handhabung häufig aus. Man hat festgestellt, dass alle Drucker in gleichem Maße anfällig sind. Wegen der Gewährleistung wird bei jedem Ausfall ein Wartungstechniker der betreffenden Firma geholt. Die Kosten für die Wiederherstellung eines Druckers hängen vom Hersteller ab, wobei die Drucker der Firma Gamma in der Reparatur am billigsten sind.

Am liebsten ist es natürlich Herrn Printzig, wenn ein Drucker mit den geringsten Reparaturkosten ausfällt.

Überlegen wir:

- Welche Ergebnismenge gehört zu dem Zufallsvorgang: Ein Drucker fällt zufällig aus?

- Mit welcher Wahrscheinlichkeit entstehen Herrn Printzig die geringsten Kosten?

Wir erhalten die Ergebnismenge

- Ω = {A1, A2, A3, B1, B2, G1, G2, G3, G4, D1},

wobei z.B. B2 Drucker Nr. 2 der Firma Beta bedeutet. G sei das Ereignis, die geringsten Reparaturkosten zu haben. Jeder Drucker hat die gleiche Wahrscheinlichkeit, auszufallen. Dann ist nach dem Symmetrieprinzip

Die Kosten für die Reparatur eines Druckers betragen je nach Hersteller wie folgt:

| Hersteller | Alpha | Beta | Gamma | Delta |

| Kosten (Euro) | 50 | 60 | 30 | 100 |

Überlegen wir: Wieviel muss Herr Printzig pro Ausfall im Durchschnitt bezahlen?

Ordnen wir nun der Ergebnismenge die entsprechenden Kosten zu:

| A1 | A2 | A3 | B1 | B2 | G1 | G2 | G3 | G4 | D1 |

| 50 | 50 | 50 | 60 | 60 | 30 | 30 | 30 | 30 | 100 |

Ω hat 10 Ergebnisse und jedes Elementarereignis hat die Wahrscheinlichkeit 1/10. Jeder Drucker fällt dann auch mit der Wahrscheinlichkeit 1/10 aus. Die durchschnittlichen Reparaturkosten sind also

Wir haben soeben eine Zufallsvariable konstruiert und zwar, indem wir allen Ergebnissen von Ω eine Zahl zugeordnet haben.

Den Durchschnitt konnten wir erst berechnen, nachdem wir die Drucker mit einer Zahl versehen hatten. Man kann je nach Interesse den Elementarereignissen beliebige Zahlen zuordnen. So könnten für die laufende Wartung wieder ganz andere Kosten gelten. Nur die Ergebnismenge ist festgelegt. Man könnte nun die Wahrscheinlichkeit berechnen, dass bei einem Ausfall 60 Euro fällig werden: Es gibt 10 Elementarereignisse und zwei davon entsprechen 60 Euro. Also beträgt diese Wahrscheinlichkeit 2/10.

Wir bezeichnen eine Zufallsvariable mit einem großen Buchstaben. Die Werte, die eine Zufallsvariable annehmen kann, nennt man Ausprägung. Eine bestimmte Ausprägung kennzeichnen wir mit einem Kleinbuchstaben. Nennen wir unsere Zufallsvariable „Reparaturkosten“ X. Wir fassen jetzt die verschiedenen Wahrscheinlichkeiten der Zufallsvariablen X in einer Wahrscheinlichkeitstabelle zusammen. Herr Printzig hat 4 mal die „Chance“, 30 Euro zu bezahlen, also ist die Wahrscheinlichkeit, dass X = 30 ist, gleich 4/10, usw.

Wahrscheinlichkeitstabelle:

| x1 | x2 | x3 | x4 | |

|---|---|---|---|---|

| Ausprägung xi | 30 | 50 | 60 | 100 |

| Wahrscheinlichkeit f(xi) | 0,4 | 0,3 | 0,2 | 0,1 |

f(x) bezeichnet die zur bestimmten Ausprägung x gehörende Wahrscheinlichkeit. Es ist beispielsweise

- P(X = 60) = f(x3) = f(60) = 0,2,

aber

- P(X = 70) = f(70) = 0,

denn für X = 70 existiert kein Ergebnis.

Die Summe aller Wahrscheinlichkeiten ist

Man kann diese Wahrscheinlichkeiten auch grafisch als Stabdiagramm darstellen.

Man sieht, dass an den x-Stellen 30, 50, 60 und 100 die Wahrscheinlichkeitsfunktion die Werte 0,4, 0,3, 0,2 und 0,1 annimmt, aber an allen sonstigen Werten von x Null ist.

Wie groß ist nun aber die Wahrscheinlichkeit, dass Herr Printzig höchstens 50 Euro bezahlen muss?

- P(X ≤ 50) = P(X = 30) + P(X = 50) = 0,4 + 0,3 = 0,7.

Das kann man auch aus der Graphik ersehen: Es ist die Summe der „Stäbchen“ für x ≤ 50.

Mit welcher Wahrscheinlichkeit muss Herr Printzig weniger als 100 Euro zahlen? Gefragt ist hier nach P(X < 100). Ein Blick auf die Grafik verrät uns, dass gilt

- P(X < 100) = P(X ≤ 60) = P(X = 30) + P(X = 50) + P(X = 60) = 0,4 + 0,3 + 0,2 = 0,9.

Wieviel ist nun P(30 < X ≤ 60)?

Man kann hier wieder die „Stäbchenmethode“ anwenden:

- P(30 < X ≤ 60) = 0,3 + 0,2 = 0,5.

Es gibt aber auch eine Rechenregel, die man mit Hilfe der Grafik leicht erkennt:

- P(a < X ≤ b) = P(X ≤ b) - P(X ≤ a),

also

- P(30 < X ≤ 60) = P(X ≤ 60) - P(X ≤ 30) = 0,9 - 0,4 = 0,5.

Die Wahrscheinlichkeiten P(X ≤ a) einer bestimmten Ausprägung a von X bilden die Verteilungsfunktion von X, die die Wahrscheinlichkeitsverteilung von X in eindeutiger Weise beschreibt. Das ist eine Festlegung, die die Statistiker als sinnvoll erachten. Die Verteilungsfunktionen werden grossbuchstabig als F(a) bezeichnet. Meist wird statt a das Symbol x verwendet. Wir wollen die Verteilungsfunktion konstruieren, indem wir die obige Graphik zu Hilfe nehmen und für einzelne Stützwerte x die Verteilungsfunktion berechnen.

Wie groß ist z.B. P(X ≤ 10)? Es ist P(X ≤ 10) = F(10) = 0.

Ebenso sind P(X ≤ 15) = 0 und P(X ≤ 20) = 0.

Es ist also F(a) = 0 für alle Werte von a mit - ∞ < a < 30.

Als nächstes untersuchen wir P(X ≤ 30):

P(X ≤ 30) = F(30) = 0,4 . Ebenso sind P(X ≤ 30,1) = 0,4 und P(X ≤ 49,99999) = 0,4.

Die Verteilungsfunktion hat also den Wert F(a) = 0,4 für 30 ≤ a < 50.

Es gilt weiter: P(X ≤ 50), P(X ≤ 59), ... P(X< 60) sind, siehe Graphik: 0,4 + 0,3 = 0,7.

...

Schließlich ist die Wahrscheinlichkeit P(X ≤ 100) oder auch P(X ≤ 110), P(X ≤ 1000) usw... gleich 1.

Wir können die Wahrscheinlichkeiten zusammenfassen in der Verteilungsfunktion

Man sieht, dass diese Verteilungsfunktion grafisch eine Treppenfunktion darstellt. Die Punkte links an den Stufen zeigen an, dass der Funktionswert dieser Stufe genau zum Punkt a gehört.

Man kann hier auch die Wahrscheinlichkeiten der Grafik entnehmen, z.B. ist P(X ≤ 70) = 0,9.

Besonders interessiert man sich bei einer Zufallsvariable für zwei Kennwerte, Parameter genannt, die die Zufallsvariable genauer beschreiben.

Einer ist der durchschnittliche Wert, den die Zufallsvariable „auf lange Sicht“ annimmt, wenn der Zufallsvorgang „sehr oft“ durchgeführt wird. Dieser Parameter wird Erwartungswert EX genannt, also der Wert, den man langfristig erwarten kann. Wir hatten ihn schon oben ermittelt als

die durchschnittlichen Reparaturkosten.

Ein weiterer Parameter ist die Streuung der X, ein Maß, wie stark die einzelnen Werte von X von EX abweichen, also 30-49, 50-49, 60-49, 100-49. Da z.B. 100 viel seltener auftritt als 30, gewichtet man auch diese Abweichungen mit ihrer Wahrscheinlichkeit. Eine Quadrierung sorgt dann einerseits dafür, dass sich positive und negative Abweichungen nicht aufheben, andererseits für eine überproportionale Berücksichtigung von besonders starken Abweichungen. Man erhält im Ergebnis als durchschnittliche quadratische Abweichung der X-Werte von EX die Varianz

wobei zu beachten ist, dass sich hier als Einheit Euro2 ergibt.

Die Wurzel der Varianz ist die Standardabweichung; man könnte sie salopp als mittlere Abweichung der Ausprägungen vom Durchschnitt bezeichnen. Sie beträgt in unserem Beispiel etwa 20,71.

Allgemeine Darstellung einer Zufallsvariablen

Gegeben ist ein Zufallsvorgang mit der Ergebnismenge Ω. Jedem Element aus Ω wird eine reelle Zahl x zugeordnet:

- .

Die Elemente von X sind Realisationen, Ausprägungen, Werte. Die Verteilung der Zufallsvariablen kann festgelegt werden mit ihrer Verteilungsfunktion F, definiert als

- .

Es gilt für die Verteilung jeder Zufallsvariablen:

- F(x) ist für alle x ∈ definiert.

- 0 ≤ F(x) ≤ 1 .

- F(x) ist monoton steigend, also x1 < x2 → F(x1) ≤ F(x2)

- F(x) ist rechtsseitig stetig.

- P(a < X ≤ b) = P(X ≤ b) - P(X ≤ a) = F(b) - F(a).

| 2.1. | Diskrete Zufallsvariablen |

| ||||

|---|---|---|---|---|---|---|

Eine Zufallsvariable ist diskret, wenn sie in fast jedem beschränkten Intervall der reellen Zahlen nur endlich viele Ausprägungen annehmen kann. Die diskrete Zufallsvariable kann endlich oder abzählbar unendlich viele Werte xi ( i = 1,2,..., m bzw. i = 1,2,... ) annehmen.

Beispiele

- Zahl der Schadensleistungen, die in einem Jahr bei einer Versicherung auftreten

- Kinderzahl von Konsumenten

- Zahl der defekten Kondensatoren in einem Fertigungslos

Ihre Wahrscheinlichkeitsfunktion ist

Es gilt

Die Verteilungsfunktion P(X ≤ a) = F(a) ist die Summe aller Wahrscheinlichkeiten f(xi) für xi ≤ a.

Der Erwartungswert einer Zufallsvariablen ist der Durchschnitt des Auftretens ihrer Realisationen. Bei einer diskreten Zufallsvariablen beträgt er

falls EX existiert, d.h. nicht unendlich wird.

Die Varianz einer diskreten Zufallsvariablen berechnet sich als

Nach dem sog.Verschiebungssatz ist auch

im Beispiel:

| 2.2. | Stetige Zufallsvariablen |

| ||||

|---|---|---|---|---|---|---|

Beispiel eines Zeitungskiosks

Dichtefunktion

Die Zufallsvariable X: „An einem Tag verkaufte Menge an Tageszeitungen (in 100) eines Zeitungskiosks“ lässt sich beschreiben mit der (in diesem Fall frei erfundenen) Dichtefunktion

Diese Zufallsvariable X ist nun stetig, d.h. sie hat in jedem Intervall a ≤ X ≤ b unendlich viele Ausprägungen.

Eine Analyse der Grafik zeigt, dass diese Dichtefunktion symmetrisch bezüglich 8 ist, was die Berechnung von Wahrscheinlichkeiten sehr erleichtert.

Wir wollen nun die Wahrscheinlichkeit bestimmen, dass an einem Tag höchstens 700 Zeitungen verkauft werden, also P(X ≤ 7). Wenn wir analog zu der diskreten Zufallsvariablen vorgehen, wo wir „die Summe der Stäbchen“ ermittelten, müsste die Wahrscheinlichkeit P(X ≤ a) hier „unendlich viele Stäbchen“, also eine Fläche ergeben.

Wir berechnen die Dreiecksfläche mit Hilfe der Geometrie:

Es ist übrigens auch

denn bei einer stetigen Zufallsvariablen ist P(X = x) = 0, da es als unmöglich angesehen wird, genau einen bestimmten Wert x zu „treffen“. Man betrachtet also bei einer stetigen Zufallsvariablen nur Wahrscheinlichkeiten der Art P(X ≤ x) o.ä.

Es ist P(X ≤ 8) = 0,5, wie man der Grafik sofort entnimmt.

denn wie man sieht, ist die Fläche von P(X ≥ 9) genau gleich der Fläche P(X ≤ 7).

Außerdem ist

Bestimmen wir die Wahrscheinlichkeit eines Intervalls. Es ergibt

P(8 < X ≤ 9) = P(X ≤ 9) - P(X ≤ 8) = 0,875 - 0,5 = 0,375,

wenn man die Rechenregel für P(a < X ≤ b) anwendet.

|

|

Verteilungsfunktion

Man kann Wahrscheinlichkeiten von X auch als Verteilungsfunktion darstellen. Sucht man die Wahrscheinlichkeit P(X ≤ a), muss also das Integral von -∞ bis a berechnet werden:

Bei unserem Beispiel sind wir mit verschiedenen Bereichen konfrontiert:

1. a < 6

2. 6 ≤ a ≤ 8

3. 8 < a ≤ 10

4. a > 10

Wir erhalten beispielsweise durch Einsetzen in F(x)

Quantil

Das Quantil x(p) gibt die Ausprägung x an, die zu einem bestimmten Verteilungswert p = F(x) gehört. Es handelt sich beim Quantil x(p) also gerade um die Umkehrfunktion der Verteilungsfunktion F(x).

Beispiele

x(0,875) = 9, d.h. zur Wahrscheinlichkeit 0,875 gehört der x-Wert 9.

Ebenso ist x(0,5) = 8. D.h. 8 ist der Median, also wurden an 50% aller Tage höchstens 800 Zeitungen verkauft.

Übung

Bestimmen Sie P(6,25 < X < 8,75). Mit welcher Wahrscheinlichkeit wurden an den 50% besten Tagen mindestens 900 Zeitungen verkauft? Gesucht ist hier P(X > 9| X > 8).

Was Sie speziell über stetige Zufallsvariablen wissen sollten

Eine stetige Zufallsvariable kann in jedem beschränkten Intervall unendlich viele Ausprägungen annehmen. Ihre Verteilung lässt sich durch eine Dichtefunktion f(x) beschreiben. f(x) ist keine Wahrscheinlichkeit, sondern eine Dichte.

- Die Verteilungsfunktion ist

- Es gilt: P(X = a) = 0.

- Wegen P(X = a) = 0 ist P(X ≤ a) = P(X < a) und P(X > a) = P(X ≥ a)

- Die Dichtefunktion f(x) ist die erste Ableitung der Verteilungsfunktion, falls diese an der Stelle x differenzierbar ist.

- Die Dichtefunktion f(a) kann auch größer als 1 werden.

- Ausgehend von ist das p-Quantil x(p) der Wert x, der zu einer gegebenen Wahrscheinlichkeit p gehört. Speziell x(0,5) ist der Median.

- Der Erwartungswert einer stetigen Zufallsvariablen ist analog zu oben

- falls EX existiert, d.h. nicht unendlich wird.

- Ihre Varianz ist

wobei auch hier der Verschiebungssatz angewendet werden kann:

Bei symmetrisch verteilten Zufallsvariablen ist im Allgemeinen der Erwartungswert der Zufallsvariablen gleich dem Median.

In unserem Beispiel ist also EX = 8, denn die Verteilung ist symmetrisch. Das bedeutet, dass im Durchschnitt pro Tag 800 Zeitungen umgesetzt werden.

Wendet man die gegebene Formel für EX auf unser Beispiel an, so erhält man:

Entsprechend gilt für die Varianz:

Beispiel: Eingehende Anrufe bei Fernsehabstimmungen

Während einer Fernsehsendung wurden die Zuschauer aufgefordert, telefonisch abzustimmen. Die Leitungen wurden um 14 Uhr freigeschaltet. Dann konnten die Zuschauer bis ca. 17.30 Uhr anrufen. Für die eintreffenden Anrufe ergab sich näherungsweise die Verteilungsfunktion der stetigen Zufallsvariablen X: Zeitpunkt (Uhrzeit), an dem ein Anruf eintrifft, wie folgt:

Sei jetzt ein beliebiger Anruf.

Wir wollen nun bestimmen

- die Dichtefunktion f(x)

- die Wahrscheinlichkeit, dass bis höchstens 15 Uhr der Anruf eingegangen ist.

- die Wahrscheinlichkeit, dass zwischen 15 und 16 Uhr der Anruf eingegangen ist.

- die Uhrzeit, zu der 90% aller Anrufe eingetroffen sind

- den Median

- den Erwartungswert

- die Varianz

Die Grafik der Verteilung F(X) zeigt den typischen Verlauf einer logarithmischen Funktion.

1. Dichtefunktion f(x)

Die Dichtefunktion ist immer die erste Ableitung der Verteilungsfunktion: f(x) = F'(x).

Unsere Verteilungsfunktion ist abschnittsweise definiert. Wir müssen bereichsweise ableiten (dass die Funktion an den Knickstellen möglicherweise nicht differenzierbar ist, tut im Allgemeinen nicht weh, Hauptsache, die Fläche ergibt 1).

- Bereich x < 2:

- Bereich 2 ≤ x ≤ 2e:

- Bereich x > 2e:

Wir wollen jetzt f(x) noch ordentlich angeben:

Betrachten wir mal die Dichtefunktion: Man sieht hier deutlich, dass die meisten Anrufe in den ersten 1,5 Stunden nach Freischalten eingelaufen sind. Danach flaut die Zahl der Anrufe allmählich ab.

2. Wahrscheinlichkeit, dass bis höchstens 15 Uhr der Anruf ω eingegangen ist

Gesucht ist P(X ≤ 3). In der Dichtefunktion ist das die Fläche von 2 bis 3. Diese Fläche ist das Selbe wie der Funktionswert F(3). Wir erhalten

Man kann also sagen, dass in einer Stunde ab Freischalten der Leitungen 40% der Anrufe eingegangen sind.

|

|

3. Wahrscheinlichkeit, dass zwischen 15 und 16 Uhr der Anruf ω eingegangen ist

Gesucht ist hier P(3 ≤ X ≤ 4). Wir wissen schon, dass speziell für stetige Zufallsvariablen (bei diskreten muss man noch zwischen < und ≤ unterscheiden) gilt: P(3 ≤ X ≤ 4) = P(X ≤ 4) - P(X ≤ 3). Wir erhalten dann

4. Uhrzeit, zu der 90% aller Anrufe eingetroffen sind

Hier ist die Wahrscheinlichkeit 0,9 gegeben und wir suchen den X-Wert, der zu dieser Wahrscheinlichkeit passt, also P(X ≤ ?) = 0,9. Gesucht ist also das 90%-Quantil. Wir bilden den Ansatz

F(?) = 0,9 oder etwas professioneller: F(x(0,9)) = 0,9, also

- ,

d.h. etwa um 16.55 waren 90% der Anrufe eingegangen.

5. Median

Der Median ist das 50%-Quantil. Es ergibt sich also analog zu oben:

6. Erwartungswert

Der Erwartungswert der Zufallsvariablen X wird bei einer stetigen Zufallsvariablen integriert:

Wir müssen hier wieder bereichsweise vorgehen und bestimmen zunächst mal die Teilintegrale:

- Bereich x < 2:

- Bereich 2 ≤ x ≤ 2e: .

- Bereich x > 2e:

Wir müssen nun die Teilintegrale addieren und erhalten

- .

Es kam also ein Anruf im Durchschnitt um 15.30 an.

7. Varianz

Die Varianz berechnet sich nach der Formel

- .

Analog zu oben erhalten wir

- .

| 2.3. | Ungleichung von Bienaymé-Tschebyschew |

| ||||

|---|---|---|---|---|---|---|

Mit der Ungleichung von Tschebyschew oder Biennaymé-Tschebyschew kann man Wahrscheinlichkeiten einer Zufallsvariablen mit unbekannter Verteilung abschätzen. Benötigt werden als Information der Erwartungswert und die Varianz der Zufallsvariablen, die im Allgemeinen geschätzt werden müssen.

Die Ungleichung lautet folgendermaßen:

- .

Besser kann man sich die Beziehung vorstellen, wenn man die Betragsungleichung ausschreibt :

Diese Abschätzung ist naturgemäß sehr grob und kann manchmal nichtssagende Ergebnisse liefern.

Beispiel

Es ist bekannt, dass ein Kaffeeautomat im Durchschnitt 250 ml Kaffee ausschenkt mit einer Varianz von 100 ml2. Eine Tasse gilt als korrekt befüllt, wenn ihr Inhalt nicht mehr als 30 ml vom Durchschnitt abweicht. Der Anteil der inkorrekt befüllten Tassen beträgt höchstens

bzw.

- .

Umgekehrt gilt dann auch

bzw.

- .

Also wäre der Anteil der korrekt befüllten Tassen mindestens 8/9.

| 2.4. | Mehrdimensionale Zufallsvariablen |

| ||||

|---|---|---|---|---|---|---|

Beispiel für mehrdimensionale Zufallsvariablen

In einer Studie über Total Quality Management (TQM) wurde eine umfangreiche Befragung bei europäischen Produktionsbetrieben durchgeführt. Man erfasste zum einen den Aufwand für die Qualitätskontrolle während der laufenden Produktion in Prozent der Produktionskosten und zum anderen die Aufwendungen für Reklamationen prozentual zum Umsatz.

Wir definieren die folgenden zwei Zufallsvariablen:

- X: Anteilige Kosten der Qualitätskontrolle [%].

- Y: Anteilige Kosten der Reklamationen [%].

Es ergibt sich die nebenstehende gemeinsame Wahrscheinlichkeitstabelle (Abb. 1) mit der i-ten Zeile (i = 1, ... , n) und der j-ten Spalte (j = 1, ... , m). Siehe darunter die graphische Darstellung der Tabelle (Abb. 2). Man erkennt, wie bei steigendem Aufwand der Qualitätskontrolle die Ausgaben für die Reklamationen sinken.

Die gemeinsame Wahrscheinlichkeit P(X = 5 ∧ Y = 10) = 0,05 werde bezeichnet als fX,Y(5;10) .

Die spalten- bzw. zeilenweisen Summen der gemeinsamen Wahrscheinlichkeiten ergeben die Randwahrscheinlichkeiten oder auch Einzelwahrscheinlichkeiten der Zufallsvariablen X bzw. Y.

Es ergeben sich also für diese beiden Variablen die Wahrscheinlichkeitsverteilungen

|

xi |

0% |

5% |

10% |

|

fX(xi) |

0,4 |

0,2 |

0,4 |

|

yj |

0% |

5% |

10% |

15% |

|

fY(yj) |

0,2 |

0,2 |

0,2 |

0,4 |

Die Einzelwahrscheinlichkeit berechnet sich als

also hier

| 2.4.1. | Abhängigkeit von Zufallsvariablen |

| ||||

|---|---|---|---|---|---|---|

Stochastische Unabhängigkeit

Falls X und Y stochastisch unabhängig sind, ist

- .

Beispiel:

Z.B. ist P(X = 0 ∧ Y = 0) = 0, aber P(X = 0) · P(Y = 0) = 0,4 · 0,2 ≠ 0.

Also sind X und Y stochastisch abhängig. Es genügt schon, wenn die Unabhängigkeitsvoraussetzung für ein Paar nicht erfüllt ist.

Kovarianz

Man interessiert sich bei gemeinsam verteilten Variablen im allgemeinen auch dafür, inwieweit zwischen diesen Variablen ein Zusammenhang besteht. In unserer Wahrscheinlichkeitstabelle des Beispiels „Qualitätskontrolle“ stehen beispielsweise links unten und rechts oben die größeren Wahrscheinlichkeiten, also scheinen niedrige Ausprägungen von X eher mit hohen Ausprägungen von Y und hohe Ausprägungen von X eher mit niedrigen Ausprägungen von Y einherzugehen.

| Wahrscheinlichkeitstabelle des Beispiels von oben Gemeinsame Wahrscheinlichkeit von Qualitätskontrolle X und Reklamationskosten Y | |||||

| x \ y | 0 | 5 | 10 | 15 | |

| 0 | 0,00 | 0,00 | 0,10 | 0,30 | 0,4 |

| 5 | 0,00 | 0,05 | 0,05 | 0,10 | 0,2 |

| 10 | 0,20 | 0,15 | 0,05 | 0,00 | 0,4 |

| 0,2 | 0,2 | 0,2 | 0,4 | 1,0 | |

Ein Maß für einen linearen Zusammenhang zweier Zufallsvariablen X und Y ist beispielsweise die Kovarianz covXY. Sie ist für diskrete Zufallsvariablen definiert als

bzw. wegen des Verschiebungssatzes

Es ergibt für unser Beispiel

und

und damit die Kovarianz

Eine positive Kovarianz deutet daraufhin, dass eher ein proportionaler Zusammenhang zwischen X und Y besteht, eine negative Kovarianz dagegen, dass eher ein umgekehrt proportionaler Zusammenhang zwischen X und Y besteht.

Korrelationskoeffizient

Ist die Kovarianz null, sind die Zufallsvariablen unkorreliert, sonst korreliert.

Die Kovarianz ist nicht normiert. Ein normiertes Maß für den linearen Zusammenhang stellt der Korrelationkoeffizient nach BRAVAIS-PEARSON ρX,Y dar, der definiert ist als

- .

Es gilt für den Korrelationskoeffizienten ρXY :

- .

Ist ρXY 1 oder -1, besteht ein exakter linearer Zusammenhang zwischen X und Y.

Sind X und Y stochastisch unabhängig, ist covXY und damit ρXY gleich null. Der Umkehrschluss ist nicht zulässig, da eine nichtlineare Abhängigkeitsstruktur zwischen X und Y bestehen kann, die vom Korrelationskoeffizienten nicht erfasst werden kann.

Beispiel:

Wir berechnen zunächst die Varianz von X als

und entsprechend die Varianz von Y als

- .

Damit erhalten wir

- .

Bedingte Wahrscheinlichkeiten von Zufallsvariablen

Auch für Zufallsvariablen sind bedingte Wahrscheinlichkeiten angebbar, nämlich

die bedingte Wahrscheinlichkeit einer Zufallsvariablen als

und die bedingte Wahrscheinlichkeit zweier Zufallsvariablen

- .

Entsprechendes gilt für ≥ und =.

Ebenso gilt:

Wenn X und Y stochastisch unabhängig sind, ist

für alle i,j.

Beispiele:

- .

„Die Hälfte aller Unternehmen mit Reklamationskosten hatte mindestens 15% Aufwand.“

- .

„Die Hälfte aller Unternehmen mit sehr viel Qualitätskontrolle hatte Reklamationskosten.“

| 2.4.2. | Funktionen von Zufallsvariablen |

| ||||

|---|---|---|---|---|---|---|

Funktion einer Zufallsvariablen

Lineare Transformation einer Zufallsvariablen

Der Student Bert hat eine kleine schicke Appartementwohnung, die er hin und wieder säubern muss. Die Intervalle der Reinigungsaktionen sind unterschiedlich und lassen sich folgendermaßen beschreiben: Die Zeit in Wochen, die nach der letzten Säuberungsaktion verstrichen ist, wird als Zufallsvariable X bezeichnet. Die Intervalle verteilen sich folgendermaßen:

| Zahl der Wochen bis zur nächsten Putzaktion xi | 0 | 1 | 2 | 3 | 4 | 5 |

| Wahrscheinlichkeit f(xi) | 0,1 | 0,2 | 0,2 | 0,3 | 0,1 | 0,1 |

X hat den Erwartungswert EX =2,4 und die Varianz 2,04. Rechnen Sie das zur Übung selber nach.

Wenn Bert putzen muss, hängt der Aufwand in Stunden von der Zahl der Wochen ab, die er seine Wohnung vernachlässigt hat. Er braucht jedesmal ca. 1 Stunde für das Bad und einmal Durchsaugen. Für die restlichen Arbeiten muss er pro verstrichener Woche noch eine halbe Stunde Arbeitszeit hinzugeben. Morgen kommen seine Eltern zu Besuch. Mit welcher Wahrscheinlichkeit muss Bert heute 2 Stunden putzen? Wie lange putzt er durchschnittlich jedes Mal?

Hier überlegen wir uns zunächst mal, dass die Putzzeit von der vorherigen „Karenzzeit“ X abhängt. Sie ist also auch eine Zufallsvariable. Man könnte sie so darstellen:

Wie ist nun Y verteilt? Y hängt direkt von X ab und wir erhalten die Wahrscheinlichkeitstabelle

| Zahl der Wochen bis zur nächsten Putzaktion xi | 0 | 1 | 2 | 3 | 4 | 5 |

| Aufgewendete Putzzeit yi | 1 | 1,5 | 2 | 2,5 | 3 | 3,5 |

| Wahrscheinlichkeit f(yi) | 0,1 | 0,2 | 0,2 | 0,3 | 0,1 | 0,1 |

Man kann sofort sehen, dass Bert mit einer Wahrscheinlichkeit von 20% 2 Stunden putzen wird.

Wir wollen nun Erwartungswert und Varianz von Y ermitteln. Der Erwartungswert berechnet sich wie gewohnt als

- .

Das bedeutet er putzt durchschnittlich 2,2 Stunden.

Die Varianz ergibt sich analog als

Schön wäre es allerdings, wenn man die Parameter der Verteilung etwas einfacher ausrechnen könnte. Y hat die schöne Eigenschaft, dass es eine lineare Transformation von X ist der Art

- .

Bei linearen Transformationen wie oben gilt

und

- .

Rechnen wir nach:

und

- .

Standardisierung

Eine spezielle lineare Transformation ist die Standardisierung einer Zufallsvariablen X durch

- .

Man kann nämlich Z so umformen:

mit und , denn Erwartungswert und Varianz von X sind Konstanten.

Es ist dann EZ = 0 und varZ = 1.

Nichtlineare Funktion einer Zufallsvariablen

Lakonisch könnte man sagen: Eine nichtlineare Funktion ist eine Funktion, die nicht linear ist. Man kann sie also nicht in der Form Y = a + bx schreiben. Beispiele sind etwa

Hier kann man die Parameter im Allgemeinen nur über die Verteilung der Zufallsvariablen bestimmen.

Beispiel

Es hat sich herausgestellt, dass der Aufwand an Putzmitteln (ml pro qm) in Abhängigkeit von der verstrichenen Zeit quadratisch steigt mit der Funktion

| Zahl der Wochen bis zur nächsten Putzaktion xi | 0 | 1 | 2 | 3 | 4 | 5 |

| Aufgewendete Putzmittel yi | 2 | 3 | 6 | 11 | 18 | 27 |

| Wahrscheinlichkeit f(yi) | 0,1 | 0,2 | 0,2 | 0,3 | 0,1 | 0,1 |

Hier kann man Erwartungswert und Varianz von Y nur mit den bekannten Formeln ermitteln, etwa

- .

Lineare Funktionen mehrerer Zufallsvariablen

Zwei Variablen

Gegeben sind zwei Zufallsvariablen X1 und X2 mit den Verteilungsparametern EX1, varX1 und EX2, varX2. Außerdem sind die beiden Zufallsvariablen korreliert mit der Kovarianz covX1X2. Es wird eine Zufallsvariable

gebildet. Analog zu oben errechnet sich der Erwartungswert von Y durch

- .

Die Varianz von Y setzt sich aus den Einzelvarianzen der Zufallsvariablen zusammen. Hinzu kommt noch die Kovarianz:

- .

Wenn die zwei Zufallsvariablen X1 und X2 stochastisch unabhängig sind, ist ihre Kovarianz Null. Dann reduziert sich die Formel für die Varianz auf

- .

Beispiel

Die Versorgung mit Getränken in einem Fußballstadion mittlerer Größe wird bei Spielen von einem Gastronomieunternehmen betrieben. Man weiß aus Erfahrung, dass die Zahl der verkauften Bierbecher von der Zahl der vorbestellten Eintrittskarten abhängt, und zwar in unterschiedlicher Weise von einheimischen und auswärtigen Besuchern. Es sei X1: Zahl der bestellten Karten von Einheimischen und X2: Zahl der bestellten Karten von Auswärtigen.

Es hat sich herausgestellt, dass und sind.

Zudem sind X1 und X2 korreliert, denn je interessanter ein Spiel, desto mehr Einheimische und Auswärtige schauen das Spiel an. Es ist covX1X2 = 400.

Die Zahl der verkauften Getränke lässt sich angeben als

- .

Es ist hier

und

Mehr als zwei Variablen

Gegeben sind n Zufallsvariablen Xi (i = 1, ..., n) mit den Erwartungswerten EXi, den Varianzen varXi und den paarweisen Kovarianzen covX1X2, covX1X3, ..., covXn-1Xn . covXiXj (i < j; i = 1, ..., n-1; j = i+1, ..., n). Es sei

- .

Dann erhalten wir für den Erwartungswert

- .

Die Varianz von Y können wir als Summe der Varianzen und paarweisen Kovarianzen ermitteln als

- .

und, falls die Zufallsvariablen Xi stochastisch unabhängig sind, als Varianz

- .

| 3. | Ausgewählte Verteilungen |

| ||||

|---|---|---|---|---|---|---|

Bei den ausgewählten Verteilungen handelt es sich um theoretische Zufallsverteilungen. Das sind Verteilungen, deren Form durch eine allgemein bekannte Funktion beschrieben wird. Oftmals kann beobachtet werden, dass die Verteilung bestimmter Zufallsvariablen annähernd durch eine theoretische Verteilung dargestellt werden kann, z. B. das Gewicht von Hähnchen einer Geflügelzucht ist meistens annähernd normalverteilt. Meist haben diese Verteilungen bestimmte Vorzüge, sie können leicht berechnet werden, und man kann auch wahrscheinlichkeitstheoretische Folgerungen ziehen. Hier bekannt ist bereits die Dreiecksverteilung.

| 3.1. | Diskrete Verteilungen |

| ||||

|---|---|---|---|---|---|---|

| 3.1.1. | Binomialverteilung |

| ||||

|---|---|---|---|---|---|---|

Binomialverteilung

Das Urnenmodell mit Zurücklegen bestimmt die binomialverteilte Zufallsvariable.

Gegeben ist eine Urne mit zwei Sorten Kugeln. Man spricht von einer dichotomen (griech: zweigeteilten) Grundgesamtheit. Es sind insgesamt N Kugeln in der Urne und M Kugeln der ersten Sorte. Der Anteil der Kugeln erster Sorte ist also

- ,

(0 ≤ θ ≤ 1). Es werden n Kugeln mit Zurücklegen gezogen. Es ist die Zufallsvariable definiert:

- X: Anzahl der Kugeln 1. Sorte unter den n gezogenen Kugeln.

Beispiele für binomialverteilte Zufallsvariablen

- In einer Urne befinden sich 3 schwarze und 12 weiße Kugeln. Es werden fünf Kugeln gezogen, wobei jede Kugel sofort wieder zurückgelegt wird (Modell mit Zurücklegen). Wir definieren X als Zahl der weißen Kugeln bei n = 5 Entnahmen.

- 10 mal Würfeln. X: Zahl der Würfe mit einer Augenzahl von mindestens 5.

- Einem sehr großen Fertigungslos von Kondensatoren werden 10 Kondensatoren entnommen. Erfahrungsgemäß sind 15% der Kondensatoren schadhaft. X: Zahl der schadhaften Kondensatoren.

- In einer Schulklasse mit 30 Schülern und Schülerinnen wird täglich ein Kind per Los zum Tafeldienst bestimmt. X: Zahl der Tage, die Paula innerhalb von n = 40 Tagen Tafeldienst machen musste.

Exkurs

Beispiel: Sie würfeln 5 mal. Mit welcher Wahrscheinlichkeit erhalten Sie zweimal Sechs?

Offensichtlich handelt es sich bei diesem Problem um ein Urnenmodell mit Zurücklegen. Es wäre beispielsweise die Wahrscheinlichkeit, dass die ersten zwei Würfe Sechs ergeben:

- .

Insgesamt gibt es folgende Möglichkeiten, zwei Sechsen zu erhalten, nämlich:

(SSFFF), (FFFSS), (FFSFS), (FFSSF), (FSFFS), FSFSF), (FSSFF), (SFFFS), (SFFSF) und (SFSFF).

Hier bedeuten S: eine Sechs wird gewürfelt, F: keine Sechs wird gewürfelt. Es gibt insgesamt

verschiedene Möglichkeiten, zwei Sechsen zu erhalten. Wir erhalten für die gesamte Wahrscheinlichkeit P(X = 2), dass bei fünf Versuchen genau zwei Sechsen resultieren:

Formale Darstellung

Die Zufallsvariable X ist binomialverteilt mit den Parametern n und θ. Ihre Wahrscheinlichkeitsfunktion lautet (0 ≤ θ ≤ 1)

Der Binomialkoeffizient berechnet sich als

Siehe auch in der Wikipedia: Binomialkoeffizient

Die Verteilungsfunktion P(X ≤ a) = B(a|n; θ) ergibt sich als Summe der Wahrscheinlichkeiten einer diskreten Zufallsvariablen, wie in Zufallsvariablen und Diskrete Zufallsvariablen erläutert.

Wie man der obigen Formel entnehmen kann, ist zur Berechnung der Wahrscheinlichkeiten die Kenntnis von N und M nicht erforderlich, es genügt die Bekanntheit von θ .

Weitere Kennwerte der Binomialverteilung sind

EX = n ·θ und varX = n · θ·(1 - θ) .

Beispiel: Verkehrszählung

Der Anteil der LKWs an den Kraftfahrzeugen auf deutschen Autobahnen soll für unser Beispiel 20% betragen. Im Rahmen einer Verkehrszählung an einer Auffahrt der Autobahn werden während einer Stunde 5 einfahrende Fahrzeuge zufällig erfasst.

- Mit welcher Wahrscheinlichkeit befinden sich 2 LKWs in einer Stichprobe?

- In wieviel Prozent der Stichproben befanden sich mindestens 2 LKWs in einer Stichprobe?

Es handelt sich offensichtlich um ein Modell mit Zurücklegen, denn ein Fahrzeug kann theoretisch auch mehrmals diese Auffahrt nehmen. Da wir die Fahrzeuge in LKW und Nicht-LKW unterscheiden, ist die betrachtete Grundgesamtheit dichotom (zwei Sorten Kugeln in der Urne). Wir definieren als Zufallsvariable X: Zahl der LKWs bei fünf gezählten Fahrzeugen.

X ist also binomialverteilt mit den Parametern n = 5 und θ = 0,2 (20%), in Kurzschreibweise

- .

Wir werden zunächst die Wahrscheinlichkeitsfunktion von X bestimmen:

| X = 0 | 0,32768 | |

| X = 1 | 0,4096 | |

| X = 2 | 0,2048 | |

| X = 3 | 0,0512 | |

| X = 4 | 0,0064 | |

| X = 5 | 0,00032 |

mit n = 5 und θ = 0,2

Wir erhalten dann die Wahrscheinlichkeitstabelle

| xi | 0 | 1 | 2 | 3 | 4 | 5 |

| b(xi|5;0,2) | 0,32768 | 0,4096 | 0,2048 | 0,0512 | 0,0064 | 0,00032 |

Wir können also die gesuchten Wahrscheinlichkeiten aus der Tabelle ablesen

- P(X = 2) = 0,2048

- P(X ≥ 2) = 1 - P(X ≤ 1) = 1- (0,3277 + 0,4096) = 0,2627

Eigenschaften der Binomialverteilung

Bei einem Urnenmodell mit Zurücklegen und zwei Sorten Kugeln (dichotome Grundgesamtheit) ist die Zahl der Kugeln erster Sorte bei n Entnahmen immer binomialverteilt.

Bei einem relativ kleinen Anteil θ ist die Verteilung rechtsschief (bzw. linkssteil), da die Wahrscheinlichkeit für ein kleines x groß ist. Bei einem relativ großen Anteil θ ist die Verteilung linksschief, da die Wahrscheinlichkeit für ein großes x eher groß ist.

Ist θ = 0,5, ist die Verteilung symmetrisch bezüglich .

mit n = 5 und θ = 0,8 |

|

Bemerkung

Bei großem n wird die Berechnung der Binomialkoeffizienten ein numerisches Problem, das allerdings beispielsweise mit der Stirling-Formel gelöst werden kann. Bei der Berechnung von Verteilungswerten kann allerdings die Addition der Wahrscheinlichkeiten sehr umständlich werden. Unter Umständen kann man die Funktionswerte der Binomialverteilung durch die Poissonverteilung oder auch durch die Normalverteilung approximieren.

Siehe auch in der Wikipedia: Binomialverteilung

| 3.1.2. | Hypergeometrische Verteilung |

| ||||

|---|---|---|---|---|---|---|

Das Urnenmodell ohne Zurücklegen bestimmt die hypergeometrisch verteilte Zufallsvariable.

Gegeben ist eine Urne mit zwei Sorten Kugeln. Man spricht von einer dichotomen (griech: zweigeteilten) Grundgesamtheit. Es sind insgesamt N Kugeln in der Urne und M Kugeln der ersten Sorte. Der Anteil der Kugeln erster Sorte ist also

- ,

(0 ≤ θ ≤ 1). Es werden n viele Kugeln ohne Zurücklegen gezogen. Es ist die Zufallsvariable definiert:

X: Anzahl der Kugeln 1. Sorte unter den n gezogenen Kugeln.

Beispiele für Hypergeometrische Verteilungen

- In einer Urne befinden sich 3 schwarze und 12 weiße Kugeln. Es werden fünf Kugeln ohne Zurücklegen gezogen (Modell ohne Zurücklegen). Wir definieren X als Zahl der weißen Kugeln bei n = 5 Entnahmen.

- Einem Fertigungslos von 100 Kondensatoren werden 10 Kondensatoren entnommen. Erfahrungsgemäß sind 15% der Kondensatoren schadhaft. X: Zahl der schadhaften Kondensatoren unter den 10 gezogenen.

Eine Zufallsvariable X ist hypergeometrisch verteilt mit den Parametern N, M und n, wenn ihre Wahrscheinlichkeitsfunktion lautet

Die Verteilungsfunktion P(X ≤ a) = H(a|N; M; n) ergibt sich als Summe der Wahrscheinlichkeiten einer diskreten Zufallsvariablen, wie in Zufallsvariablen oder Diskrete Zufallsvariablen erläutert.

Weitere Kennwerte der hypergeometrischen Verteilung sind Erwartungswert und Varianz,

- und

Der letzte Bruch wird Korrekturfaktor genannt; er korrigiert die Varianz bei einem Modell ohne Zurücklegen. Wir können leicht sehen, dass für eine sehr große Grundgesamtheit (N) dieser Faktor etwa 1 wird. Bei einer großen Grundgesamtheit kann man also das Modell ohne Zurücklegen durch ein Modell mit Zurücklegen annähern.

Beispiel: