Wikijunior Computer und Internet/ Geschichte

|

|

Computer

Begriff Internet

Begriff Verwendung

Grundlagen Anhang

|

Rechnen und Zahlen

[Bearbeiten]Bereits sehr früh haben die Menschen angefangen, ihre Gedanken auszudrücken. Zahlen waren ein großes Hilfsmittel. Sie konnten die Anzahl der erlegten Tiere beispielsweise an den Fingern abzählen. In ihren Höhlenbildern konnten sie dann die Anzahl der Tiere malen. Bereits sehr früh haben die Menschen vermutlich auch Zahlen aufgeschrieben anfangs wahrscheinlich mit Hilfe von Strichlisten, wie sie auch heute noch manchmal, zum Beispiel von Kellnern in manchen Restaurants, verwendet werden.

Einige Menschen begannen miteinander zu handeln und diese Händler begannen vermutlich auch zu rechnen. Doch sie stellten fest, dass es sehr schwer ist, dies ohne Hilfsmittel zu machen. Ihre zehn Finger reichten nur für kleine Rechnungen. Als dann nach dem Beginn des Ackerbaus sich die ersten Städte und Königreiche bildeten mussten diese Staaten auch verwaltet werden. Um diese Verwaltung effizienter durchführen zu können entwickelten sich nach und nach vermutlich die Schrift und auch die ersten Zahlensysteme. Recht häufig wurden dabei Additionszahlensysteme verwendet. So wurde das folgende Zahlensystem bereits vor über 5000 Jahren im alten Ägypten verwendet.

Für jede Potenz der Basis wurde dabei eine eigene Ziffer verwendet, also z. B.: E=1, Z=10, H=100 und T=1000.

Die einzelnen Stellen wurden meistens nach einem bestimmten Muster geordnet.

HHH ZZZ E

1982 = T HHH Z Z

HHH ZZZ E

Solche ähnlichen Zahlensysteme gab es auch in anderen Hochkulturen dieser Zeit. Daraus entwickelte sich zum Beispiel das Römische Zahlensystem, die in Europa lange Zeit verwendet wurden und erst relativ spät, nämlich vor 500-1000 Jahren durch das Indische Zahlensystem abgelöst wurde. Dieses Zahlensystem, das wir heute benutzen, ist ein Stellenwertzahlensystem. Dort entscheidet nicht das Zeichen über die Potenz, sondern an welcher Stelle das Zeichen steht. Aus verschiedenen Gründen ist dieses Zahlensystem zum Rechnen besser geeignet. Computer verwenden ein binäres Zahlensystem mit der Basis 2 im Gegensatz zu unserem Zahlensystem mit der Basis 10.

Die ersten Rechenmaschinen

[Bearbeiten]Das menschliche Gehirn ist ein großartiges Gebilde, aber es ist nicht zum einfachen Rechnen ausgelegt, nur wenige Menschen können ohne viel Übung mehr als das kleine Einmaleins im Kopf berechnen. Daher waren Menschen immer bestrebt, wenn sie etwas ausrechnen wollten Hilfsmittel zu verwenden. Zunächst wurden vermutlich, wie es kleine Kinder häufig machen, die Finger verwendet. Aber davon hat man nur zehn und man ist auch nicht sonderlich schnell. Und Multiplikationen funktionieren sehr schlecht. Ein geschicktes Zahlensystem, wie es weiter oben angesprochen wurde, kann ebenfalls schon ein gutes Hilfsmittel sein.

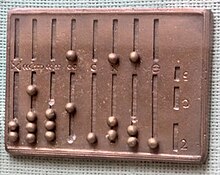

Zu den ersten Rechenhelfern gehört der sogenannte Abakus, er wurde vermutlich um ca. 1100 v. Chr. im indo-chinesischen Kulturraum erfunden. Auch die Römer und Griechen verwendeten den Abakus. Im Bild links siehst du einen römischen Abakus. Dieser Rechenschieber ist ein Werkzeug, mit dem man auch kompliziertere Rechnungen schnell lösen kann.

Aus der Zeit, um das Jahr Null, stammt der "Mechanismus von Antikythera". Diese komplizierte Rechenmaschine diente dazu, die Bewegung der Planeten zu berechnen. Dieses aus vielen Zahnrädern bestehende Gerät geriet aber in Vergessenheit. Das Gerät wurde erst 1900 wieder entdeckt. Es wurde von Tauchern aus einem Schiff geholt, das schon vor langer Zeit untergegangen ist.

Bis zum Mittelalter wurde die Idee der Rechenmaschine verworfen. 1623 wurde dann eine so genannte "Vier-Spezies-Maschine" von Wilhelm Schickard gebaut. Er verwendete Zahnräder, die man normalerweise in Uhren einbaute. Deshalb wurde sein Apparat auch als "rechnende Uhr" bezeichnet.

Bereits ein paar Jahre später, 1703 genau, erfand Gottfried Wilhelm Leibniz das so genannte Dualsystem. Das Besondere an diesem Zahlensystem ist, dass es nur aus zwei Zahlen besteht – 0 und 1. Das war der Schlüssel für die moderne Computertechnik.

Erste programmierbare Maschinen

[Bearbeiten]

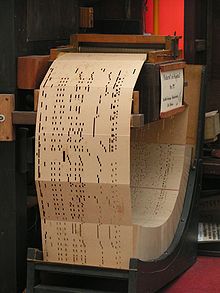

Im Jahre 1805 kam der Franzose Joseph-Marie Jacquard auf die Idee, Webstühle mit Papierkarten zu steuern. So stanzte er einfach viele Löcher nach einem bestimmten Muster in Papierkarten. Damit war er der erste, der Soft- und Hardware trennte – eine der wichtigsten Grundlagen heutiger Computer.

Charles Xavier Thomas de Colmar baute dann 1820 den ersten mechanischen Rechner, der in großen Stückzahlen verkauft wurde. Dieser Apparat, der einer Schreibmaschine ähnlich war, nannte sich „Arithmometer“. Durch die großen Mengen, in denen die Maschine gebaut wurde, konnten sich große Firmen das Gerät anschaffen.

Im Jahr 1822 baute Charles Babbage seine „Differenzmaschine“, eine Rechenmaschine, die auch umfangreichere Rechnungen durchführen konnte. Seine Maschinen litten allerdings unter der damals noch nicht so genauen Fertigung. Für ihre niemals fertiggestellte „Analytic Engine“ schrieb 1843 Ada Lovelace die ersten Computerprogramme, sie gilt damit als die erste Programmiererin.

1890 wurde dann die erste Spielmaschine von Torres y Quevedo gebaut. Dieses Gerät konnte Schach spielen.

Die ersten Computer

[Bearbeiten]Anfang des 20. Jahrhunderts wurden dann vermehrt auch elektrische Rechenmaschinen gebaut, die allerdings noch keine richtigen Computer waren, zum Beispiel die 1935 vorgestellte IBM 601 der Firma IBM. 1937 meldete der Deutsche Konrad Zuse zwei wichtige Patente für eine Rechenmaschine an und der englische Mathematiker Alan Turing veröffentlichte das Konzept der sogenannten „Turing Maschine“. Dieses Konzept ist die Beschreibung eines Computers und damit für die theoretische Informatik wichtig.

1938 stellte Konrad Zuse seine Rechenmaschine „Zuse Z1“ vor. Dieser arbeitete mit einer Taktfrequenz von 1 Hz (1 Hertz). Das bedeutet, dass er eine Rechenoperation pro Sekunde durchführen konnte. Um zwei Zahlen zu multiplizieren, benötigte der Apparat ungefähr 5 Sekunden. Er war halb so schwer wie ein Auto und verbrauchte dreimal so viel Strom wie ein heutiger PC. Leider hatte die Maschine Fehler, weil die Fertigungspräzision noch nicht so hoch war. Sie wurde im Krieg zerstört. Daraufhin wurde sie nach den alten Plänen wieder aufgebaut und später dem „Deutschen Technik Museum“ in Berlin überlassen.

Der Z3, ebenfalls von Konrad Zuse, wurde im Krieg gebaut. Diese Rechenmaschine war die allererste, die alle Grundrechenarten beherrschte. Der Z3 wird als erster voll funktionsfähiger Computer der Geschichte betrachtet und hatte eine Taktfrequenz von bis zu 10 Hertz.

1943 wurde vom britischen Geheimdienst der „Colossus“ in Betrieb genommen, um die deutschen Geheimcodes zu knacken. Die Existenz dieses Computers wurde lange geheim gehalten. Es war der erste voll programmierbare digitale Computer.

Der „ENIAC“ (Electronic Numerical Integrator and Computer) war nach den „Colossus“ der zweite Universalrechner. Der von John Presper Eckert und John William Mauchly gebaute Computer wurde am 14. Februar 1946 vorgestellt. Die Anlage war 27 Tonnen schwer, hatte eine Größe von 10 mal 17 Metern und kostete 468.000 Dollar.

1949 wurde die „Zuse Z4“ vorgestellt. Dieses Exemplar war der erste Computer, der je verkauft wurde, und zwar 1950 an die „Eidgenössische Technische Hochschule Zürich“.

1952 nahm das Luftverteidigungssystem der USA den SAGE-Computer in Betrieb. 1963 erreichte er mit 55.000 Elektronenröhren seine volle Ausbaustufe. Mit einem Gewicht von 275 Tonnen belegte er eine Fläche von über 2000 m² und hatte eine Leistungsaufnahme von bis zu 3 Megawatt. Die USA kostete das SAGE-System rund acht Milliarden US-Dollar.

1959 begann Siemens mit der Auslieferung des „Siemens 2002“. Das war der erste Computer, der vollständig aus Transistoren bestand und in großen Mengen verkauft wurde.

Die Zeit der Großrechner

[Bearbeiten]In der Anfangszeit waren Computer riesige, schwere Ungetüme, die sich nur wenige Universitäten, staatliche Forschungseinrichtungen und große Firmen leisten konnten. Außerdem arbeiteten damals teilweise viele Menschen an einem einzigen Computer. Diese Computer wurden „Mainframes“ genannt. Dass die Computer so groß und teuer waren hing mit der damaligen Technik zusammen.

Technik der ersten Computer

[Bearbeiten]Der erste Computer von Zuse, die Z1 arbeitete mit Relais, das sind elektromechanische Schalter, die mit einer Drahtspule arbeiten. Wenn ein Strom durch diese Spule fließt wird ein Magnetfeld erzeugt und damit ein Schalter geschlossen. Ein typisches Relais ist ungefähr 2 bis 5 cm groß, man benötigt für einen Computer aber tausende dieser Relais. Außerdem klackern Relais bei jedem Schaltvorgang und man kann sich den riesigen Lärm dieser Maschinen vorstellen. Zudem sind sie auch ziemlich langsam, da sie nur wenige Schaltvorgänge pro Sekunde ausführen können. Die nächsten Rechner arbeiteten mit Röhren und waren dadurch etwas schneller, allerdings fielen die Röhren des Öfteren aus und mussten ausgetauscht werden. 1949 wurde der Transistor vorgestellt, allerdings dauerte es noch bis 1959, als Siemens mit der Auslieferung des „Siemens 2002“ begann und sich Transistoren in der Computerwelt durchsetzten. Der "Siemens 2002" war der erste Computer, der vollständig aus Transistoren bestand und in größeren Mengen verkauft wurde.

Die ersten Betriebssysteme und Programmiersprachen

[Bearbeiten]Anfangs wurden diese Computer über Lochkarten programmiert und die Ergebnisse wurden auf Lochkarten und langen Listen auf Endlospapier ausgegeben. Das sah dann ungefähr so aus: Der Programmierer stanzte sein Programm in Lochkarten, ging zum Operator und gab diesem sein Programm. Der Operator schob die Lochkarten in den Lochkartenleser des Computers, der Programmierer musste nun warten, bis die „Jobs“ von anderen Programmierern und sein „Job“ durchgelaufen waren und er nach einigen Stunden seine ausgedruckten Ergebnisse abholen konnte. Das war natürlich etwas unpraktisch, vor allem wenn der Programmierer einen Fehler gemacht hatte. Wenig später (so um 1955) wurden die ersten höheren Programmiersprachen eingeführt. Dort programmierte man nun seine Programme an einer kleinen Maschine die dann Lochkarten ausdruckte. Diese Lochkarten enthielten Anweisungen zur Übersetzung in die Maschinensprache und wurden auf dem Computer zuerst übersetzt und dann ausgeführt. Der Vorteil war, das man die Lochkarten nicht mehr in Maschinensprache beschreiben musste sondern eine für Menschen etwas besser verständliche Programmiersprache verwenden konnte.

Um die Computer besser auszunutzen wurden ab 1960 teilweise kleinere Computer verwendet um die Programme zu übersetzen und dann die "Jobs" nacheinander auf Magnetbänder zu speichern, die dann ohne Verzögerung auf den großen Computern ausgeführt werden konnten. Diese Magnetbänder kann man sich vorstellen wie die alten Kassetten nur deutlich größer. Um die „Jobs“ vom Magnetband zu laden wurde ein Operatorprogramm eingeführt. Das kann man als Vorläufer eines Betriebssystems bezeichnen. Das Operatorprogramm wurde komplexer und konnte nun von mehreren Übersetzungsmaschinen quasi gleichzeitig Programme annehmen und auch mehrere Druckjobs für die Ergebnisse zwischenspeichern. Das wurde als Spooling (Simultaneous Peripheral Operation On-Line) bezeichnet. Ein Beispiel hierfür war der FMS (Fortran Monitor System), der auf dem Großrechner IBM 7094 lief. Kleinere und billigere IBM 1401 Maschinen dienten als Vorrechner und bereiteten die Bänder vor. FMS könnte daher als eines der ersten Betriebssysteme angesehen werden. Allerdings musste man immer noch warten, bis die „Jobs“ der anderen Programmierer durchgelaufen waren. Das war besonders ärgerlich, wenn man einen Fehler gemacht hatte, weil man dann wieder warten musste.

Aus diesem Grund wurde nun das sogenannte Multitasking eingeführt, bei dem die Programme immer wieder unterbrochen werden und ein anderes Programm ausgeführt wird. Diese Unterbrechungen gehen so schnell, dass es einem Menschen vorkommt, als würden die Programme gleichzeitig ausgeführt. Heutzutage gibt es das auch noch, zum Beispiel kann man gleichzeitig etwas im Internet lesen und Musik am PC hören.

Die Operatorprogramme, die das konnten waren dann schon richtige Betriebssysteme, Multitasking- und Multi-User-fähig – mehrere Benutzer können gleichzeitig am Computer arbeiten –, wie heutzutage auch. Beispiele sind Multics, das von 1963 bis 1969 entwickelt wurden, allerdings sehr spezielle Computer benötigten, die das unterstützten oder das davon abgeleitete, auch auf einfacherer Hardware ausführbare und auch einfacher aufgebaute Unix von 1969. Im Gegensatz zu Multics, das, wie schon erwähnt, zu komplex war, wurde Unix, welches allerdings ungefähr das gleiche konnte, ein großer Erfolg. Es gibt heutzutage immer noch durchaus moderne Betriebssysteme, die von Unix abstammen, wie zum Beispiel Apples Mac OS X oder Linux.

Der PC entsteht

[Bearbeiten]

1968 wurde von Hewlett-Packard der erste Personal Computer (PC) unter diesem Namen vorgestellt. Der „HP-9100A“ ist somit der erste offizielle PC, der gebaut und verkauft wurde. Er war allerdings sehr teuer. 19.600,— DM musste man damals dafür bezahlen. Man muss bedenken, dass die Leute damals viel weniger Geld verdienten. Würde man den Wert des Geldes auf heute umrechnen, würde der erste PC 59.000,— Euro kosten. Er hatte einen Bildschirm mit 3 Zeilen und einen Drucker.

Die ersten Mikroprozessoren

[Bearbeiten]Früher waren Computer große Geräte, die zuerst aus Relais, dann aus Röhren und später aus einzelnen Transistoren aufgebaut waren. Ende der 1960er, Anfang der 1970er Jahre wurden dann vermehrt auch Integrierte Schaltkreise (ICs) verwendet.

Am 15. November 1971 wurde dann der „Intel 4004“ der Firma Intel vorgestellt. Das war der erste Mikroprozessor, der je gebaut wurde. Er hatte eine Taktfrequenz von 500–740 kHz (Kilohertz), das sind 500.000-740.000 Rechenoperationen pro Sekunde. Er war ein 4-Bit-Mikroprozessor und bestand aus 2.300 Transistoren.

1972 erscheint dann der „Intel 8008“ als erster 8-Bit-Mikroprozessor. Dieser hatte eine Taktfrequenz von 500 kHz und bestand aus 3.500 Transistoren. In einer umgebauten Form (Intel 8008-1) wurde der Takt auf 800 kHz erhöht.

1974 stellte Intel den „Intel 8080“ vor. Er wird als erster vollwertiger Mikroprozessor angesehen. Dieser 8-Bit-Prozessor hatte eine Taktfrequenz von 4,77 MHz (Megahertz).

Die ersten Heimcomputer

[Bearbeiten]1973 wird der „Xerox Alto“ von „Xerox Palo Alto Research Center“ vorgestellt. Dieser Computer war der erste mit grafischer Benutzeroberfläche.

Mit dem HP-65 wird dann 1974 der erste programmierbare Taschenrechner produziert. Er galt damals als technisches Wunderwerk.

Der „Apple I“ wurde am 1. April 1976 zum Treffen des „Homebrew Computer Club“ von Steve Wozniak vorgestellt. Dieser Computer bestand nur aus einer Platine. Er besaß einen Bildschirmanschluss (schwarz-weiß) und eine eingebaute Tastatur.

Ersetzt wurde er durch den 1977 erschienenen „Apple II“. Ebenfalls in diesem Jahr erschienen der „Commodore PET 2001“ und der „Tandy TRS 80 Model 1“. Alle drei Modelle gelten als die ersten Heimcomputer, die in großen Stückzahlen gebaut und verkauft wurden.

Die Blütezeit der Heimcomputer

[Bearbeiten]

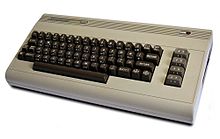

In den 80er Jahren begann die Blütezeit der Heimcomputer. Die Firma Commodore International baute zunächst den VC 20. Mit dem Nachfolger, dem „Commodore 64“ (kurz C64), gelang der Firma der Durchbruch. Der C64 gilt als erfolgreichster Heimcomputer, der je gebaut wurde. Von ihm wurden 22 Millionen Exemplare verkauft. Er erfreut sich noch heute, vor allem bei Sammlern, großer Beliebtheit. Nicht zuletzt die große Anzahl der Zusatzgeräte verhalf zum Erfolg. Denn neben dem Bildschirm wurden auch Steuerknüppel (Joysticks), Drucker und andere Geräte für den C64 gebaut; auch nützliche und weniger notwendige elektronische Zusätze gab es viele.

Am 24. Januar 1984 wurde der erste „Apple Macintosh“ vorgestellt. Dieser hatte einen Prozessor mit 8 MHz und einen Arbeitsspeicher von 128 KB (Kilobyte) RAM. Außerdem war ein 3,5-Zoll Diskettenlaufwerk für 400-KB-Disketten eingebaut. Der Bildschirm vervollständigte das Set. Das Betriebssystem besaß eine grafische Benutzeroberfläche, die mit der Maus bedient werden konnte.

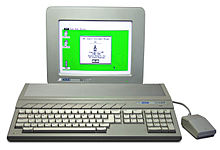

Zur gleichen Zeit wurden auch andere Heimcomputer vorgestellt. Der Amiga war ebenfalls sehr beliebt. Gerade die Einsteigermodelle „A500“ und „A1200“ erfreuten sich hoher Beliebtheit. Dies lag vor allem an der bereits gut ausgebauten grafischen Benutzeroberfläche und der Fähigkeit, mehrere Medien gleichzeitig zu betreiben (Multimediafähigkeit). Das Betriebssystem besaß im Gegensatz zu damals üblichen Betriebssystemen anderer Rechner einige moderne Dienste (engl.:Features), wie Multitasking und eine grafische Benutzeroberfläche. Die Firma wurde 1984 von Commodore übernommen. Der Amiga war seiner Zeit weit voraus, er besaß zum Beispiel bereits eigene Chips zur Sound- und Grafikbeschleunigung, und eine ganze Palette an möglichen Erweiterungskarten, mit denen man die Leistung eines Computers verbessern kann. Allerdings traf die Firma einige schwere Fehlentscheidungen. Zum Beispiel hatte der Amiga immer den Ruf eines Spielcomputers und es wurden eine Reihe von Entscheidungen getroffen welche den Amiga als Bürocomputer nicht geeignet erscheinen ließen. 1994 musste die Firma Konkurs anmelden. Die Entwicklung des Amiga ging jedoch, wenn auch nur auf Sparflamme bei verschiedenen Nachfolgefirmen bis heute weiter.

Von der Firma „Atari“ stammten die Geräte aus der Serie „Atari ST“. Bis 1994 wurden Geräte unter diesem Namen produziert. Das ST steht in dem Fall für Sixteen/Thirty-Two (16/32). Dies lag daran, dass die verwendeten Prozessoren einen 16 Bit breiten Datenbus hatten und mit 32 Bit arbeiteten.

Ende der 1980er Jahre verschwanden viele dieser Heimcomputer wieder vom Markt. Dies lag unter anderem an der Übermacht der IBM-PCs und Kompatiblen, aber auch an Managementfehlern welche in vielen dieser Firmen gemacht wurden.

Der Personal Computer (PC)

[Bearbeiten]

Im Jahr 1981 stellte die Firma IBM ihren Personal Computer vor. Dieser Personal Computer wurde sehr erfolgreich. Weil IBM versäumte, Patente anzumelden, konnten andere Firmen den Personal Computer nachbauen. Man bezeichnet die Computer, die von anderen Firmen hergestellt werden, auch als IBM-kompatible PCs. Der IBM-PC war mit einem Intel 8088 Prozessor ausgestattet. Die meisten bekannten heutigen Prozessoren, wie der Athlon, der Pentium und auch der Core-Duo sind Weiterentwicklungen dieses Prozessors und sind zu diesem Abwärtskompatibel, das heißt, sie können noch Programme ausführen, die für den Ur-PC geschrieben wurden.

1982 erschien der „Intel 80286“ Mikroprozessor. Der Prozessor wurde mit Taktraten zwischen 4 und 16 MHz ausgeliefert. Es gab jedoch Sondermodelle mit 20 und 25 MHz. 1990 wurde eine Erweiterung herausgegeben, die es dem Prozessor ermöglichte, mit dem Betriebssystem Microsoft Windows zu arbeiten. Er verfügte über 134.000 Transistoren.

Als Weiterentwicklung der Intel-Prozessoren wurde ab 1985 der „Intel 80386“, kurz „i386“ oder „386er“ produziert. Dieser Prozessor war ein 32-Bit-Prozessor und konnte damit bessere Betriebssysteme ausführen und mehr Speicher adressieren.

Grafische Benutzeroberflächen

[Bearbeiten]Was ist das?

[Bearbeiten]Grafische Benutzeroberflächen (englisch: Graphical User Interface oder abgekürzt GUI) sind ein wesentlicher Bestandteil der heutigen Computerbedienung. Fast immer, wenn man heutzutage mit einem Computer in Berührung kommt findet man sie. Eine Grafische Benutzeroberfläche besteht heute aus Knöpfen und Symbolen, die mit der Maus bedient werden können. Manchmal kommt anstatt der Maus auch ein Touchscreen, der mit dem Finger oder einem Stift bedient werden kann zum Einsatz. Das erscheint uns heute sehr selbstverständlich, doch früher war das anders, wie schon erwähnt mussten ganz am Anfang Computer mit Lochkarten bedient werden, später gab man dann Textkommandos ein. Erst vor 15-20 Jahren wurden Grafische Benutzeroberflächen für Heimbenutzer quasi selbstverständlich.

Frühe Oberflächen

[Bearbeiten]Ideen für Grafische Benutzeroberflächen gab es schon früh. 1945 stellte Vannevar Bush in dem Artikel "As We May Think" sich eine Maschine vor die über einen "berührungssensitiven Bildschirm" (Touchscreen) gesteuert werden sollte und in der Texte gespeichert werden sollten, die über etwas ähnliches wie "Link" miteinander verknüpft werden sollten. Die Memex sollte allerdings keine digitale Maschine und auch kein Computer sein. Einen weiteren wichtigen Vorläufer der Grafischen Benutzeroberflächen gab es im militärischen Luftverteidigungssystem SAGE (englisch: Semi-Automatic Ground Environment) der USA, bei dem die Soldaten das System über Lichtgriffel bedienten. Lichtgriffel sind Stifte, die mithilfe von Infrarot-Licht in der Spitze etwas auf einem Bildschirm steuern können. SAGE wurde zwischen 1952 und 1963 entwickelt. Einen Vorläufer eines ersten grafischen CAD (englisch: Computer Aided Design = Rechnerunterstützte Konstruktion) ähnlichen Programms stellte das Sketchpad von Ivan Sutherland aus dem Jahre 1963 dar, mit dem man Zeichnungen am Computer anfertigen konnte und welches ebenfalls über einen Lichtgriffel gesteuert wurde. Von 1963 an arbeitete ein Forschungsteam um Douglas Carl Engelbart an einem Projekt bei dem unter anderem die Computermaus entwickelt wurde. Das Projekt namens "On-Line-System" wurde 1968 vorgestellt und hatte eine Oberfläche mit mehreren Fenstern und mithilfe zweier Computer konnte sogar schon ein Chat mit Video vorgeführt werden. Es hatte auch schon eine grafische Copy-and-Paste-Funktion (englisch für: "Kopieren und Einfügen"). 1973 wurde der „Xerox Alto“ von „Xerox Palo Alto Research Center“ präsentiert. Dieser Computer besaß schon Fenster, Ikonen, Menüs und Zeiger, war allerdings nur ein experimenteller Computer. Er wurde zum Xeroc 8010 "Star" weiterentwickelt, der 1981 herauskam und der erste auch verkaufte Computer mit grafischer Benutzeroberfläche war. Ein ehemaliger Mitarbeiter Niklaus Wirth entwickelte 1981 an der ETH Zürich den Lilith, der zwar großes Aufsehen erregte aber kein Verkaufserfolg wurde.

Apple

[Bearbeiten]

Inspiriert durch die Arbeiten am Xeroc PARC und mit einigen von dort übernommenen Mitarbeitern entwickelte ab 1979 die Firma Apple einen eigenen Computer mit grafischer Benutzeroberfläche. Der Apple Lisa kam 1983 auf den Markt und bot Multitasking und hatte eine verbesserte Oberfläche. Die Apple-Oberfläche benutzte eine Schreibtisch-Metapher, in der die Dateien wie Papierstreifen und die Verzeichnisse wie Dateihefte aussahen. Es gab Schreibtischutensilien wie einen Rechner, einen Notizblock und einen Wecker, die der Benutzer nach seinen Wünschen auf dem Bildschirm platzieren konnte. Außerdem hatte er die Möglichkeit, Dateien und Hefte zu löschen, indem er sie in einen Abfalleimer auf dem Bildschirm warf. Zudem wurden Aufklapp-Menüs („Drop down menus“) eingeführt. Da der Rechner allerdings sehr teuer war wurde er ein Misserfolg und es wurde am 24. Januar 1984 der nicht so leistungsfähige aber auch billigere "Apple Macintosh" (kurz: "Mac") eingeführt. Der "Apple Lisa 2" wurde danach in "Macintosh XL" umbenannt. Fast alle späteren Oberflächen wurden von diesen Apple-Oberflächen beeinflusst.

Andere Oberflächen

[Bearbeiten]In den 1980er Jahren entwickelten, beeinflusst vor allem durch Apple auch andere Firmen grafische Benutzeroberflächen. Erwähnenswert sind hier Amiga Intuition von 1985 und die Oberfläche GEM von Digital Research, das zunächst für MS-DOS und später für den Atari ST entwickelt wurde. Auch OS/2, einem Betriebssystem, welches von IBM und Microsoft entwickelt wurde besaß eine grafische Oberfläche. Dies waren Oberflächen vor allem für Heimcomputer.

X-Window-System

[Bearbeiten]Für die Unix-Computer, die vor allem in Rechenzentren eingesetzt wurden, wurde Anfang der 1980er Jahre am MIT das X-Window-System entwickelt, welches allerdings nur einen Unterbau für die Windowmanager darstellt, die darauf laufen. So kann man das X-Window-System nicht direkt als grafische Benutzeroberfläche ansehen, sondern es bietet lediglich eine grundsätzliche Unterstützung für grafische Benutzeroberflächen, so dass man heute auf Unix-ähnlichen Systemen wie Linux eine Vielzahl an grafischen Benutzeroberflächen, wie KDE oder Gnome, findet. Dies ist nur eine der Besonderheiten des X-Window-Systems, es ist nämlich zudem Netzwerkfähig, so dass man auf einem Rechner vor seiner Oberfläche sitzen kann und die Programme aber auf einem anderen Rechner laufen.

Windows

[Bearbeiten]Microsoft war mit ihrem MS-DOS, welches für die IBM-PCs entwickelt worden war, eine der dominanten Firmen auf dem Personal-Computer-Markt. Nachdem Apple ihre grafische Benutzeroberfläche herausgebracht hatte, entwickelte Microsoft eine eigene Oberfläche nach Apples Vorbild. Windows 1.0 erschien 1985. Es war allerdings nicht sonderlich erfolgreich, ebenso wenig wie Windows 2.0. Erst Windows 3.0 und die hinsichtlich der Computersicherheit verbesserten Versionen Windows 3.1 und Windows 3.11, wurden 1990 ein Erfolg. Mit dem Upgrade auf Windows 95 (erschienen 1995) erhielt Windows dann die bekannte Fensterleiste und den dem Macintosh-Finder ähnlichen Schreibtisch, mit dem man Dateien auf dem Schreibtisch ablegen konnte, zudem wurde endlich echtes Multitasking möglich. Windows 98 und Windows ME (Millenium Edition für Windows 2000) enthielten lediglich kleinere Änderungen. Windows 2000 enthielt zwar keine größeren Änderungen an der Oberfläche, brachte jedoch einige Änderungen unter der Haube, da es eigentlich eine Weiterentwicklung des für Server und professionellere Anwender gedachten Systems Windows NT war, bei dem kein DOS mehr unter der Oberfläche arbeitete. Mit Windows XP, welches 2001 erschien, war dann diese Verschmelzung des Windows-Zweiges mit zugrundeliegendem DOS und Windows NT beendet und es erfreut sich immer noch hoher Beliebtheit. Die Technische Beratung (der Support) älterer Betriebssysteme als Microsoft Windows XP ist heute eingestellt. Seit 2015 ist aktuelle Version von Microsoft das Programm Windows 10. Gleichzeitig mit diesen Änderungen gibt es heute Spiele kaum noch auf CD, sondern vorwiegend auf dem leistungsfähigeren Datenträger DVD. Spiele auf Diskette gibt es schon lange nicht mehr.

Heutige Oberflächen

[Bearbeiten]Die noch im Handel befindlichen, jedoch selten vertriebenen PCs mit Benutzeroberfläche Windows XP werden heute nur mit Versionen ab Service Pack 2 (SP2) mit Support bedient. Es gibt inzwischen ein Service Pack 3 (SP3), welches alle Fehlerkorrekturen für Windows XP bis April 2008 enthält. Die letzte gültige Benutzeroberfläche kannst Du im Handel für 15,00 Euro auf CD-ROM erwerben, wenn Du über einen am PC angebrachten Aufkleber nachweist, dass Du diese Windows-Version besitzt.

Mit Windows Vista erhielt die grafische Oberfläche Hardwarebeschleunigung und wurde nicht durch den Prozessor, sondern durch die Grafikkarte gerechnet ("Aero"). Dieses Feature wies vor Vista schon Apple's MacOS X ("Tiger") seit 2001 auf; Apple wirft Microsoft vor, viele Features der "neuen" Oberfläche von MacOS "übernommen" zu haben. Microsoft erwidert seinerseits, dass Apple im Laufe der Zeit die Möglichkeit hatte, die für Vista geplanten Features in MacOS X zu integrieren.

Aufgrund der Leistungsfähigkeit der Grafikkarten wurden verschiedene neue Effekte durch die Hardwarebeschleunigung möglich, wie etwa "aus der Transparenz einblenden" und "Windows Flip", wo Fenster in eine künstliche 3D-Seitenansicht geschaltet werden können, um das Auswählen zu erleichtern, was bisher nur mit Alt+Tab möglich war. Die GUI von Vista ist erstmalig vollständig vektororientiert.

Die Neunziger-Jahre

[Bearbeiten]Technische Entwicklungen in den frühen Neunzigern

[Bearbeiten]Die frühen 90er sind die Zeit der Betriebssysteme. Nachdem am 22. Mai 1990 Microsoft Windows 3.0 veröffentlicht wurde, setzte ein wahrer Boom der Verkaufszahlen ein. Doch Windows setzte sich erst in Nachfolge-Version 3.1, die am 1. März 1992 veröffentlicht wurde, richtig durch. Denn die Vorgängerversion war leider mit gravierenden Sicherheitslücken behaftet.

Am 25. August 1991 veröffentlichte Linus Torvalds seinen Linux-Kernel.

Die Mikroprozessoren der Serie „i486DX“ (Intel 80486) aus dem Jahre 1989 waren die ersten Intel-Prozessoren, die mit 1,2 Millionen Transistoren die Millionen-Marke bei den eingebauten Transistoren sprengte.

Der Pentium

[Bearbeiten]

1993 wurden der erste „Intel Pentium“ veröffentlicht. Er hatte 60 MHz Taktfrequenz, spätere Modelle kamen auf 120 MHz. Der „Intel Pentium MMX“ war mit Taktfrequenzen von 120 bis 300 MHz sehr erfolgreich, der letzte wurde 1997 vorgestellt. Aus heutiger Sicht ist der Pentium 1 ein Meilenstein der modernen Computersysteme.

Konkurrenz

[Bearbeiten]1999 überschreitet der Intel „Pentium III“ mit 1.133 MHz erstmals für einen PC-Prozessor die Gigahertz-Marke. Der MHz-Wettlauf verschärft sich, ein halbes Jahr später überschreitet AMD mit dem Athlon ebenfalls diese Marke.

Das neue Jahrtausend

[Bearbeiten]64-Bit Prozessoren

[Bearbeiten]

Als Erweiterung der in allen PC-Prozessoren verwendeten x86-Prozessorarchitektur, die (wie der Name schon sagt) auf den 8086-Prozessor des Ur-IBM-PC zurückgeht, brachte AMD 2003 den Athlon 64 Prozessor heraus. Ein bis zwei Jahre später brachte Intel dann ebenfalls 64-Bit-Prozessoren heraus.

Mehrkernprozessoren

[Bearbeiten]Nachdem es bereits einige Jahre vorher kritische Stimmen gegeben hatten, die voraussagten, falls die Gigahertzzahlen weiterhin so wüchsen, würden spätestens 2010 die Prozessoren pro Fläche mehr Wärme abstrahlen als ein Brennstab in einem Atomreaktor, beendeten sowohl AMD als auch Intel 2006 das Gigahertzrennen und beschlossen stattdessen, mehrere Prozessorkerne zur Leistungssteigerung zu verwenden. Intels „Core 2 Duo“ und AMDs „X2“ sind Doppelkernprozessoren. Dann gibt es seit einiger Zeit noch 4-Kerner von Intel mit „Core 2 Quad“ und AMDs „Quad FX“. Und seit neustem gibt es von Intel den i9 und von AMD den X6 mit jeweils 6 Kernen! Inzwischen gibt es schon 8 und 12 Kern Prozessoren. Mehrkernprozessoren haben die Leistungsfähigkeit von heutigen Computer weiter erhöht.